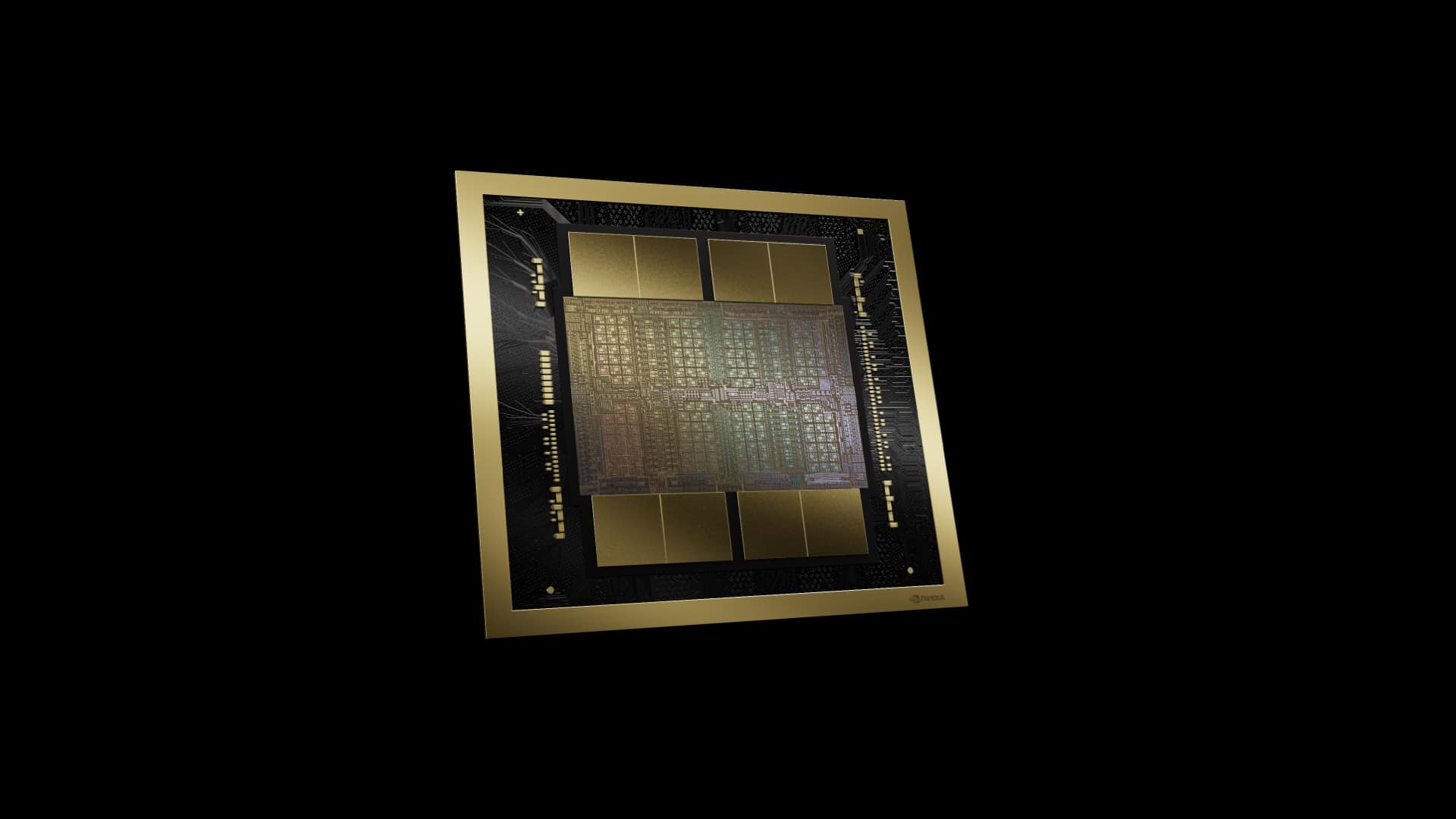

チップ設計の巨人であり現在はTenstorrentのCEOであるJim Keller氏は、NVIDIAが最近発表したBlackwell GPUアーキテクチャの研究開発費が100億ドルにも及んだことに対し、単に相互接続方式を変更するだけで数十億ドルを節約できたはずだとの主張をXで繰り広げている。

Keller氏はGB200 GPUでEthernetプロトコルのチップ間接続を使用すべきだったと述べ、これによってNVIDIAとそのハードウェアのユーザーは多くの費用的メリットが享受出来たはずだと主張している。

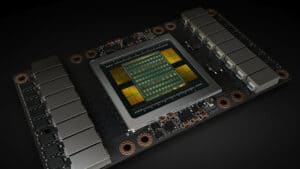

Blackwellインターコネクトに関して、NVIDIAはチップ間およびサーバー間の通信に独自の低レイテンシーの第5世代「NVLINK」(CXLプロトコルを搭載したPCIeと競合する)インターコネクト技術を利用している。上位層の通信には独自のInfiniBand接続を使用している。NVLINKは、帯域幅、レイテンシ、スケーラビリティの面で他の方式より大きな利点がある一方で、他のメーカーのハードウェアに対応できない「独自」方式であり、これは、すでにNVIDIAのハードウェアとソフトウェアを使用している人にとっては問題ではないが、NVIDIAのプラットフォームからソフトウェアを移植する際にデメリットとなる。逆に、NVIDIAはこれによって囲い込みを図っているとも言えるだろう。

代替案はEthernet相互接続である。Ethernetは、費用対効果が高く、NVLINKの専有状態を破壊し、最終的にはるかに優れたエコシステムを提供する可能性がある。問題は、総合的な性能に関しては、Ethernetは、InfiniBandと組み合わせたNVIDIAのNVLINKにまだ劣ると言う点だ。

一部のスペック的には、Ethernet(特に次世代400GbEと800GbE)はInfiniBand(最大200GbE)に対抗できる。しかし、AIやHPC向けの機能や優れたテールレイテンシーに関しては、InfiniBandの方がまだ優位性がある。これによってAI、HPC用途ではNVLINKを選択せざるを得ないという向きもあるかも知れない。

だが、AMD、Broadcom、Intel、Meta、Microsoft、Oracleが主導する業界では、Ultra Ethernet相互接続技術の開発が進んでおり、AIやHPCの通信により高いスループットと機能を提供する体制が整いつつある。もちろん、Ultra Ethernetは、この種のワークロードにおいて、NVIDIAのInfiniBandに対するより現実的な競争相手となるだろう。

Sources

コメント