最新のAI生成動画に驚嘆したり、詐欺検出システムによって銀行残高を犯罪者から守られたり、走りながら音声入力でメッセージを送れて少し楽になったりした経験があるなら、多くの科学者、数学者、エンジニアに感謝すべきである。

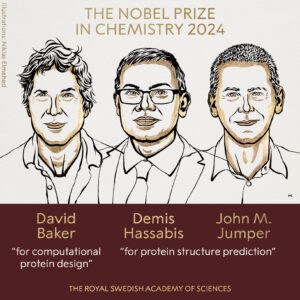

しかし、そのような体験を可能にするディープラーニング技術への基礎的貢献において、2つの名前が際立っている。プリンストン大学の物理学者John Hopfieldとトロント大学のコンピューター科学者Geoffrey Hintonである。

この2人の研究者は、人工ニューラルネットワークの分野における先駆的な業績により、2024年10月8日に物理学のノーベル賞を受賞した。人工ニューラルネットワークは生物学的ニューラルネットワークをモデルにしているが、両研究者の業績は統計物理学に基づいているため、物理学賞の対象となった。

ニューロンの計算方法

人工ニューラルネットワークの起源は、生体脳内のニューロンの研究に遡る。1943年、神経生理学者のWarren McCullochと論理学者のWalter Pittsがニューロンの働きについて簡単なモデルを提案した。McCulloch-Pittsモデルでは、ニューロンは隣接するニューロンと接続し、それらから信号を受け取ることができる。そして、それらの信号を組み合わせて他のニューロンに信号を送ることができる。

しかし、ここに一つのひねりがある。異なる隣接ニューロンからの信号に異なる重みを付けることができるのである。新しいベストセラーの携帯電話を買うかどうか決めようとしているところを想像してみよう。友人たちに話を聞いて、彼らの推薦を求める。単純な戦略は、すべての友人の推薦を集めて、多数派の意見に従うことだ。例えば、Alice、Bob、Charlieの3人の友人に聞いて、彼らがそれぞれ賛成、賛成、反対と言ったとする。これにより、賛成が2票、反対が1票なので、携帯電話を買うという決定に至る。

しかし、技術的なガジェットについて深い知識を持っている友人もいるかもしれない。そのため、彼らの推薦により大きな重みを与えることにするかもしれない。例えば、Charlieが非常に知識豊富な場合、彼の反対票を3回カウントすることにすれば、今度は携帯電話を買わないという決定になる – 賛成2票、反対3票となる。不運にも技術的なガジェットに関して全く信用できない友人がいる場合は、マイナスの重みを割り当てることさえあるかもしれない。つまり、彼らの賛成は反対としてカウントされ、反対は賛成としてカウントされる。

新しい携帯電話が良い選択かどうか自分で決めたら、今度は他の友人があなたに推薦を求めるかもしれない。同様に、人工および生物学的ニューラルネットワークでは、ニューロンが隣接するニューロンからの信号を集約し、他のニューロンに信号を送ることができる。この能力は重要な区別につながる。ネットワーク内にサイクルはあるだろうか?例えば、今日私がAlice、Bob、Charlieに尋ね、明日Aliceが私に推薦を求めた場合、そこにはサイクルがある。Aliceから私へ、そして私からAliceへと戻るのである。

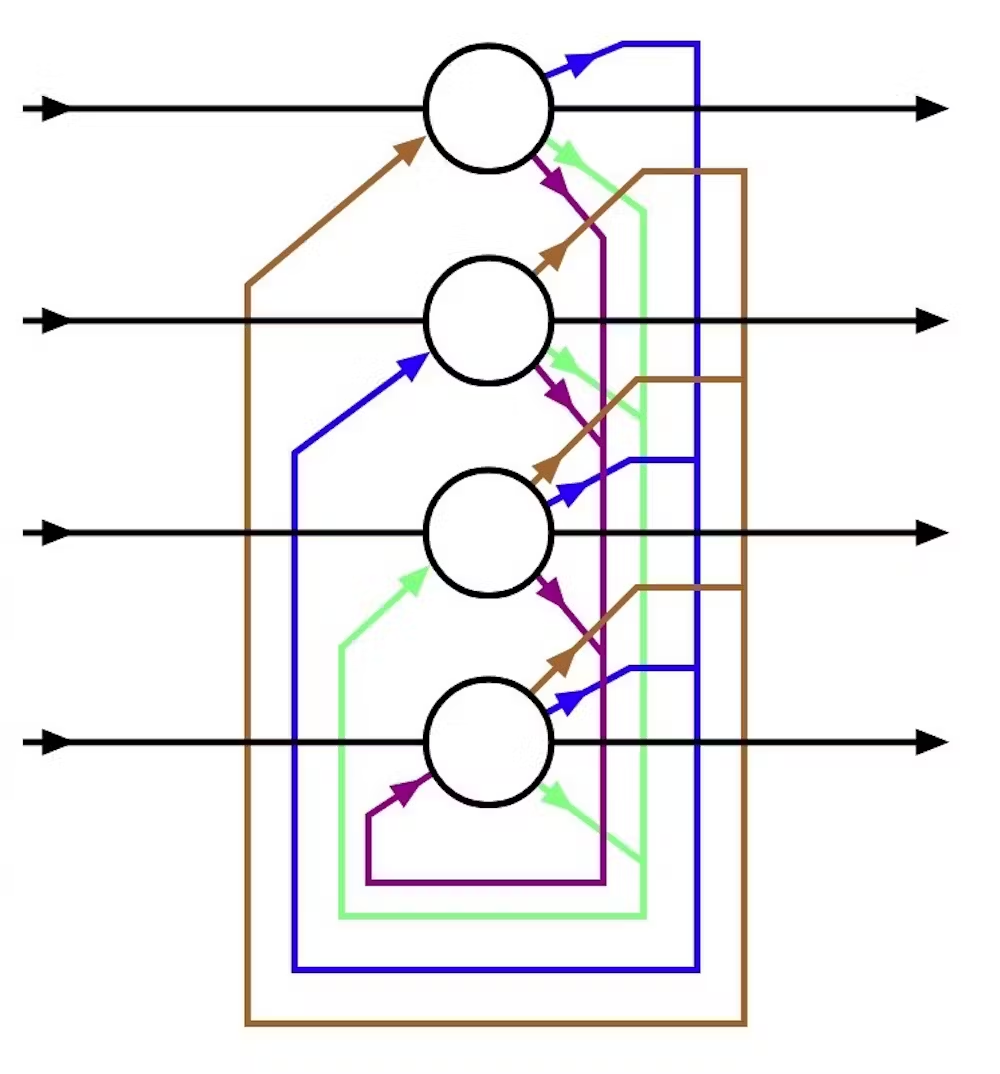

ニューロン間の接続にサイクルがない場合、コンピューター科学者はそれをフィードフォワードニューラルネットワークと呼ぶ。フィードフォワードネットワークのニューロンは層状に配置できる。第1層は入力からなる。第2層は第1層から信号を受け取り、以降も同様である。最後の層がネットワークの出力を表す。

しかし、ネットワークにサイクルがある場合、コンピューター科学者はそれをリカレントニューラルネットワークと呼び、ニューロンの配置はフィードフォワードニューラルネットワークよりも複雑になる可能性がある。

Hopfieldネットワーク

人工ニューラルネットワークの最初のインスピレーションは生物学から来たが、すぐに他の分野がその発展を形作り始めた。これには論理学、数学、物理学が含まれた。物理学者のJohn Hopfieldは、物理学のアイデアを使って特定のタイプのリカレント・ニューラルネットワーク(現在はHopfieldネットワークと呼ばれる)を研究した。特に、彼はそのダイナミクス、つまり時間の経過とともにネットワークに何が起こるかを研究した。

このようなダイナミクスは、情報がソーシャルネットワークを通じて広がる際にも重要である。オンラインのソーシャルネットワークでミームがバイラルになったり、エコーチェンバーが形成されたりすることは誰もが認識している。これらはすべて、ネットワーク内の人々の間で行われる単純な情報交換から最終的に生じる集団現象である。

Hopfieldは、物理学のモデル(特に磁性の研究のために開発されたモデル)を使用して、リカレントニューラルネットワークのダイナミクスを理解する先駆者であった。また、そのダイナミクスによって、このようなニューラルネットワークに一種の記憶を持たせることができることも示した。

ボルツマンマシンとバックプロパゲーション

1980年代、Geoffrey Hinton、計算論的神経生物学者のTerrence Sejnowski、その他の研究者たちがHopfieldのアイデアを拡張し、19世紀の物理学者Ludwig Boltzmannにちなんで名付けられたボルツマンマシンと呼ばれる新しいクラスのモデルを作り出した。その名前が示すように、これらのモデルの設計はBoltzmannが先駆けた統計物理学に根ざしている。パターンを保存し、パターンのエラーを修正できる(スペルチェッカーのように)Hopfieldネットワークとは異なり、ボルツマンマシンは新しいパターンを生成でき、これにより現代の生成AI革命の種が蒔かれた。

Hintonは1980年代に起こったもう一つのbreakthroughの一翼も担った。それがバックプロパゲーションである。人工ニューラルネットワークに興味深いタスクを実行させたいなら、人工ニューロン間の接続に適切な重みを何らかの方法で選択しなければならない。バックプロパゲーションは、トレーニングデータセットに対するネットワークのパフォーマンスに基づいて重みを選択することを可能にする重要なアルゴリズムである。しかし、多層の人工ニューラルネットワークを訓練することは依然として課題であった。

2000年代、Hintonとその共同研究者たちは、まずネットワークを層ごとに事前訓練し、その後、事前訓練されたネットワークの上に別の微調整アルゴリズムを使用して重みをさらに調整することで、ボルツマンマシンを巧みに利用して多層ネットワークを訓練した。多層ネットワークはディープネットワークと改名され、ディープラーニング革命が始まった。

AIから物理学への貢献

物理学のノーベル賞は、物理学からのアイデアがディープラーニングの台頭にどのように貢献したかを示している。現在、ディープラーニングは物理学に恩返しを始めており、分子や材料から地球全体の気候に至るまで、様々なシステムの正確で高速なシミュレーションを可能にしている。

HopfieldとHintonに物理学のノーベル賞を授与することで、賞委員会は、これらの進歩を人類の福祉の促進と持続可能な世界の構築に活用する人類の可能性に期待を寄せていることを示している。

コメント