量子コンピュータの実用化における最大の課題であったエラー訂正の問題を、Googleが画期的な手法で解決した。同社が開発した新型量子プロセッサー「Willow」は、量子ビット数を増やすほどエラーが指数関数的に減少する特性を実現。さらに、最新のスーパーコンピュータが10の25乗年(10,000,000,000,000,000,000,000,000年)かかる計算を、わずか5分で処理することにも成功した。

30年来の量子コンピューティングの課題を克服

量子コンピュータの基本的な仕組みは、原子より小さなスケールで発生する量子力学的な現象を利用している。従来型のコンピュータがトランジスタを「0」と「1」の間で切り替えて計算を行うのに対し、量子コンピュータの量子ビットは「重ね合わせ」と呼ばれる状態により、0と1の組み合わせを同時に表現できる。この特性により、特定の計算において従来型コンピュータを圧倒的に上回る性能を発揮する可能性を秘めている。

しかし、量子ビットは非常にデリケートな性質を持っている。宇宙線の通過のような微細な外乱でさえ、量子ビットの状態を乱してしまう可能性がある。通常のコンピュータでもエラーは発生するが、古典的なビットの場合は直接観測してエラーを修正できる。一方、量子ビットは観測した瞬間に「重ね合わせ」状態が崩壊し、古典的なビットと同じ状態になってしまうという量子力学特有の性質がある。このため、エラーの検出と修正には間接的な方法が必要となる。

さらに深刻な問題は、これまでの量子コンピュータでは量子ビットの数を増やすほどエラーも増加していったことだ。これは量子コンピュータの大規模化における決定的な障壁となっていた。この課題は、1995年にPeter Williston Shorが量子誤り訂正の理論を発表して以来、約30年にわたって量子コンピューティング分野の中心的な研究課題であり続けてきた。

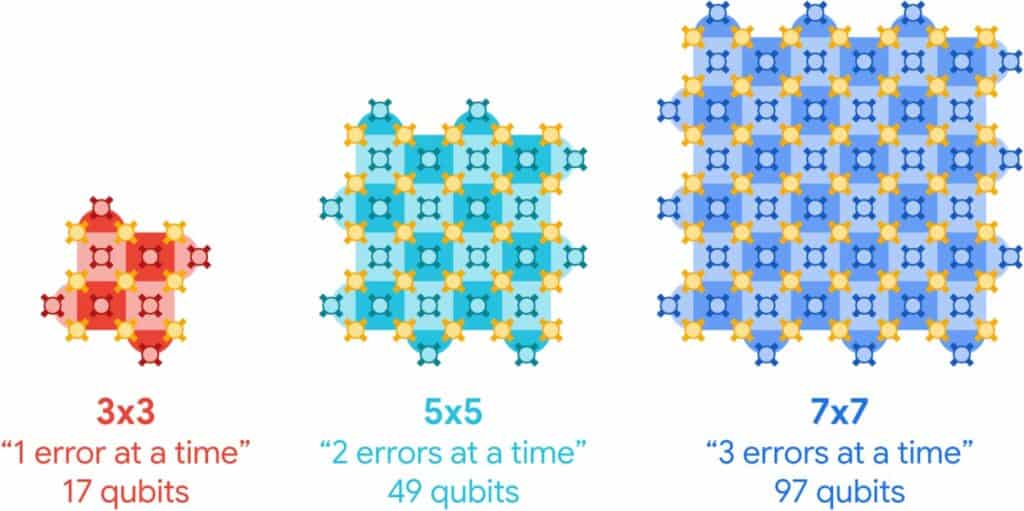

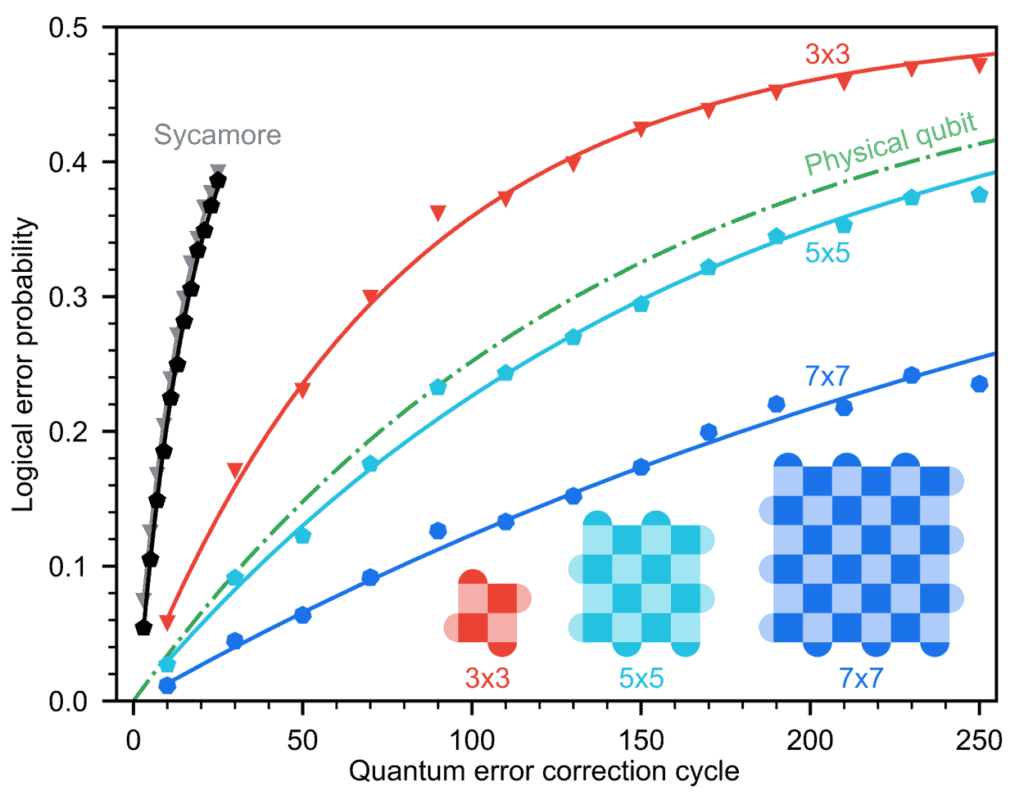

Googleが開発したWillowチップは、この長年の課題に対して画期的な解決策を提示した。同チップは物理的な量子ビットを3×3、5×5、7×7といった格子状に配置し、それらを組み合わせて「論理量子ビット」を構成する。この構造により、量子ビットの数を増やすごとにエラー率が半減することが実証された。これは「閾値以下」と呼ばれる重要な達成であり、大規模な量子コンピュータの実現可能性を強く示唆している。

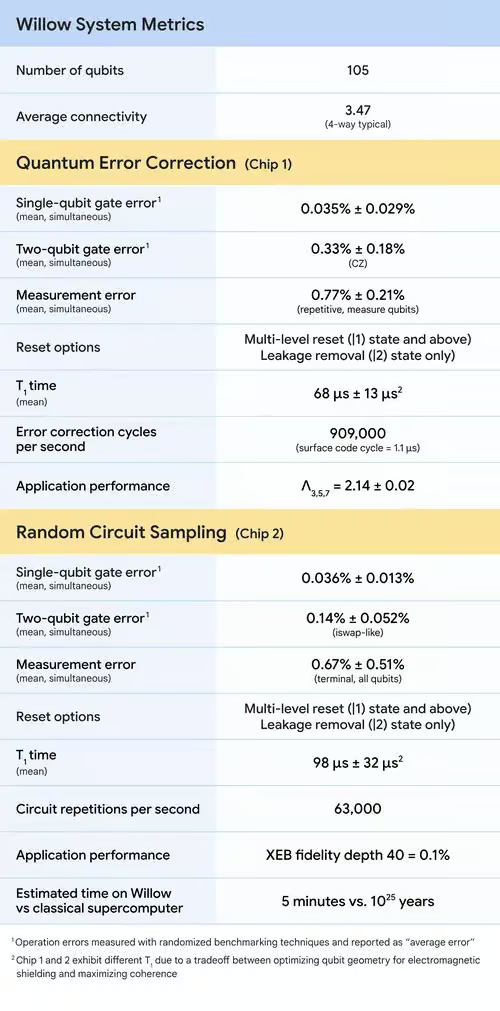

加えて、Willowは量子ビットのコヒーレンス時間(量子状態を維持できる時間)を約100マイクロ秒まで延長することにも成功した。これは前世代のSycamoreチップと比較して5倍の改善である。この進歩は、キャリブレーション(較正)プロトコルの改善、機械学習を用いたエラー検出の向上、デバイス製造方法の改良など、複数の技術革新を組み合わせることで実現された。

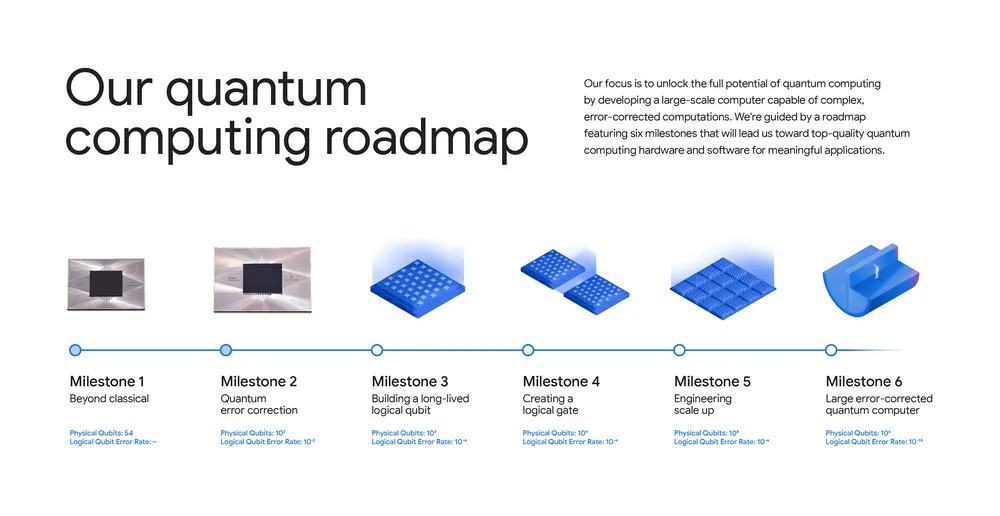

チームによれば、この成果は、量子誤り訂正が初めて提案されて以来、進歩を妨げてきた課題に対処するものだという。最終的には、このシステムをさらに改良し、新たなアルゴリズム技術やイノベーションを実装する作業を継続し、究極の目標であるフォールトトレラントな量子コンピューターにさらに近づく予定だ。

Google Quantum AIの量子ハードウェア・ディレクターであるJulian Kelly氏は、「エラー訂正は量子コンピュータの最終目標です。 Willowはスケーラブルなエラー訂正を念頭に置いて設計されています。 今回のデモのためだけでなく、これは未来につながる技術なのです」と、この成果について報告している。

驚異的な計算能力を実証

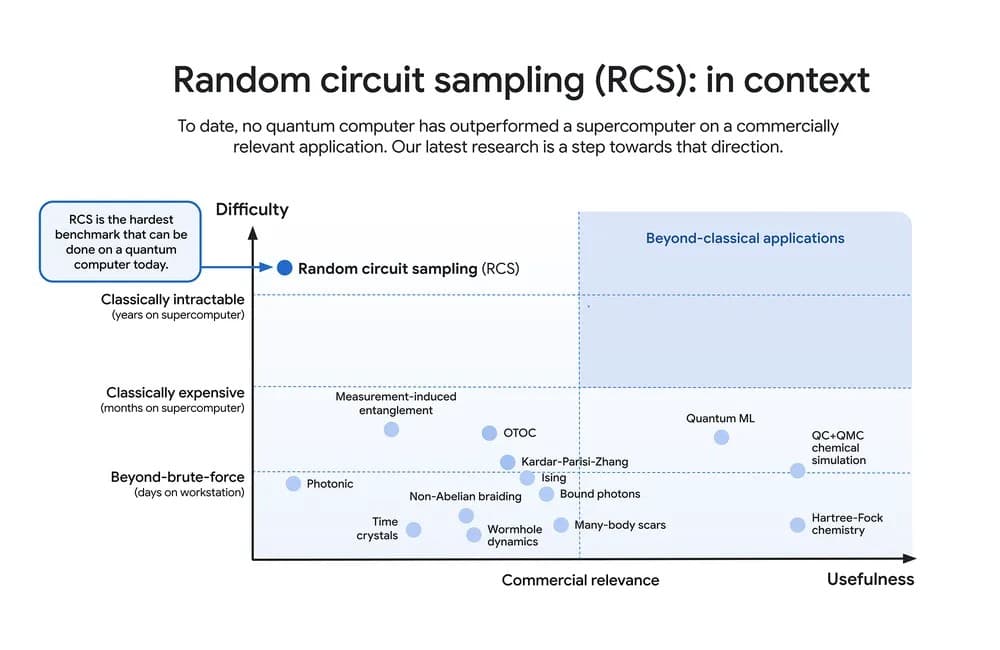

Willowチップの性能評価には、量子コンピュータの標準的なベンチマークテストである「ランダム回路サンプリング(RCS)」が用いられた。このテストは、Google Quantum AIチームが開発し、現在では量子コンピュータの性能を評価する業界標準として広く採用されている。RCSは量子コンピュータが従来型のコンピュータでは実行が困難な計算を実行できることを実証するための入門的なベンチマークとして位置づけられている。

RCSテストにおけるWillowの性能は、科学界の予想をはるかに超える結果となった。現代最高性能のスーパーコンピュータの一つであるFrontierが1025年を要する計算を、わずか5分で完了したのである。この「1025年」という時間スケールを理解するために、宇宙の年齢(約138億年)と比較してみると、その差は途方もないものであることがわかる。実に宇宙年齢の約1兆倍以上の時間に相当する計算を、たった5分で処理したことになる。

この性能評価において特筆すべきは、Googleの研究チームが極めて保守的な前提条件を設定していたことだ。例えば、比較対象となるFrontierスーパーコンピュータについて、二次記憶装置(ハードドライブ)への完全なアクセスを想定し、帯域幅のオーバーヘッドも考慮しないという、従来型コンピュータに有利な条件設定を行っていた。それにもかかわらず、Willowは圧倒的な性能優位性を示したのである。

研究チームは、従来型コンピュータの性能も今後向上し続けることを予想している。しかし、量子プロセッサの性能向上は二重指数関数的な速度で進んでおり、この性能差は今後さらに拡大していくと予測されている。この急速な進歩は、量子コンピュータが特定の計算領域において、従来型コンピュータを決定的に上回る可能性を示唆している。

実用化に向けた次なる展開

Googleの研究チームが掲げる次の技術的マイルストーンは、極めて野心的なものだ。エラー率を100万分の1まで低減させた「高性能論理量子ビット」の開発を目指している。この目標を達成するためには、1,457個もの物理量子ビットを緊密に結合させる必要がある。この取り組みが特に困難なのは、単純に物理的なハードウェアの性能を向上させるだけでは達成できない点にある。エラー訂正技術を複数の層で重ねながら、システム全体として高い信頼性を実現しなければならないのだ。

量子コンピューティングの研究は現在、興味深い分岐点に立っている。これまでの研究では、主に二つの異なる方向性で実験が行われてきた。一つは、古典的なコンピュータとの性能比較を目的としたRCSベンチマークのような理論的な実証実験である。もう一つは、量子システムのシミュレーションといった科学的な発見につながる実験だ。しかし、後者は依然として従来型コンピュータでも計算可能な範囲にとどまっていた。

Googleの研究チームが目指すのは、これら二つのアプローチを統合することである。つまり、従来型コンピュータでは実行不可能な計算を行いながら、同時に実世界の問題解決に直接的な価値をもたらすことだ。この野心的な目標に向けて、Willowチップは重要な一歩を記録したと言える。

実用化に向けた具体的な応用分野も徐々に明確になってきている。例えば、新薬開発における分子レベルのシミュレーションは、量子コンピュータの特性を活かせる有望な領域だ。電気自動車用バッテリーの効率改善や、核融合エネルギーの研究開発といった分野でも、量子コンピュータの活用が期待されている。これらの応用は、原子や分子レベルでの複雑な相互作用を理解し、最適化する必要があるため、従来型コンピュータでは現実的な時間での計算が困難とされてきた。

さらに注目すべきは、量子コンピューティングとAIの融合への期待だ。Google Quantum AIの創設者は、両者が今後最も変革的な技術となると予測している。量子アルゴリズムは根本的なスケーリング上の利点を持っており、AIの訓練データ収集や学習アーキテクチャの最適化において、重要な役割を果たす可能性がある。特に、量子効果が重要となるシステムのモデリングにおいて、この融合は革新的な進展をもたらすかもしれない。

こうした実用化に向けた取り組みを加速させるため、Googleは開発者コミュニティとの協力も重視している。オープンソースソフトウェアや教育リソースの提供、Courseraでの新しいコース開設など、量子誤り訂正の基礎を学び、未来の問題解決に貢献できる人材の育成にも力を入れている。これは、量子コンピューティングの実用化には、ハードウェアの進化だけでなく、それを使いこなすソフトウェアや人材の育成も不可欠だという認識を示している。

論文

参考文献

コメント

コメント一覧 (1件)

[…] さらに読む ⇒XenoSpectrum出典/画像元: https://xenospectrum.com/googles-new-quantum-chip-willow-breaks-the-error-correction-barrier/ […]