MIT発のAIスタートアップLiquid AIは、AMDをリード投資家とする総額2.5億ドルのシリーズA資金調達を実施したことを発表した。同社の企業価値は20億ドル超に到達し、従来のTransformerモデルとは異なる新しいアーキテクチャによるAIモデルの開発を加速させる。

革新的な「リキッドニューラルネットワーク」技術

MITコンピュータ科学・人工知能研究所(CSAIL)の元研究者Ramin Hasani、Mathias Lechner、Alexander Amini、Daniela Rusらによって開発された「リキッドニューラルネットワーク(Liquid Neural Networks)」は、線虫の神経系にヒントを得たもので、従来のTransformerアーキテクチャとは一線を画す、全く新しいAIアーキテクチャだ。

各ニューロンの挙動を時系列で予測する方程式によって制御され、OpenAIのGPTシリーズやGoogleのGeminiで採用されているTransformerベースの設計と比較して大幅に小規模かつ効率的な処理を実現する。特筆すべきは、テキストや音声、画像、ビデオ、各種信号など、多様な連続データを驚くべき効率で処理できる点である。

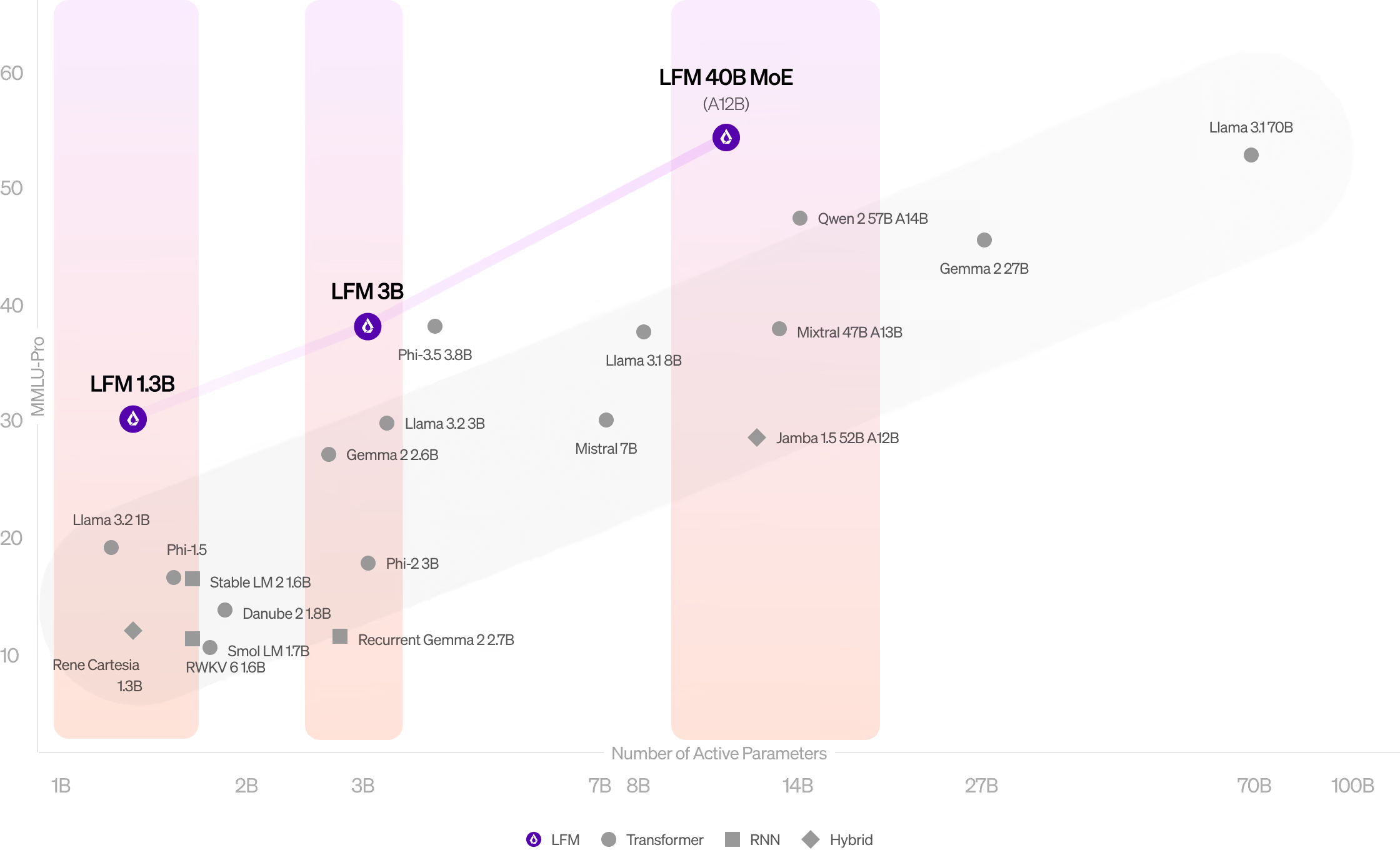

Liquid AIが発表した3つのモデルは、それぞれ明確な用途を想定している。モバイルデバイス向けの13億パラメータモデル「LFM-1B」は、限られたリソース環境下での高性能を実現。31億パラメータを持つ「LFM-3B」は、ロボットやドローンなどのエッジコンピューティング向けに最適化されている。最上位の「LFM-40B」は403億パラメータを擁し、企業の複雑なユースケースに対応する。

特に注目すべきは、これらのモデルが示す卓越したメモリ効率性だ。例えば、LFM-3Bは同じパラメータ数のLlama 3.2-3Bと比較して、約3分の1のメモリ消費量で動作する。さらに、最大100万トークンという長大な文脈を効率的に処理できる能力は、大規模文書分析や長文生成において圧倒的な優位性を持つ。

ベンチマークテストでの性能も驚異的な結果を示している。特にLFM-1Bは、MMLU(Massive Multitask Language Understanding)やARC-C(AI2 Reasoning Challenge)において、同クラスのモデルの性能を大きく上回った。LFM-3BはMicrosoftのPhi-3.5やMetaのLlamaモデルと互角の性能を発揮し、最上位のLFM-40Bは、より大規模なモデルをも凌駕する効率性を示している。

現在、これらのモデルはLiquid Playground、Lambda、Perplexity Labsなどのプラットフォームを通じて早期アクセスが可能となっている。さらにLiquid AIは、NVIDIA、AMD、Apple、Qualcomm、Cerebras Computingなど、主要ハードウェアベンダー向けの最適化を進めており、今後さらなる性能向上が期待される。

AMDとの戦略的パートナーシップで最適化を推進

今回の資金調達には、AMD以外にもOSS Capital、Duke Capital Partners、PagsGroupが参加している。特にAMDとは戦略的パートナーシップを締結し、同社のGPU、CPU、NPUに最適化されたモデル開発を進める。これにより、eコマース、家電、バイオテクノロジー、金融サービスなど、幅広い産業向けに特化したAIソリューションの展開を目指す。

Xenospectrum’s Take

Liquid AIの取り組みは、現在のAI業界が直面する計算リソースのボトルネックに対する興味深いアプローチと言える。特にGemma 2 2B-itやLlama 3 3Bと比較して大幅なメモリ使用量の削減を実現している点は注目に値する。しかし、実用面での性能やスケーラビリティの検証はこれからであり、既存の巨大言語モデルに対する現実的な代替となりうるかは未知数だ。AMDという強力なパートナーを得たことで、ハードウェアレベルでの最適化という武器を手に入れた意義は大きい。

Source

コメント