米スタンフォード大学教授Stefano Ermonらが設立したInception Labsは、従来の大規模言語モデル(LLM)より最大10倍高速なテキスト生成が可能な拡散型LLM「Mercury」を発表した。同社の最初の公開製品Mercury Coderは、NVIDIA H100 GPUで毎秒1000トークン以上の処理速度を実現し、AI生成テキストの効率性に新たな基準を打ち立てている。

拡散モデルがテキスト生成に革命をもたらす

従来のLLMは自己回帰(autoregression)方式で、テキストを左から右へと1トークン(単語や文字の断片)ずつ順次生成する仕組みを採用している。OpenAIのGPT-4oやAnthropicのClaude 3.7 Sonnetなどがこの方式だ。この順次処理方式は文脈の深さを保持できる一方、レスポンスが長くなるほど計算コストが指数関数的に増加するという欠点がある。

一方、Mercuryが採用する拡散モデル(Diffusion Model)は根本的に異なるアプローチを取る。画像生成AI(Stable Diffusion、DALL-E、Midjourney)で広く使われているこの技術は、「粗から細へ(coarse-to-fine)」のプロセスでテキストを生成する。初期の粗い推定値を並列で一連の「デノイジング(ノイズ除去)」ステップを通じて洗練させていく。

「拡散モデルはデータの大まかな推定値から始めて、一度にすべてを洗練させます」とErmon氏はTechCrunchに語った。「LLMでは、最初の単語を生成するまで2番目の単語を生成できず、最初の2つを生成するまで3番目を生成できません」拡散モデルの独自構造を活用することで、Mercuryの拡散型LLM(diffusion-based large language model: Inception LabsではDLMと呼んでいる)はこれらの制約を回避し、従来の自己回帰型モデルよりも効率的に応答を提供することを目指している。

テキスト拡散モデルの技術的仕組み

画像拡散モデルがピクセル値に連続的なノイズを追加するのに対し、テキスト拡散モデルは離散的なトークンに連続的なノイズを適用できない。その代わり、特殊なマスクトークンをノイズの代わりとして使用する。

テキスト拡散モデルの処理フローは以下のようになる:

- 最初に完全にマスクされたテキスト(または高いノイズレベル)から始める

- 各「デノイジング」ステップでマスクを徐々に取り除く(ノイズを低減)

- ニューラルネットワーク(変換器モデル)がマスクされた部分を予測

- 全体の応答を一度に洗練させていく

研究機関Renmin UniversityとAnt Groupが開発したLLaDAなどのテキスト拡散モデルでは、マスキング確率がノイズレベルを制御し、高いマスキングは高いノイズを、低いマスキングは低いノイズを表す。拡散プロセスは高いノイズから低いノイズへと移行する。LLaDAはこれをマスキング用語で説明し、Mercuryはノイズ用語を使用しているが、両者はテキスト生成に拡散に根ざした同様の概念を適用している。

拡散モデルを構築するプロセスは、部分的に隠されたデータでニューラルネットワークをトレーニングし、モデルに最も可能性の高い完成を予測させ、実際の答えと比較するというものだ。モデルが正解した場合、その正解につながったニューラルネットワークの接続が強化される。十分な例を学習した後、モデルはコーディングなどのタスクに役立つ十分な確からしさを持つ出力を生成できるようになる。

Inceptionによると、このアプローチにより、モデルは以前に生成されたテキストのみを考慮するという制限がなくなり、出力を洗練し、ミスに対処することが可能になるという。この並列処理により、MercuryはNVIDIA H100 GPUで報告されている毎秒1,000トークン以上の生成速度を実現している。

ベンチマークで証明される優位性

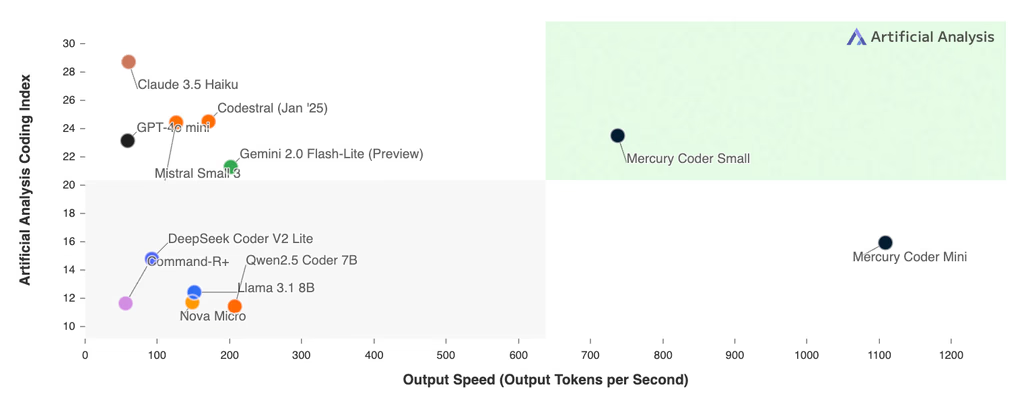

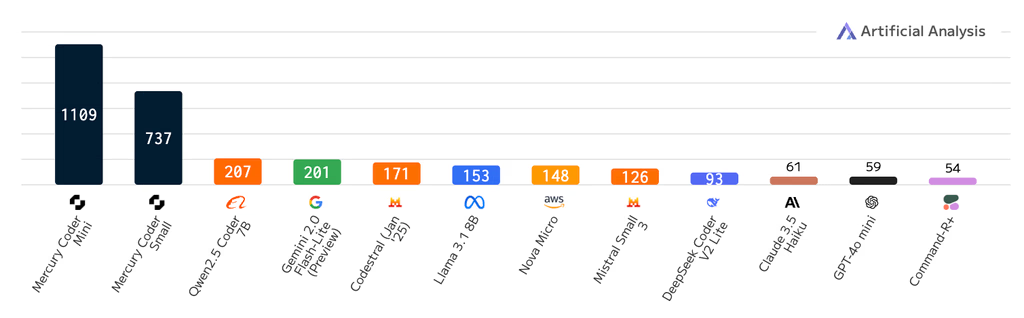

Mercury Coderは標準的なコーディングベンチマークで既存の速度最適化モデルと同等以上の品質を達成しながら、大幅な速度向上を実現している。以下の表はMercuryと競合モデルの主要ベンチマークにおけるパフォーマンス比較を示したものだ:

| モデル | 処理速度 (トークン/秒) | HumanEval | MBPP |

|---|---|---|---|

| Mercury Coder Mini | 1,109 | 88.0% | 77.1% |

| Mercury Coder Small | 737 | 90.0% | 76.6% |

| Gemini 2.0 Flash-Lite | 201 | 90.0% | 75.0% |

| Claude 3.5 Haiku | 61 | 86.0% | 78.0% |

| GPT-4o Mini | 59 | 88.0% | 74.6% |

| Qwen 2.5 Coder 7B | 207 | 90.0% | 80.0% |

| DeepSeek Coder V2 Lite | 92 | 92.1% | 81.0% |

Mercury Coder Miniは、HumanEval(コード生成能力を評価する標準ベンチマーク)で88.0%、MBPP(より幅広いプログラミングタスクを評価)で77.1%のスコアを記録し、これはGPT-4o Miniと同等のパフォーマンスだが、処理速度では毎秒1,109トークンとGPT-4o Miniの59トークン/秒と比較して約19倍速い。

同様に、Gemini 2.0 Flash-Lite(201トークン/秒)の約5.5倍、Claude 3.5 Haiku(61トークン/秒)の約18倍の速度を誇る。この処理速度は通常、Groq、Cerebras、SambaNova等の特殊ハードウェアでしか達成できなかったレベルだ。

また、開発者がコード補完を評価するCopilot Arenaでは、Mercury Coder Miniが2位タイに入り、GPT-4o MiniやGemini-1.5-Flash、さらには大規模モデルであるGPT-4oをも上回るパフォーマンスを示した。

拡散モデルのトレードオフと利点

拡散モデルにはいくつかのトレードオフが存在する。完全な応答を生成するためには、ネットワークを複数回通過させる必要がある。これに対し、従来のモデルではトークンごとに1回の通過で済む。しかし、拡散モデルはすべてのトークンを並列処理するため、このオーバーヘッドにもかかわらず高いスループットを実現している。

拡散モデルの主な利点は以下のとおりである:

- 並列処理による高速生成 – 従来のLLMが1トークンずつ順次生成するのに対し、拡散モデルは並列で生成

- 推論コストの削減 – 効率的なGPU活用により、従来のLLMよりもコスト効率が高い

- エラー修正能力 – 以前の出力のみを考慮する制限がないため、間違いや幻覚を修正しやすい

- 応答の構造化 – 全体を見渡せるため、より論理的で構造化された応答が可能

AIの未来に与える影響

こうした速度と効率性の向上は、AIの実装コストという大きな課題に対処する可能性を秘めている。LLMは大量の計算能力を必要とし、推論トレースの複雑さが増すにつれてコスト削減が困難になっている。Mercuryの拡散ベースのアプローチは、推論の価格を劇的に下げることでAIをより身近なものにする可能性がある。

「我々のモデルははるかに効率的にGPUを活用します」とErmon氏は述べている。「これは大きな変化です。言語モデルの構築方法を変えることになるでしょう。」

他の速度重視のAIソリューションが特殊なチップに依存しているのとは異なり、Mercuryの速度向上はハードウェア依存ではなくアルゴリズムの進歩によるものだ。これは、GPU技術が進化し続けるにつれ、Mercuryのパフォーマンス向上がさらに加速する可能性があることを意味する。

Inceptionは、今後のDLMがもたらす新たな可能性として以下を挙げている:

- 改良されたエージェント – 広範な計画と長い生成を必要とするエージェント型アプリケーションに最適

- 高度な推論 – 現在の自己回帰型推論モデルが数分かかるのに対し、数秒で考えながら幻覚を修正し回答を改善

- 制御可能な生成 – 出力を編集しトークンを任意の順序で生成、テキストの埋め込みや安全性などの目的に合わせて出力を調整

- エッジアプリケーション – スマートフォンやラップトップなどのリソース制約のある環境に適した効率的なモデル

Mercuryの速度向上が特に大きな影響を与える可能性がある分野としては、インスタントレスポンスが開発者の生産性に影響する可能性のあるコード補完ツール、会話型AIアプリケーション、モバイルアプリケーションなどのリソース制限のある環境、迅速な応答が必要なAIエージェントが挙げられる。

業界の反応と展望

Mercuryの発表は業界リーダーからも注目を集めている。Andrew Ng氏はトランスフォーマーがLLMテキスト生成を支配してきたことに言及し、「これは拡散モデルを代替手段として探求するクールな試みです。粗から細へのプロセスを使用して、同時にテキスト全体を生成するものです。おめでとう@StefanoErmonとチーム!」と評価した。

元OpenAI研究者のAndrej Karpathy氏もX(旧Twitter)で「このモデルは異なる可能性があり、新しくユニークな心理、または新しい長所と短所を示す可能性があります。人々に試してみることをお勧めします!」とコメントしている。

インディペンデントAI研究者のSimon Willison氏はArs Technicaに対し「人々がトランスフォーマーに代わる代替アーキテクチャを実験していることが大好きです。それはLLMの領域でまだ探索が始まっていない部分がいかに多いかを示すもう一つの例です」と述べた。

テキスト生成に拡散モデルを採用するアプローチがGPT-4oやClaude 3.7 Sonnetなどの大規模モデルのパフォーマンスに匹敵できるか、信頼性の高い結果を提供できるか、そしてますます複雑化するシミュレーション推論タスクに対応できるかについては、まだ疑問が残る。しかし、現時点ではこれらのモデルはスピードを犠牲にすることなく機能を提供する小規模AIモデルの代替手段を提供する可能性がある。

提供形態と今後の展開

Mercuryは現在、エンタープライズ顧客向けにAPIとオンプレミス展開を通じて提供されており、既存のハードウェア、データセット、監視付きファインチューニング(SFT)およびアライメント(RLHF)パイプラインと完全に互換性がある。両方の展開オプションでファインチューニングのサポートが利用可能だ。

Inception Labsは既に複数のFortune 100企業をクライアントとして獲得しているが、具体的な企業名は公表されていない。同社の共同創設者はソーシャルメディアで「言語生成の現状に挑戦しています。最初の結果は、最先端の速度最適化されたLLMの品質に匹敵しながら、毎秒1000トークン以上の超高速言語生成をもたらします」と述べている。

Mercury Coderはdシリーズの最初のモデルであり、チャットアプリケーション向けのモデルは現在クローズドベータ版で提供されている。誰でもInceptionのプレイグラウンドでMercury Coderの機能を体験できる。

Source

コメント