Googleは12月12日、次世代AIモデル「Gemini 2.0」を発表した。画像と音声の生成機能を新たに搭載し、複数のツールを連携させた自律的なタスク実行を可能にした新モデルは、AIの活用領域を大きく広げる可能性を秘めている。

進化したマルチモーダル機能と高速処理の実現

Gemini 2.0の実験版である「2.0 Flash」は、その前身となるモデルから大きく性能を向上させ、マルチモーダル処理の新たな地平を切り開いている。最も注目すべき進化は、テキストだけでなく、画像生成や音声生成をネイティブに行える機能を獲得したことである。これにより、ユーザーは自然な対話を通じて、複数のメディア形式を横断した複雑なタスクを実行できるようになった。本日より、全てのGeminiユーザーに向けて試験提供が開始されるとのことだ。

音声生成においては、八種類の異なるアクセントと言語に最適化された音声を使用可能で、さらに話す速度の調整など細かな制御にも対応している。Google DeepMindのTulsee Doshi氏によれば、海賊のような特殊な話し方まで再現できるという柔軟性を持ち合わせている。

処理速度においても大きな前進を遂げており、前モデルの「Gemini 1.5 Pro」と比較して2倍の高速化を実現している。注目すべきは、この速度向上が性能の犠牲を伴っていない点である。むしろ、コーディングや画像解析などの複雑なタスクにおいて、1.5 Proを上回る性能を示している。特に数学的な問題解決能力と事実に基づく正確な応答能力において、顕著な改善が見られる。

さらに、Gemini 2.0は外部ツールとの連携においても革新的な機能を備えている。Google検索との直接的な連携により、リアルタイムの情報アクセスが可能となり、またコード実行機能によってプログラミング関連のタスクをより効率的に処理できる。これらの機能は、APIを通じて第三者の開発者も利用可能となっており、新しいアプリケーションの開発可能性を大きく広げている。

セキュリティ面では、生成された画像や音声に対して、GoogleのSynthID技術による電子透かしが自動的に適用される。これにより、AIによって生成されたコンテンツの識別が可能となり、深刻化するディープフェイクの問題に対する一定の対策となることが期待される。

3つの革新的なAIエージェントの登場

Googleは今回の発表で、Gemini 2.0をベースとした3つの実験的AIエージェントを披露した:

- Project Astra:複数言語での会話やGoogle製品との連携機能を備えた万能型AIアシスタント

- Project Mariner:Chromeブラウザ上で実際のWebタスクを実行できる拡張機能

- Jules:開発者向けのコード支援に特化したAIエージェント

特にProject Marinerは、WebVoyagerベンチマークにおいて83.5%という高い成功率を達成し、自律的なWebナビゲーションの可能性を示している。各項目については後ほど別の記事で詳しくお伝えしたい。

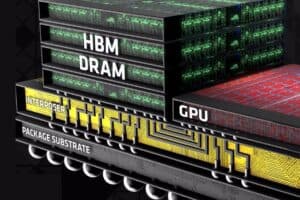

インフラストラクチャの強化

Gemini 2.0の革新的な機能を支えているのは、Googleが新たに開発した第6世代のTensor Processing Unit(TPU)、「Trillium」である。このカスタム設計されたAIアクセラレータは、Googleのインフラストラクチャ戦略における重要な転換点を示している。Googleは単一のネットワークファブリックに10万個以上のTrilliumチップを統合することで、前例のない規模の並列処理能力を実現した。

特筆すべきは、Gemini 2.0の学習(トレーニング)と推論(インファレンス)の全工程において、Trilliumが100%活用されている点である。これは、モデルの開発段階から実運用に至るまで、一貫した処理アーキテクチャを採用していることを意味する。この統一されたインフラストラクチャは、モデルの性能最適化とコスト効率の向上に大きく貢献している。

Google AI StudioとGemini APIのプロダクトマネージャー、Logan Kilpatrick氏が明らかにしたところによると、この強化されたインフラストラクチャは既に顕著な成果を上げている。Flashモデルの利用率は実に900%以上の増加を記録し、数百万人の開発者がGeminiプラットフォームを活用するまでに成長している。また、過去数ヶ月間で6つの実験的なモデルがローンチされ、継続的な技術革新を支える基盤となっている。

さらに注目すべき点は、GoogleがTrilliumを一般のクラウド顧客にも開放したことである。これにより、企業や開発者は同等の高性能コンピューティングリソースを活用して、独自のAIソリューションを開発できるようになった。この決定は、Googleのインフラストラクチャ投資が単なる自社サービスの強化にとどまらず、AIエコシステム全体の発展を視野に入れた戦略的な取り組みであることを示している。

このインフラストラクチャの強化は、特に新しいMultimodal Live APIの実装において重要な役割を果たしている。このAPIは、リアルタイムの音声・動画ストリーミング入力や複数ツールの統合的な利用を可能にし、より動的でインタラクティブなアプリケーション開発の基盤となっている。音声の中断にも対応可能な自然な会話パターンの処理など、高度な機能の実現にはこの強化されたインフラストラクチャが不可欠である。

Xenospectrum’s Take

Gemini 2.0の発表は、GoogleがOpenAIやAnthropicとの競争において、独自の戦略的方向性を示したものと解釈できる。特筆すべきは、単なる言語モデルの性能向上ではなく、実世界でのタスク実行能力の獲得を重視している点だ。

しかし、自律型AIの実現には新たな安全性とセキュリティの課題が伴う。Googleは段階的な展開アプローチを採用し、信頼できるテスター群による検証を重視しているものの、この技術が社会に与える影響については慎重な検討が必要だろう。皮肉なことに、AIの「自律性」を高めれば高めるほど、人間による監督の重要性も増すことになるのかもしれない。

Source

コメント