OpenAIはGoogleの開発者会議の前日に「ChatGPT-4o」を発表し、またもや世界に衝撃を与えた。公開されたデモビデオの数々は、SFの中に存在したAIアシスタントそのものであり、スマートフォンのカメラを通して得られた入力も認識し、ユーザーとやりとりをしてくれる。その自然で感情表現豊かな様子は時に不気味なほど人間味溢れる物だった。

これに対するGoogleの答えは、本日のGoogle I/O 2024で登場した「Project Astra」だ。このAIアシスタントは、スマートフォンやスマートグラスからの入力を使い、音声でユーザーと自然なやりとりが出来る物だ。

Project AstraはGoogleのGPT-4oへの回答

Google DeepMindの責任者でありGoogleのAI開発を率いているDemis Hassabis氏はGoogle I/Oで、“ユニバーサル/アシスタント”となるべく開発を行っているProject Astraの初期バージョンを披露した。これはリアルタイムの応答性を備えたマルチモーダル・AIアシスタントだ。“アシスタント”と言う言葉の通り、Project AstraのAIはユーザーの“手助け”をしてくれるわけだが、以下の動画をご覧になればこの言葉が想像以上に高度なレベルで実現されていることに驚くのではないだろうか。ちなみにHassabis氏曰く「捏造や加工は一切していない」とのことだ。

動画はGoogleのロンドンオフィスで撮影された物だが、テスターがAstraを使いスピーカーのパーツの名称を教えてもらったり、画面に映ったコードの見直しをしてもらったり、外の景色の映して自分がどこにいるのか教えてもらったりするが、驚くべきは、メガネをどこに置き忘れたのかを教えてもらう事だ。「私の眼鏡をどこで見たか覚えている?」と、テスターが尋ねると、「はい、覚えています」とAstraは答え、「あなたのメガネは赤いリンゴの近くの机の上にありました」と教えてくれている。動画では特にメガネを置いた場所を覚えておいて欲しい等のやりとりはないため、詳細は不明だが、Astraはその場所を記憶しており、ユーザーに的確なアドバイスを与え、探し物を見つけ出す手助けをしている。これらがほぼリアルタイムで行われるのだ。

その後、テスターがそのメガネをかけると動画はARメガネを通して見る景色に変わっている。メガネは装着者の周囲をスキャンし、ホワイトボード上の図のようなものを見る。テスターが、「このシステムをより速くするために、ここに何を追加できますか?」と尋ねると、Astraは、「サーバーとデータベースの間にキャッシュを追加することで、スピードが向上する可能性がある」と、アドバイスをしてくれている。

Project Astraの仕組みは?

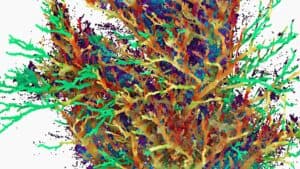

Project Astraの驚くべき点は、視覚データをリアルタイムで処理するだけでなく、見たものを記憶し、記憶された情報のバックログと効率的に連携している点にある。Hassabis氏によれば、この「エージェント」は「ビデオフレームを連続的にエンコードし、ビデオと音声入力をイベントのタイムラインに組み合わせ、効率的に呼び出すためにこの情報をキャッシュすることで、より速く情報を処理するように設計されている」ため、このようなことが可能になったのだという。

動画の中でも現行のGoogleアシスタントよりもAstraの応答速度が素晴らしい物を見せていたが、Hassabis氏はブログの中で、「マルチモーダル情報を理解できるAIシステムの開発は驚くほど進歩したが、応答時間を会話できるレベルまで短縮するのは工学的に難しい課題である」と述べている。実際の所、応答速度の点では昨日OpenAIが発表したChatGPT-4oの方がよりスムーズで自然な印象を与える。

Googleは応答速度の他に、AIに音声表現の幅を与えることにも取り組んでおり、音声モデルを使って“声の出し方を強化し、エージェントに幅広いイントネーションを与えている”という。

Project Astraはまだ初期段階の機能であり、具体的なリリース計画はないが、Googleはこれらの機能の一部が今年後半にGeminiアプリのような製品に統合される可能性を示唆しており(「Gemini Live」と呼ばれる機能)、役に立つAIアシスタントの開発における重要な一歩となる。これは、Google CEOのSundar Pichai氏が説明するように、「あなたの代わりに先を読み、推論し、計画を立てる」ことができる「エージェンシー」を持つエージェントを作り出そうという試みだ。Hassabis氏によれば、今後AIは、モデルそのものではなく、AIがあなたのために何ができるかに集約される。AI開発も次のフェーズへと移ってきたのかも知れない。

Source

コメント