新しいスマートフォンがAI(人工知能)を活用した機能を搭載して発売されている。最新の例としては、GoogleのフラッグシップモデルであるGoogle Pixel 9がある。2024年初頭に発売されたSamsungのGalaxy S24も、AIを活用した様々な写真編集機能を特徴としている。

これらのデバイスの背後にある隠れた物語は、企業がAI機能に必要な処理をクラウドから手のひらにある端末へと移行させることに成功した点である。

Google Pixel 9では、編集マジックと呼ばれる機能により、ユーザーは生成AIを使用して写真を「再構築」することができる。実際には、これは写真の被写体の位置を変更したり、背景から他の人物を消去したり、灰色の空を青い空に調整したりする機能を意味する。適切なプロンプトを提供し、アプリにその処理を任せるだけである。

このスマートフォンの生成AI機能は、テキストプロンプトを入力することで、写真に人物やオブジェクトを追加することも可能にする。

もちろん、ユーザーはこれまでも写真編集ソフトウェアを使ってこのような編集を行うことができたが、自然な仕上がりにし、明らかに編集されたように見せないようにするには、ある程度のスキルが必要だった。編集マジックは、AIを使用してこれらの複雑な写真編集を「シンプルで直感的な操作」で実行することを約束している。

「一緒に写る」と呼ばれる別の機能では、見知らぬ人にスマートフォンを渡すことなく集合写真を撮ることができる。スマートフォンの所有者がグループの写真を撮り、その後友人にスマートフォンを渡して、先ほど撮影した場所に自分が入る。スマートフォンは2つの写真をつなぎ合わせる。

「ベストテイク」と呼ばれる別の機能は、非常に似た一連の画像から最良の要素を選択し、それらすべてを1枚の写真に組み合わせるために使用できる。Googleのチャットボット技術は、デジタルアシスタントやその他の機能をスマートフォン上で実現している。

スマートフォンの機能は、最初のデジタル携帯電話の時代や、携帯電話に独自のカメラが搭載され始めた頃から大きく進化している。

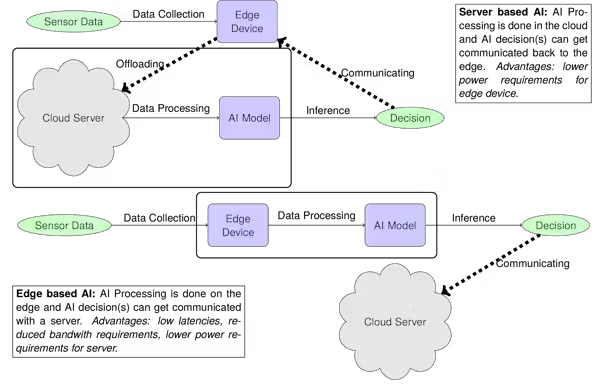

エッジAIへ

従来、このようなAIベースの機能に必要な処理は、スマートフォンのようなデバイスでホストするには負荷が高すぎた。代わりに、大型の強力なコンピューターサーバーによって駆動されるオンラインクラウドサービスにオフロードされていた。

しかし、企業はますます多くの処理を顧客のデバイスで実行する必要性を認識し、潜在的に消費者の手により大きな制御力を置くようになっている。

これには、企業が「エッジ」と呼ぶものに大量のAI計算処理を移行することが含まれる。エッジとは、通常、処理性能が低下したスマートフォンのような消費者向けデバイスを指す。

クラウドベースのAIとエッジベースのAIの動作の違い:

これを実現するには、処理に必要な電力需要を削減する必要がある。企業は、AIベースのプロセスに特化した専用マイクロプロセッサーを用いてこの移行を実現した。

例えば、GoogleのTensor AIプロセッサー(Tensor Processing Units、TPUと呼ばれる)は、Pixelモバイルで利用可能な機能の中心的な役割を果たしているように見える。エッジベースのプロセッサーは、専用ソフトウェアを使用して、モバイルデバイスで取得または保存されたデータにAIモデルを効率的に適用することができる。

これらのTPUには、システムアレイと呼ばれるコンポーネントのネットワークが含まれており、大量のデータを同時に処理することができる。この効率的な設計により、電力と計算時間を節約できる。

これは、1つのAI決定を行うために実行する必要がある膨大な数の計算のために重要である。GoogleのTPUなどのプロセッサーは、ここ数年でこの点において大幅に改善されている。

実際、2015年に最初に設計されたTPUは、AIモデルのトレーニング中に大規模なクラウドベースのサーバーが実行する計算を高速化するのに役立つように作られた。2018年には、「エッジ」のコンピューターで使用するために設計された最初のTPUがGoogleによってリリースされた。そして2021年には、スマートフォン用に設計された最初のTPUが登場した – これもGoogleのPixel向けである。

モバイルデバイスにさらに多くのAIを統合する競争は激しい。つまり、今後数年でさらに革新的な技術が市場に登場する可能性が高いだろう。

コメント