意外かも知れないが、GPT-4やGeminiなど、最先端の大規模言語モデルは計算が苦手だ。

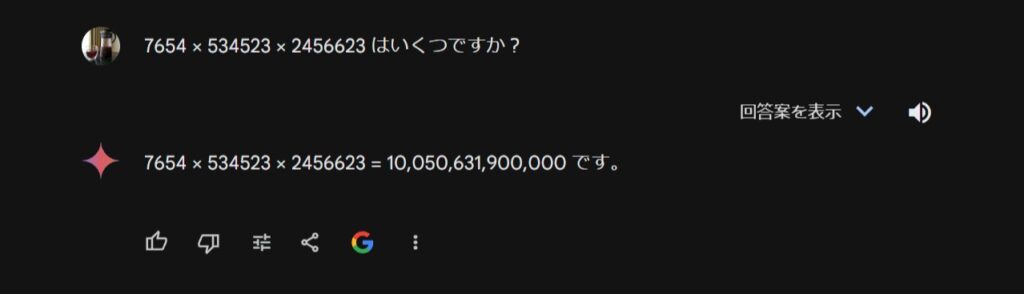

例えば、GoogleのGeminiに以下の通り少し長い計算を依頼してみると完全に間違える。(ライバルのGPT-4oは内部で別に計算を行うように受け渡す事で、こうした長大な数字の計算についても間違わずに行えるように進化しているようだ)。

だが、これらは根本的に“言語モデル”であり、それらが基づく機械学習モデル「Transfomer」そのものの問題でもあった。

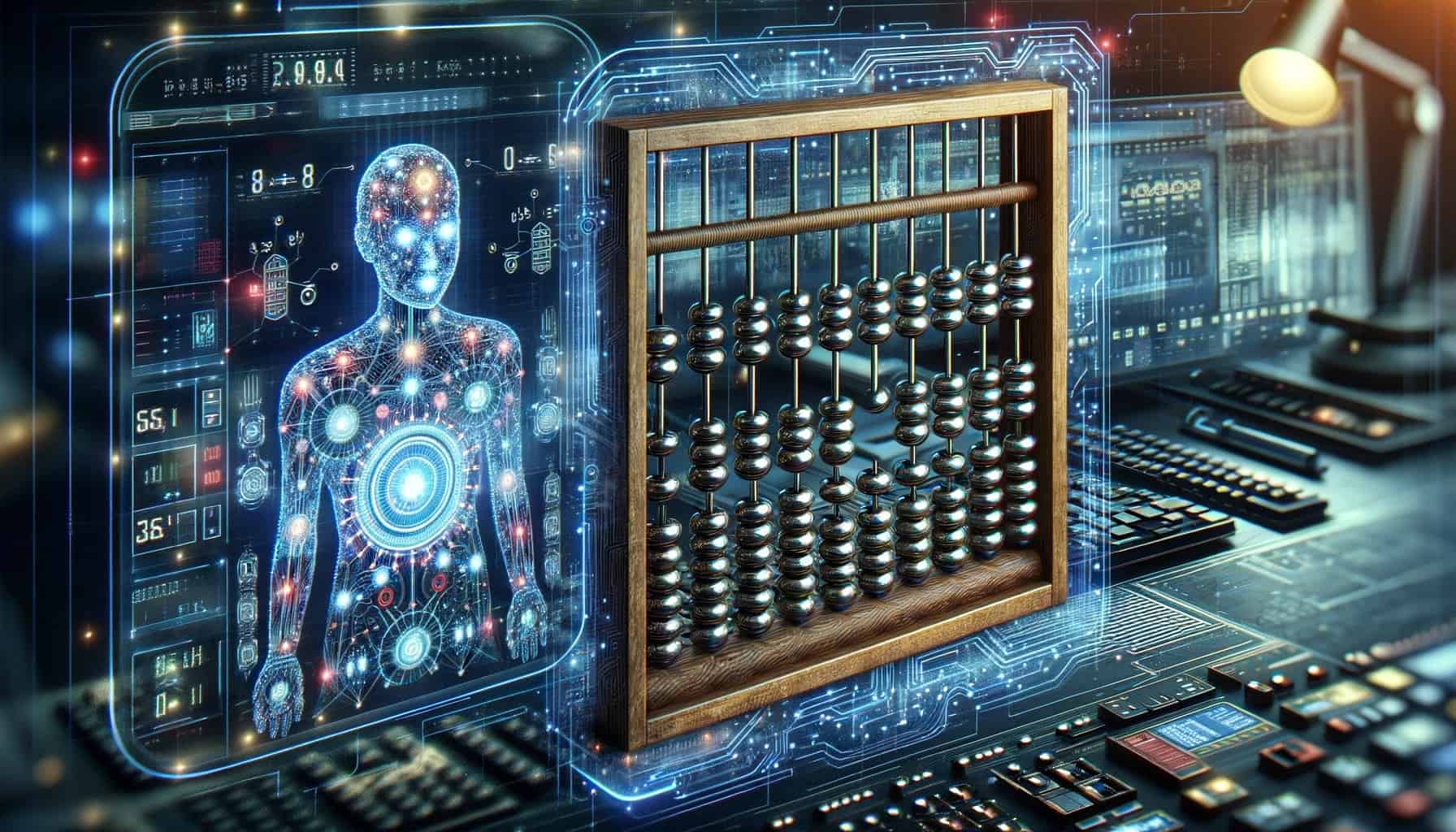

今回メリーランド大学、ローレンスリバモア国立研究所、ELLIS Institute Tübingen、Max Planck Institute for Intelligent Systems、Tübingen AI Center、およびCarnegie Mellon Universityの研究チームは、こうした計算タスクにおけるAI言語モデルの能力を飛躍的に向上させる新しい方法として、“そろばん”を埋め込む事でこれを実現した事を報告している。

そろばんのように桁の正確な位置合わせが複雑な計算の鍵に

従来のAI言語モデルは、例えば最大20桁の数字でトレーニングをされていた場合、最大100桁の非常に長い加算を正確に実行するのは難しかった。これは、モデルが長い数字内の桁の位置を見失うためである。

今回研究者らが考案した、「Abacus(そろばんの原型)Embeddings」メソッドは、各桁に特定の位置を割り当てることで、そろばんのように桁の正確な位置合わせと加算を可能にする。この方法により、モデルは桁を正しく一列に並べ、それらを位置ごとに加算することができるようになるのだ。

Abacus Embeddingsは、性能の飛躍的な向上を可能にする このアプローチにより、研究者たちはAIモデルの精度と一般化能力を大幅に向上させることができた。20桁の数字で訓練されたモデルが、ほぼエラーなしで最大120桁の加算を解決した。これは一般化の係数6に相当し、従来の最高値であった2.5を大きく上回る。

研究者たちは、Abacus埋め込みを特別なネットワークアーキテクチャと組み合わせることで、さらに良い結果を達成したと報告している。「Looped Transformers」や「入力インジェクション」を用いることで、入力データが各ネットワーク層に供給され、エラー率がわずか0.9%に減少した。

研究者らはこのアプローチを最大15桁の乗算や数列のソートにも成功裏に適用し、Abacus Embeddingsがモデルの性能を大幅に向上させる大きな可能性を再び実証した。

これにより、正確な数値処理が求められる金融や科学計算などの分野におけるAI性能の向上が見込まれる。長期的には、アルゴリズムトレーディング、データ分析、科学研究などの分野における複雑な問題解決においてAIの役割を革命的に変える可能性があり、これらの分野内での競争環境を再構築することが予想される。

しかし、計算能力の制限により、チームは自然言語でのテストは実施していない事も合わせて報告している。

論文

参考文献

- The Decoder: Abacus embeddings help AI models sort out their arithmetic issues and tackle longer calculations

研究の要旨

算術演算タスクにおけるTransfomerモデルの性能の低さは、大きな桁のスパンにおける各桁の正確な位置を追跡できないことに大きく起因しているようだ。この問題を解決するために、各桁に埋め込みを追加し、数字の先頭からの相対的な位置をエンコードする。エンベッディングはそれ自体で性能を向上させるだけでなく、この修正によって、入力注入やリカレント層などのアーキテクチャの変更が可能になり、性能がさらに向上することを示す。位置が解決されたことで、変換器の論理的外挿能力を研究することができる。訓練データよりも大きく複雑な算術問題を解くことができるだろうか?GPU1台で20桁の数字を1日トレーニングするだけで、100桁の足し算問題で最高99%の精度を達成し、最先端の性能を達成できることがわかった。最後に、このような計算能力の向上が、並べ替えや掛け算を含む他の多段階推論タスクの向上にもつながることを示す。

コメント