人工知能(AI)技術の急速な発展に伴い、その膨大な電力消費が深刻な問題となっている中、画期的な解決策が登場した。BitEnergy AI社の研究チームが開発した新アルゴリズム「Linear-Complexity Multiplication(L-Mul)」は、AIモデルの電力消費を最大95%削減できる可能性を秘めている。

L-Mulアルゴリズム:AIの電力効率を根本から変える革新

L-Mulは、AIの計算プロセスにおいて最もエネルギー消費の大きい浮動小数点乗算を、はるかに効率的な整数加算で近似する手法を採用している。この革新的なアプローチにより、AIモデルの演算効率が飛躍的に向上し、同時に精度も維持されることが期待されている。

従来のAIモデルでは、大規模な行列演算や要素ごとの乗算に浮動小数点演算を多用していた。これらの演算は高い精度を実現する一方で、大量の電力を消費する要因となっていた。L-Mulは、これらの複雑な浮動小数点乗算を、より単純な整数加算で近似することで、計算効率を劇的に改善する。

BitEnergy AI社の研究者らは、「要素ごとの浮動小数点テンソル乗算のエネルギーコストを95%削減し、内積計算のエネルギーコストを80%削減できる可能性がある」と主張している。この革新的な手法は、AIモデルの演算効率を根本から変える可能性を秘めており、AI技術の持続可能性に向けた重要な一歩となる可能性がある。

従来のAI計算と比較した技術的優位性

L-Mulアルゴリズムの革新性は、その計算方法にある。従来の浮動小数点乗算では、指数部の加算、仮数部の乗算、そして丸め処理という複雑な手順が必要だった。これに対し、L-Mulは整数加算を用いて浮動小数点乗算を近似することで、計算の複雑さを大幅に削減している。

具体的には、L-Mulは浮動小数点数の乗算を以下の式で近似している:

L-Mul(x, y) = (1 + x_m + y_m + 2^(-l(m))) * 2^(x_e+y_e)

ここで、x_m、y_mは仮数部、x_e、y_eは指数部を表す。この近似により、複雑な乗算操作を加算操作に置き換えることが可能となる。

研究チームの解析によると、L-Mulは8ビット浮動小数点(fp8)の乗算と比較して、より高い精度を維持しつつ、計算量を大幅に削減できることが示されている。例えば、fp8 e4m3形式の乗算では約325の演算が必要なのに対し、L-Mulでは157の演算で済むという。

さらに、L-Mulは従来の8ビット標準を上回る精度を達成しつつ、ビットレベルの計算量を大幅に削減できることが示されている。これにより、AIモデルの性能を損なうことなく、エネルギー効率を飛躍的に向上させることが可能となる。

ベンチマークテストと実証結果

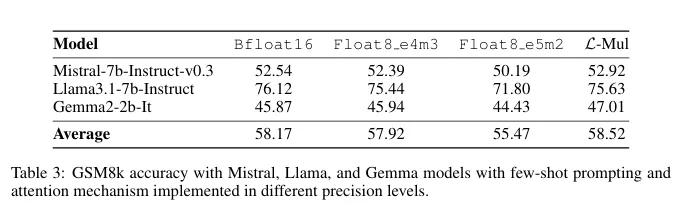

L-Mulの有効性を検証するため、研究チームは自然言語処理、視覚タスク、および記号推論など、さまざまなAIタスクにおいてベンチマークテストを実施した。その結果、L-Mulを用いた場合の性能低下はわずか0.07%に留まり、エネルギー節約効果と比較すると無視できるレベルであることが明らかになった。

特筆すべきは、Transformerベースのモデル、特に大規模言語モデル(LLM)におけるL-Mulの効果である。L-Mulは、これらのモデルの計算集約的な部分である注意機構(Attention Mechanism)にシームレスに統合できることが示された。

具体的な実験結果として、以下のようなデータが報告されている:

- Mistral-7b-Instruction-v0.3モデルでのMMULベンチマークにおいて、L-Mulを使用した場合の精度(62.19%)は、BFloat16(62.20%)とほぼ同等であり、Float8 e4m3(62.18%)やFloat8 e5m2(61.75%)を上回った。

- Llama-3.1-8B-Instructモデルでも同様の傾向が見られ、L-Mul(74.00%)はBFloat16(74.24%)に迫る精度を示し、Float8 e4m3(73.40%)やFloat8 e5m2(71.86%)を上回った。

- 視覚言語タスクにおいても、Llava-v1.5-7bモデルを使用したテストで、L-Mulはほとんどの場合でBFloat16と同等以上の性能を示した。

これらの結果は、L-Mulが理論上の効率性だけでなく、実際のAIタスクにおいても高い有効性を持つことを示している。特に、追加のトレーニングなしで既存のモデルに適用できる点は、実用化に向けて大きな利点となる。

AIの持続可能性への影響

L-Mulアルゴリズムの登場は、AIの持続可能性に関する議論に新たな展開をもたらす可能性がある。現在、AIの電力消費は急速に増加しており、例えばChatGPTは1日あたり564MWhもの電力を消費している。これは約18,000世帯の家庭の1日の電力使用量に相当する。

Cambridge Centre for Alternative Financeの推計によると、AI産業全体の年間電力消費量は2027年までに85〜134TWhに達する可能性があり、これはビットコインマイニング操作と同程度の規模となる。このような状況下で、L-Mulのような革新的技術は、AIの発展と環境負荷の軽減を両立させる重要な役割を果たすことが期待される。

L-Mulの実用化に向けては、いくつかの課題も存在する。最大の課題は、現在のハードウェアがL-Mulの利点を最大限に活かせるよう最適化されていない点である。研究チームは、L-Mul計算をネイティブにサポートする特殊なハードウェアの開発計画を示唆している。

「L-Mulとそのカーネルアルゴリズムをハードウェアレベルで実装し、高レベルのモデル設計のためのプログラミングAPIを開発する予定です」と研究チームは述べている。これが実現すれば、高速で正確、かつ非常に省エネルギーな新世代のAIモデルの登場につながる可能性がある。

一方で、業界内での採用にはいくつかの障壁が予想される。特に、AI用ハードウェア開発で主導的立場にあるNVIDIAのような企業が、市場シェアを維持するために新技術の採用を妨げる可能性も指摘されている。

しかし、AIの持続可能性がますます重要な課題となる中、L-Mulのような革新的技術は、長期的には業界全体に大きな影響を与える可能性が高い。エネルギー効率の高いAI技術の実現は、データセンター、ロボティクス、エッジコンピューティングデバイスなど、幅広い分野でのAI活用を促進し、技術の民主化にも貢献することが期待される。

論文

参考文献

研究の要旨

コメント