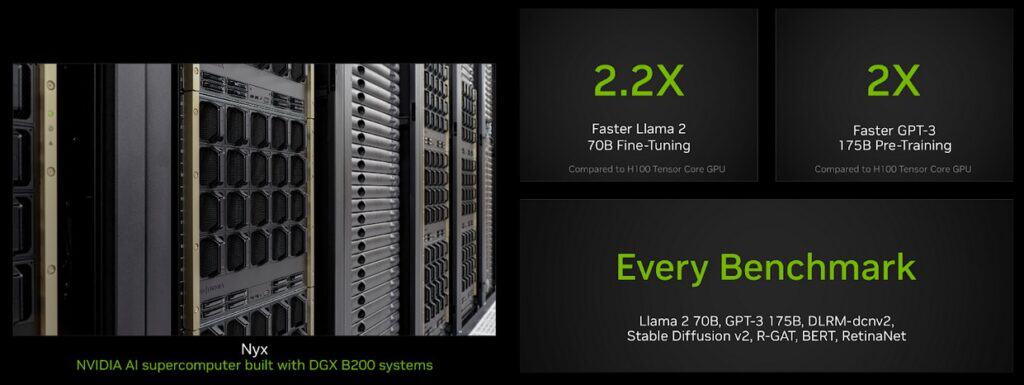

NVIDIAの次世代AIアクセラレータ「Blackwell」が、MLPerf Training 4.1ベンチマークにおいて、前世代Hopperと比較して最大2.2倍の性能向上を達成した。特にLLMのファインチューニングと事前学習において顕著な性能向上が確認され、AIトレーニング市場における同社の優位性を一層強化する結果となった。

ベンチマーク詳細と性能向上の実態

MLPerf Training 4.1ベンチマークにおいて、NVIDIAのBlackwellプラットフォームは複数の重要なAIワークロードで前世代を大きく上回る性能を示した。最も顕著な性能向上が見られたのはLlama 2 70Bのファインチューニングで、GPU1基あたりの性能がHopperと比較して2.2倍に達している。また、大規模言語モデルの事前学習においても際立った成果を上げており、GPT-3 175Bの事前学習では2倍の性能向上を記録した。画像生成モデルの分野でも着実な進歩が見られ、Stable Diffusion v2のトレーニングでは1.7倍の性能向上を達成している。

特に注目に値するのは、GPT-3 175Bベンチマークにおける必要計算リソースの劇的な削減だ。従来のHopperアーキテクチャでは256基のGPUを必要としたワークロードを、Blackwellは64基で同等の性能で処理可能となった。この効率化は、新世代HBM3eメモリの採用による最大8TBpsという圧倒的な帯域幅と、新設計のTensor Coreカーネルの効率的な活用によって実現された。GPU数の削減は、データセンターの電力消費とインフラストラクチャコストの大幅な低減に直結する重要な進展といえる。

このベンチマーク結果は、NVIDIAのNyxスーパーコンピューターを用いて実施された。同システムはDGX B200システムで構成され、1基あたり9ペタFLOPSのFP8演算性能を誇るB200 GPUを搭載している。さらに注目すべきは、これらの性能値が初期のベンチマーク結果であるという点だ。NVIDIAの過去の実績から、ソフトウェアスタックの最適化や次世代ConnectX-8 SuperNICによる800GbpsへのInfiniBand帯域幅の倍増により、今後さらなる性能向上が期待できる。事実、現行のHopperプラットフォームでも、初期提出時からソフトウェア最適化によってLLM事前学習において1.3倍の性能向上を達成している実績がある。

アーキテクチャの革新とソフトウェアの最適化

BlackwellアーキテクチャにおけるNVIDIAの技術革新は、ハードウェアとソフトウェアの両面で従来の限界を打ち破る成果をもたらしている。中核となる技術的進展は、新設計されたTensor Coreカーネルの最適化にある。これらのカーネルは行列演算などのディープラーニングアルゴリズムの基礎となる数学的操作を担う重要コンポーネントで、従来よりも効率的な演算処理を実現している。

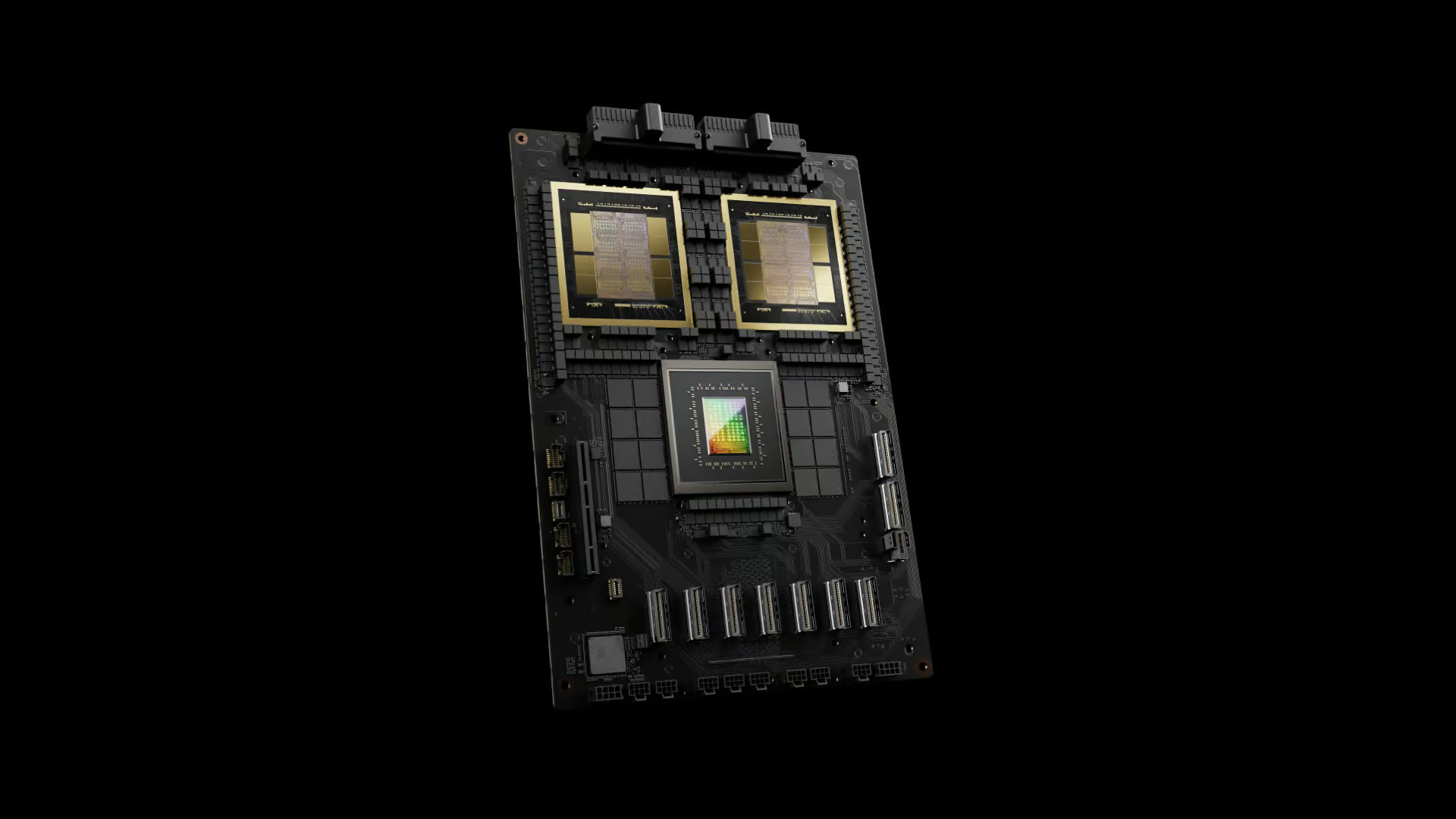

メモリアーキテクチャにおいても大きな飛躍が見られる。新世代のHBM3eメモリの採用により、最大8TBpsという業界最高水準のメモリ帯域幅を実現。この圧倒的な帯域幅は、大規模言語モデルの学習において特に重要となるデータ転送のボトルネックを大幅に軽減している。B200 GPUでは、この強化されたメモリシステムと最適化された演算ユニットにより、FP8精度で9ペタFLOPSという卓越した演算性能を実現している。さらに上位モデルとなるGB200では、1.2キロワットの電力枠で10ペタFLOPSの演算性能を達成する見込みだ。

相互接続技術においても重要な進展が見られる。従来のDGXシステムでは8基のGPUをNVLinkスイッチファブリックで接続し、ノード間の拡張性はInfiniBandリンクに依存していた。Blackwellでは、NVL72リファレンスデザインにより、NVLinkドメインを8基から72基のアクセラレータまで拡張。これにより、より大規模なGPUクラスターでの効率的なデータ通信が可能となっている。

ソフトウェアスタックの最適化も継続的に進められている。現行のHopperプラットフォームでは、CUDAベースのAIソフトウェアスタックの継続的な改善により、初期提出時と比較してGPT-3(175Bトレーニング)で70%の性能向上を達成。512 GPU構成では、HGX A100比で6倍という劇的な性能向上を実現している。さらに、次世代のConnectX-8 SuperNICの導入により、InfiniBand帯域幅は800Gbpsへと倍増する予定だ。

NVIDIAは2025年に向けて、さらなる進化を計画している。次世代となるBlackwell Ultraでは、288GBのHBM3eメモリを搭載し、より大きな演算性能を実現する予定だ。これはB300命名規則で展開される見込みである。その先のRubinプラットフォームでは、2026年に標準モデル、2027年にはHBM4を採用した8Sおよび12Sバリアントの投入が予定されており、継続的な性能向上への取り組みが示されている。

このように、NVIDIAは単なるチップメーカーとしてではなく、データセンターソリューションおよびシステムプロバイダーとしての総合的な技術革新を推進している。現在Blackwellは本格的な量産段階に入っており、今後の四半期で記録的な売上と性能指標が期待される。

Xenospectrum’s Take

BlackwellのMLPerfデビューは、NVIDIAのAIアクセラレータ市場における圧倒的優位性を改めて示した形だ。特に注目すべきは、単純な演算性能の向上だけでなく、必要GPU数の削減による総所有コストの低減も実現している点である。

しかし、真の実力はまだ見えていない可能性が高い。現在のベンチマークはB200ベースのシステムによるものだが、より高性能なGB200や、2025年に予定されているBlackwell Ultraの登場により、さらなる性能向上が期待される。競合他社にとって、這い上がるべき崖はますます高くなったと言えるだろう。

Source

Meta Description

NVIDIAの次世代GPU「Blackwell」がMLPerfベンチマークで前世代比最大2.2倍の性能を達成。HBM3eメモリとTensor Core最適化により、少ないGPU数で高いパフォーマンスを実現。2025年にはさらなる進化も予定。

コメント