1981年、アメリカの物理学者でノーベル賞受賞者のRichard Feynmanは、ボストン近郊のマサチューセッツ工科大学 (MIT)で革新的なアイデアを概説した講演を行った。Feynmanは、量子力学の不思議な物理学を計算に利用できると提案した。

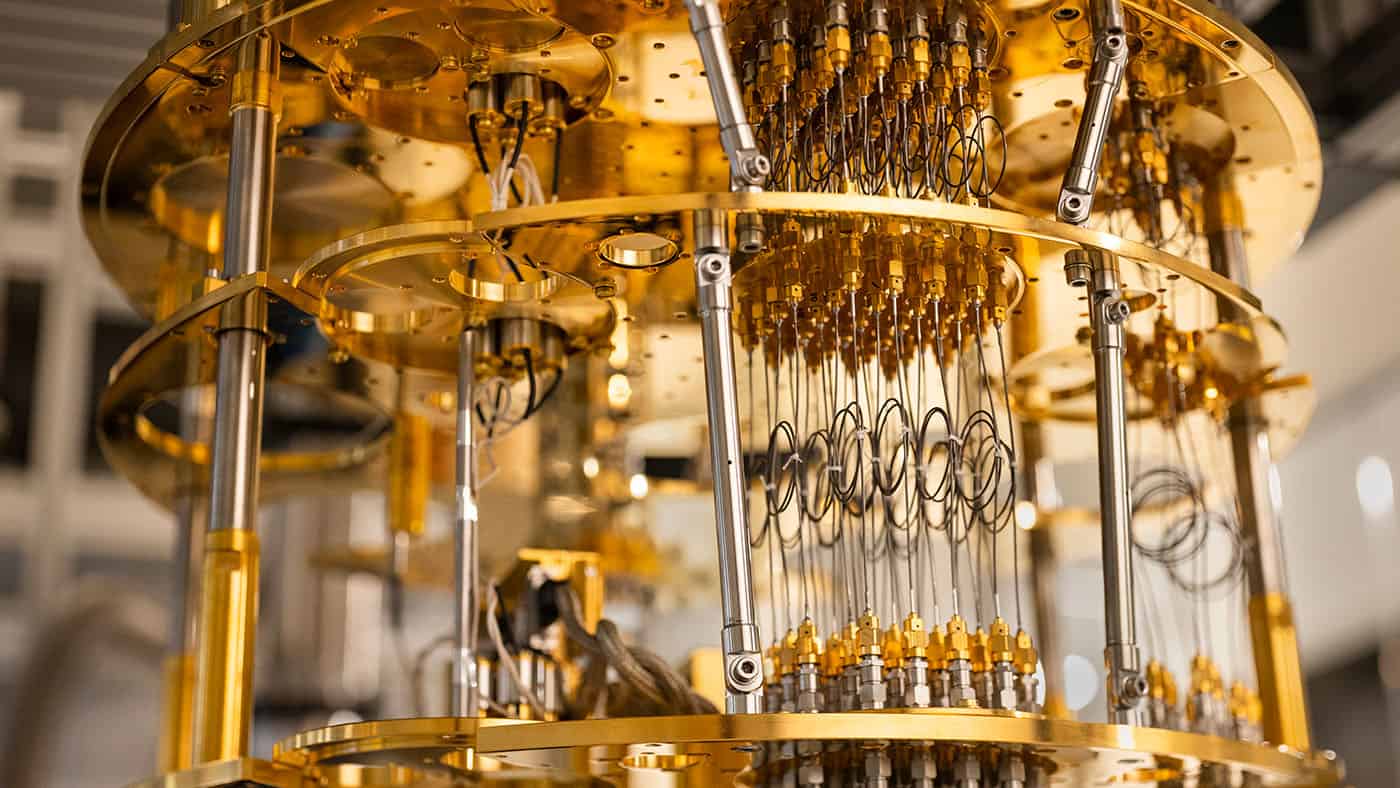

こうして量子コンピューティングの分野が誕生した。その後40年以上にわたり、コンピュータサイエンスにおける集中的な研究分野となっている。懸命な開発が続けられているにもかかわらず、物理学者たちは、日常的な使用や通常の条件下(例えば、多くの量子コンピュータは極低温で動作する)に適した実用的な量子コンピュータをまだ構築できていない。この節目に到達するための最善の方法については、依然として疑問と不確実性が残されている。

量子コンピューティングとは正確には何か、そして私たちはその広範な利用をどの程度間近に控えているのだろうか。まずは、この記事を書くために使用しているラップトップのような、今日私たちが依存している古典的なコンピューティングについて見てみよう。

古典的なコンピュータは、最小のデータ単位である「ビット」の組み合わせを使用して情報を処理する。これらのビットは0か1のいずれかの値を持つ。メールの作成からWebサイトの閲覧まで、コンピュータ上で行うすべての操作は、これらのビットを0と1の文字列として処理することで可能となっている。

一方、量子コンピュータは量子ビット、もしくはキュービットを使用する。古典的なビットとは異なり、量子ビットは単に0または1を表すだけではない。量子重ね合わせと呼ばれる性質により、量子ビットは複数の状態を同時に取ることができる。つまり、量子ビットは0、1、またはその両方を同時に表すことができる。これにより、量子コンピュータは膨大な量のデータと情報を同時に処理することが可能となる。

問題に対するすべての可能な解決策を一度に探索できることを想像してみよう。迷路の中で、すべての可能な経路を同時に試すことで正しい道を見つけることができる。そのため、量子コンピュータは最短経路や最速の方法など、最適な解決策を見つけることが非常に速い。

航空便の遅延や予期せぬ事態の後のフライトスケジュールの再調整という極めて複雑な問題について考えてみよう。これは現実世界で定期的に発生するが、適用される解決策が最善または最適なものではない可能性がある。最適な対応を算出するために、標準的なコンピュータは、フライトの移動、経路変更、遅延、キャンセル、またはグループ化のすべての可能な組み合わせを一つずつ検討する必要がある。

毎日45,000以上のフライトが500以上の航空会社によって運航され、4,000以上の空港を結んでいる。この問題を解決するには、古典的なコンピュータでは何年もかかるだろう。

一方、量子コンピュータはこれらすべての可能性を一度に試すことができ、最適な構成を自然に浮かび上がらせることができる。量子ビットにはまた、もつれと呼ばれる物理的性質がある。キュービットがもつれると、どれだけ離れていても、一方のキュービットの状態は他方の状態に依存することがある。

これもまた、古典的なコンピューティングには存在しない性質である。エンタングルメントにより、量子コンピュータは特定の問題を従来のコンピュータよりも指数関数的に速く解くことができる。

よく聞かれる質問は、量子コンピュータが古典的なコンピュータを完全に置き換えるかどうかである。短い答えは、少なくとも予見可能な将来においては、ノーである。量子コンピュータは特定の問題—例えば、異なる分子間の相互作用のシミュレーション、多くの選択肢から最適な解決策を見つけること、暗号化と復号化の処理など—を解くのに非常に強力である。しかし、あらゆる種類の作業に適しているわけではない。

古典的なコンピュータは計算を直線的な順序で一つずつ処理し、0か1のいずれかである古典的なビットを使用するように設計されたアルゴリズム(特定のコンピューティングタスクを実行するための一連の数学的規則)に従う。これにより、極めて予測可能で堅牢であり、量子マシンよりもエラーが発生しにくい。ワードプロセッシングやインターネットの閲覧といった日常的なコンピューティングのニーズには、古典的なコンピュータが引き続き主要な役割を果たすだろう。

そこには少なくとも2つの理由がある。1つ目は実用的な理由である。信頼性の高い計算を実行できる量子コンピュータを構築することは極めて困難である。量子の世界は非常に不安定で、キュービットは電磁放射などの環境からの干渉によって容易に乱されるため、エラーが発生しやすい。

2つ目の理由は、量子ビットを扱う際の本質的な不確実性にある。量子ビットは重ね合わせの状態(0でも1でもない)にあるため、古典的なコンピューティングで使用されるビットほど予測可能ではない。そのため、物理学者は量子ビットとその計算を確率の観点から記述する。これは、同じ問題を同じ量子アルゴリズムで同じ量子コンピュータ上で複数回実行しても、毎回異なる解が得られる可能性があることを意味する。

この不確実性に対処するため、量子アルゴリズムは通常、複数回実行される。その結果は統計的に分析され、最も可能性の高い解が決定される。このアプローチにより、研究者は本質的に確率的な量子計算から意味のある情報を抽出することができる。

商業的な観点からは、量子コンピューティングの開発はまだ初期段階にあるが、その状況は非常に多様で、毎年多くの新しい企業が参入している。IBMやGoogleのような大手の確立された企業に加えて、IQM、Pasqal、Alice and Bobのようなスタートアップが参入していることは興味深い。これらの企業はすべて、量子コンピュータをより信頼性が高く、スケーラブルで、アクセスしやすいものにすることに取り組んでいる。

これまで、製造業者は量子コンピュータの性能の指標として、量子ビット数に注目を集めてきた。製造業者は、量子コンピュータが起こしやすいエラーを修正する方法を優先している。この転換は、大規模で耐障害性のある量子コンピュータの開発において重要だ。これらの技術は、使用可能性を向上させるために不可欠だからだ。

Googleの最新の量子チップであるWillowは、この分野で目覚ましい進歩を実証した。GoogleがWillowで使用する量子ビットが多いほど、エラーは減少した。この成果は、医療、エネルギー、AIなどの分野に革命をもたらす可能性のある商業的に意味のある量子コンピュータの構築に向けた重要な一歩となる。

40年以上を経て、量子コンピューティングはまだ初期段階にあるが、今後10年間で大きな進展が期待される。これらのマシンの確率的な性質は、量子コンピューティングと古典的なコンピューティングの間の根本的な違いを表している。それはこれらを脆弱にし、開発とスケールアップを困難にする要因である。

同時に、それは最適化問題を解決し、複数の解決策を同時に探索し、古典的なコンピュータよりも速く効率的に処理できる非常に強力なツールとなる要因でもある。

コメント