MITのスピンオフ企業であるLiquid AIが、従来のGPTモデルを超える性能を持つ新しい言語モデル「LFM(Liquid Foundation Models)」を発表した。この革新的なモデルは、Transformerアーキテクチャに依存せず、独自の手法で高い効率性と優れた性能を実現している。

Liquid AIとLFM

Liquid AIは、マサチューセッツ工科大学(MIT)のコンピュータ科学・人工知能研究所(CSAIL)の元研究者たちによって設立されたAIスタートアップである。創設者には、Ramin Hasani、Mathias Lechner、Alexander Amini、Daniela Rusといった「Liquid Neural Networks」の先駆者たちが名を連ねる。同社は、従来のTransformerベースのモデルとは異なるアプローチで言語モデルの開発に取り組んでいる。

LFMの最大の特徴は、OpenAIのGPTシリーズやGoogleのGeminiモデルなどで使用されている従来のGenerative Pre-trained Transformer(GPT)アーキテクチャを使用していない点にある。代わりに、動的システム、数値線形代数、信号処理の原理に基づいて設計されている。

この新しいアプローチにより、LFMは最小限のシステムメモリで例外的な計算能力を発揮することができる。具体的には、テキスト、音声、画像、ビデオ、信号などの様々な種類の連続データを効率的に処理することができるというのだ。

Liquid AIは今回、異なる用途に対応する3つのモデルを同時にリリースした:

- LFM-1B:13億のパラメータを持つ密なモデルで、リソースに制約のある環境向け

- LFM-3B:31億のパラメータを持ち、モバイルアプリケーション、ロボット、ドローンなどのエッジデプロイメント向け

- LFM-40B:403億のパラメータを持つ「専門家の混合」モデルで、最も複雑なユースケースに対応するクラウドサーバー向け

これらのモデルは、性能だけでなく運用効率も考慮して設計されており、企業レベルのアプリケーションから、エッジデバイスへのデプロイメントまで、幅広いユースケースに対応できるという。

LFMの性能評価と業界へのインパクト

Liquid AIによると、LFMは既に複数の重要なAIベンチマークテストにおいて「最先端の結果」を示しており、ChatGPTのような既存の生成AIモデルに対して強力な競争相手となる可能性があるという。

特筆すべき点は以下の通りである:

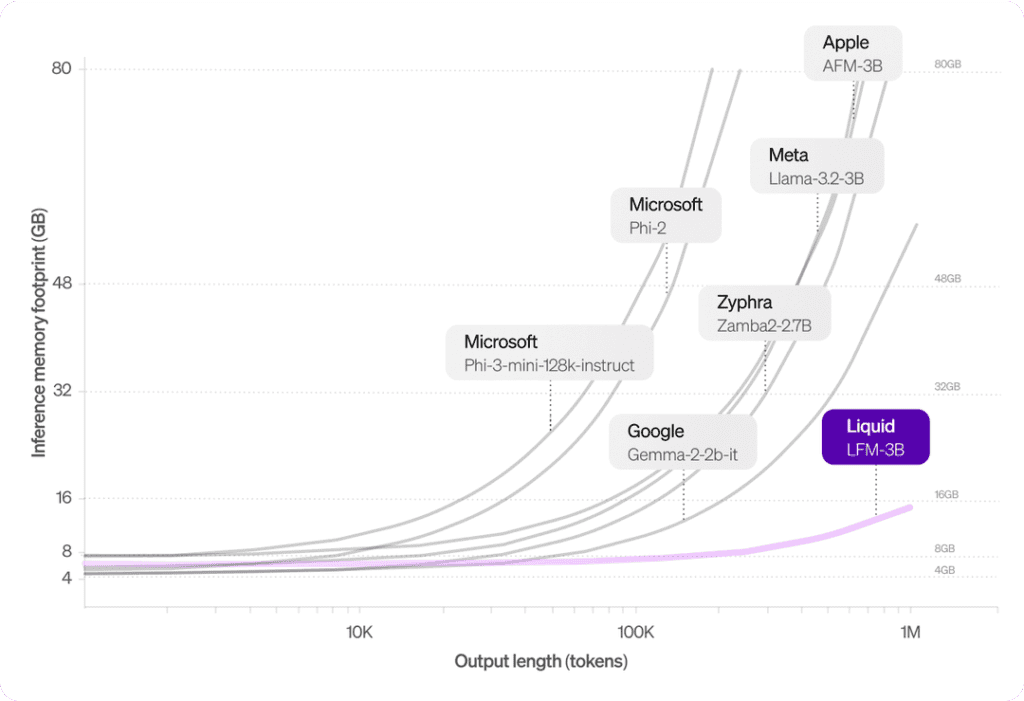

- メモリ効率: LFM-3Bモデルは、同等サイズのLlama 3.2-3Bモデルと比較して、約3分の1のメモリ使用量で動作する。これにより、より小型のデバイスでも高度な言語処理が可能になる。

- 長文脈処理: LFMモデルは、最大100万トークンの長い文脈を効率的に処理できる。これは、大量のテキストデータを扱う必要がある文書分析や長文生成タスクで大きな優位性を持つ。

- マルチモーダル性能: LFMは、テキスト以外のデータ形式でも高い処理能力を示しており、音声認識や画像分類などのタスクでも従来のモデルを凌駐する結果を出している。

特筆すべきは、LFM-3Bモデルのメモリ使用効率である。従来のLLMが長文脈処理時にメモリ使用量が急増するのに対し、LFM-3Bは非常に小さなメモリフットプリントを維持する。これにより、大量の連続データ処理が必要なチャットボットやドキュメント分析などのアプリケーションに最適だとされている。

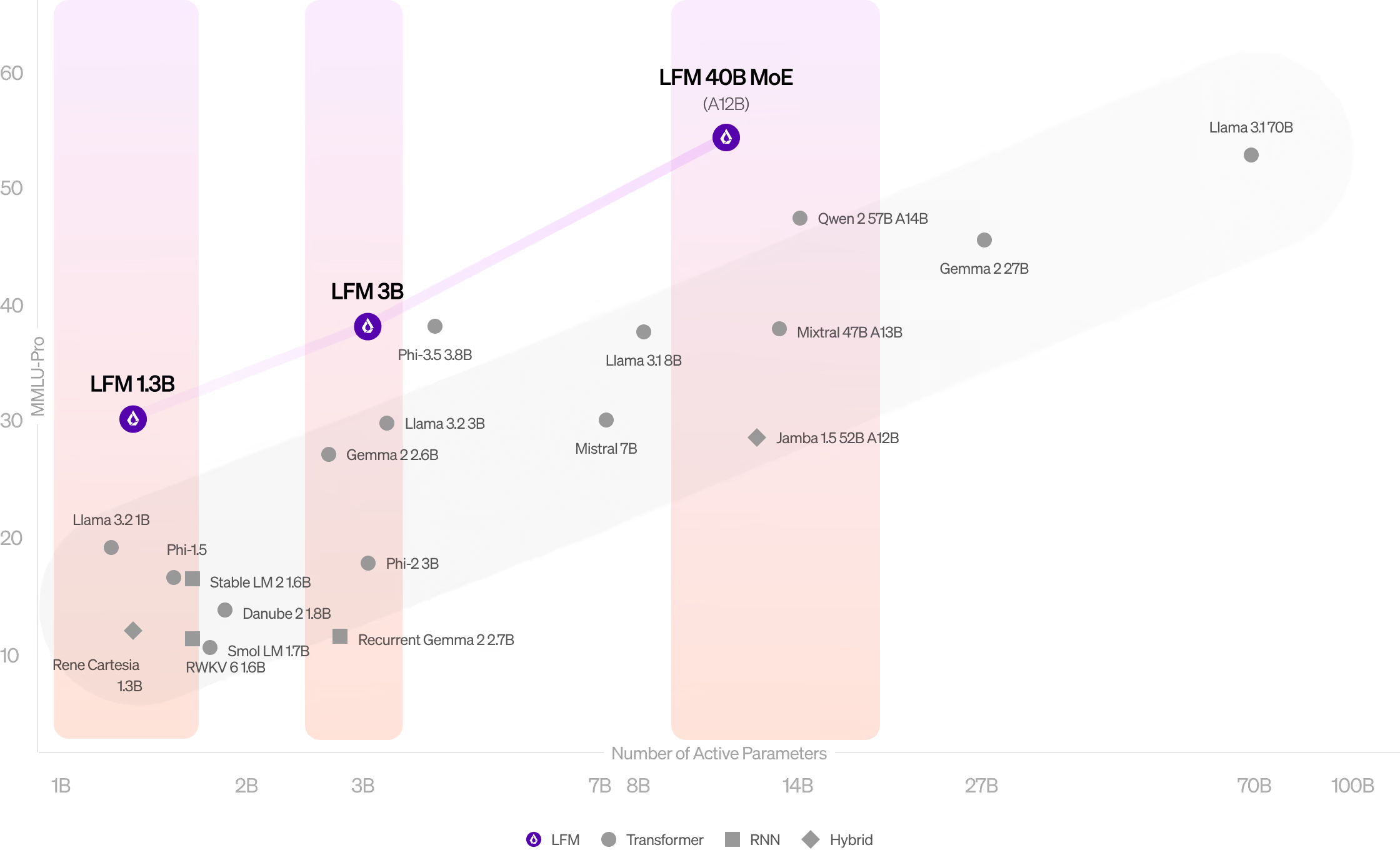

ベンチマークテストの結果も驚異的だ。LFM-1Bは同じサイズカテゴリのトランスフォーマーベースのモデルを凌駕し、LFM-3BはMicrosoftのPhi-3.5やMetaのLlamaファミリーと互角の性能を示した。さらに、LFM-40Bは効率性が高く、より大規模なモデルをも凌駕しながら、性能と効率のバランスを保っているという。

特に、LFM-1Bモデルは、MMLU(Massive Multitask Language Understanding)やARC-C(AI2 Reasoning Challenge)などのベンチマークで圧倒的な性能を示し、13億パラメータモデルの新基準を打ち立てたとされる。

Liquid AIのMaxime Labonne氏は、LFMの主な利点について「Transformerベースのモデルを凌駕しながら、はるかに少ないメモリを使用する能力」であると強調している。

現在、これらのモデルはLiquid Playground、Lambda(ChatおよびAPI経由)、Perplexity Labsなどのプラットフォームを通じて早期アクセスが可能となっている。これにより、組織は様々なAIシステムにLFMを統合し、エッジデバイスやオンプレミスなど、様々なデプロイメントシナリオでの性能を確認することができる。また、2024年10月23日にMITのKresge Auditoriumで開催される製品発表イベントに向けて、技術的な詳細を公開するブログ記事シリーズの発行を予定している。

Liquid AIは現在、NVIDIA、AMD、Apple、Qualcomm、Cerebras Computingなどの特定のハードウェア向けにLFMモデルを最適化する作業を進めており、一般提供時にはさらなる性能向上が期待できるという。

Source

コメント