Metaは2024年5月、革新的な動画生成AIモデル「Movie Gen」を発表した。このAIスイートは、テキスト入力から動画、画像、音声を生成する能力を持ち、既存の動画を編集することも可能とのことだ。

AIによる動画生成のニュープレイヤー

Movie Genは、Metaの動画合成に関する以前の研究成果である2022年の「Make-A-Scene」動画ジェネレーターと画像合成モデル「Emu」を基盤としている。

Movie Genの主な機能は以下の通りだ:

- テキストからの動画生成: Movie Genは、テキストプロンプトを基に、最長16秒、16フレーム/秒の1080p高解像度動画を生成できる。このモデルは、物体の動き、主体と物体の相互作用、カメラの動きなど、複雑な概念を扱うことができるとMetaは主張している。さらに、1:1、9:16、16:9などの異なるアスペクト比に対応し、768×768ピクセルの解像度で出力可能である。

- 1枚の写真からの動画生成: Movie Genは、1枚の写真と説明テキストを入力するだけで、その人物が登場する動画を生成することができる。この機能は、ディープフェイク技術の新たな進展を示しており、個人化された動画コンテンツの作成を容易にする一方で、倫理的な懸念も提起している。Metaはこの機能を「パーソナライズドビデオ作成」と呼んでいる。

- 音声生成機能: Movie Genは、テキストプロンプトに基づいて、動画コンテンツに同期した環境音、効果音、インストゥルメンタルのバックグラウンドミュージックを生成することができる。これにより、無音だった従来のAI生成動画に、より豊かな聴覚体験を加えることが可能になった。生成された音声は、48kHzのサンプリングレートで最長45秒間の動画に対応している。

- 動画編集機能: 既存の動画を、テキスト指示に基づいて正確に修正することができる。要素の追加や削除などの局所的な編集から、背景や全体的なスタイルの変更といったグローバルな変更まで可能である。この機能により、ユーザーは生成された動画を微調整したり、既存の動画を大幅に変更したりすることができる。

これらの機能により、Movie Genはコンテンツ制作の新たな可能性を開くツールとなる可能性がある。Metaは、この技術が「人々の本来の創造性を強化する」ものであり、人間のアーティストやアニメーターに取って代わるものではないと主張している。

Movie Genの技術的詳細と将来の展望

Movie Genは、複数のAIモデルから構成される高度なシステムである。その中核となるのは、動画および画像生成のための300億パラメータのTransformerモデルである。このモデルは、約1億本の動画と10億枚の画像を用いて事前学習されており、高品質な動画生成を可能にしている。

音声生成は、別の130億パラメータモデルによって処理される。このモデルは、約100万時間の音声データを用いて学習されており、動画の内容に合わせた音声、BGM、効果音を生成することができる。

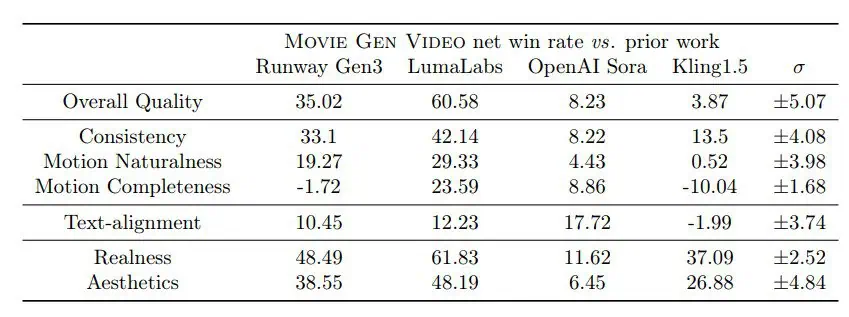

Metaは、Movie Genが他社の類似モデルよりも優れているとしている。人間による評価では、Runway社のGen-3、OpenAIのSora、中国の動画モデルKlingなどを上回る結果を示したという。ただし、SoraやKlingとの差は比較的小さいとされている。

Movie Genの潜在的な応用分野は広範囲に及ぶ。Metaは、ソーシャルメディアプラットフォーム向けの「一日の生活」動画の簡単な作成や編集、パーソナライズされたアニメーション誕生日メッセージの生成などを将来のアプリケーションとして想定している。これらの機能は、InstagramのリールやWhatsAppなどのMetaのプラットフォームとの統合が期待される。

しかし、この技術には倫理的な懸念も存在する。ディープフェイク技術の進歩は、人々の姿を無断で使用した動画の作成や、歴史的な文脈の偽造、ディープフェイクポルノの生成など、悪用の可能性を秘めている。Metaは、これらの懸念に対処するため、現時点でMovie Genを一般に公開する予定はないとしている。

安全性に関しては、Metaの広報担当者は「Movie Genは現時点では純粋にAI研究の概念段階にあり、この初期段階でも、他のすべての生成AIテクノロジーと同様に、安全性が最優先事項となっています」と述べている。

今後の展開として、Metaは映画製作者やクリエイターと協力し、彼らのフィードバックを将来のバージョンのモデルに統合する計画を立てている。また、現在のモデルの制限事項を認識しており、動画生成時間の短縮や全体的な品質の向上を目指して、モデルのさらなるスケールアップを計画している。

Source

- Meta: Meta Movie Gen

コメント