GoogleはGemini 2.0モデルファミリーを拡張し、新たにコスト効率に優れた「Gemini 2.0 Flash-Lite」、高度なコーディング性能を持つ「Gemini 2.0 Pro」 (実験版)、そして思考過程を提示する「Gemini 2.0 Thinking」モデル の3つの新モデルを発表した。開発者とGemini Advancedユーザー向けに、コスト効率と高性能を両立する多様な選択肢を提供する。

Gemini 2.0モデルファミリーの拡大

GoogleはAIモデルファミリーを拡充し、3つの新しいGemini 2.0モデルを発表した。これらは、それぞれ異なるユースケースに対応し、性能とコストのバランスを調整している。

Gemini 2.0 Flash-Lite:低コストで高性能を実現

Googleは、Gemini 2.0モデルファミリーの新モデルとして、「Gemini 2.0 Flash-Lite」を発表した。Flash-Liteは、コスト効率を重視したモデルでありながら、従来のGemini 1.5 Flashを上回る性能を持つ。

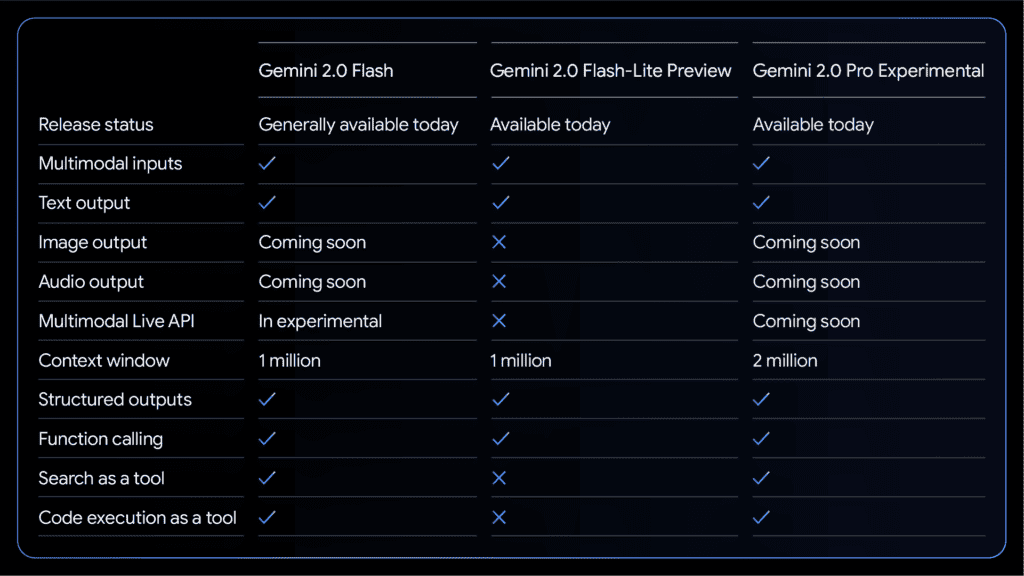

Google DeepMindによると、Flash-Liteは、MMLU Pro(77.6% vs. 67.3%)やBird SQLプログラミング(57.4% vs. 45.6%)など、多くのベンチマークで1.5 Flashを凌駕する。その一方で、価格と速度は1.5 Flashと同等に維持されている。

Flash-Liteは、100万トークンのコンテキストウィンドウとマルチモーダル入力をサポートする。例えば、Google AI Studioの有料プランでは、1ドル未満で約4万枚の画像に対して適切なキャプションを生成できる。

現在、Flash-LiteはGoogle AI StudioとVertex AIでパブリックプレビューとして提供されている。

Gemini 2.0 Pro:高度なコーディングと複雑なプロンプトに対応

より高度なAI機能を求めるユーザー向けに、Googleは「Gemini 2.0 Pro (Experimental)」モデルのテスト提供を開始した。このモデルは、コーディング性能と複雑なプロンプトの処理能力に優れたモデルだ。

Gemini 2.0 Proは、200万トークンのコンテキストウィンドウを持ち、高度な推論能力を備える。さらに、Google検索やコード実行といった外部ツールとの連携も可能だ。

Googleのベンチマークデータによると、Gemini 2.0 Proはほぼ全ての領域で前モデルを上回る性能を示しているという。特に数学タスクでは、「MATH」ベンチマークで91.8%、「HiddenMath」で65.2%というスコアを記録しており、加えてOpenAIのSimpleQAテストでは、Proモデルが44.3%を達成し、Deepseek-R1 (30.1%) と o3-mini-high (13.8%) という競合を大きく上回るスコアを誇っているが、これはトレーニングデータセットのサイズの違いに起因する可能性がある。

Google Developer Expert for Machine LearningであるSam Witteveen氏は、「新しいGemini 2.0 Proモデルは、200万トークンのコンテキストウィンドウ、ツールサポート、コード実行、関数呼び出し、Google検索との連携など、Pro 1.5の機能をすべて備えつつ、さらに改善されている」と評価している。

Gemini 2.0 Proは、Google AI StudioとVertex AI、そしてGemini Advancedユーザー向けに、デスクトップおよびモバイルのGeminiアプリで利用可能となっている。

Gemini 2.0 Flash Thinking:思考過程を提示する実験的モデル

Googleは、Gemini 2.0の実験的なモデルとして、「Gemini 2.0 Flash Thinking Experimental」と「Gemini 2.0 Flash Thinking Experimental with apps」を発表した。これらのモデルは、推論能力を強化するために、プロンプトを複数のステップに分解して処理するよう訓練されている。

これらのモデルの最大の特徴は、思考過程を提示する点にある。Googleによると、「このモデルは、なぜそのように応答したのか、どのような仮定を立てたのか、そしてモデルの推論の過程を追跡できるように、思考プロセスを示す」とのことだ。

これにより、ユーザーはモデルの出力に対する信頼性を高めることができるだけでなく、回答の背後にある論理を理解し、学習体験として活用することも可能になる。

Gemini 2.0 Flash Thinking Experimentalは、Chatbot Arena LLM Leaderboardで世界最高のモデルとしてランク付けされており、無料で利用できる。Gemini 2.0 Flash Thinking Experimental with appsは、YouTube、マップ、検索と連携し、より高度な調査や対話を実現する。

価格設定と競合モデルとの比較

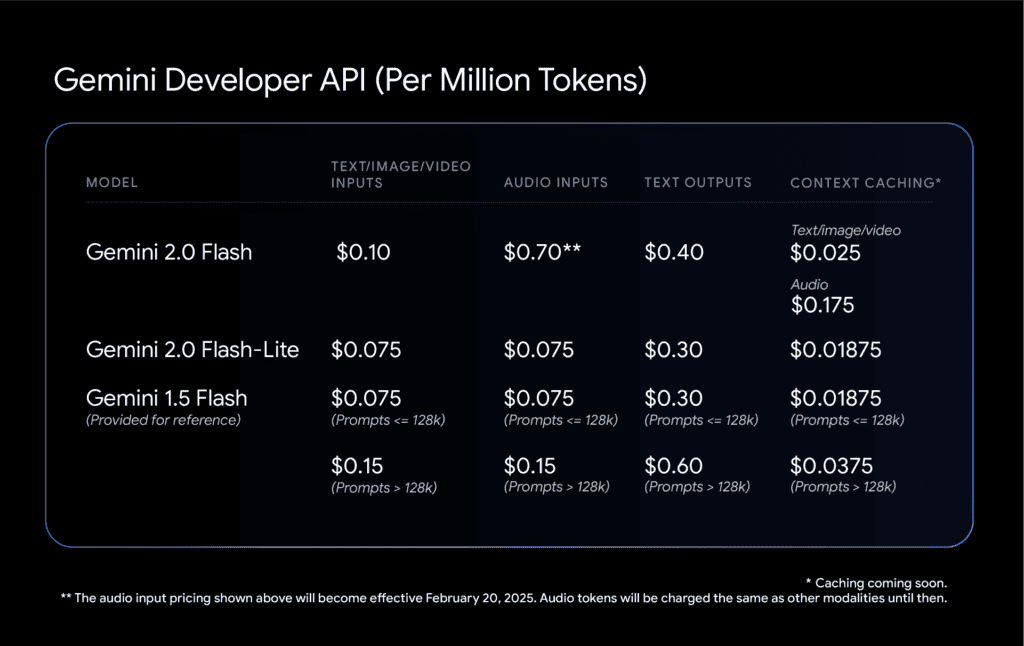

Gemini 2.0 Flash-Liteは、100万トークンあたり入力0.075ドル、出力0.30ドルで提供される。これは、他の主要なLLMと比較しても、非常に競争力のある価格設定である。

例えば、OpenAIのo3-miniは100万トークンあたり入力0.15ドル、出力0.6ドル、AnthropicのClaudeは100万トークンあたり入力0.8ドル、出力4ドルである。DeepSeekの従来のLLM V3は100万トークンあたり入力0.14ドル、出力0.28ドルである。

また、Googleは以前のショートコンテキストクエリとロングコンテキストクエリの区別を廃止した。これにより、混合ワークロード (テキストと画像) は、Gemini 1.5 Flashよりも低コストになる可能性がある。

Gemini 2.0 Flashは、従来の1.5 Flashよりも価格が高いものの、新しいFlash-Liteは、1.5 Flashと同等の価格で、ほとんどのベンチマークで優れた性能を発揮するように設計されている。

安全性への取り組み

Google DeepMindは、Gemini 2.0モデルファミリーの安全性とセキュリティを確保するための対策を講じている。Gemini自体が自身の応答を批判的に評価する強化学習技術を導入し、応答の精度を向上させている。また、自動化されたセキュリティテストを活用し、間接的なプロンプトインジェクション攻撃などの脆弱性を特定している。

今後、Google DeepMindは、Gemini 2.0モデルファミリーの機能を拡張し、テキスト以外のモダリティ(画像、音声など)の一般提供を予定している。

Sources

コメント