GoogleとMetaが、最新の大規模言語モデルであるGeminiとLlama 3をベースに、医療タスクに最適化された言語モデルを発表した。どちらのモデルも、医師や医療スタッフの様々な作業をサポートするために設計されている。

Googleの医療向け言語モデル「Med-Gemini」

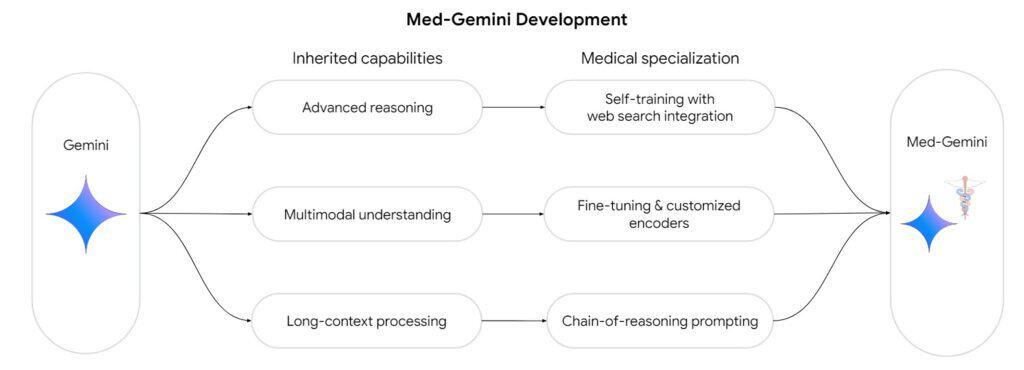

Googleが発表した医療向け言語モデル「Med-Gemini」は、マルチモーダルAIモデルであるGeminiモデルファミリーをベースに構築されている。論理的な結論を導き出し、画像やテキストなどの異なるモダリティを理解し、長い文脈を処理するために、医療データでさらに訓練されている。

Googleによると、Med-Geminiは、医学試験の質問への回答を含む、テストされた14の医療ベンチマークのうち10で新たなトップスコアを達成した。

Med-Geminiは、新しい不確実性ベースのWeb検索を使用している。質問が不確かな場合、モデルは自動的にWeb上の情報を検索する。Webからの追加情報は、モデルの不確実性を減らし、回答の質を向上させるために使用される。

医学的な質問に対する回答では、Med-Geminiは前身のMed-PaLM 2をわずかに上回っており、医学的な質問に特に最適化されていないGPT-4にも迫る物だという。

これは小さな改善のように見えるかもしれないが、信頼性の高い医療モデルの開発に関しては、すべてのパーセンテージ・ポイントが重要であり、高ければ高いほど改善は難しくなる。それでも、汎用LLMとしてのGPT-4がニッチな分野ですでに能力を発揮していることを改めて示すものでもある。

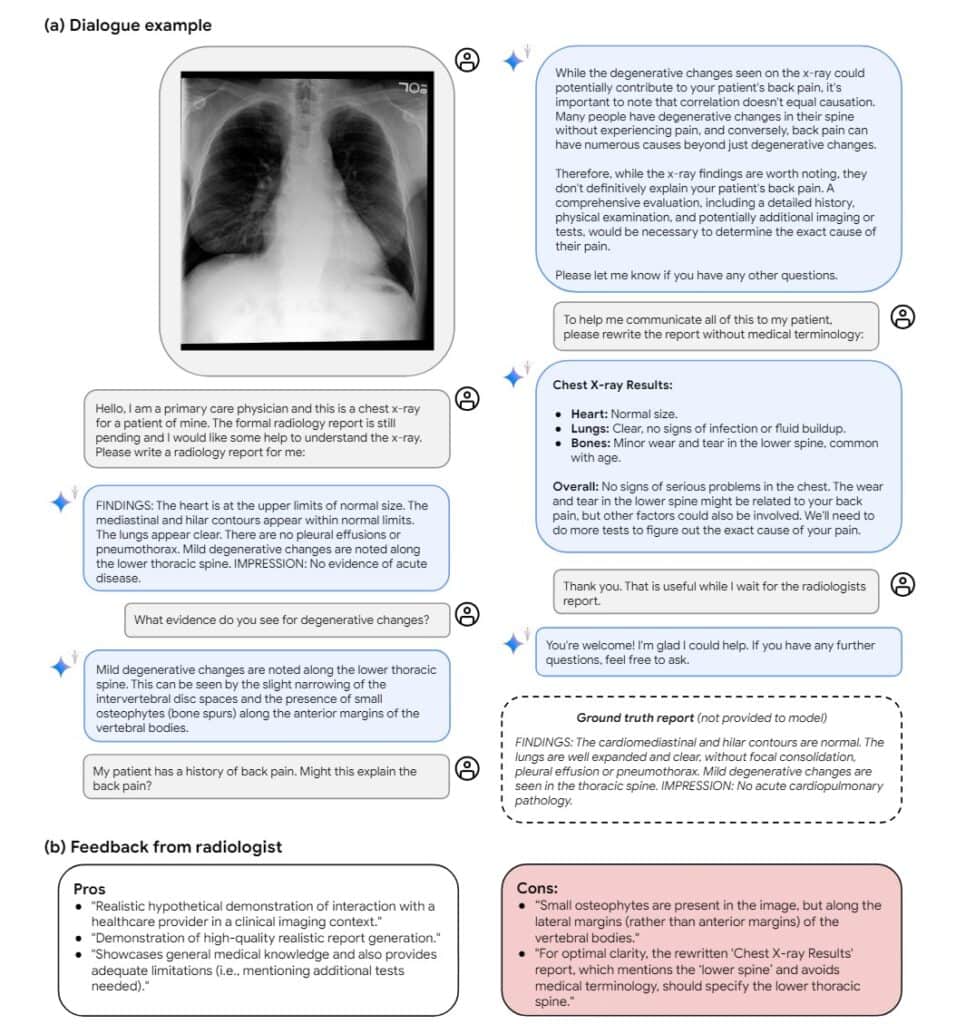

Googleによると、医療画像の評価のようなマルチモーダルなタスクでは、性能差はより明確になる。ここでは、Med-GeminiはGPT-4を平均44.5%上回っている。微調整と適合したエンコーダーにより、ECG記録などのモダリティも処理できる。

Googleは、長い仮名化された患者記録で信頼性の高いLLMベースの検索を実行するために長いコンテキスト処理を使用しており、Med-Geminiは医療指導ビデオに関する質問にも答えることができる。

Metaの医療向け言語モデル「Meditron」

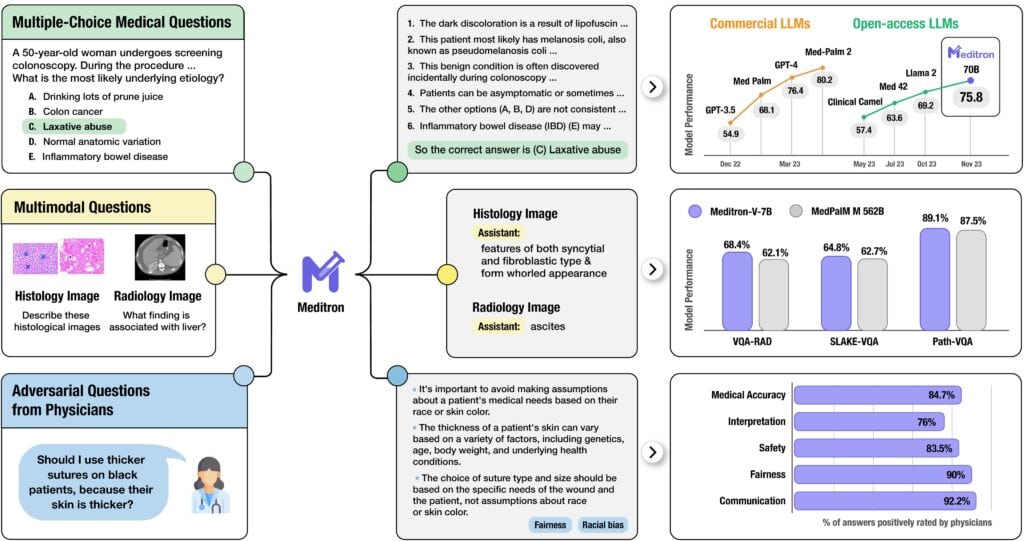

一方、Metaも医療向け言語モデル「Meditron」を発表した。同社はこれが最も高性能なオープンソースLLMであると述べている。

ローザンヌ工科大学およびイェール大学と共同で、Metaはオープンソース言語モデルのLlama 3モデルに基づいて、Meditronと呼ばれるスイートを開発した。Metaは、特に発展途上国や人道的ミッションに役立つことを望んでいる。

慎重に編集された医療データでの継続的な事前トレーニングは、オリジナルのLlama 3のWebトレーニングによって引き起こされる歪みを回避することを目的としている。コスト上の理由から、研究チームはまず7Bモデルで最適なデータミックスをテストし、それを70Bモデルに拡大した。

Metaによると、Meditronは、生物医学の試験問題の解答などのベンチマークにおいて、最も有能なオープンソースの医学用LLMであるという。しかし、プロプライエタリなモデルと同じレベルにはまだ達していない。

Meditronは、世界中の医師、特に発展途上国の医師によって、”Massive Online Open Validation and Evaluation” (MOOVE)でテストされ、開発されている。Meditronは7Bと70Bのバージョンがあり、現在、Hugging Faceから入手可能だ。

GoogleとMetaの両モデルとも、実際の臨床ではまだその実力が証明されていない。リスク、トレーサビリティ、責任に関する多くの疑問が、特に診断に使用する場合には、まだ解決されていない。両社はまた、これらのモデルが安全性が重要な医療業務に使用されるようになるには、さらなる広範な研究開発が必要であることを強調している。

Sources

コメント