Googleは、同社史上最も高性能とされるAIモデル「Gemini 2.5 Pro」のプレビュー版を開発者向けに公開した。これまで制限付きの無料実験版のみだったが、今回のリリースでより高いレート制限と明確な料金体系が導入された。このモデルはLMArenaベンチマークでトップスコアを記録するなど、高い性能で開発者からの注目を集めている

Gemini 2.5 Pro プレビュー版、開発者の熱い要望に応え公開

Googleは開発者からの強い関心とフィードバックを受け、最新の大規模言語モデル(LLM: Large Language Model)である「Gemini 2.5 Pro」をパブリックプレビューとして提供開始したことを発表した。これまで実験的な位置づけで、、1日25リクエスト、1分あたり5リクエストという厳しい制限付きの無料APIとしてのみ提供されていたが、今回のプレビュー版公開により、より多くの開発者がこの強力なモデルを利用できるようになった。

具体的には、「Gemini API」および「Google AI Studio」を通じてプレビュー版へのアクセスが可能となり、近日中には「Vertex AI」での提供も開始される予定である。

従来の無料実験版(gemini-2.5-pro-exp-03-25)は低いレート制限(APIリクエスト数の上限)のもとで引き続き無料で利用可能だが、今回発表されたパブリックプレビュー版では有料となり、代わりに大幅に引き上げられたレート制限が適用される。これにより、開発者は1分あたり最大2,000リクエスト、処理能力としては1分あたり最大800万トークン(言語モデルが処理するテキストの単位)という、本番環境のアプリケーションにも耐えうる規模での利用が可能となった。

GoogleのGemini製品管理ディレクターであるTulsee Doshi氏は、「これまで構築してきた多くの要素や基礎が、今、本当に素晴らしい形で結実しつつあります。そのため、我々はこの分野でペースを上げることができていると感じています」と、Ars Technicaの取材で述べ、開発ペースの加速に自信を見せている。

注目すべき性能:推論、コーディング、そして「Vibes」

Gemini 2.5 Proは、特にコーディングや複雑な推論タスクにおいて卓越した性能を発揮するとされている。

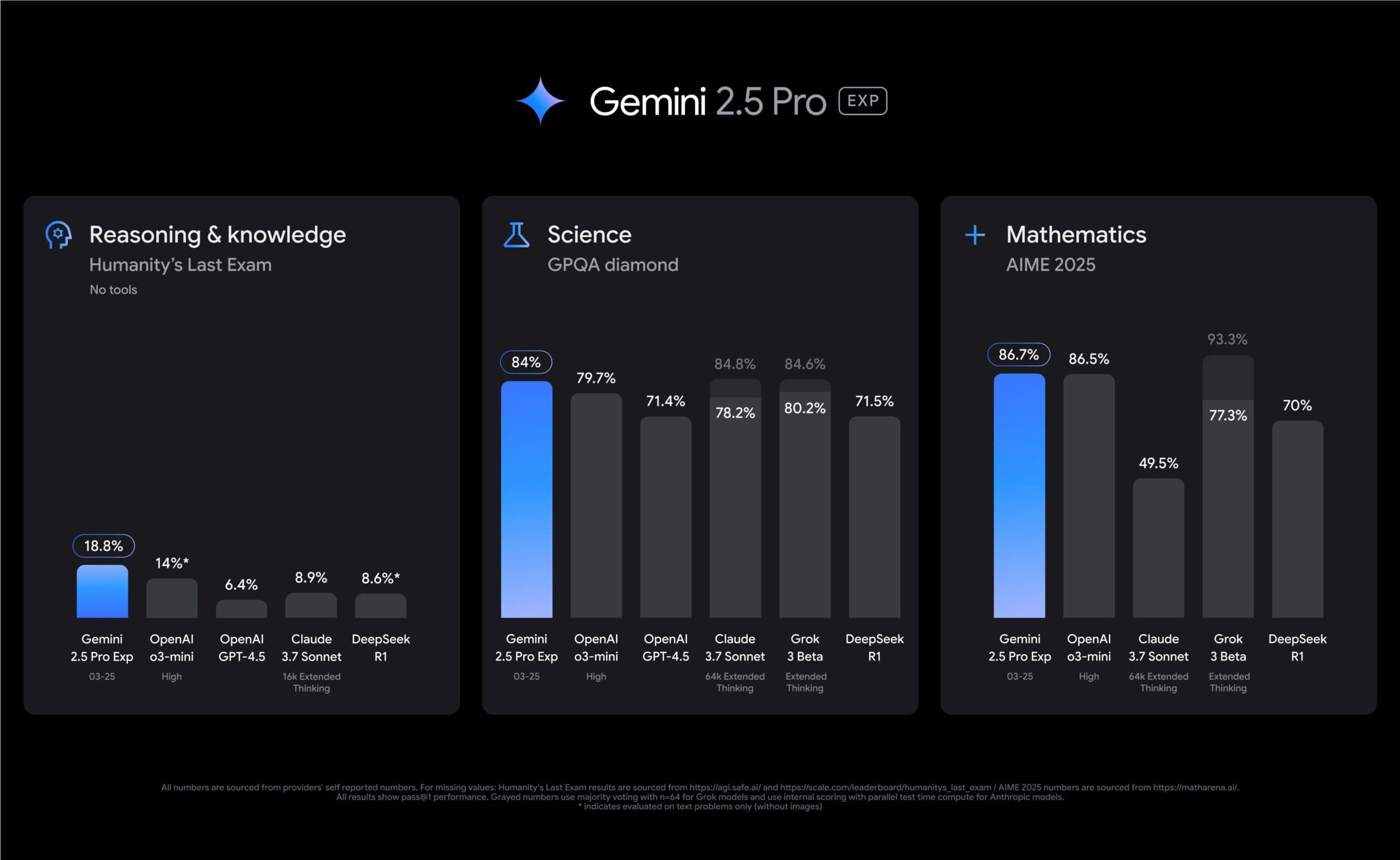

- ベンチマークでの高評価: 公開当初、ユーザー評価に基づくAIモデル比較ベンチマーク「LMSys Chatbot Arena(LMArena)」で首位を獲得。また、米国の数学オリンピック予選である「AIME 2025」でも86.7%という高いスコアを記録した。

- 効率的な高性能化: Googleによると、Gemini 2.5 Proは、推論性能を向上させる一方でコスト増につながる「テストタイム技術(Test-time Compute)」を使用せずに、複数の推論特化モデルを上回る性能を達成している。これは、モデルの基本性能(ベースモデル)と学習後の調整プロセス(ポストトレーニング)の両方を改善した結果であるとされる。

- Dynamic Thinking機能: Googleが公開したモデルとしては初めて「Dynamic Thinking」と呼ばれる機能を搭載している。これは、プロンプト(指示)の複雑さに応じてモデルが推論に費やす計算リソースを動的に調整する機能だ。これにより、単純な問いに対して過剰な思考(オーバーシンキング)を行うことを避け、効率的な処理を目指している。Doshi氏は、「現在リリースしている2.5 Proモデルは、単純なプロンプトに対してまだ考えすぎている部分があり、改善を続けたいと考えています。より単純なプロンプトに対してさらに思考を減らす、2.5 Proの一般提供(GA)バージョンに向けて、Dynamic Thinkingは大きく投資している分野の一つです」と述べており、さらなる効率化を目指す方針を示している。

- 「Vibes」の重視: 近年、AIモデルの評価軸として、単なる性能だけでなく、出力の質や対話の自然さといった「Vibes(雰囲気)」が重視される傾向にある。Gemini 2.5 ProはLMArenaでの高評価にも見られるように、ユーザーから好まれる「良いVibes」を持つと評価されている。Googleは、ユーザーフィードバックを重視し、コード生成などにおいても「楽しい体験」を提供できるよう、この「Vibes」の改善にも注力している。

筆者もOpenAIのo1やo3、AnthropicのClaude 3.7 Sonnetと並行して使ってみたが、Gemini 2.5 Proはその処理速度や出力の内容など、現時点で最も有能と感じている。

料金体系と競合ひしめく市場でのポジショニング

Gemini 2.5 Proのパブリックプレビュー版は有料となり、その価格設定は大きな注目を集めている。

Gemini 2.5 Pro プレビュー版 料金(100万トークンあたり)

| トークン数 | 入力価格 (Input) | 出力価格 (Output) |

| 200,000トークン以下 | $1.25 | $10.00 |

| 200,000トークン超 | $2.50 | $15.00 |

| 無料実験版 | 無料 | 無料 |

| (gemini-2.5-pro-exp-03-25) | (低レート制限) | (低レート制限) |

この価格設定について、いくつかの特徴が見られる。

- Google内での位置づけ: Gemini 2.5 Proは、Googleが提供する他のAIモデル、例えば軽量版の「Gemini 2.0 Flash」(入力

0.10ドル/100万トークン、出力0.10ドル/100万トークン、出力0.10ドル/100万トークン、出力0.40ドル/100万トークン)と比較して、最も高価なモデルとなる。これは、その高い性能を反映したものだろう。 - 競合との比較:

- Anthropic Claude 3.7 Sonnet: 入力

3ドル、出力3ドル、出力3ドル、出力15ドル(100万トークンあたり)であり、Gemini 2.5 Proはこれよりも安価である。 - OpenAI:(100万トークンあたり)

- GPT-4o: 入力

2.5010ドル、出力2.50ドル、出力2.50ドル、出力ドル(非推論モデル) - o1 (推論モデル): 入力

1560ドル、出力15ドル、出力15ドル、出力ドル - o3-mini (小型推論モデル): 入力

1.104.40ドル、出力1.10ドル、出力1.10ドル、出力ドル - GPT-4.5: 入力

75150ドルドルドルドル - o1-pro: 入力

150600ドルドルドルドル

- GPT-4o: 入力

- Anthropic Claude 3.7 Sonnet: 入力

Gemini 2.5 Proは、OpenAIの主力モデルであるGPT-4oや高性能推論モデルo1と比較すると安価だが、小型のo3-miniよりは高価である。

- DeepSeek R1: 入力

0.55ドル、出力0.552.19ドル、出力0.55ドル、出力ドル

DeepSeek R1と比較すると、Gemini 2.5 Proは高価である。

総じて、Gemini 2.5 Proは、競合の高性能モデルと比較して競争力のある、あるいはそれらを下回る価格設定を実現しており、SNSなどでは「驚くほど安い」「競争が激化する」といった反応が見られる。ただし、Google、OpenAI、Anthropicといった主要ラボの最新フラッグシップモデルの価格が上昇傾向にあることもまた気になるところだ。

開発者の熱狂とAI市場へのインパクト

Gemini 2.5 Proの登場は、開発者コミュニティから熱狂的に受け止められている。Google CEOのSundar Pichai氏によると、Gemini 2.5 Proは開発者の間で最も需要の高いAIモデルとなっており、GoogleのAI StudioプラットフォームとGemini APIの利用は、発表があった月だけで80%増加したという。

この高い関心は、Gemini 2.5 Proが持つ性能と価格のバランスが、開発者にとって魅力的であることを示唆している。特に、これまで高性能モデルの利用コストに悩んでいた開発者にとって、新たな選択肢となり得る。

AIモデル開発市場では、性能競争と同時に価格競争も激化している。中国発のDeepSeekが低価格モデルを投入し、市場に価格圧力をかけている中、GoogleがGemini 2.5 Proを比較的手頃な価格で提供したことは、OpenAIやAnthropicといった競合他社にとっても、高性能かつ手頃な価格のモデルを提供するプレッシャーをさらに高めるものと見られる。

これに対し、OpenAIも対抗策を打ち出しており、CEOのSam Altman氏は、推論モデル「o3」および未発表の「o4-mini」を近々リリースする計画を明らかにしている。さらに数ヶ月後には、次世代モデル「GPT-5」の投入も予定されており、AI市場の競争はますます加速する見込みだ。

Googleの戦略と今後の展望:効率化と透明性の課題

GoogleがGemini 2.5 Proをこのタイミングでプレビュー公開し、競争力のある価格を設定した背景には、OpenAIなどに先行された生成AI分野での巻き返しを図り、開発者エコシステムを拡大しようという明確な戦略がある。

OpenAIのChatGPT登場時に指摘されたように、GoogleはAI基盤技術の開発で先行していたにも関わらず、製品化で後れを取った。しかし、ここ数ヶ月で開発ペースを加速させており、Gemini 2.5 Proはその成果の一つと言える。

一方で、課題も存在する。

- 効率化の追求: Dynamic Thinking機能は効率化への第一歩だが、Doshi氏が認めるように、まだ改善の余地がある。大規模言語モデルの運用には莫大な計算コストがかかり、Google自身も2025年にAIインフラへ750億ドルを投じる計画である。モデルの効率化は、コスト削減と持続可能なビジネスモデル構築のために不可欠である。

- 技術的な透明性: GoogleはGeminiモデルの技術詳細(パラメータ数など)をあまり公開しておらず、批判もある。Gemini 1.5のテクニカルレポートは公開されたが、2.0のものは未公開であり、2.5についても公開時期は未定である。モデルの能力や限界、バイアスなどを評価するためには、技術情報の透明性向上が求められる。Googleは、2.0および2.5のモデルカード(モデルの概要や評価データなどを記した文書)を準備中であるとしている。

Gemini 2.5 Proはまだプレビュー段階であり、今後、フィードバックを受けてさらなる改善が加えられ、一般提供(GA)へと移行していくと予想される。その高性能と価格競争力が、AIアプリケーション開発の現場にどのような変化をもたらすか、そして熾烈なAI開発競争の中でGoogleがいかにリーダーシップを発揮していくのか、今後の動向が注目される。

Sources