Googleは年次開発者会議「Google Cloud Next 2024」で、AIハイパーコンピューター・アーキテクチャーに関する多くの取り組みを発表した。その焦点となるものは、Cloud TPU v5pやNVIDIAの次期Blackwell GPUなど、性能を最適化した新しいハードウェア・コンポーネントだ。これらのイノベーションは、洗練されたAIモデルのトレーニングと展開を加速するように設計されている。

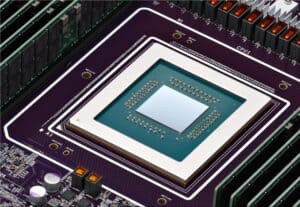

Googleによると、Cloud TPU v5pは現在一般提供されており、これまでで最も強力でスケーラブルなTPU世代だという。1つのTPU v5pポッドには、TPU v4ポッドの2倍以上となる8,960個の接続されたチップが搭載されている。さらに、TPU v5pは、前世代と比べて2倍以上のチップレベルのFLOPSと3倍以上の高速メモリを提供する。

このため、TPU v5pは大規模なAIモデルのトレーニングに最適な選択肢となり得る。これを促進するために、Google Kubernetes Engine(GKE)はTPU v5pクラスタとマルチホストサービングを完全にサポートするようになった。Googleによると、後者は複数のホストに分散されたモデルサーバー群を単一の論理ユニットとして管理・監視することを可能にする。

合わせて、Google CloudはGPUの提供も拡大している。新しいNVIDIA H100 GPUベースのA3 Megaインスタンスが来月から一般利用可能になる。これはA3の2倍のGPU間ネットワーク帯域幅を提供する。

Googleはまた、新しいNVIDIA Blackwellプラットフォームが2つの構成でAIハイパーコンピュータ・アーキテクチャに統合されることも発表した。Google Cloudの顧客は、2025年春にNVIDIAのHGX B200およびGB200 NVL72システムを利用できるようになる。新しいHGX B200システムは、AI、データ分析、HPCコンピューティング向けで、GB200 NVL72は何兆ものパラメーターを持つAIモデルのトレーニングと可能な限り高速な推論用に設計されている。さらに一歩進んだ液冷GB200 NVL72システムは、リアルタイムの言語モデル推論と1兆パラメータモデルのトレーニング用に設計されている。

Source

コメント