人工知能は何千もの異なる方法でその存在感を示している。科学者が膨大なデータを理解する手助けをしたり、金融詐欺の検知に役立ったり、自動車を運転したり、音楽の提案をしたり、チャットボットが私たちを夢中にさせたり。そして、それはまだ始まったばかりだ。

私たちは、AIがどれほど急速に発展し続けるかを理解できるのだろうか?その答えが「ノー」だとしたら、それは「グレート・フィルター」なのだろうか?

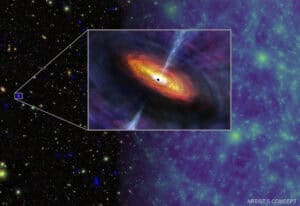

Fermiのパラドックスとは、高度な文明が存在する可能性が高いにもかかわらず、それが存在するという証拠がまったくないという矛盾のことである。この矛盾が存在する理由については、多くの解決策が提案されている。その一つが “グレート・フィルター”である。

グレート・フィルターとは、知的生命体が惑星間や恒星間に進出するのを妨げ、さらには滅亡に導くような仮説上の出来事または状況である。気候変動、核戦争、小惑星の衝突、超新星爆発、疫病など、大災害にまつわる悪党ギャラリーのようなものだ。

あるいは、AIの急速な発達はどうだろう?

『Acta Astronautica』に掲載された新しい論文は、人工知能(AI)が人工超知能(ASI)になり、ASIがグレートフィルターになるというアイデアを探求している。論文のタイトルは”Is Artificial Intelligence the Great Filter that makes advanced technical civilizations rare in the universe?” である。著者はマンチェスター大学物理・天文学科のMichael Garrettだ。

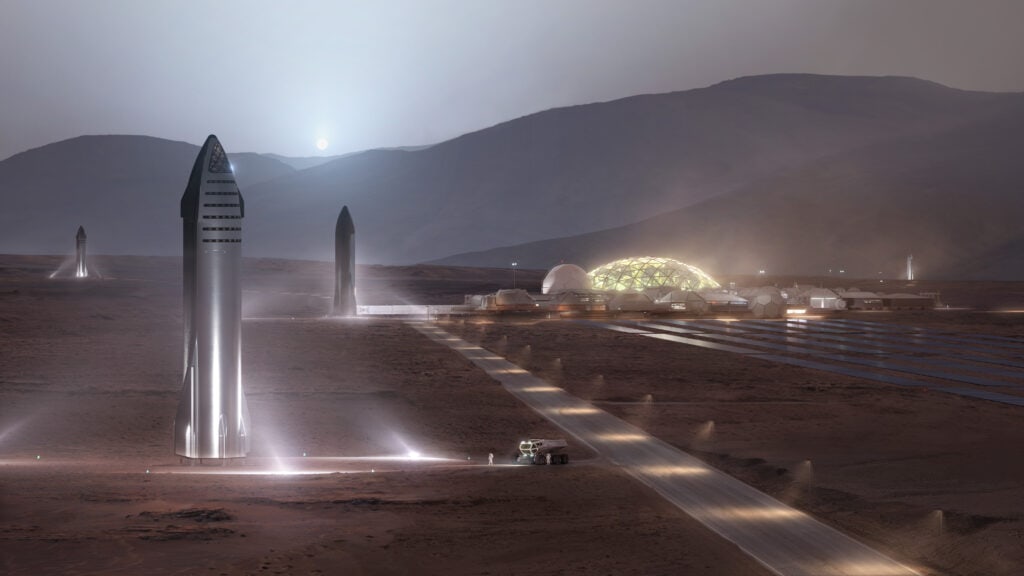

グレート・フィルターが、私たちのような科学技術の発達した種が多惑星化するのを妨げているという見方もある。それは、種が1つの惑星しか持たない場合、絶滅や停滞のリスクが高まるからだ。Garrettによれば、予備の惑星がなければ、種は時間との戦いになる。「これらの文明が安定した多惑星的存在を確立する前に、そのようなフィルターが出現することが提案されており、技術文明の典型的な寿命(L)が200年未満であることを示唆している」とGarrettは書いている。

もしそうだとすれば、なぜ我々が地球外知的生命体(ETI)のテクノシグネチャーやその他の証拠を発見できないのかが説明できる。もし私たちが200年という制約に直面し、それがASIのせいだとしたら、私たちはどうなるのだろうか?Garrettは、「……このような存亡の危機を緩和するために、地球上でのAI開発と多惑星社会の発展のための規制の枠組みを早急に確立することが極めて重要である」と強調している。

多くの科学者やその他の思想家は、私たちは巨大な変革の入り口に立っていると言う。AIは私たちのやり方を変え始めたばかりで、変革の多くは舞台裏にある。AIは何百万人もの仕事をなくす用意があるようで、ロボット工学と組み合わされれば、その変革はほとんど無限に続くように思われる。これはかなり明白な懸念である。

しかし、より深く、より体系的な懸念がある。誰がアルゴリズムを書くのか?AIは何らかの差別をするのだろうか?ほぼ間違いない。競合するアルゴリズムは強力な民主主義社会を弱体化させるのか?開かれた社会は開かれたままなのか?ASIは私たちのために決定を下すようになるのだろうか?

これは、明確な終着点のない、枝分かれした疑問の広がる木である。

Stephen Hawking博士(故人)は、AIが独自に進化し始めたら人類は滅亡しかねないと警告した。「私はAIが人間に取って代わるのではないかと危惧している。もし人々がコンピューターウイルスを設計するなら、誰かが自己を改良し複製するAIを設計するだろう。これは人間を凌駕する新しい生命形態になるだろう」と彼は2017年にWired誌に語った。AIが人間を凌駕するようになれば、それはASIとなる。

Hawking博士は、AIについて警告を発している最も有名な人物の一人かもしれないが、彼だけではない。メディアは、AIが私たちのためにしてくれる仕事についての記事とともに、議論や警告で溢れている。最も憂慮すべき警告は、ASIが暴走する可能性があるというものだ。それをSFだと切り捨てる人もいるが、Garrettは違う。

「人工超知能(ASI)がいずれ暴走するのではないかという懸念は、大きな問題だと考えられている。今後数年間、この可能性に立ち向かうことが、この分野のリーダーたちの研究課題となっている」とGarrettは書いている。

もしAIが何の利益ももたらさないのであれば、この問題はもっと簡単だ。しかし、医療画像や診断の改善から、より安全な交通システムまで、AIはあらゆる恩恵をもたらす。政府にとって重要なのは、被害を最小限に抑えつつ、利益を享受できるようにすることだ。「国家安全保障や防衛のような分野では、責任ある倫理的な開発が最優先されるべきです」とGarrettは書いている。

問題なのは、我々と政府が準備不足だということだ。AIのようなものはかつて存在したことがなく、私たちがAIをどのように概念化し、その軌跡を理解しようとしても、私たちは何もできないままなのだ。もし私たちがこのような立場にあるのなら、AIを開発する他の生物種も同じだろう。AI、そしてASIの出現は普遍的なものである可能性があり、グレート・フィルターの候補となる。

これが、ASIが具体的にもたらすリスクである:ASIは、それを生み出した生物学的生命を必要としなくなる可能性があるのだ。「技術的特異点(シンギュラリティ)に到達すると、ASI システムは急速に生物学的知性を超え、従来の監視メカニズムを完全に上回るペースで進化し、生物学的利益や倫理に沿う可能性が低い予期せぬ意図しない結果をもたらすでしょう」と、Garrettは述べている。

ASIはどのようにして、厄介な生物学的生命体から解放されるのだろうか?致命的なウイルスを作り出したり、農作物の食糧生産と流通を阻害したり、原子力発電所をメルトダウンさせたり、戦争を引き起こしたりする可能性もある。すべてが未知の領域であるため、本当のところはわからない。何百年も前、地図製作者は世界の未踏地域にモンスターを描いていたが、それは私たちが現在行っていることのようなものだ。

もし、このすべてが寂しく、やむを得ないことのように聞こえるなら、Garrettはそうではないと言う。

彼のこれまでの分析は、ASIと人類が同じ空間を占めることを前提としている。しかし、もし我々が多惑星の地位を得ることができれば、見通しは変わる。「例えば、多惑星の生物種は、異なる惑星での独立した経験を生かし、生存戦略を多様化させ、惑星に縛られた文明が直面する一点集中型の失敗を回避できる可能性がある」とGarrettは書いている。

複数の恒星の周りにある複数の惑星にリスクを分散させることができれば、ASIの最悪の結果に対して緩衝することができる。「この分散された存在モデルは、冗長性を生み出すことで、AIによる大災害に対する生物文明の回復力を高める」と彼は書いている。

未来の人類が居住する惑星や前哨基地のひとつがASI技術的特異点を生き延びられなかったとしても、他の惑星は生き延びるかもしれない。そして、彼らはそこから学ぶだろう。

多惑星の地位は、ASIを生き残らせる以上の効果があるかもしれない。ASIを使いこなすのに役立つかもしれない。Garrettは、AIを封じ込めたまま、より徹底的な実験を行える状況を想像している。孤立した小惑星や矮小惑星にいるAIが、牢獄から脱出するのに必要な資源にアクセスすることなく、我々の命令に従うことを想像してみてほしい。「地球滅亡の危険性なしに、高度なAIの効果を研究できる隔離された環境が可能になる」とGarrettは書いている。

しかし、ここに難問がある。AIの開発は加速度的に進んでいるが、私たちの多惑星化の試みはそうではない。「AIの急速な進歩と宇宙技術の進歩の遅さとの間の格差は歴然としている」とGarrettは書いている。

その違いは、AIは計算と情報によるものだが、宇宙旅行には物理的な障害が複数あり、それを克服する方法がまだわかっていないことだ。私たち自身の生物学的性質が宇宙旅行を制限しているが、AIを制限するような障害はない。「AIは理論的にはほとんど物理的な制約なしに自身の能力を向上させることができるが、宇宙旅行はエネルギーの制限、物質科学の限界、宇宙環境の過酷な現実と戦わなければならない」とGarrettは書いている。

今のところ、AIは我々が設定した制約の中で動いている。しかし、常にそうとは限らない。AIがいつASIになるのか、あるいはASIになれるのかさえわからない。しかし、その可能性を無視することはできない。その結果、2つの結論が導き出される。

Garrettが正しいとすれば、人類は宇宙旅行にもっと熱心に取り組まなければならない。奇想天外に思えるかもしれないが、知識のある人なら知っている。宇宙に進出しなければ、人類は自らの手によって、あるいは自然の手によって、ここで滅びるだろう。Garrettの200年という見積もりは、まさにそのことを象徴している。月と火星への到達に再び重点を置くことで、希望が見えてくる。

第二の結論は、AIを法制化し管理することである。サイコパスが国家全体を支配し、戦争を仕掛ける世界では難しい課題である。「業界の利害関係者、政策立案者、個々の専門家、そして各国政府はすでに規制が必要だと警告しているが、世界的に受け入れられる規制の枠組みを確立するのは難しいだろう」とギャレットは書いている。チャレンジングという言葉では言い表せない。人類が内輪もめをしているせいで、さらに手に負えなくなっている。また、どんなに早くガイドラインを策定しても、ASIはもっと早く変わってしまうかもしれない。

「実用的な規制がなければ、AIは私たちの技術文明だけでなく、すべての技術文明の将来の進路にとって大きな脅威となりうると信じるだけの理由がある」とギャレットは書いている。

人類の希望と夢の多くは、Fermiのパラドックスとグレートフィルターに結晶している。他の文明は存在するのか?私たちは他のETIと同じ状況にあるのだろうか?私たちの種は地球を去るのだろうか?私たちは直面する多くの困難を乗り越えることができるのだろうか?私たちは生き残れるのだろうか?

もしそうだとしたら、それは退屈で日常的と思われること、つまり法案をめぐる駆け引きに行き着くかもしれない。

「宇宙における知的生命体の存続は、このような国際的な規制措置と技術的努力の適時かつ効果的な実施にかかっているかもしれない」とGarrettは書いている。

この記事は、EVAN GOUGH氏によって執筆され、Universe Todayに掲載されたものを、クリエイティブ・コモンズ・ライセンス(表示4.0 国際)に則り、翻訳・転載したものです。元記事はこちらからお読み頂けます。

コメント