中国のAI企業DeepSeekが自社の大規模言語モデル運用における収益性データを公開し、理論上は545%という驚異的な利益率が可能だと主張している。ただし同社は、実際の収益は複数の要因により「大幅に低い」と認めており、このデータがAI業界全体の収益性議論に新たな視点を提供している。

理論上の高収益と現実のギャップ

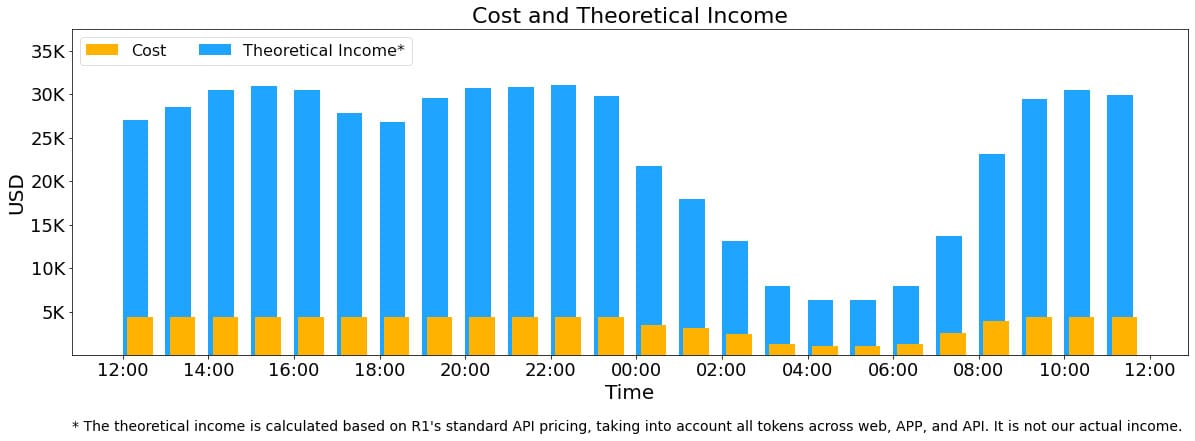

DeepSeekは、自社のDeepSeek-V3およびR1モデルの運用コストと潜在的な収益性について透明性の高いデータを公開した。同社の発表によると、2025年2月27日から28日の24時間の統計期間中、同社のAIサービスは608B(6080億)の入力トークンと168B(1680億)の出力トークンを処理した。

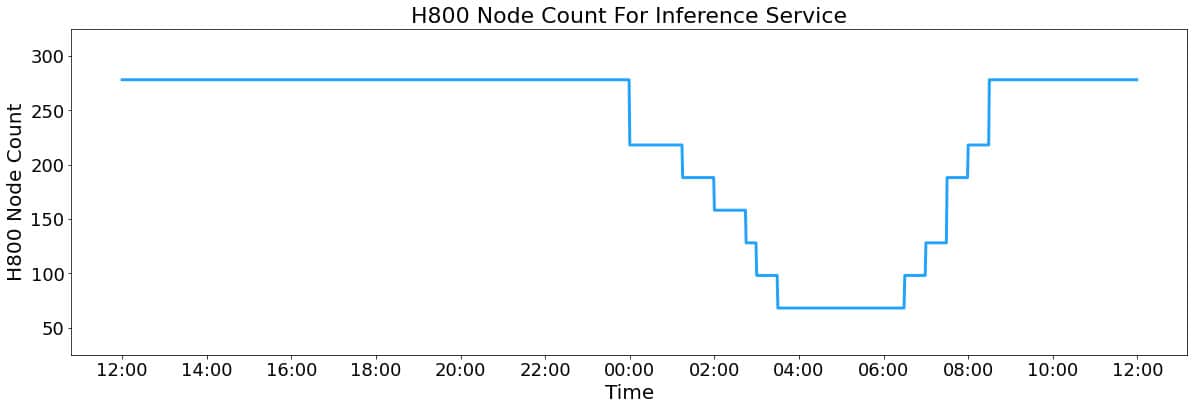

この処理に必要なハードウェアインフラは、平均して226.75のサーバーノードで構成され、各ノードには8つのNVIDIA H800 GPUが搭載されている。GPUのリース費用を1時間あたり2ドルと仮定すると、24時間の総コストは87,072ドルとなる。

DeepSeekによれば、プレミアムモデルであるR1の料金体系(キャッシュヒットした入力トークン: 100万トークンあたり0.14ドル、キャッシュミスした入力トークン: 100万トークンあたり0.55ドル、出力トークン: 100万トークンあたり2.19ドル)ですべてのトークンに課金した場合、理論上の日次収益は562,027ドルに達するという。この計算に基づくと、コストに対する利益率は545%となる。

しかし、DeepSeek自身も認めているように、実際の収益はこの理論値を大幅に下回っている。その主な理由として、同社は以下の3点を挙げている:

- DeepSeek-V3の料金はR1よりも大幅に低い設定になっている

- サービスの一部(主にAPI)のみが収益化されており、ウェブアクセスとアプリ利用は無料のままとなっている

- 深夜の低需要時間帯には自動的に割引が適用されている

これらの計算は「非常に推測的」であり、将来の潜在的な利益率を示唆するものであって、現在のDeepSeekの実際の収益状況を反映したものではないだろう。また、もし無料サービスを有料化すれば、利用量自体が大幅に減少する可能性も高いのではと、TechCrunchは指摘している。

効率的なインフラ管理によるコスト削減

とは言え、DeepSeekのシステム設計には注目すべき点も多い。同社は効率性を高めコストを削減するための複数の技術的工夫をシステム設計で施している。

特筆すべきは、入力トークンの56.3%(342B)がオンディスクのKVキャッシュから処理されている点だ。キャッシュからのトークン処理はコンピューティングリソースを大幅に節約する。

また同社は、需要の変動に応じた動的リソース割り当てシステムを採用している。昼間の高需要時間帯にはすべてのノードが推論リクエストを処理し、夜間の低需要時間帯には一部のリソースを研究開発やモデルトレーニングタスクに転用している。

技術的には、クロスノードのExpert Parallelism(EP)と呼ばれる手法を用いて、高いスループットと低いレイテンシーを実現。この手法により、バッチサイズの大幅な拡大とGPUのマトリックス計算効率の向上が可能になっているという。

各H800ノードは、プレフィリング(文脈理解)フェーズでは平均約73,700トークン/秒、デコーディング(文章生成)フェーズでは約14,800トークン/秒のスループットを達成している。平均出力速度は毎秒20〜22トークンで、出力トークンあたりの平均KVキャッシュ長は4,989トークンとなっている。

AI業界への影響と示唆

DeepSeekの透明性の高いデータ公開は、AI業界全体に関する重要な示唆を含んだものだ。

特に注目すべきは、言語モデルが「コモディティ化」の方向に進んでいる可能性だ。DeepSeekのデータは、言語モデルがOpenAIなどよりも大幅に低い価格設定でも、理論上は高い利益率を達成できることを示している。

これはOpenAIなど西側AI企業のビジネスモデルに対する挑戦となりうる。OpenAIの最新モデルGPT-4.5は、パフォーマンスの向上が限定的であるにもかかわらず、前世代モデルや競合他社の製品よりも大幅に高い価格設定となっている。

OpenAIのGTMマネージャーであるAdam Goldberg氏が最近、AIでの成功には「インフラからデータ、モデル、アプリケーションまでのバリューチェーン全体を制御すること」が重要だと強調したのも、こうした市場環境の変化を反映してのことかもしれない。言語モデル自体がコモディティ化する中、競争優位性はモデル単体ではなく、技術スタック全体の統合と最適化能力にシフトしつつあるのかもしれない。

Sources

コメント