量子コンピュータの実用化における最大の課題である「量子エラー訂正」の効率を大幅に向上させる人工知能システム「AlphaQubit」を、Google DeepMindとQuantum AIチームが共同開発した。Nature誌に掲載された研究によると、AlphaQubitは従来手法と比較して最大30%のエラー削減を実現し、より信頼性の高い量子計算への道を開いたという。

AIによる革新的なエラー訂正手法

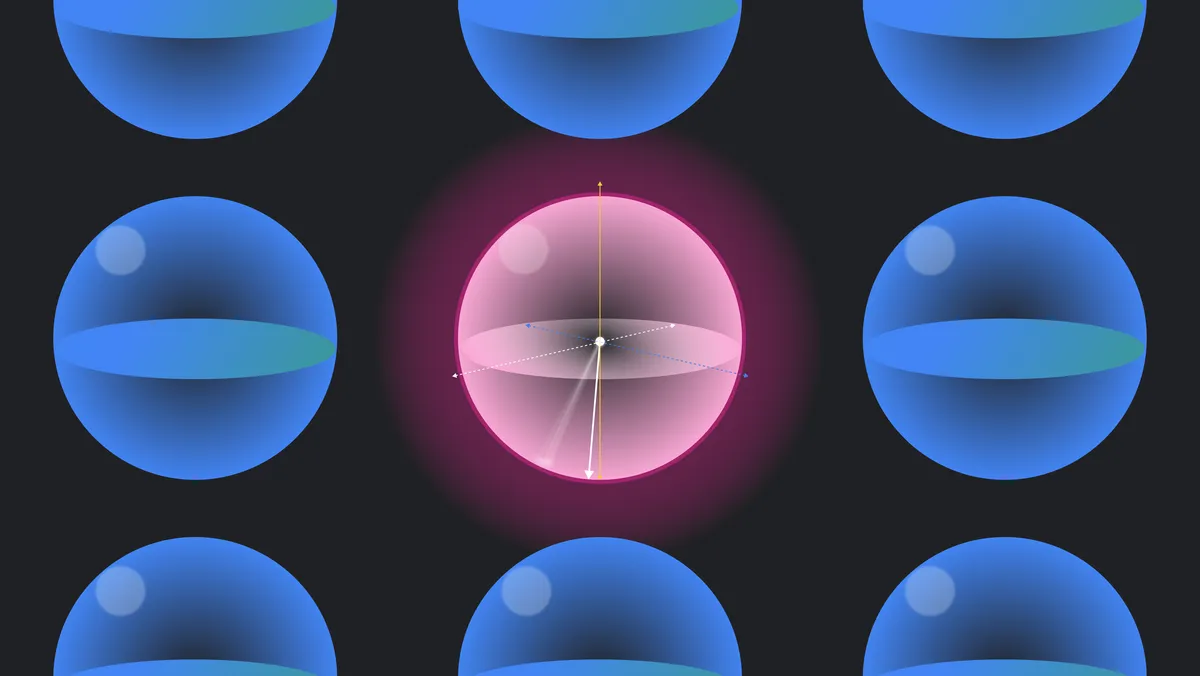

量子コンピュータは、量子ビット(キュービット)の特性を活用して特定の計算を従来のコンピュータよりも指数関数的に高速に処理できる可能性を持つ。しかし、キュービットは外部からの微細な欠陥、熱、振動、電磁干渉、さらには宇宙線といった様々な要因によって容易に状態が乱れ、エラーが発生する。現在のハードウェアでは1回の操作あたり1%から10%という高いエラー率が発生しており、これは実用的な計算には遠く及ばない水準だ。

AlphaQubitはこの課題に対し、大規模言語モデルで使用されているTransformer型のニューラルネットワークアーキテクチャを採用している。このシステムは複数の物理キュービットを1つの論理キュービットにグループ化し、定期的な整合性チェックを行うことでエラーを検出・訂正する。特筆すべきは、システムがクロストーク(キュービット間の望ましくない相互作用)やリーケージ(計算状態外への遷移)といった複雑なエラーパターンにも対応できる点である。

学習プロセスは2段階で構成されている。第一段階では量子シミュレータで生成された数億件の合成データを使用してプレトレーニングを行う。これにより、システムは様々なノイズ条件下での一般的なエラーパターンを学習する。第二段階では、Googleの量子プロセッサSycamoreから得られた実際のエラーデータを使用して微調整を行う。この段階で、ハードウェア固有のノイズ特性に適応する。

さらに革新的な点として、AlphaQubitは確率的な測定値を活用できる「ソフトリードアウト」機能を備えている。これにより、キュービットの状態についてより豊富な情報を得ることができ、より正確なエラー訂正が可能となる。研究チームによれば、この手法により、エラー訂正に必要な物理キュービットの数を削減できる可能性があり、量子コンピュータのコストと規模の最適化にも貢献することが期待される。

実証実験での優れた性能

Googleの研究チームは、同社が開発した量子プロセッサSycamoreを用いて、AlphaQubitの性能を徹底的に検証した。実験は3×3から11×11までの異なるサイズの表面コードを用いて実施され、特に注目すべき成果が得られた。

まず、3×3および5×5の表面コードを用いた実験では、AlphaQubitは従来の最高性能とされていたテンソルネットワークデコーダーを上回る性能を示した。具体的には、3×3コードでは1ラウンドあたりのエラー率を2.901%まで低減し、5×5コードでは2.748%という優れた結果を達成した。これは、テンソルネットワーク方式と比較して約6%の改善を意味する。さらに、広く使用されている相関マッチング方式と比較すると、約30%ものエラー削減を実現している。

より大規模なシステムへのスケーラビリティも実証された。研究チームは最大で11×11(241物理キュービット)までの表面コードでの検証を行い、AlphaQubitが大規模化しても優位性を保持できることを確認した。特筆すべきは、システムが単にエラーを検出・訂正するだけでなく、エラーの発生確率も高精度に予測できる点である。これにより、量子計算の信頼性を事前に評価することが可能となった。

耐久性の検証も実施され、AlphaQubitは最大100,000ラウンドという長時間の量子エラー訂正においても安定した性能を維持できることが示された。この結果は、実用的な量子計算に必要とされる長時間の安定性を確保できる可能性を示唆している。また、実験データによる学習(ファインチューニング)に必要なデータ量も比較的少なく、現実的な規模でシステムを最適化できることが確認された。

重要な点として、AlphaQubitはソフトウェアリードアウトと呼ばれる確率的な測定情報を活用できる。これにより、従来のバイナリ(0か1か)の測定値だけでなく、より詳細な状態情報を利用してエラー訂正の精度を向上させることに成功している。この機能により、特に複雑なノイズ環境下での性能向上が実現された。

実用化に向けた課題

AlphaQubitは量子エラー訂正において画期的な成果を示したものの、実用的な量子コンピューティングの実現に向けては、なお重要な課題が残されている。最も喫緊の課題は処理速度の向上である。超伝導量子コンピュータでは、1マイクロ秒ごとに100万回もの整合性チェックを実行する必要があるが、現状のAlphaQubitはこの高速な処理要求に対応できていない。研究チームは、ニューラルネットワークの軽量化や専用ハードウェアの開発などを通じて、この課題に取り組む方針を示している。

スケーラビリティの問題も重要な課題として挙げられる。実用的な量子計算には、論理エラー率を10の-12乗以下に抑える必要があるとされている。これを達成するには、現在実証されている11×11(241物理キュービット)を大きく超えるスケールでの動作が求められる。しかし、システムの規模が大きくなるにつれて、学習に必要なデータ量が非線形的に増加することが判明している。研究チームは、データ効率を向上させる新しい学習手法の開発や、アーキテクチャの最適化が必要だと指摘している。

さらに、実験データの効率的な活用も課題となっている。量子デバイスから得られる実験データは限られており、高価である。AlphaQubitは一般的なノイズモデルでプレトレーニングを行った後、実験データで微調整するという2段階のアプローチを採用しているが、より少ない実験データで効果的な学習を実現する手法の開発が求められている。研究チームは、メタラーニングや Few-shot学習などの先進的な学習手法の適用を検討している。

また、実用的な量子コンピューティングでは、単純なメモリ実験を超えて、より複雑な量子回路の実行が必要となる。AlphaQubitを実際の量子計算に適用するためには、格子手術(Lattice Surgery)などの高度な操作にも対応できるよう、システムを拡張する必要がある。研究チームは、異なる量子操作に対応する複数のネットワークコンポーネントを組み合わせる方式を提案しているが、この実現にはさらなる研究開発が必要とされている。

これらの課題に対して、研究チームは楽観的な見方を示している。機械学習ハードウェアの継続的な進歩や、より効率的な学習アルゴリズムの開発により、これらの課題は段階的に克服できると考えられている。実際、約2.6年ごとに演算性能が2倍になるというトレンドが継続すれば、大規模な量子コンピュータの実現時期までには、必要な処理性能を達成できる可能性が高いとしている。

論文

参考文献

研究の要旨

大規模量子コンピュータの構築には、物理的量子システムで不可避的に発生するエラーを効果的に訂正する戦略が必要である。 量子誤り訂正符号 は、論理情報を多数の物理量子ビットに冗長的に符号化することで、この目標を達成する方法を提示している。 このような符号を実装する際の重要な課題は、冗長検査から抽出されたノイズの多いシンドローム情報を正確に復号し、符号化された正しい論理情報を得ることである。 ここでは、量子誤り訂正符号の代表格であるサーフェス符号のデコードを学習する、リカレント変換器ベースのニューラルネットワークを開発する。 我々のデコーダーは、GoogleのSycamore量子プロセッサーの実データにおいて、距離3と距離5の表面符号について、他の最先端のデコーダーを凌駕した。 距離11までは、クロストークやリークを含む現実的なノイズを含むシミュレーションデータにおいて、ソフト読み出しとリーク情報を利用することで、デコーダーの優位性を維持している。 近似的な合成データで学習した後、限られた予算の実験サンプルで学習することで、デコーダはより複雑だが未知の基礎誤差分布に適応する。 我々の研究は、機械学習がデータから直接学習することで、人間が設計したアルゴリズムを超える能力を示すものであり、機械学習が量子コンピューターにおける復号化の有力な候補であることを強調している。

コメント