クラウドコンピューティングが次の段階に進み始めた。Microsoft Azureは、NVIDIAの最新GPU「Blackwell」を搭載したサーバーラックを世界で初めて公開した。

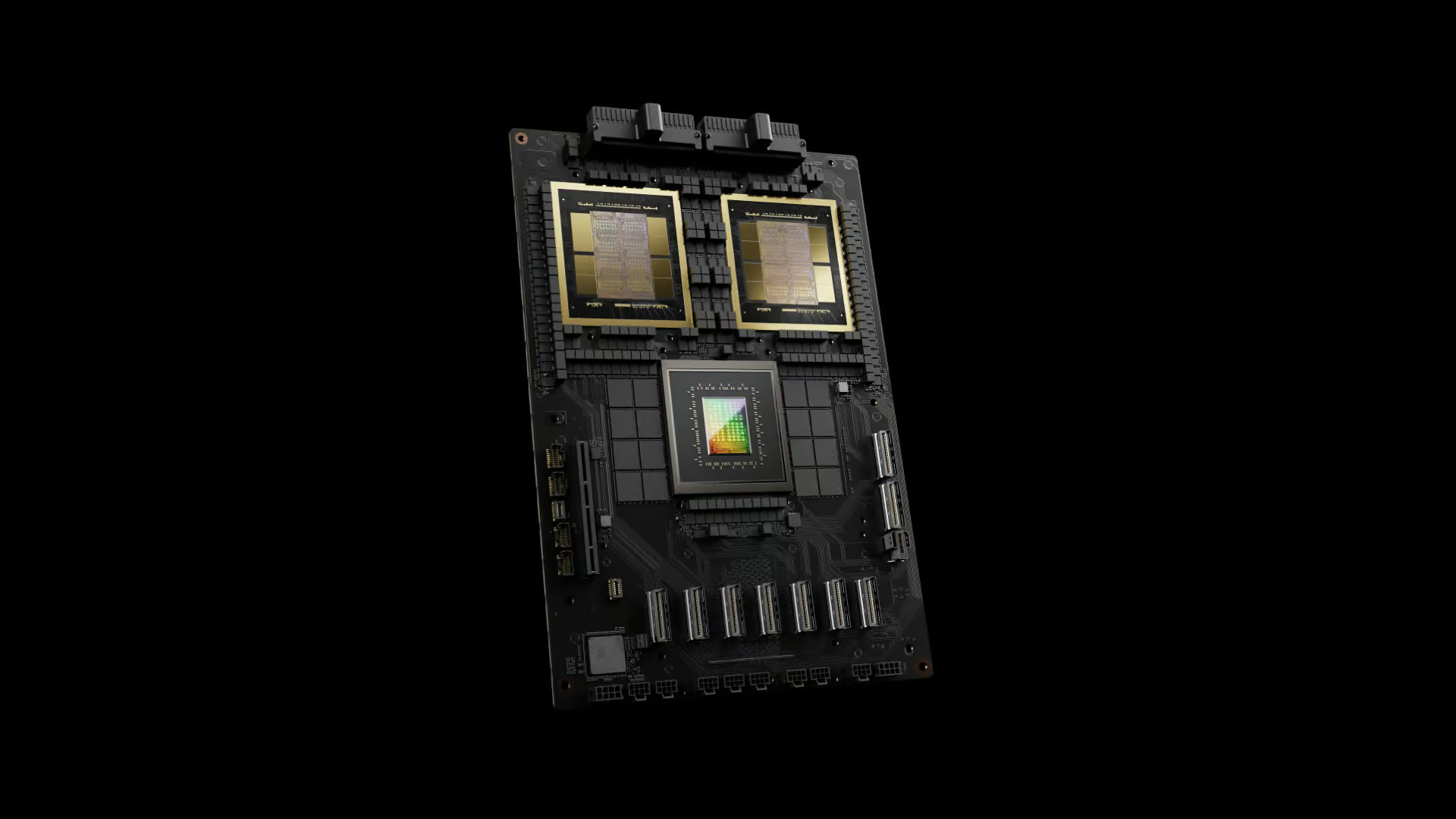

Microsoft Azureの公式Xアカウントを通じて発表されたこの新システムは、NVIDIA GB200プロセッサを搭載し、高度なAIモデルの学習と推論を可能にする。同社は、InfiniBandネットワーキングや革新的なクローズドループ液冷システムを活用し、あらゆるレベルで最適化を行っているとのことだ。

Microsoft AzureによるNVIDIA GB200システムの公開

Microsoftの最高経営責任者(CEO)であるSatya Nadella氏は、「NVIDIAとの長年にわたるパートナーシップと深いイノベーションにより、業界をリードし続け、最も洗練されたAIワークロードを実現しています」とコメントしている。この発表は、MicrosoftがAI分野におけるリーダーシップを強化する意思を明確に示すものだ。

NVIDIA Blackwell GPUは、AIと高性能コンピューティング分野に大きな飛躍をもたらす可能性を秘めている。B200 GPUは、前世代のH100プロセッサと比較して、FP8/INT8性能で2.5倍の向上を実現し、具体的には、4,500 TFLOPS/TOPSという驚異的な性能を誇り、H100の1,980 TOPSを大きく上回っている。

さらに注目すべきは、FP4データフォーマットにおいて、B200 GPUが9 PFLOPSという圧倒的な性能を発揮することだ。これにより、極めて複雑な大規模言語モデル(LLM)の学習が可能となり、AIの新たな利用モデルへの扉を開くことになる。

Microsoft Azureが公開したGB200システムの詳細は明らかにされていないが、テスト用途として少なくとも1台のGB200ベースのサーバーラックが稼働していると推測される。このラックには、未確認ながら32基のB200プロセッサが搭載されている可能性が高い。

革新的な冷却システム

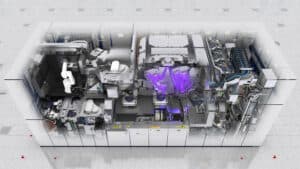

NVIDIA Blackwell GPUの驚異的な性能は、同時に膨大な熱を生み出す。そのため、Microsoft Azureが開発した革新的な冷却システムが注目を集めている。

公開された画像によると、冷却システムは計算ラックの2倍以上のスペースを占めている。この巨大な冷却装置は、クーラント分配ユニット(CDU)と呼ばれ、液体から空気への熱交換を行う。本質的には、高度に洗練された自動車のラジエーターのような役割を果たしている。

CDUには、大型の液体-空気熱交換器、ポンプ、電源、モニタリング機器が含まれている。この冷却システムの規模は、デスクトップPCユーザーが大型の空冷クーラーや水冷システムを使用する傾向と類似しているが、はるかに大規模だ。

興味深いのは、MicrosoftがAWSやGoogleのような秘密主義の組織とは異なり、ラックだけでなくCDUのデザインも公開していることだ。これは、同社の技術的な自信と透明性への姿勢を示していると言える。

クラウドコンピューティング業界へ与える影響

Microsoft AzureによるNVIDIA Blackwell GPU搭載サーバーの導入は、クラウドコンピューティングとAI業界に大きな影響を与えると予想される。この動きは、高度なAIモデルの開発と利用を加速させ、さまざまな分野でのイノベーションを促進する可能性がある。

現在のところ、このGB200システムはテスト用途で使用されていると考えられるが、近い将来、商用ワークロード向けに展開される見込みだ。業界筋によると、MicrosoftはNVIDIAのNVL72 GB200マシンを好んでいるとされ、これは72基のB200グラフィックプロセッサを搭載し、約120kWの電力を消費・放熱する。

Blackwellベースのサーバーの大規模展開は、2024年後半から2025年初頭にかけて本格化すると予想されている。Microsoftは、2024年11月18日から22日にかけてシカゴで開催される年次カンファレンス「MS Ignite」で、Blackwellベースのマシンやその他のAIプロジェクトに関する詳細を明らかにする見込みだ。

この技術革新は、AIの民主化と高度化を促進し、研究機関や企業が複雑なAIモデルを効率的に開発・実行できる環境を提供するだろう。同時に、エネルギー効率と持続可能性の観点から、高性能コンピューティングの未来に新たな課題を投げかけている。

Sources

コメント