アナリストのMing-Chi Kuo氏がMediumに投稿した情報によると、NVIDIAが既に発表したBlackwellの次の世代となる「Rubin」アーキテクチャに基づいた「R100」AIアクセラレータは、TSMCの3nmプロセスによって製造され、HBM4メモリを搭載し、2025年の第4四半期に量産を開始するようだ。

AIパフォーマンス向上と電力効率の向上が焦点に

NVIDIAの次世代アーキテクチャは、米国の天文学者で、最近その名を冠した天文台もついに今年稼働を開始する、Vera Rubin氏にちなんで「Rubin」と名付けられている。

今回アナリストのMing-Chi Kuo氏は、NVIDIAのRubinシリーズの一つとなる「R100」GPUは、2025年第4四半期に量産が開始され、DGXやHGXなどのシステムは2026年前半に量産される予定だと報告している。

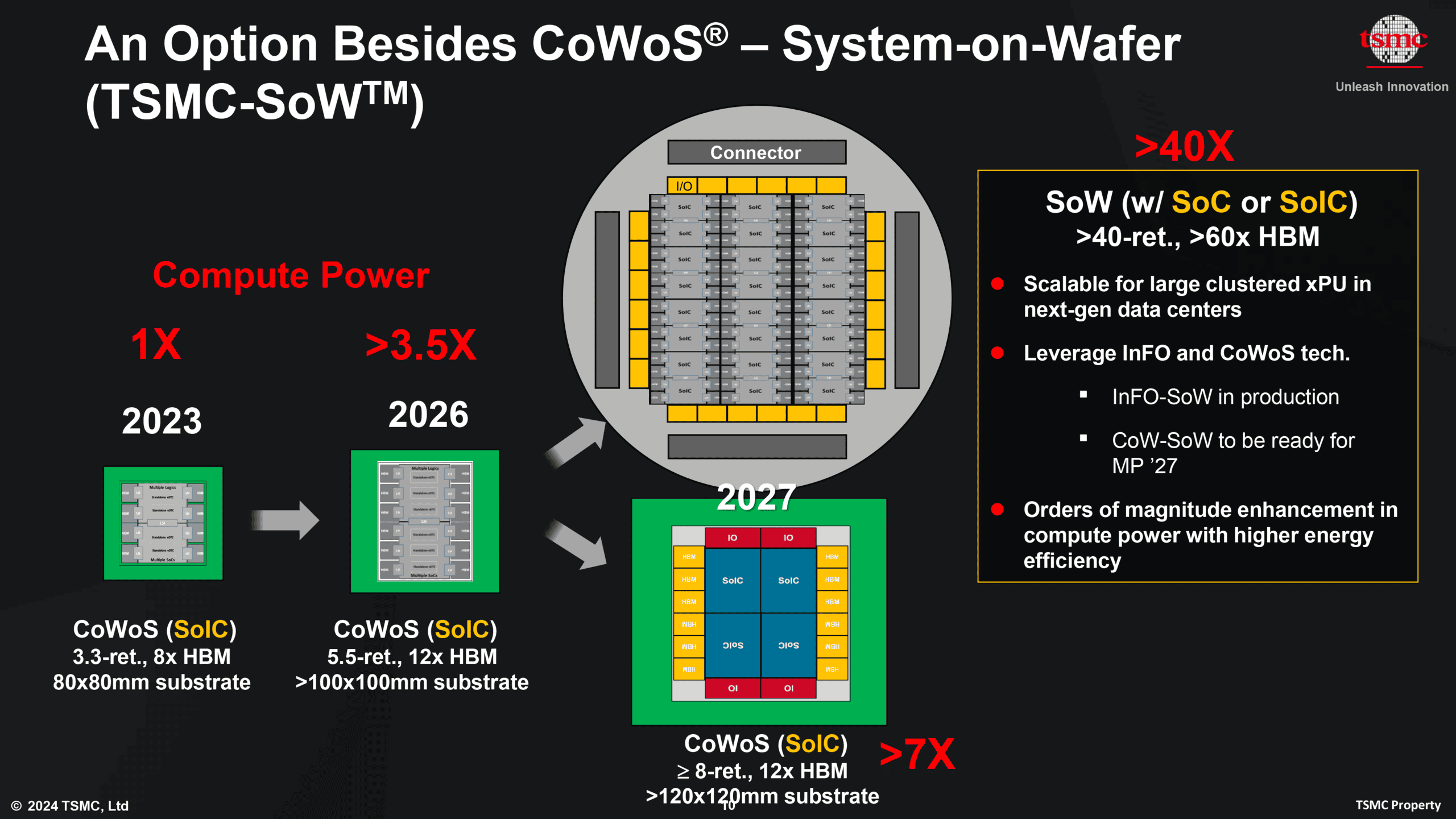

今年発表されたNVIDIAの「Blackwell」B100チップがTSMCのN4Pを採用しているのに対し、R100はTSMCのN3ノード(恐らくN3P)を採用し、B100と同じ「CoWoS-L」パッケージングを採用する可能性があるようだ。

また、B100の3.3倍のレクチルサイズに対し、R100は4倍にまでなるという。ただし、現時点ではインターポーザーの設計は確定していない。これに先立ち、TSMCは最近、2026年までに最大5.5倍のレクチルサイズのチップを製造する計画を打ち出していたが、これはRubinなどのAIやHPCトレンドへの対応も見越しての物だ。TSMCは少し前、6,864mm2ともなるCoWoS巨大パッケージに、12個のHBM4メモリ・スタックと追加のI/Oダイとともに、4個のスタックド・ロジック・チップレットを組み込むことができると述べていた。

その他の情報によると、NVIDIAは次世代HBM4 DRAMをR100 GPUに搭載する予定だという。なお、同社は現在、B100 GPU向けには、現在最速のHBM3Eメモリを利用しているが、2025年後半にHBM4が広く量産されるようになれば、これらのチップもHBM4バリアントでリフレッシュする見込みだ。

NVIDIAはまた、TSMCの3nmプロセスをベースとする2つのR100 GPUとアップグレードされたGrace CPUを搭載するGR200 Superchipモジュール向けに、Grace CPUをアップグレードする予定である。現在、Grace CPUはTSMCの5nmプロセスノードで製造されており、Grace Superchipソリューションには72コア、合計144コアが搭載されている。

NVIDIAのRubin GPUの設計目標の1つは、消費電力を抑えることだ。NVIDIAのB200 GPUは最大1000Wの電力を消費するように構成することができ、2つのB200 GPUと1つのGrace CPUで構成されるGB200ソリューションは最大2700Wを消費する。このような消費電力は、データセンターがこれらのコンピュートGPUの大規模なクラスターに給電し、冷却することを困難にするため、Nvidiaは何らかの対策を講じる必要がある。NVIDIAがBlackwellベースの製品に比べ、性能を目に見える形で向上させながら消費電力を下げることに実際に成功するのか、それとも代わりに性能効率に重点を置くのかはまだ不明だ。

NVIDIAは2025年第4四半期にR100プロセッサーの量産を開始すると予測されているため、同社のRubin GPUをベースとした実際のシステムやラックソリューションの生産開始は2026年前半になるとKuo氏は見ている。その結果、R100ベースのマシンが実際のデータセンターに登場するのは、早くても2026年半ばからになるだろう。

Sources

- MingChi Kuo – Medium: Some prediction updates about Nvidia’s next-generation AI chip R-series/R100

コメント