OpenAIは、AI画像のトレーサビリティのため、「C2PA (Coalition for Content Provenance and Authenticity)」をサポートし、独自のAI画像検出器へのアクセスを研究者に初めて提供することを発表した。

OpenAIは、DALL-E 3画像にC2PAのメタデータを追加することを発表し、Soraビデオモデルにも同様のメタデータを追加する予定であることを明らかにした。これに伴い同社は、C2PA運営委員会に参加し、デジタルコンテンツのトレーサビリティ標準の開発を支援する。

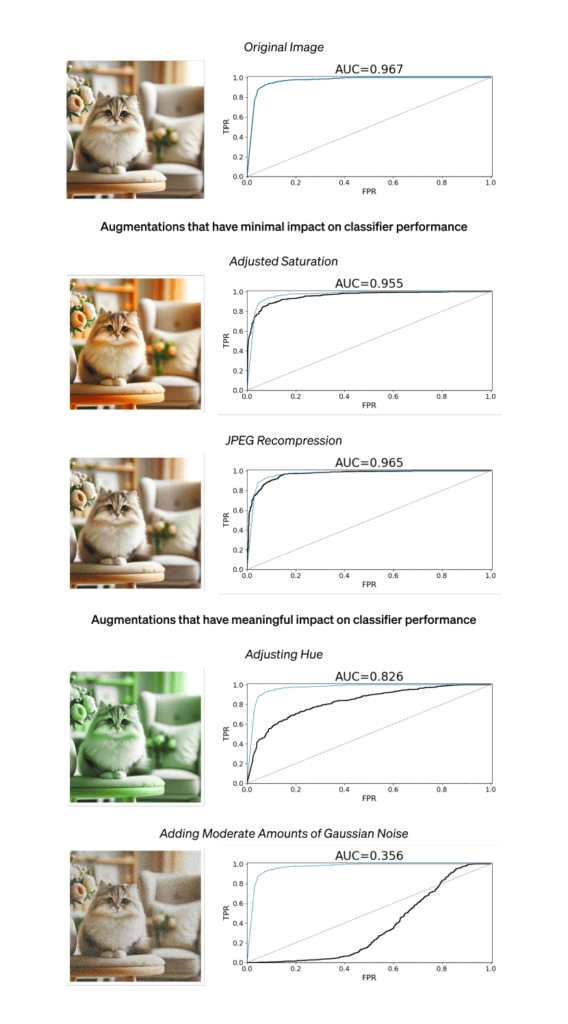

C2PA規格のサポートに加えて、OpenAIは独自の改ざん防止透かしと、AIが生成した画像を検出するためのAIベースの画像検出器を開発している事も報告している。OpenAIによれば、この現在テスト中の名称が決まっていないツールの初期バージョンは、DALL-Eが作成した画像の98%以上を識別することに成功し、DALL-Eが作成した画像であると誤認したのは0.5%未満であったという。また、画像に何らかの加工が施されていると、問題が発生する。トリミングや圧縮、彩度の変更など、ちょっとした修正では、分類精度には大きな差はなかったとのことだ。確かに少し精度は下がったが、それでも約95~97%と許容範囲内だった。ただし、色相を調整すると、成功率は82%まで低下したという。

このツールは現在、多くの “研究所や研究志向のジャーナリズムNPO “によって非公開でテストされている。このツールがいつ一般に利用可能になるかは未定である。

私たちの目標は、分類器の有効性を評価し、その実世界での適用を分析し、そのような使用に関連する考慮事項を浮上させ、AIが生成したコンテンツの特性を探求する独立した研究を可能にすることです。

しかし、この画像検出器が上記の高精度を発揮するのは、あくまでも“DALL-E”によって作成された画像に対してである。OpenAIによると、他のAIモデルによって生成された画像では、分類の成功率はわずか5~10パーセントにしかならなかったとのことだ。OpenAIによると、AIが生成した画像に関連する問題に効果的に対処するためには、業界の集団的なアプローチが必要だと主張している。

また、更に大きな問題としては、広範な変更が加えられた場合は更に検出率が下がったようだ。OpenAIは成功率を公表しておらず、単に”他の変更は、パフォーマンスを低下させる可能性がある”とだけ述べている。つまり、一部を切り抜いて他の画像と合成した様なものであれば、ほとんど検出は困難になるという事が想像できる。

加えて、OpenAIとMicrosoftは「Societal Resilience Fund(社会的レジリエンス基金)」と呼ぶものに200万ドルを出資するために提携している。この基金は、”AIの教育と理解 “に専念する数多くの組織への資金援助に使われるとのことだ。

Sources

コメント