2024年のノーベル物理学賞が、「人工ニューラルネットワークによる機械学習を可能にする基礎的発見と発明」により、John Hopfield氏とGeoffrey Hinton氏に授与された。

物理学と生物学からのアイデアに触発され、HopfieldとHintonはデータのパターンを記憶し、学習できるコンピューターシステムを開発した。直接的な共同研究はなかったものの、互いの研究を基に現在の機械学習と人工知能(AI)ブームの基礎を築いた。

ニューラルネットワークとは何か?(そして物理学とどう関係しているのか?)

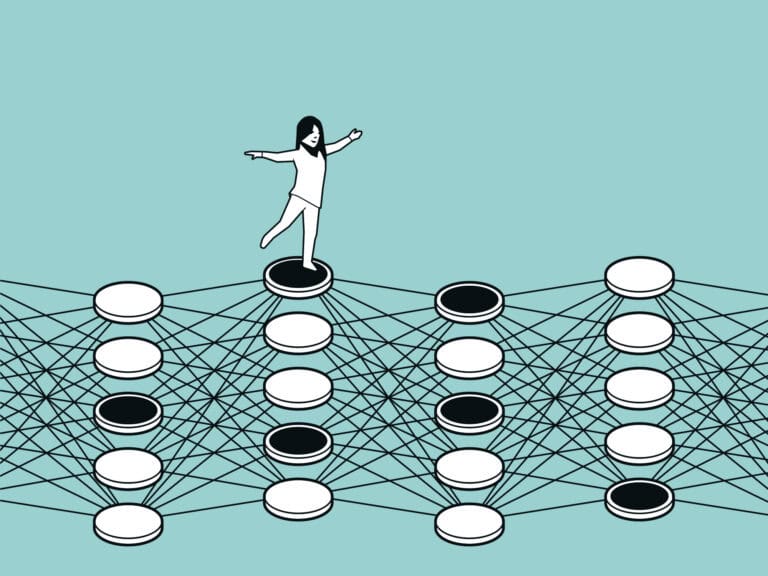

人工ニューラルネットワークは、現在我々が使用している多くのAI技術の背後にある。

人間の脳にニューロン細胞とシナプスによる結合があるように、人工ニューラルネットワークにはデジタルニューロンが様々な形で結合している。個々のニューロンは大したことをしない。代わりに、魔法はニューロン間の結合のパターンと強さにある。

人工ニューラルネットワークのニューロンは入力信号によって「活性化」される。これらの活性化は、入力情報を変換し処理できる方法で、あるニューロンから次のニューロンへとカスケード的に伝わる。結果として、ネットワークは分類、予測、意思決定などの計算タスクを実行できる。

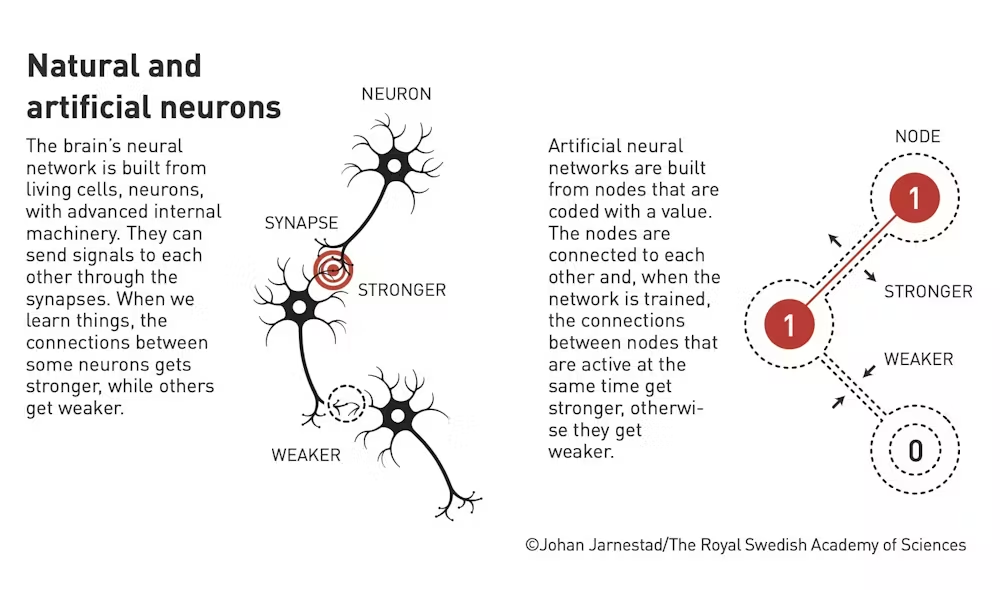

自然のニューロンと人工ニューロン

- 自然のニューロン(Natural Neurons)

- 脳の神経ネットワークは、生きている細胞であるニューロン(神経細胞)で構成されており、内部には高度な機構が備わっている。

- これらのニューロンはシナプス(synapse)を通じて互いに信号を伝達できる。

- 私たちが物事を学ぶとき、あるニューロン間の接続(シナプス結合)は強化され、他の接続は弱くなる。

- 強い接続(Stronger): ある学習や経験によって強化されたニューロン同士の接続を表している。

- 弱い接続(Weaker): 使われる頻度が少ないか、活動性の低いニューロン同士の接続を示している。

- 人工ニューロン(Artificial Neurons)

- 人工神経ネットワークは、値を持つノード(人工ニューロン)で構成されている。

- これらのノードは互いに接続されており、ネットワークがトレーニングされると、同時に活性化しているノード間の接続が強くなり、そうでない場合は接続が弱くなる。

- 強い接続(Stronger): 活動中のノード間の接続が強化されている状態。

- 弱い接続(Weaker): 活動が少ないノード間の接続が弱くなることを示している。

機械学習の歴史のほとんどは、人工ニューロン間のこれらの結合を形成し更新するためのより洗練された方法を見つけることであった。

情報を保存し処理するためにノードのシステムをリンクさせるという基本的なアイデアは生物学から来たが、これらのリンクを形成し更新するために使用される数学は物理学から来ている。

記憶できるネットワーク

John Hopfield(1933年生まれ)は、生物物理学の分野で重要な貢献をした米国の理論物理学者である。しかし、ノーベル物理学賞は1982年のHopfieldネットワークの開発に対するものであった。

Hopfieldネットワークは、最も初期の人工ニューラルネットワークの一つであった。神経生物学と分子物理学の原理に触発されたこのシステムは、コンピューターが情報を記憶し呼び出すために「ネットワーク」のノードを使用できることを初めて実証した。

Hopfieldが開発したネットワークはデータ(例えば白黒画像のコレクション)を記憶できた。これらの画像は、ネットワークが類似の画像で促された時に連想によって「想起」できた。

実用性は限られていたが、HopfieldネットワークはこのタイプのANNがデータを新しい方法で保存し取り出せることを示した。これらはHintonの後の研究の基礎を築いた。

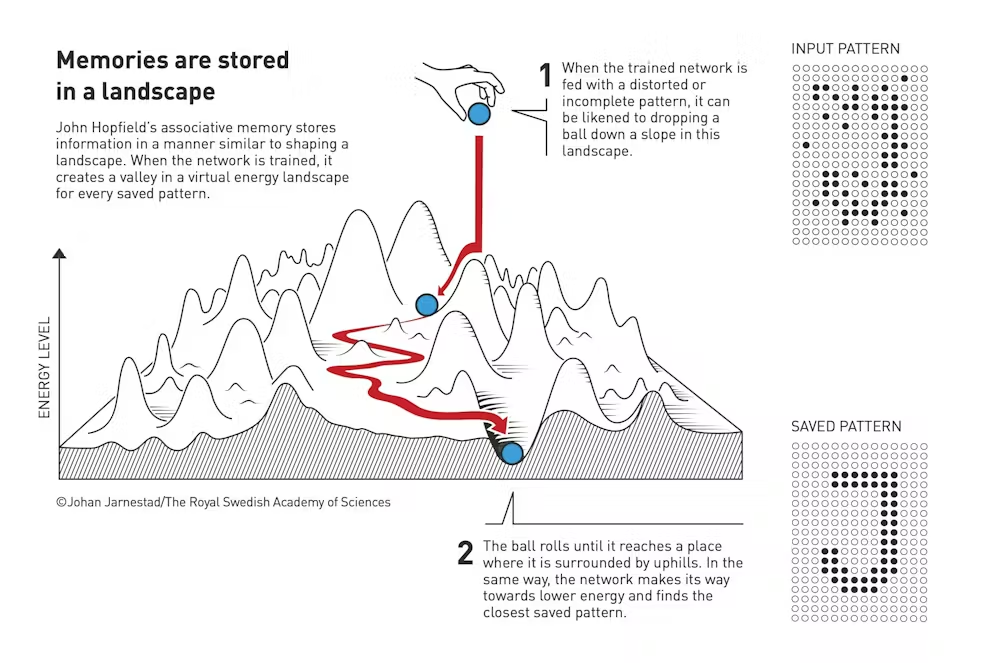

記憶は風景の中に保存される

John Hopfieldの連想記憶は、風景を形作るように情報を保存する。ネットワークが学習されると、保存された各パターンに対応する仮想的なエネルギー風景の中に谷を形成する。

- 歪んだパターンや不完全なパターンが学習済みのネットワークに与えられると、風景の斜面にボールを落とすことに例えられる。

- ボールは上り坂に囲まれた場所に到達するまで転がる。同様に、ネットワークもエネルギーが低い方へ向かい、最も近い保存されたパターンを見つける。

学習できる機械

「AIの父」の一人と呼ばれることもあるGeoff Hinton(1947年生まれ)は、この分野に多くの重要な貢献をした英国系カナダ人のコンピューターサイエンティストである。2018年には、Yoshua BengioとYann LeCunと共に、機械学習全般、特にディープラーニングと呼ばれる分野を進歩させた功績により、チューリング賞(コンピューターサイエンスにおける最高の栄誉)を受賞した。

しかし、ノーベル物理学賞は特に1984年のTerrence Sejnowskiと他の同僚とのBlotzmannマシンの開発に対するものである。

これはHopfieldネットワークの拡張で、機械学習の概念、つまりプログラマーではなくデータの例から学習できるシステムを実証した。統計物理学のエネルギー動力学のアイデアを取り入れ、Hintonはこの初期の生成コンピューターモデルが、記憶すべき事例を示されることで、時間をかけてデータを保存する方法を学習できることを示した。

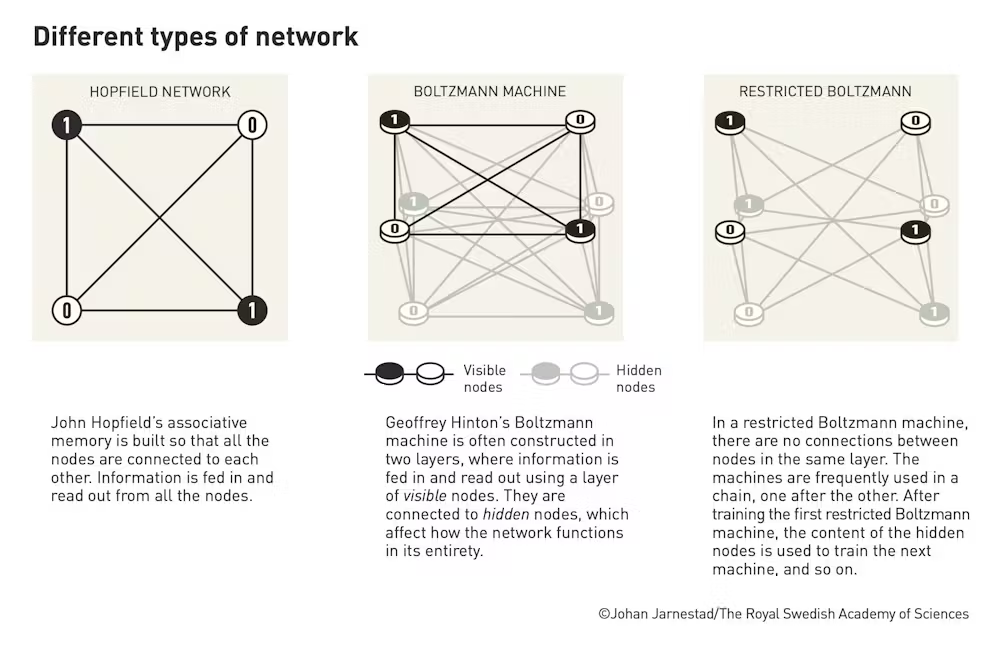

Hopfieldネットワーク

- John Hopfieldの連想記憶モデルは、すべてのノードが互いに接続されるように構築されている。情報はすべてのノードを通じて入力および出力される。

Boltzmannマシン

- Geoffrey HintonのBoltzmannマシンは通常、2層構造で設計され、情報は「可視ノード(visible nodes)」の層を通じて入力され、読み出される。これらの可視ノードは「隠れノード(hidden nodes)」に接続されており、この構造がネットワーク全体の動作に影響を与える。

制限付きBoltzmannマシン

- 制限付きBoltzmannマシンでは、同じ層内のノード間に接続はない。これらのマシンは、次々とチェーンのように使用される。最初の制限付きBoltzmannマシンをトレーニングした後、隠れノードの内容は次のマシンをトレーニングするために使用され、この手順が繰り返される。

Blotzmannマシンは、先行するHopfieldネットワークと同様に、即座に実用的な応用はなかった。しかし、修正された形(制限付きBlotzmannマシンと呼ばれる)はいくつかの応用問題で有用であった。

より重要だったのは、人工ニューラルネットワークがデータから学習できるという概念的ブレークスルーだった。Hintonはこのアイデアの発展を続けた。後に、バックプロパゲーション(現代の機械学習システムで使用される学習プロセス)と畳み込みニューラルネットワーク(今日の画像や動画データを扱うAIシステムで主に使用されるニューラルネットワークの主要タイプ)に関する影響力のある論文を発表した。

なぜ今、この賞なのか?

HopfieldネットワークとBlotzmannマシンは、今日のAIの偉業に比べると気まぐれに見える。Hopfieldのネットワークはわずか30個のニューロンしか含んでいなかった(100個のノードで試みたが、当時のコンピューティングリソースでは多すぎた)が、ChatGPTのような現代のシステムは数百万個を持つことができる。しかし、今日のノーベル賞は、これらの初期の貢献がこの分野にいかに重要であったかを強調している。

ChatGPTのような生成AIシステムでほとんどの人に馴染みのあるAIの最近の急速な進歩は、ニューラルネットワークの初期の提唱者たちの正当性を証明しているように見えるかもしれないが、少なくともHintonは懸念を表明している。2023年、Googleの人工知能部門での10年間の仕事を辞めた後、彼は開発の速度に恐れを抱いていると述べ、より積極的なAI規制を求める声の高まりに加わった。

ノーベル賞受賞後、Hintonは「AIは産業革命のようなものになるでしょうが、物理的能力の代わりに知的能力を超えることになるでしょう」と述べた。また、自分の仕事の結果が「最終的に制御を奪取する可能性のある、私たちよりも知的なシステム」になる可能性についてまだ心配していると述べた。