Microsoftが自社開発したAIアクセラレータチップ「Maia 100」の詳細が明らかになった。Hot Chips 2024で公開された情報によると、Maia 100はAzureクラウド上の大規模AIワークロード向けに特化設計された革新的なチップだ。この動きは、クラウドAIインフラストラクチャの最適化における、ハードウェアとソフトウェアの共同設計の重要性を示している。

Maia 100:Microsoftの野心が詰まったAIチップ

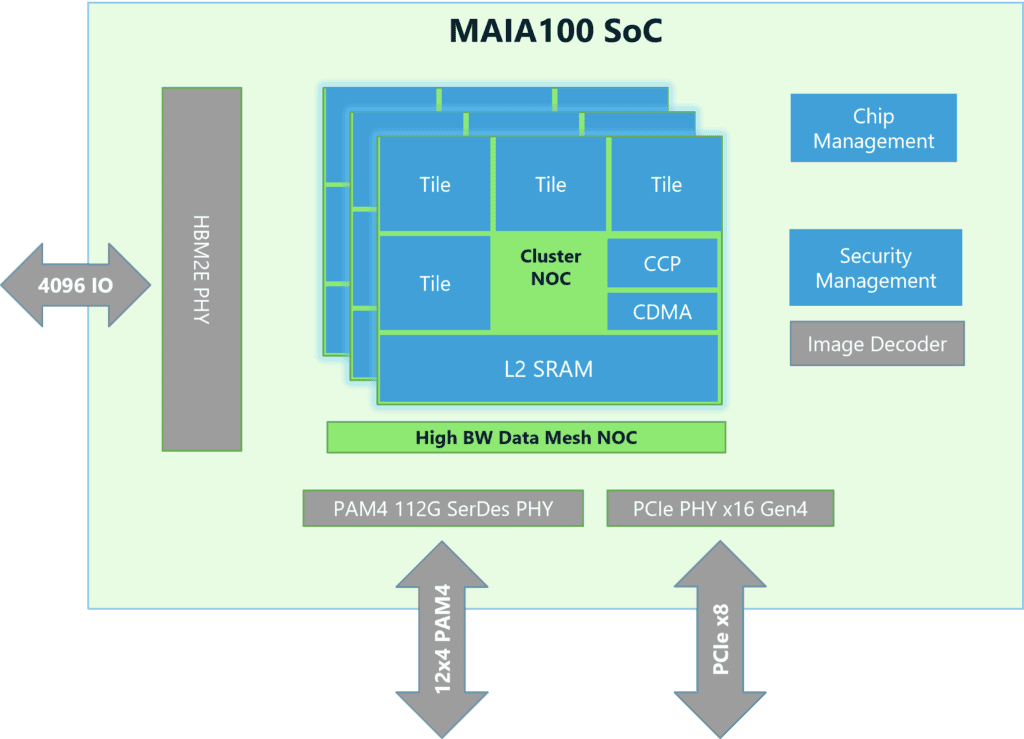

Maia 100は、TSMCの5nmプロセスを採用し、COWOS-S インターポーザー技術を活用した約820mm²の大型チップだ。主要スペックには目を見張るものがある:

- HBM2E メモリを採用し、1.8TB/秒の帯域幅と64GBの容量を実現

- 6ビット精度で3POPS、9ビット精度で1.5POPS、BF16精度で0.8POPSの演算性能

- 500MBのL1/L2キャッシュ

- 最大700Wの設計TDP(実運用は500W)

- PCIe Gen5 x8によるホスト接続(32GB/秒の帯域幅)

このチップの中核となる特徴は、高性能なテンソルユニットと柔軟なベクトルプロセッサの組み合わせだ。16xRx16構成の高速テンソルユニットは、トレーニングと推論の両方で高速処理を実現し、低精度データタイプであるMXフォーマットにも対応している。一方、ベクトルプロセッサは、カスタム命令セットアーキテクチャ(ISA)を採用したルーズカップリングのスーパースカラーエンジンで、FP32やBF16など幅広いデータタイプをサポートする。

メモリ性能も注目に値する。Maia 100は4つのHBM2Eダイを組み合わせ、1.8テラバイト/秒の帯域幅と64ギガバイトの容量を提供する。これにより、大規模AIモデルのデータ処理要件に十分対応できる設計となっている。さらに、大容量のL1およびL2スクラッチパッドがソフトウェアで管理され、データ利用効率と電力効率を最適化している。

特筆すべきは、Microsoftが独自に開発したMXデータフォーマットをサポートしている点だ。これにより、低精度演算での高効率な処理が可能となっている。

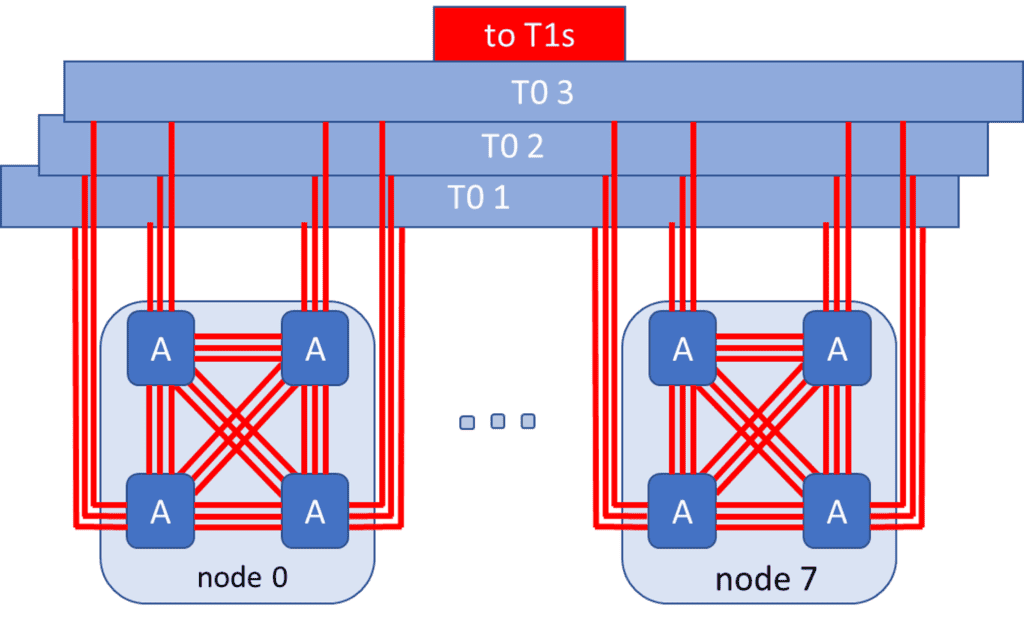

Maia 100の革新性は、ネットワーキング能力にも表れている。Microsoftが主導して開発したUltra Ethernet Consortiumの技術を活用し、イーサネットベースの相互接続を採用している。カスタムRoCE類似プロトコルにより、最大4800 Gbpsのall-gatherおよびscatter-reduced帯域幅、1200 Gbpsのall-to-all帯域幅をサポートする。これにより、大規模AIモデルの分散処理が可能になり、スケールアップとスケールアウトの両方のワークロードに対応できる柔軟性を備えている。

電力管理面では、Maia 100は700Wの設計TDPを持ちながら、500Wで運用されるよう設定されている。これにより、ワークロードに応じて効率的に電力を管理できる仕組みが整っている。

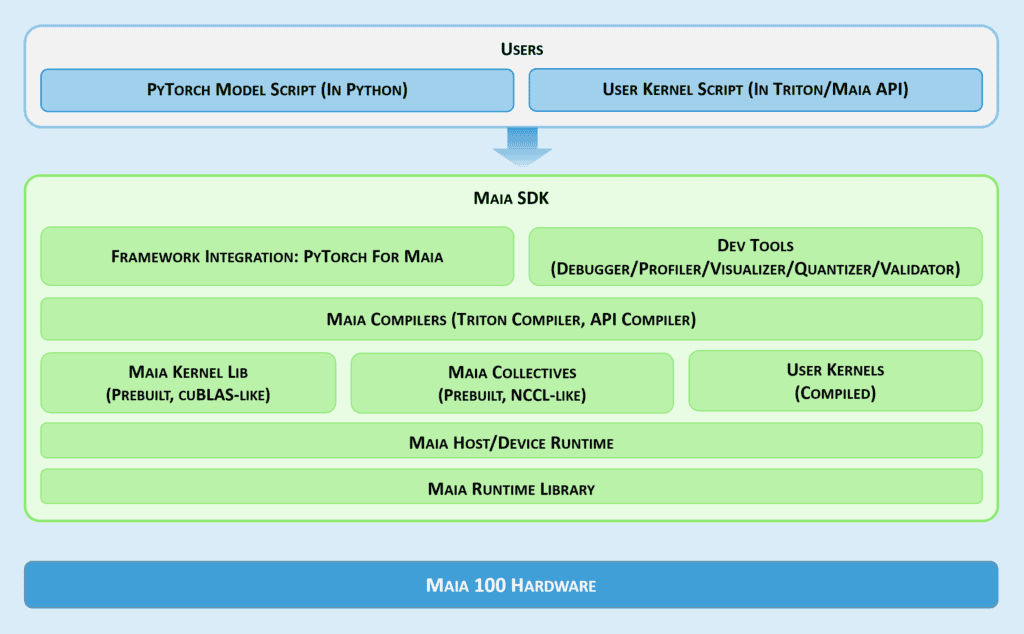

しかし、Maia 100の真の革新性は、ハードウェアとソフトウェアの緊密な統合にある。MicrosoftはMaia SDKを提供し、開発者がPyTorchやTritonで記述したモデルを素早くMaia上に移植できるようにしている。このSDKには、フレームワーク統合、開発者ツール、コンパイラ、カーネルおよびコレクティブライブラリ、Maia Host/Deviceランタイムなど、包括的なコンポーネントが含まれている。

さらに、TritonとMaia APIという2つのプログラミングモデルを用意し、開発者は柔軟性とパフォーマンスのバランスを選択できる。Tritonは人気のオープンソースドメイン固有言語(DSL)で、コーディングを簡素化し、GPUとMaia両方で動作する。一方、Maia APIはMaia特有のカスタムプログラミングモデルで、より詳細な制御と最大のパフォーマンスを提供する。

Maia 100は、行列乗算にGatherベースのアプローチを採用している点も特筆すべきだ。これにより、SRAMで直接GELUなどの後処理活性化関数を融合させ、ネットワーク通信と計算を重複させ、量子化されたデータをネットワーク経由で送信することで、全体的なシステムパフォーマンスを向上させている。

この垂直統合されたシステムにより、Microsoftはクラウドアーキテクチャの各層で学んだ知見を活かし、高度な冷却やネットワーキングのニーズから、モデルの迅速な展開を可能にするソフトウェアスタックまで、大規模ワークロードをより効率的に実行できるようになった。Maia 100は、Azure OpenAI Servicesなどのサービスで高度なAI機能の性能とコスト効率を向上させることが期待されている。

MicrosoftがこのAIアクセラレータチップを第三者組織に開放するかどうかは今後の動向が注目されるが、GoogleのTPUやAmazonのTrainium/Inferentiaチップのように、クラウドAIインフラストラクチャの競争が激化する中で、MicrosoftのAI戦略における重要な一手となることは間違いない。Maia 100の登場により、AIハードウェアとソフトウェアの共最適化の重要性が改めて浮き彫りとなり、クラウドAIの未来に新たな可能性を示している。

Source

コメント