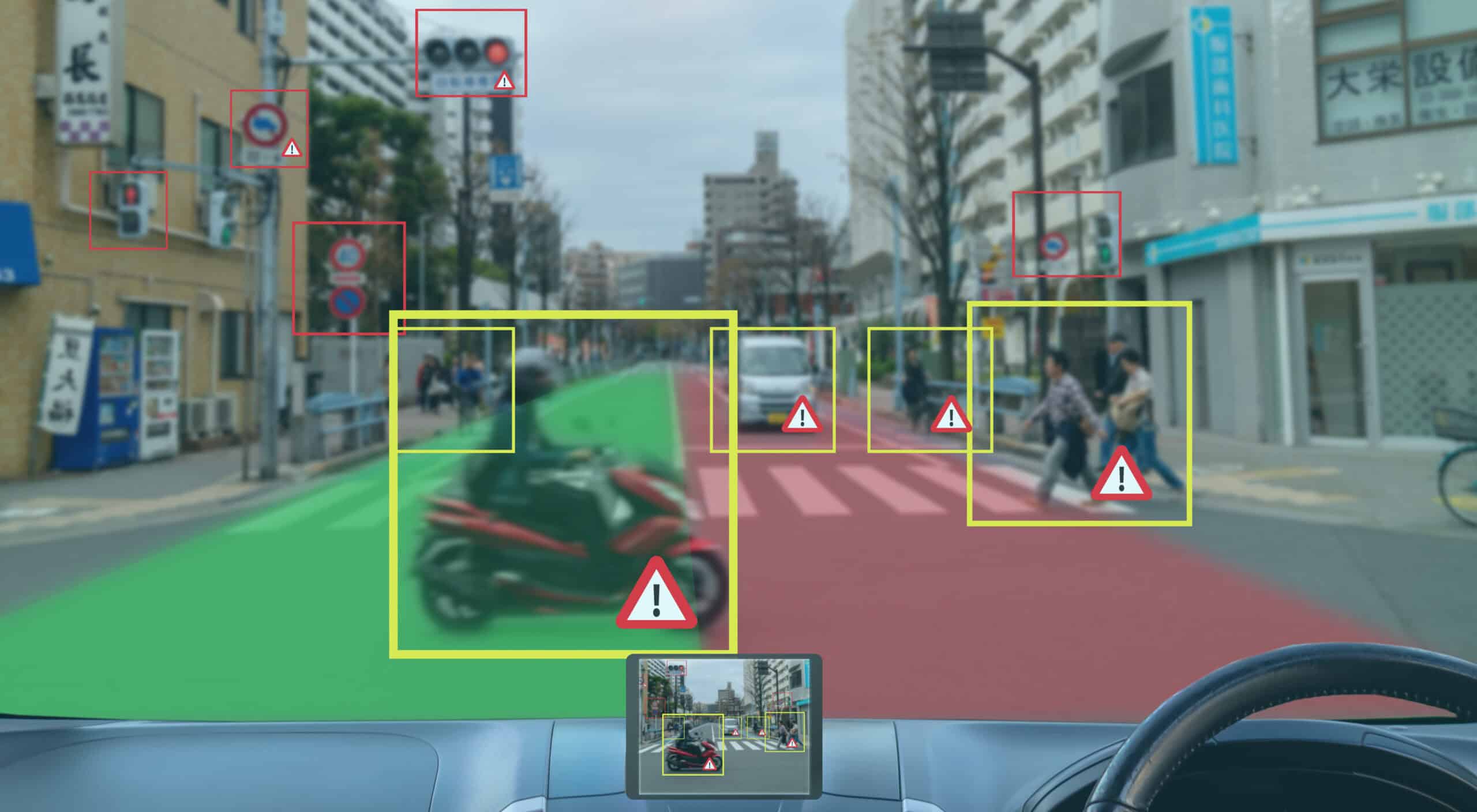

Hugging Faceが、わずか256Mパラメータで動作する超軽量ビジョン言語モデル「SmolVLM-256M」を含む新シリーズを発表した。従来の80Bパラメータモデルを300分の1のサイズに縮小しながら、より高い性能を実現。スマートフォンやノートPCでも実用的な処理が可能となり、AI視覚処理の実用化に向けた大きな一歩となる。

圧倒的な小型化で実現した革新的な性能

SmolVLM-256Mの革新性は、その徹底的な効率化と性能の両立にある。わずか1ギガバイト未満のGPUメモリで動作する世界最小のビジョン言語モデルでありながら、2023年8月にリリースされた同社の「Idefics 80B」を性能面で上回る結果を示している。Hugging Faceのmachine learning research engineerであるAndrés Marafiotiによれば、特に数学的視覚理解を評価するMathVistaベンチマークにおいて、80Bモデルと比較して10%以上のスコア向上を達成している。

モデルの処理性能も特筆に値する。バッチサイズ64での処理において、1秒あたり16例という高速な処理を実現。必要なRAMも15GBと、一般的なノートPCでも十分に動作可能なレベルに抑えられている。この効率性は、中規模企業のビジネスシーンにおいて重要な意味を持つ。例えば、月間100万枚の画像処理を行う企業の場合、従来モデルと比較して計算コストを劇的に削減できることが実証されている。

同時にリリースされたSmolVLM-500Mも注目に値する。このモデルは、より高い性能を求めるユーザーのために設計された「中間的な解決策」として位置づけられる。500Mパラメータという比較的小規模なサイズながら、DocVQAやMMMUなどの高度なタスクにおいて、より大規模なモデルに迫る性能を示している。特にプロンプトへの応答性が向上しており、実用環境での即時デプロイメントにより適している。

この性能と効率性の両立は、AIの実用化に向けた重要な転換点となる可能性を秘めている。特に注目すべきは、このモデルがWebGPU技術との互換性を持つ点だ。これにより、ブラウザベースでの実行という新たな可能性が開かれた。実際に、Hugging Faceはすでに両モデルのWebGPUデモを公開しており、インストールなしでの高度な視覚処理機能の提供が現実のものとなりつつある。

また、IBMによるDoclingプロジェクトでの採用は、このモデルの実用性を証明する重要な事例となっている。豊富な計算リソースを持つIBMが、敢えて小規模モデルを選択した背景には、大量の文書処理における効率性の追求がある。この選択は、必ずしもモデルの大規模化が最適解ではないという、AI開発における新たな方向性を示唆している。

技術的イノベーションの詳細

SmolVLMの革新性は、その徹底的な効率化アプローチにある。まず注目すべきは視覚エンコーダーの刷新だ。従来のVLMで標準的に使用されていたSigLIP 400M SOから、より軽量なSigLIP base patch-16/512への移行を実現した。このエンコーダーの変更により、パラメータ数を93Mまで削減しながら、性能の大幅な低下を防ぐことに成功している。さらに特筆すべきは、この小型エンコーダーが従来よりも高解像度での画像処理を可能にした点である。AppleとGoogleの最新の研究成果を取り入れることで、パラメータ数を増やすことなく、より鮮明な視覚理解を実現している。

トークン化処理においても大きな進展が見られる。新モデルでは1トークンあたり4,096ピクセルの処理が可能となり、2Bモデルの1,820ピクセルから大幅な効率化を達成した。また、文書構造を表現する特殊トークンの導入により、従来7トークンを要していた「」のような表現を単一トークンで表現することが可能となった。この最適化は「」までの表現に適用され、学習の安定性と結果の品質向上に大きく貢献している。

データセットの構成も精緻に設計されている。新モデルでは文書理解に41%、画像キャプション生成に14%の重みを置き、残りを視覚的推論やグラフ理解、一般的な指示への対応に割り当てている。特筆すべきは、既存のThe CauldronとDocmatixに加え、新たにMathWritingデータセットを追加したことだ。これにより、数学的表現の理解力が向上し、より広範な用途への対応が可能となった。

この一連の最適化により、SmolVLMは従来モデルの300分の1という劇的なサイズ削減を実現しながら、処理性能の向上も達成している。IBMのDoclingプロジェクトでの採用事例が示すように、この技術革新は理論上の成果にとどまらず、実用レベルでの価値を証明している。特に文書処理タスクにおいて、従来の大規模モデルに匹敵する性能を発揮しながら、必要な計算リソースを大幅に削減できる点は、産業応用における重要な利点となっている。

産業への影響と今後の展望

この革新的な小型化は、AI産業に大きな影響を与える可能性がある。IBMはすでにDocling向けに256Mモデルの採用を決定。企業の文書処理コストを大幅に削減できる可能性が示されている。

Marafiotiは「中規模企業が月間100万枚の画像を処理する場合、年間の計算コストを大幅に削減できる」と説明する。また、より安価なクラウドインスタンスでの展開が可能となり、インフラコストの削減にも貢献する。

さらに、WebGPUへの対応により、ブラウザベースでの実行も視野に入れている。これにより、インストールなしでAI視覚処理機能を提供する新しいサービスの登場も期待される。

Meta Description

Hugging Faceが世界最小のビジョン言語モデルSmolVLMをリリース。256Mパラメータで従来の80Bモデルを上回る性能を実現。スマートフォンでも動作可能な軽量設計で、AI視覚処理の実用化を加速。

コメント