AIスタートアップのAnthropicは、ユーザーがAIの「推論」時間を制御できる新しいAIモデル「Claude 3.7 Sonnet」を発表した。このモデルは、迅速な応答と人間のような深い思考を単一モデルで実現し、企業のAI活用における新たな選択肢を提示する。

「推論」機能を統合したハイブリッドAIモデル

Anthropicが発表したClaude 3.7 Sonnetは、AI業界初の「ハイブリッドAI推論モデル」だ。ユーザーは、質問の複雑さに応じて、AIが応答を生成する前に「考える」時間を調整できる。従来のAIモデルは、推論に特化したモデルと高速応答モデルが分かれていたが、「Claude 3.7 Sonnet」は単一のモデルで両方の機能を統合。これにより、ユーザーは用途に応じて最適な応答をシームレスに得られるようになる。

AnthropicのチーフプロダクトオフィサーであるMike Krieger氏はBloombergの取材に対し、「私たちが本当に目指しているのは、この機能を必要な場面でシームレスに利用できるようにし、必要のない場面では利用しないようにすることです」と述べている。

同モデルは有料プラン(Pro、Team、Enterprise)のユーザーに完全な機能が提供され、無料ユーザーには拡張思考モードなしの標準バージョンが提供される。価格は前モデルと同じく、入力100万トークンあたり3ドル、出力100万トークンあたり15ドルとなっている。

ユーザー体験の簡素化を目指す

Claude 3.7 Sonnetの開発は、AIのユーザー体験を簡素化するというAnthropicの目標を反映している。多くのAIチャットボットは、複数のモデルオプションを提供し、ユーザーに選択を強いる。しかし、Anthropicは、単一のモデルがすべてのタスクを処理できる理想的な状態を目指している。

Anthropicの製品・研究責任者であるDianne Penn氏は、「人間が即座に答えられる質問と、思考を必要とする質問に対して、2つの異なる脳を持っているわけではないのと同様に、私たちは推論を、別個のモデルで提供されるものではなく、フロンティアモデルが持つべき機能の1つとして捉えています」と説明する。

「Claude 3.7 Sonnet」の最大の特徴は、ユーザーがAIに思考時間を指示できる点にある。開発者はClaudeに最大128Kトークンまでの思考を許可でき、速度(およびコスト)と回答の質のトレードオフを調整できる。無料ユーザーを含むすべてのプランで利用可能であるが、無料プランでは拡張思考モードは初期状態では利用できない。

拡張思考モードを選択した場合、モデルは推論プロセスを「visible scratch pad(可視スクラッチパッド)」としてユーザーに提示する。これにより、ユーザーはAIがどのように答えにたどり着いたのかを理解し、誤りがあった場合に原因を特定しやすくなる。この設計は、OpenAIやxAI、DeepSeekも採用しており、AIの透明性向上への業界全体の傾向といえるだろう。

Anthropic社の共同創業者兼チーフサイエンスオフィサーであるJared Kaplan氏は、将来的にはAIが質問の複雑さを自動的に判断し、自動的に思考時間を調整する機能を実装することを目指す考えを示唆している。OpenAIのCEOであるSam Altman氏も同様の考えを示しており、AIのユーザーエクスペリエンス簡素化への関心が高まっている。

企業利用を意識した性能向上

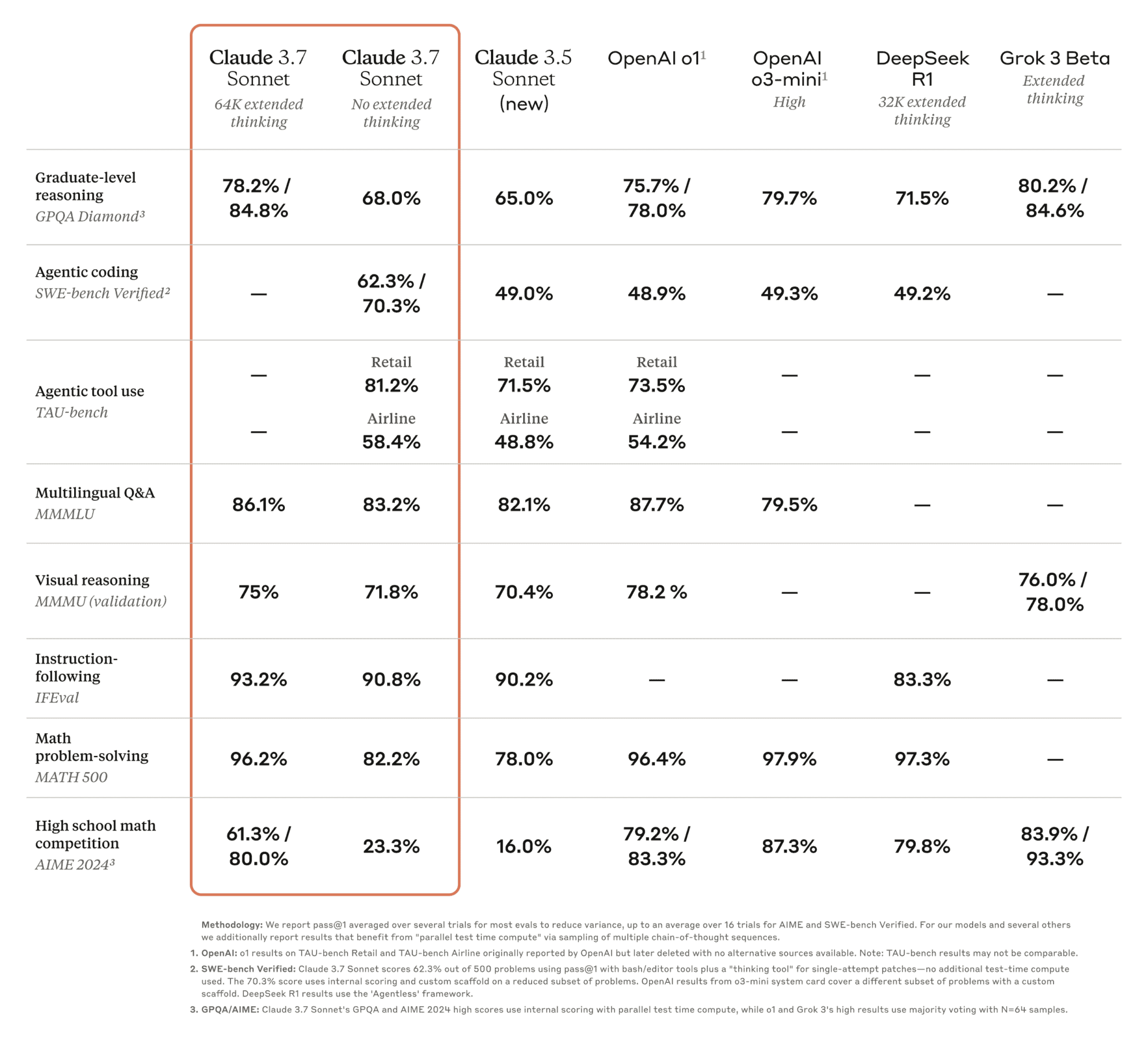

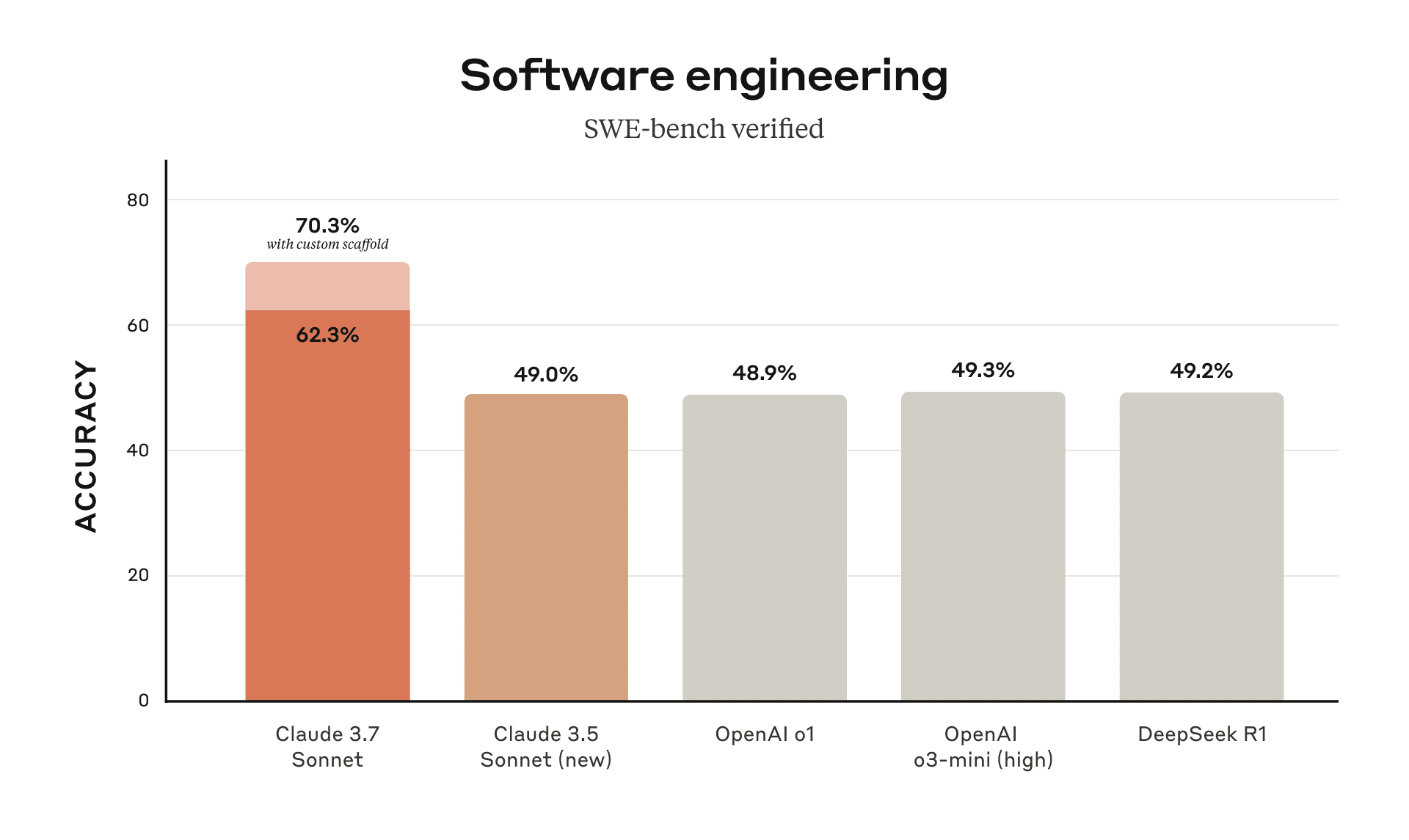

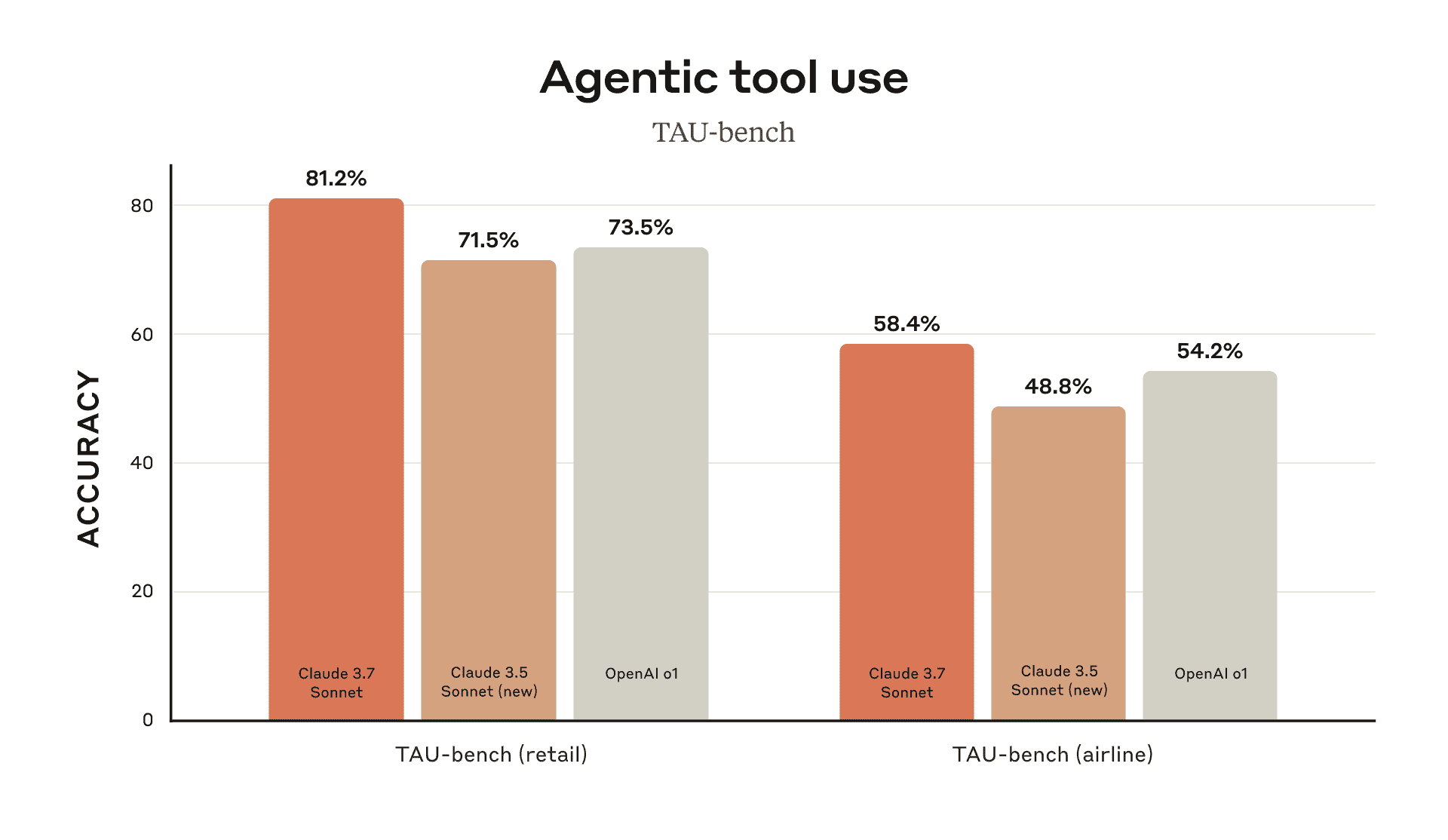

Anthropicは「Claude 3.7 Sonnet」を、特に企業での実用性を重視して開発したという。従来のベンチマークテストでは、数学やコンピュータサイエンスの競技問題に偏重する傾向があったが、「Claude 3.7 Sonnet」は、実際のビジネスシーンで頻繁に利用されるタスクでの性能に優先順位がおかれ、最適化されている。実際のコーディングタスクを測定するSWE-Benchでは62.3%の精度を示し、OpenAIのo3-miniの49.3%を上回った。また、小売環境でのAIモデルの能力を測定するTAU-Benchでは81.2%のスコアを達成し、OpenAIのo1モデルの73.5%を超えている。

初期テストでは、「Claude 3.7 Sonnet」はコーディング能力で優位性を示し、特に複雑なコードベースの処理や高度なツール利用において優れた結果を示している。Cursor、Cognition、Vercel、Replit、Canvaなど多くのパートナー企業がテストを実施し、複雑なコードベースの処理から高度なツール使用まで、幅広い分野で性能向上を確認したという。Cursor社は「実世界のコーディングタスクで再び最高のクラス」と評価し、Cognition社は「コード変更の計画とフルスタックアップデートの処理において、他のどのモデルよりもはるかに優れている」と評価している。Canva社の評価では、「Claude 3.7 Sonnet」は実用的なコードを継続的に生成し、設計センスとエラー削減において顕著な改善を見せている。

新しいコーディングエージェント「Claude Code」

同時に発表された「Claude Code」は、Anthropic初のエージェント型コーディングツールで、現在限定リサーチプレビューとして提供されている。このツールを使用することで、開発者はコードの検索・読み取り、ファイル編集、テスト作成・実行、GitHubへのコミット・プッシュなどの作業をターミナルから直接Claudeに委任できる。

TechCrunchのデモでは、「このプロジェクト構造を説明して」といった簡単なコマンドでコーディングプロジェクトを分析したり、平易な英語でコードベースを修正したりする様子が紹介された。Claude Codeは変更内容を説明しながら編集を行い、エラーのテストやGitHubリポジトリへのプッシュも実行できる。

Anthropicの製品・研究責任者であるDianne Penn氏は、「ユーザーはまだ変更を受け入れる必要があり、レビュアーとして関与します」と説明しており、完全自動化ではなく人間との協働を重視する姿勢を示している。

また、すべてのClaudeプランでGitHub統合機能が利用可能になり、開発者は自分のコードリポジトリを直接Claudeに接続できるようになった。

ポケモンでAIの進化を実証

Claude 3.7 Sonnetは「アクション・スケーリング」と呼ばれる改良された機能も備えており、関数を繰り返し呼び出し、環境の変化に対応し、オープンエンドのタスクを完了するまで継続することができる。例えば、ユーザーのコンピュータ画面を見て、マウスクリックやキーボード操作を行うことができる。

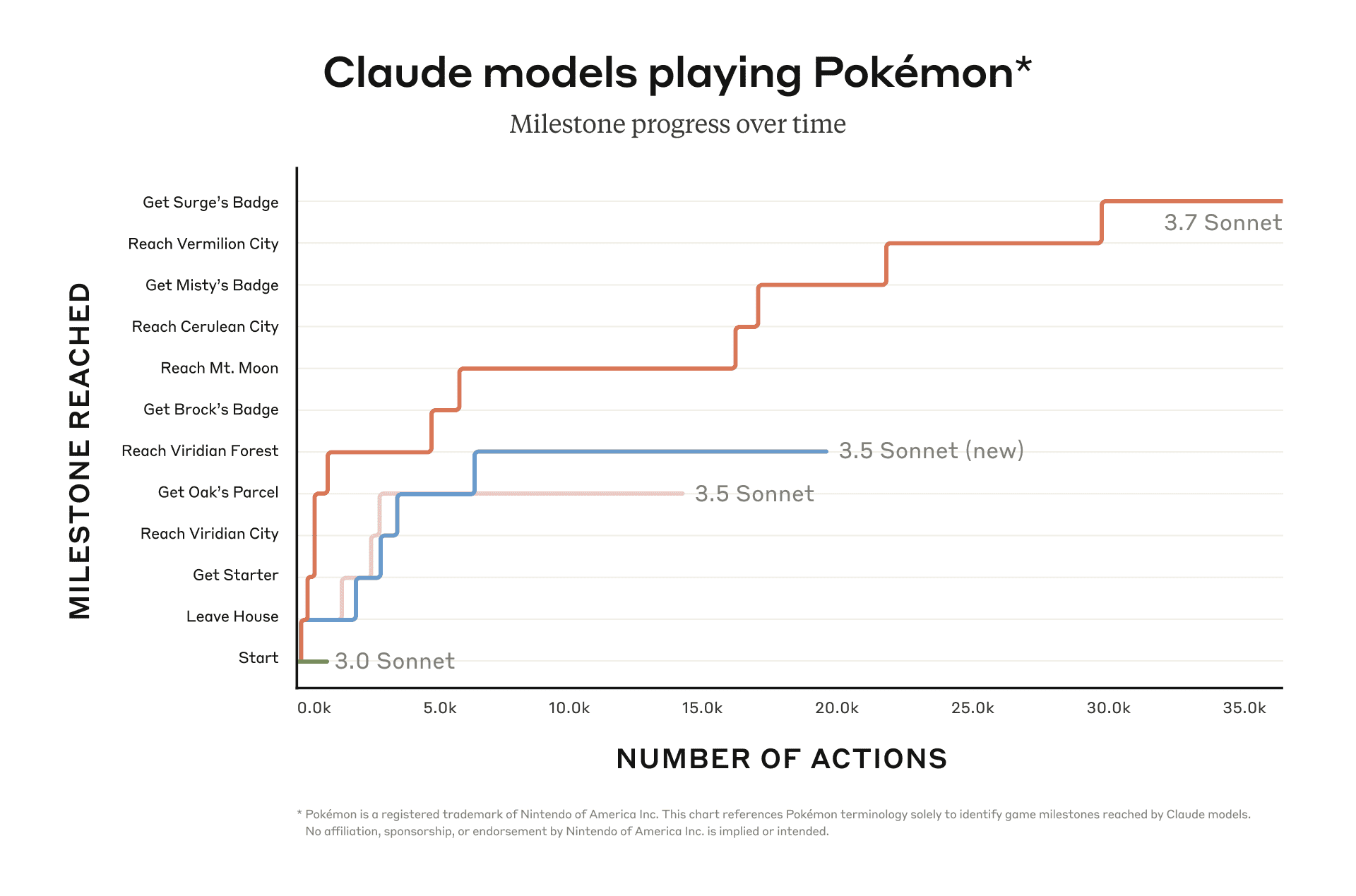

興味深いところでは、Anthropicが、Claude 3.7 Sonnetの能力を実証するために、ゲームボーイのクラシックゲーム『ポケットモンスター 赤』を使用したベンチマークテストを実施した点だろう。Claude 3.7 Sonnetは、基本的なメモリ、画面ピクセル入力、ボタンを押すための関数呼び出しを備え、ゲームを継続的にプレイすることができた。

以前のバージョンのClaude 3.0 Sonnetは、ストーリーが始まるパレットタウンの家から出ることができなかったが、Claude 3.7 Sonnetは、3人のジムリーダーと戦い、バッジを獲得することに成功した。最後のジムリーダーに到達するために35,000のアクションを実行したという。これは、AIの適応的な知性を示すものであり、企業が日常業務と複雑な戦略的意思決定の両方を処理できるAIを求めていることを示唆している。

安全性への配慮

Anthropicは同モデルの安全性も強化している。社内の評価チームによる広範なテストの結果、既存の「AI安全レベル2(ASL-2)」の基準が適切であると確認された。ただし、将来のモデルではより高いレベルの安全基準が必要になる可能性があるという。

特に気になる部分として、思考プロセスの可視化がジェイルブレイク(AIの制限を回避する手法)の開発に悪用される可能性が指摘されている。そのため、児童の安全性、サイバー攻撃、危険な武器などに関する潜在的に有害なコンテンツが思考プロセスに含まれる場合、該当部分は暗号化され、ユーザーには表示されないようになっている。

またコンピュータ操作機能に関しても、「プロンプトインジェクション攻撃」(悪意ある第三者がAIに見える場所に秘密のメッセージを隠す攻撃)に対する防御が強化され、防御率は74%から88%に向上している。

XenoSpectrum’s Take

Claude 3.7 Sonnetの登場は、AI推論モデルに関する哲学的アプローチの違いを浮き彫りにしている。Penn氏は、「これは私たちの哲学的な違いを表現する方法です」と述べ、「理想的には、モデル自体が問題がより集中的な思考を必要とするかどうかを認識し、ユーザーが明示的に異なる推論モードを選択する必要なく調整するべきです」と付け加えた。

先月、DeepSeekが米国のシステムと同等の能力を持つモデルを大幅に低いコストで発表し、NVIDIAの株価が17%下落するなど衝撃が走った。その中でAnthropicは、生のスピードやコスト削減ではなく、AI推論の正確な制御に賭けている。

OpenAIのCEOであるSam Altman氏も同様のアプローチを検討しており、「数ヶ月以内」に同社独自のハイブリッドAIモデルをリリースする可能性を示唆している。

企業にとっては、異なるタスクに複数の専門モデルを維持する必要がなくなり、単一のより高性能なソリューションを展開できる可能性がある。今後数ヶ月で、Anthropicのユニファイドなアプローチが企業市場を再形成するか、業界の急速な進化の中での実験に終わるかが明らかになるだろう。

Sources

コメント