WebブラウザのOperaは、大規模言語モデル(LLM)をローカルにダウンロードして使用できる新機能の追加を発表した。まずはテスト段階での導入のようで、デベロッパー・ストリーム・アップデートを受信しているOpera Oneユーザー向けに提供が開始されている。

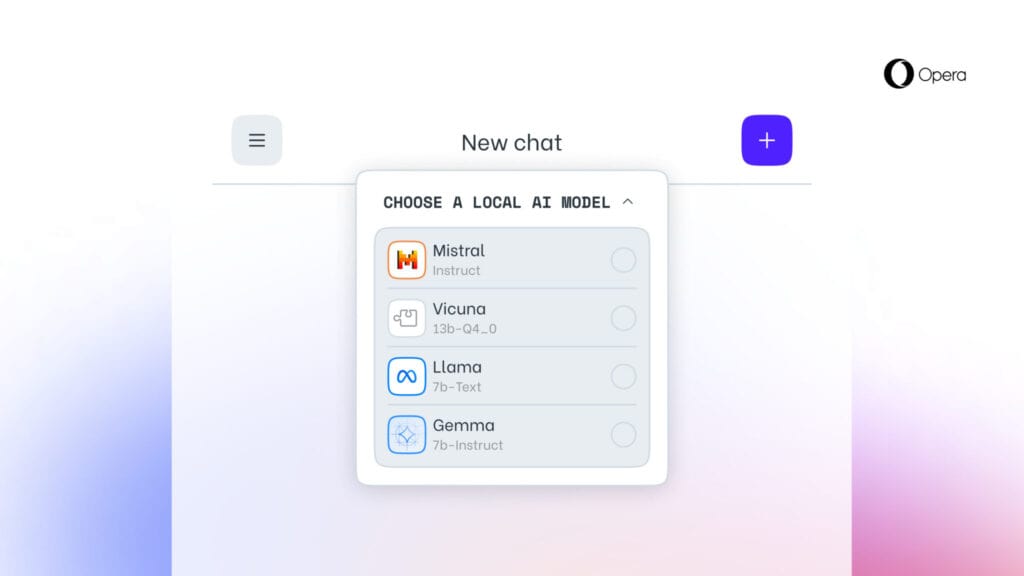

これにより、ユーザーはMetaのLlama、GoogleのGemma、Vicuna、Mistral AIなど、50以上のファミリーから150以上のモデルを選択できるようになる。

Operaのブラウザ・ゲーム担当EVPであるKrystian Kolondra氏は「このような形でローカルLLMを導入することで、Operaは急成長しているローカルAI分野で体験とノウハウを構築する方法を模索し始めることができます」と、プレスリリースで述べている。

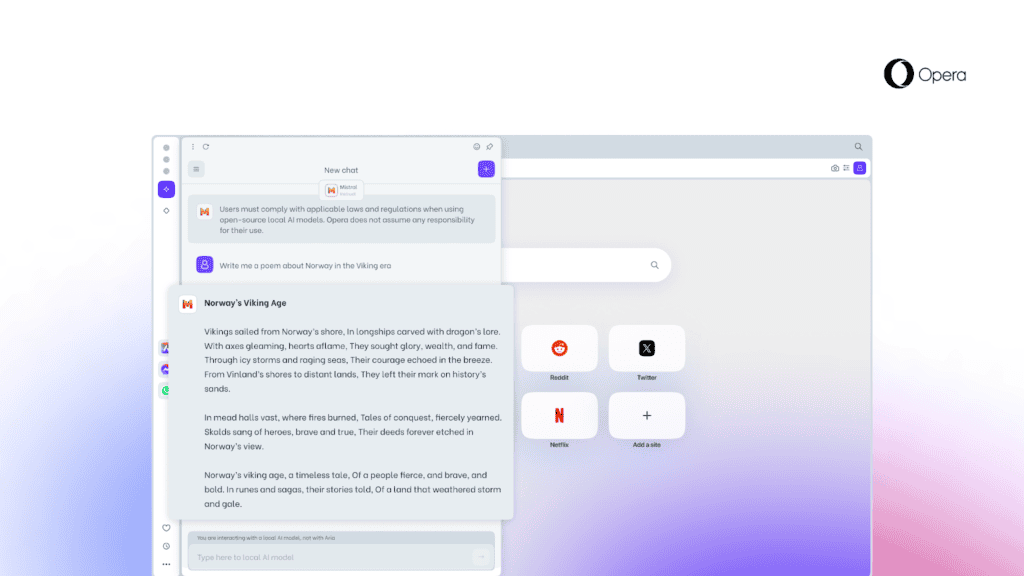

ローカルでLLMを利用する事の利点は、ユーザーデータがデバイス上にローカルに保持され、サーバーに情報を送信する必要なく生成AI機能を使用できる点にある。OperaはOperaのAI Feature Drops Programの一環としてこれを提供し、Ollamaオープンソース・フレームワークを利用し、ユーザーのコンピューター上でこれらのモデルを実行する。モデルの各バリエーションは、ローカルシステム上に2~10GBの容量を必要とする。現在、利用可能なモデルはすべてOllamaのライブラリのサブセットだが、将来的にはさまざまなソースからのモデルを含めることを検討している。

加えてOperaはまた、新しいローカルLLM機能の将来をイメージした潜在的な使用例を示唆している。「未来のブラウザが、あなたのデバイス上のすべてのデータを含みながら、あなたの過去の入力に基づいたAIソリューションに頼ることができるとしたらどうでしょう?」

ただし、実行速度はNVIDIAのH100などのハイエンドGPUを搭載した大型サーバーと比較すると、Operaによれば、「かなり遅く」なるだろうと述べている。

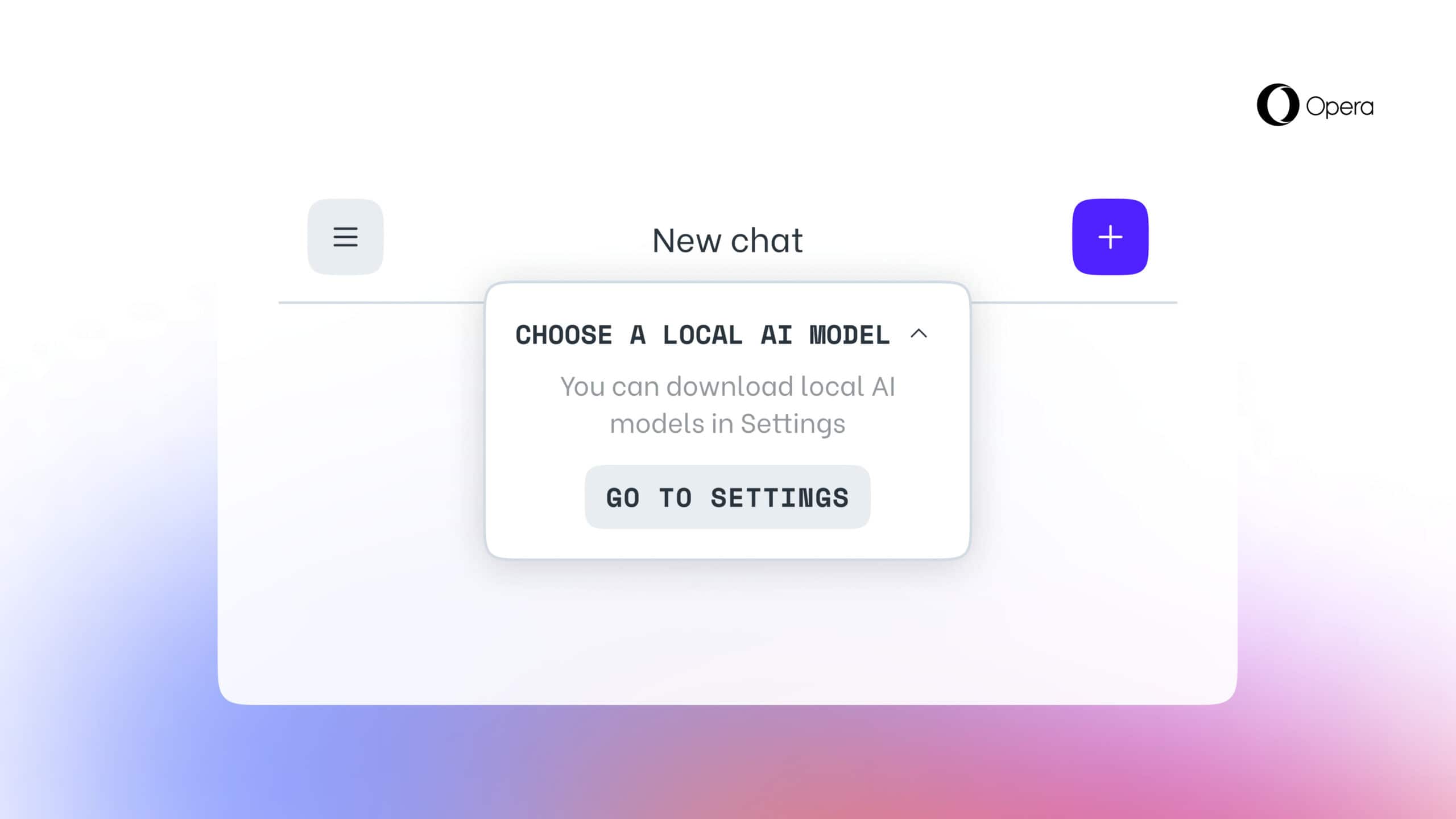

Operaのこの新機能にご興味のある方は、Opera One Developerの最新バージョンにアップグレードし、以下の手順に従ってローカルLLMをコンピュータ上で有効化しよう。

- Ariaチャットのサイドパネルを開く。

- チャットの上部に “ローカルモードを選択”というドロップダウンがある。

- “設定に移動 “をクリック。

- ここで、ダウンロードしたいモデルを検索し、参照することができる。

- ダウンロードが完了したら、左上のメニューボタンをクリックし、新しいチャットを開始する。

- チャットの上部に “ローカルモードを選択”というドロップダウンがある。

- ダウンロードしたモデルを選択する。

- チャットにプロンプトを入力し利用を開始する。

一度有効化されると、ユーザーがAriaとのチャットを開始するか、スイッチを入れ直すまで、ローカルLLMはOpera独自のAIアシスタントAriaの代わりにユーザーのマシンで利用される。

Source

コメント