中国のAI企業DeepSeekは、「Open Source Week」イベントの一環として、AI訓練と推論ワークロード向けに設計した高性能分散ファイルシステム「Fire-Flyer File System(略称:3FS)」をオープンソース化した。最新のSSDと高速ネットワーク技術を活用した3FSは、既存のファイルシステムの最大6倍の処理速度を実現し、AI開発の効率を劇的に向上させる可能性を秘めている。

3FSの技術的特徴と革新性

近年、AI技術の急速な発展に伴い、データ量と計算ニーズは増大の一途を辿っている。特にAIのトレーニングと推論のワークロードは、膨大なデータへの高速かつ並列的なアクセスをストレージシステムに要求する。従来のファイルシステムでは、高スループットなデータアクセスに対応しきれず、パフォーマンスのボトルネックとなることが課題だった。

DeepSeekが開発した「Fire-Flyer File System (3FS)」は、このような背景のもと、AIワークロードの要求を満たすために設計された分散ファイルシステムだ。最新のSSDとRDMAネットワークを活用し、分散アプリケーション開発を簡素化する共有ストレージ層を提供する。

分散アーキテクチャと高速データアクセス

Fire-Flyer File System(3FS)は、Linux向けの高性能分散ファイルシステムで、Linux FUSE(Filesystem in Userspace)技術をベースに開発されている。FUSEはカーネル空間ではなくユーザー空間でファイルシステムを実行できる仕組みだ。

3FSの最大の特徴は、その分散アーキテクチャにある。数千のSSDと数百のストレージノードのネットワーク帯域幅を組み合わせることで、アプリケーションはデータの物理的位置(データローカリティ)を気にすることなくストレージリソースにアクセスできる。従来のファイルシステムでは、データの物理的な場所に制約されることが多かったが、3FSはこの制約を取り除き、より柔軟で効率的なデータ処理を可能にしている。

データ一貫性とメタデータ管理

3FSは、「Chain Replication with Apportioned Queries(CRAQ)」と呼ばれる技術を実装することで、強力なデータ一貫性を維持している。多くの分散ファイルシステムが「結果整合性(eventual consistency)」に依存している中、CRAQによって高い同時実行性やノード障害が発生した場合でもデータの一貫性を確保できる。これによりアプリケーションコードがシンプルになり、システムの信頼性維持に役立つ。

メタデータ管理においても革新的なアプローチを採用しており、AppleのFoundationDBなどのトランザクションキーバリューストアによってバックアップされた「ステートレス」なメタデータサービスを開発している。メタデータ管理(ファイル名や属性などの情報管理)をストレージレイヤーから分離することで、システムはより拡張性が高くなり、メタデータ操作に関連する潜在的なボトルネックを減少させる。

技術的な実装面では、3FSはRustプログラミング言語を使用して開発されており、MITライセンスの下でGitHubにソースコードが公開されている。

AIワークロードのための最適化設計

ランダムリード重視のユニークな設計哲学

3FSの設計思想で最も特徴的なのは、AIトレーニングと推論の特性に合わせた最適化だ。特に、ランダムリード(任意のデータへの読み取りアクセス)速度を最優先し、読み取りキャッシュをほぼ無視するという設計判断が注目される。

AIモデルのトレーニング時には、計算ユニットが常に異なるランダムなトレーニングデータにアクセスする必要があり、データの読み取りは一度きりのプロセスであることが多い。そのため、通常のコンピューティングでは重要な読み取りキャッシュが、AIトレーニングではほぼ無用となる。さらに、同じデータを同じ順序で繰り返し読み取ることは、言語モデルのトレーニングにおいて潜在的に悪影響を及ぼす可能性もあるという。3FSではこの特性を理解し、キャッシュを大幅に削減する設計となっている。

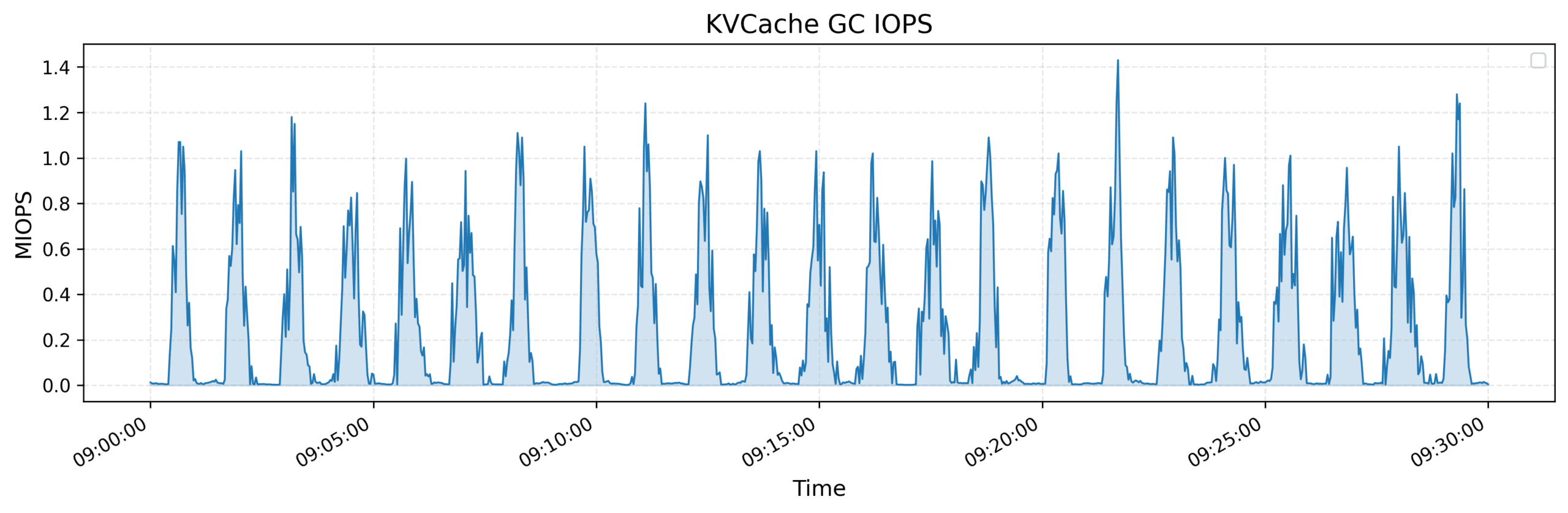

推論のためのKVCache技術

推論ワークロード(トレーニング済みモデルを使用して予測を行うプロセス)向けには、3FSは「KVCache」という革新的なキャッシング機構を提供している。従来のDRAM(メインメモリ)ベースのキャッシングは高価で容量も制限されるが、KVCacheはコスト効率の良い代替手段として、高いスループットとより大きなキャッシュ容量を提供する。

これは、大規模言語モデル(LLM)の推論時に、デコーダー層における過去のトークンのキーと値ベクトルをキャッシュすることで、冗長な計算を避ける技術だ。こうした最適化は、レイテンシ(応答時間)の削減が重要なAIシステムにとって大きな価値を持つ。

多様なAIワークロードへの対応

3FSは以下のような多様なAIワークロードに最適化されている:

- データ準備: データ分析パイプラインの出力を階層的なディレクトリ構造に整理し、大量の中間出力を効率的に管理

- データローダー: 計算ノード間でトレーニングサンプルへのランダムアクセスを可能にし、データセットのプリフェッチやシャッフルの必要性を排除

- チェックポインティング: 大規模トレーニング向けの高スループットの並列チェックポインティング(学習途中のモデル状態保存)をサポート

- 推論用KVCache: DRAMベースのキャッシングに代わるコスト効率の良い代替手段を提供

大きな性能と効率性の向上

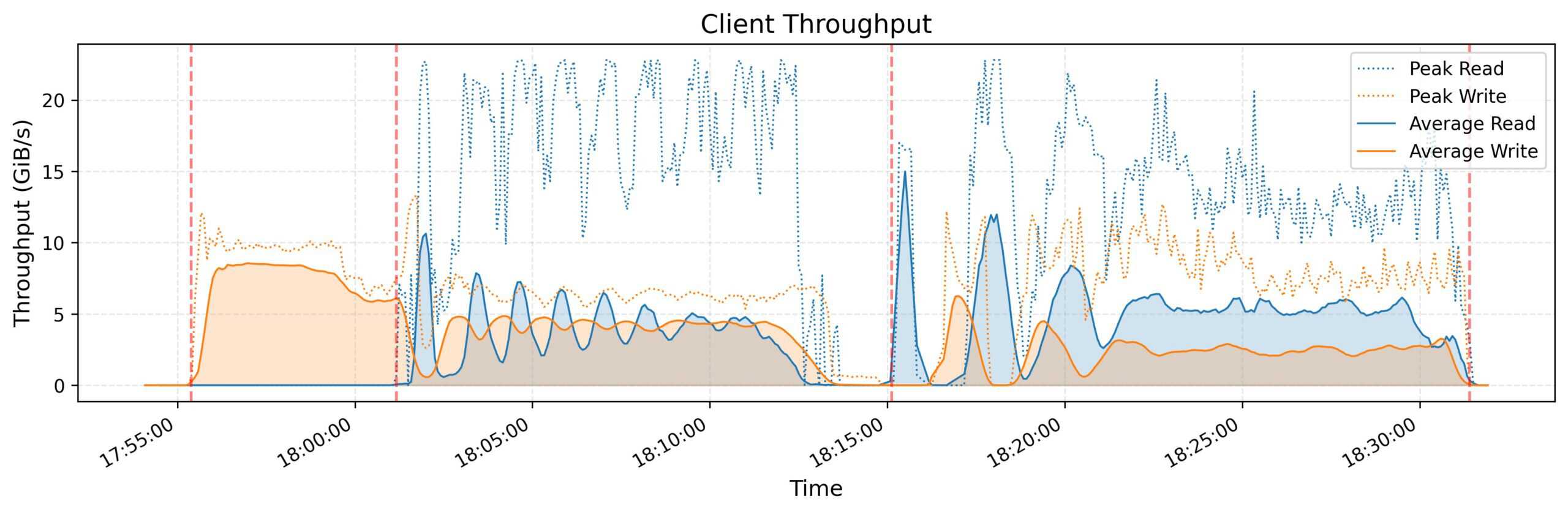

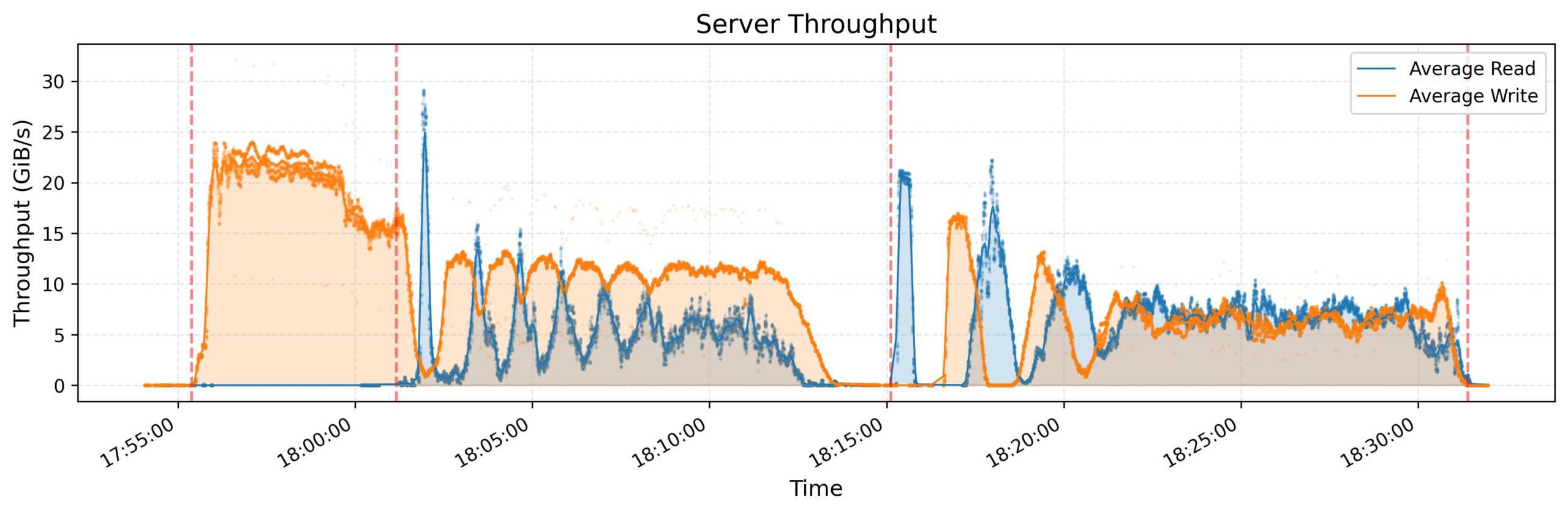

DeepSeek AIは、「3FS」の性能を評価するために、複数のベンチマークテストを実施している。

ベンチマーク結果

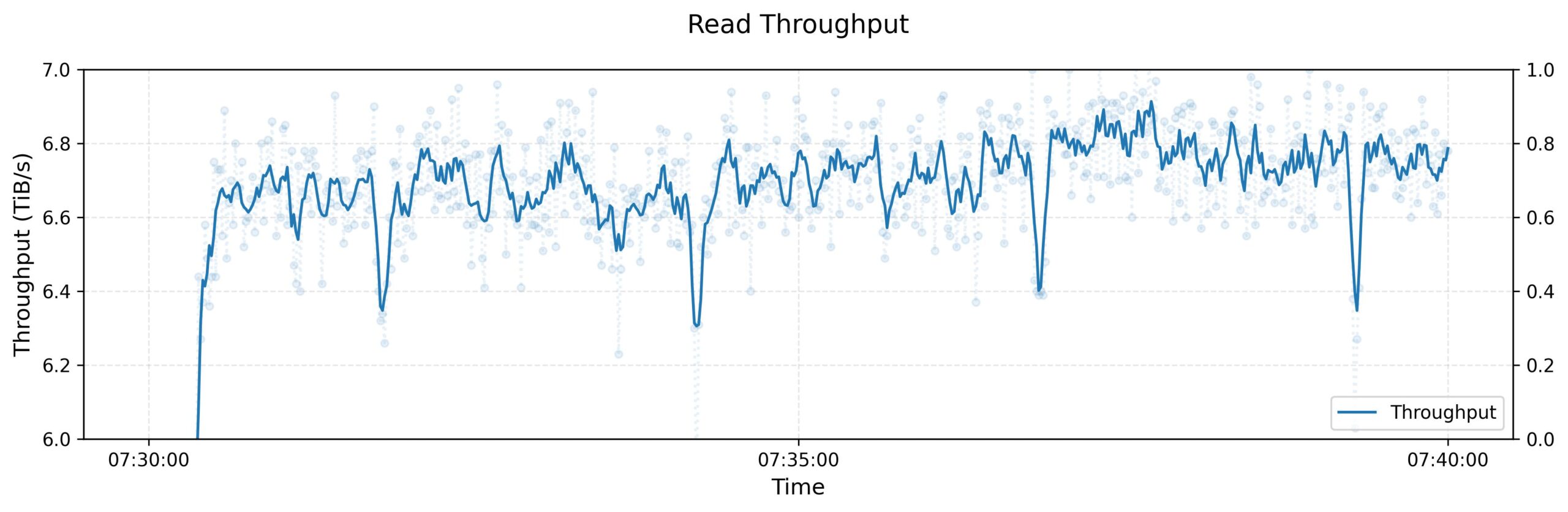

3FSの性能は複数の包括的なベンチマークテストで評価されている。DeepSeekの公式情報によれば、180のストレージノードで構成されるクラスターでのテストでは、トレーニング操作からのバックグラウンドトラフィックを処理しながらも、約6.6 TiB/秒の読み取りスループットを達成した。各ストレージノードは2×200GbpsのInfiniBand NICと16台の14TiB NVMe SSDを搭載している。

3FSの性能を競合製品と比較すると、その優位性が明確になる。競合ファイルシステムのCephは、2024年初めに68ノード(各ノードに10台の16TB SSDと2×100Gbpsネットワーキング)のサーバーで1.1 TB/秒の読み取りスループットを達成したが、3FSは競合製品の約6倍のパフォーマンスを発揮していることを示している。

GraySort性能とKVCache性能

大規模データソートのベンチマークテストであるGraySortでは、25ストレージノードと50計算ノードのクラスター上で、8,192パーティションに分散された110.5 TiBのデータを30分14秒でソートし、平均スループット3.66 TiB/分を実現した。これは、3FSが大規模データタスクを効率的に処理する能力の強力な指標となっている。

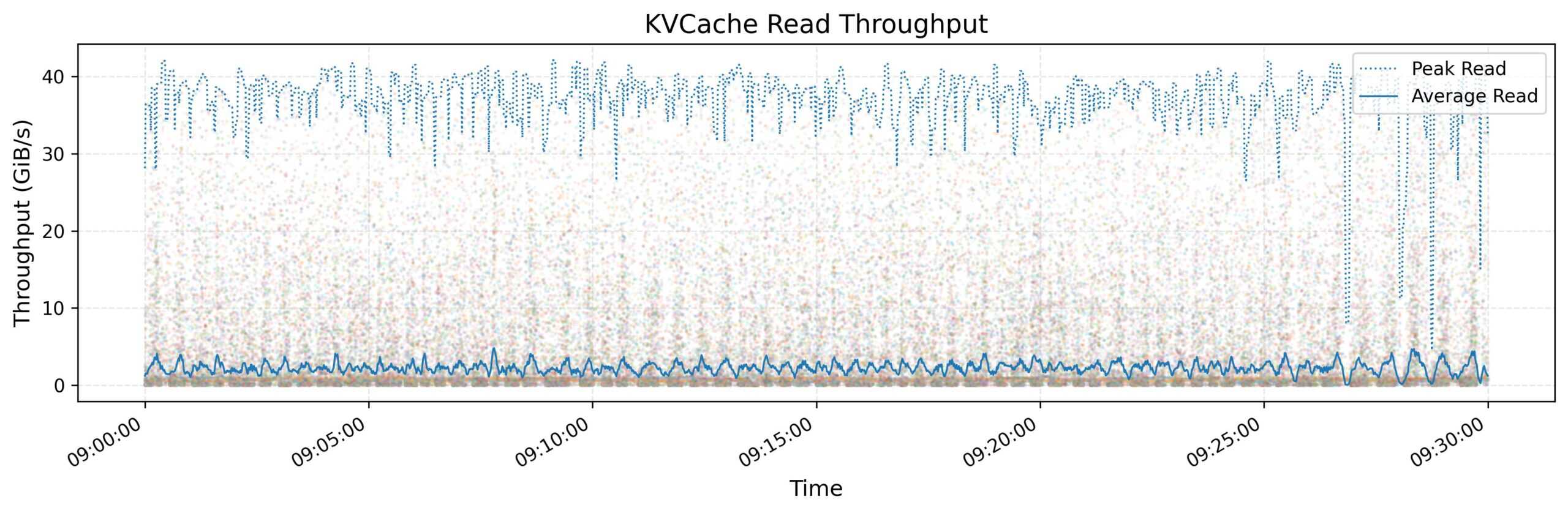

KVCache機能も顕著な性能向上を示した。推論テスト中、KVCacheは最大読み取りスループット40 GiB/秒に達した。システムは、ガベージコレクション(不要になったキャッシュデータの削除)の複雑さに対処しながらも、キャッシュメモリを動的に管理し、安定したパフォーマンスを維持した。

コスト効率とエネルギー効率

DeepSeekは独自のFireFlyer 2クラスターで3FSを利用し、NvidiaのDGX-A100サーバーソリューションと比較して、50%のコストと60%の電力消費で80%のパフォーマンスを達成したと報告されている。これは、特にコスト効率とエネルギー効率の面で大きな利点を示すものだ。

オープンソース化と今後の展望

DeepSeek AIは「Open Source Week」イベントの一環として、Fire-Flyer File System(3FS)を完全にオープンソース化した。中国のAI企業であるDeepSeekは、少なくとも2019年から自社のサーバークラスターで3FSを使用してきたとされる。

GitHubで完全にオープンソース化されたことで、エンジニアリングチームはNVIDIAのDGXシステムのような高価なハードウェアソリューションに頼ることなく、高性能なAIトレーニングインフラを構築できる可能性がある。

3FSの登場は、AI訓練と推論インフラにおける効率性とコスト効率を重視する現在のトレンドを反映している。オープンソースソリューションとしての提供は、AI研究と開発のさらなる民主化に貢献する可能性がある。

Sources

- GitHub: deepseek-ai/3FS

コメント