NVIDIAはBlackwellアーキテクチャを発表したばかりであり、これを採用した製品であるB200 GPUや、GB200スーパーチップと言った製品は今年後半に登場するが、同社の開発は加速しており、今回その更に先となる、次世代アーキテクチャが初めて明らかにされた。米国の天文学者Vera Rubin氏にちなんで名付けられたその名を「Rubin」と呼ぶ。

NVIDIAは毎年新たなAI製品をリリースする計画

Vera Rubinは、渦巻き銀河の観測からダークマターの理解に大きく貢献した先駆的な研究で知られる天文学者だ。既にその名を冠した天文台が建設中であり、2025年にも科学観測が開始される予定だ。これと前後してNVIDIAの次世代アーキテクチャ「Rubin」も同様に発表され、様々な場面でこの名を耳にする機会が増えそうだ。

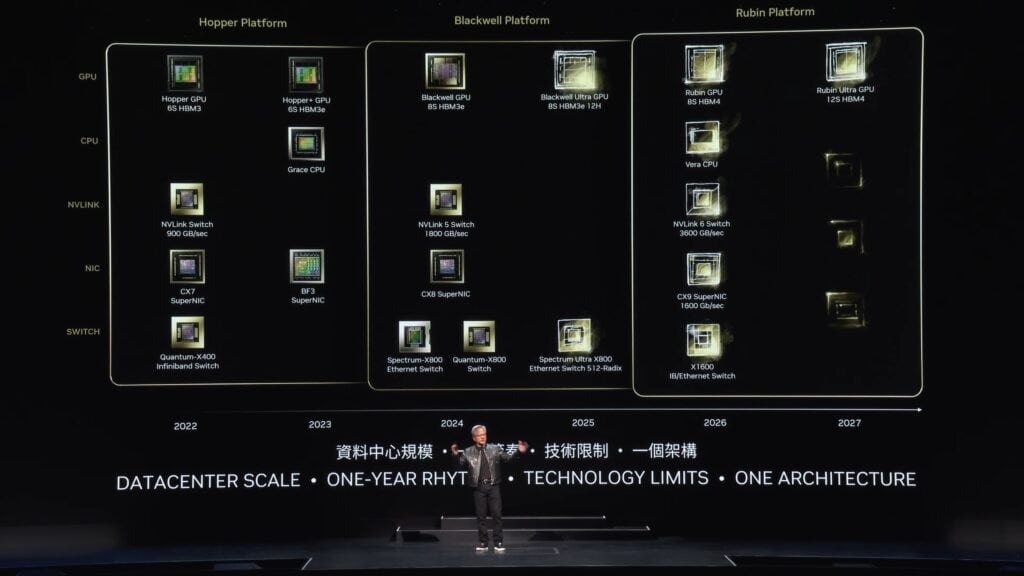

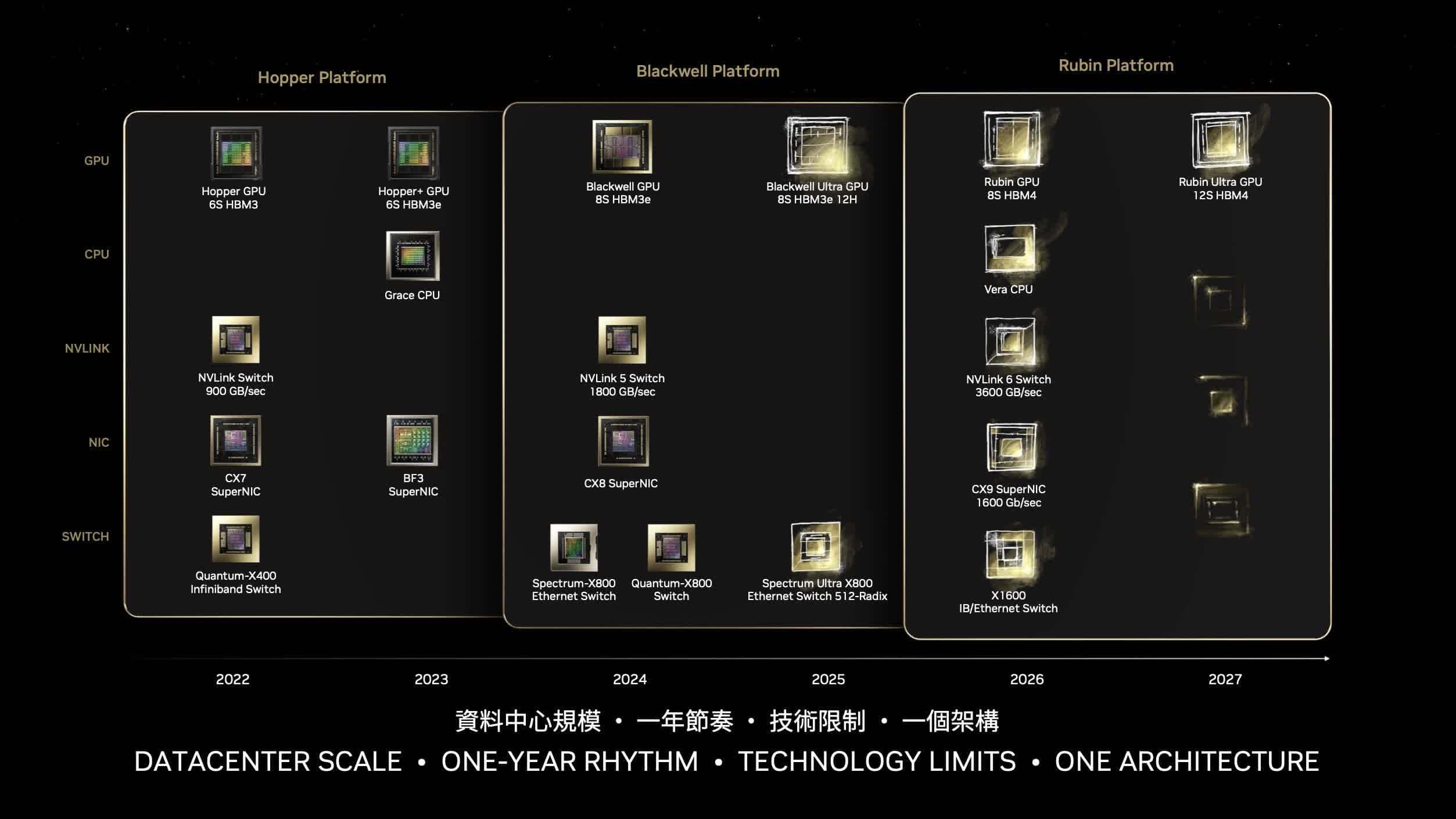

話を元に戻そう。NVIDIAはロードマップを加速させており、毎年新たなGPU製品を提供するとしている。台湾で開催されるComputex 2024年の基調講演にて、CEOのJensen Huang氏はその計画を明らかにした。

既に発表されているBlackwellについては、2024年末までにデータセンター向けに出荷が始まる予定だ。これが2024年。

そして2025年には既存製品の8サイトにわたる8Hiメモリスタックに対して、8サイトにわたる12HiメモリスタックのHBM3eを搭載した強化版「Blackwell Ultra」をリリースする計画だという。この変更により、メモリ容量は192GBから244GBに増加する。メモリ帯域幅は同じだ。

2026年にはBlackwellの後継となる「Rubin」プラットフォームが登場する。Rubinは新しいGPU、新しいArmベースCPU、NVLink 6、CX9 SuperNIC、X1600コンバージドInfiniBand/Ethernetスイッチによる先進的なネットワーキングを特徴としている。「R100」GPUをはじめとするラインナップは2025年第4四半期に量産が予定され、DGXやHGXと言ったデータセンター向け製品は2026年上半期の登場が計画されている。

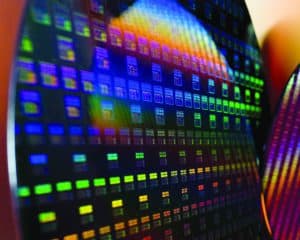

Rubinは、4xレチクルデザイン(Blackwellの3.3xに対して)を採用し、TSMCのCoWoS-Lパッケージ技術を用いてTSMCの3nmプロセス(恐らくN3P)で製造される予定だ。

TSMCは、2026年までに5.5xレチクルサイズのチップを可能にする計画を明らかにしており、100x100mmの基板を特徴とし、現在の80x80mmパッケージに対して最大12のHBMサイトを可能にする予定だ。

そして、Rubinに搭載されるメモリはHBM4となる。HBM4の量産は2025年にも開始されると見られており、このタイミングに合わせてR100 GPUも量産に入り、これらを組み合わせた製品のリリースがスムーズに行われるだろう。HBM4の供給は不明だが、Sk hynixとSamsungは2025年に次世代メモリソリューションの開発を開始し、最大16-Hiスタックに達する計画を発表している。

Rubin GPUは増大するAI処理の電力問題に対処することも念頭に置いて開発されている。NVIDIAは大幅な電力効率の改善を提供しつつ、AI処理能力の向上を果たすと述べている。

そして2027年にはRubinを強化した「Rubin Ultra」アーキテクチャの登場も計画されているようだ。

そしてもう一つの大きな発表が、現行のGrace CPUのアップグレードに関する計画だ。Hopperアーキテクチャと共に2023年に登場したGrace CPUは、Hopper、BlackwellとGPUの2つのアーキテクチャにまたがって組み合わされてきたが、これがRubin GPUの登場に合わせて刷新され、新たな「Vera」CPUが登場するようだ。これに伴い、Rubin GPUとVera CPUが組み合わされる「VR200」スーパーチップソリューションが登場する事になる。

Sources

コメント

コメント一覧 (1件)

素晴らしい分析、解説でごさいました!

見識の高さがとても伝わりますね!

机下