Amazonは、AI企業Anthropicとの提携のもと、数十万個のAI専用チップを搭載する大規模分散コンピューティングクラスター「Project Rainier」の構築計画を発表した。この画期的なプロジェクトは、従来の集中型アーキテクチャの限界を超え、次世代AIモデルの開発を加速させることを目指している。

革新的な分散アーキテクチャが実現する超大規模計算基盤

Project Rainierは、従来のAIトレーニング基盤の常識を覆す、画期的な分散アーキテクチャを採用している。これまでのAIモデルトレーニングでは、データ転送の遅延(レイテンシー)を最小限に抑えるため、単一施設内に演算リソースを集中配置することが不可欠とされてきた。この制約は、大規模なAIモデルの開発において、電力供給や熱対策という物理的な限界をもたらしていた。

しかし、AWSが開発した「Elastic Fabric Adapter」は、この技術的制約を突破する革新的なソリューションとなった。この技術の核心は、データ転送処理においてオペレーティングシステムを迂回する独自のアプローチにある。通常、サーバー間でデータを転送する際には、オペレーティングシステムによる複数の処理ステップが必要となり、これが遅延の主要な要因となっていた。Elastic Fabric Adapterは、オープンソースのネットワーキングフレームワーク「libfabric」を活用することで、これらの処理ステップを最適化し、施設間の高速なデータ転送を実現している。

この技術革新により、Project Rainierは地理的に分散した複数の施設を、あたかも単一の巨大なスーパーコンピュータのように機能させることが可能となった。この分散アーキテクチャは、単なる技術的な進歩を超えて、AIインフラストラクチャの新たなパラダイムを示唆している。施設の地理的分散により、電力供給や冷却などの物理的な制約を柔軟に解決できるだけでなく、災害などのリスクに対する耐性も向上する。

さらに、この分散システムはAIモデルのトレーニングに特化した最適化が施されている。科学シミュレーションなどの他の高性能計算とは異なり、AIモデルのトレーニングでは、大量のデータを規則的なパターンで処理する必要がある。Elastic Fabric Adapterは、このような特性を考慮した設計となっており、AIワークロードに特化した効率的なデータ転送を実現している。

自社開発チップ「Trainium2」が支える高性能計算

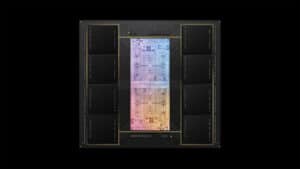

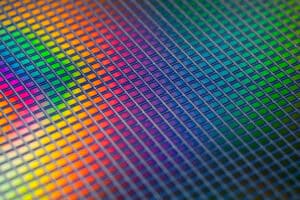

そして、Project Rainierの卓越した性能を支えているのが、AWSが独自開発したAI専用プロセッサ「Trainium2」だ。このチップの設計思想の核心は、AIモデルのトレーニングに特化した効率的な演算処理の実現にある。その中核となるのが「NeuronCore」と呼ばれる演算ユニットで、各Trainium2チップには8基のNeuronCoreが搭載されている。

各NeuronCoreは4つの計算モジュールで構成され、その中でも特に注目すべきなのが「GPSIMD」エンジンである。このエンジンは、AIモデルの学習で頻繁に使用されるカスタムAIオペレータに最適化されている。カスタムAIオペレータとは、機械学習チームが神経回路網の性能を向上させるために使用する、高度に専門化された低レベルのコード群のことを指す。この最適化により、一般的なGPUと比較して、AIトレーニングに特化した効率的な演算処理が可能となっている。

メモリシステムもTrainium2の重要な特徴である。各チップには96ギビバイトのHBM(High Bandwidth Memory)が搭載されており、これは通常のRAMと比較して格段に高速なメモリアクセスを実現する。特筆すべきは、HBMプールとNeuronCore間のデータ転送速度が2.8テラビット/秒に達する点だ。この高速なメモリアクセスは、大規模なAIモデルのトレーニングにおいて決定的な意味を持つ。なぜなら、AIモデルのトレーニングでは、大量のパラメータとトレーニングデータを絶えずメモリとプロセッサの間で移動させる必要があるためだ。

これらのTrainium2チップは、「Trn2 UltraServer」と呼ばれる専用設計のサーバーに64個ずつ搭載される。各UltraServerは、AI演算で一般的に使用されるFP8(8ビット浮動小数点)演算において、332ペタフロップスという驚異的な演算性能を実現する。これは現在Anthropicが使用しているシステムと比較して5倍以上の性能向上を意味する。

Trainium2の開発には、Anthropicとの緊密な技術協力関係が活かされている点も重要だ。Anthropicは最先端のAIモデル開発で培った知見を、チップの設計最適化にフィードバックしている。この協力関係により、理論上の性能だけでなく、実際のAIモデルトレーニングにおける実効性能の向上が図られている。

戦略的提携がもたらす相乗効果

AmazonとAnthropicの提携関係は、技術開発から事業戦略に至る包括的な協力体制として注目に値するものだ。Amazonによる80億ドルという巨額投資の背景には、次世代AI開発における明確な戦略的意図が見て取れる。

この提携の特筆すべき点は、両社の技術的な強みが相互補完的に機能する点にある。Anthropicは最先端のAIモデル開発で培った深い知見を持ち、特に「Claude」シリーズの開発を通じて、大規模言語モデルの設計と最適化に関する豊富な経験を有している。一方、AWSは世界最大のクラウドインフラストラクチャプロバイダーとして、大規模分散システムの構築・運用に関する比類ない専門性を持っている。

両社の協力関係は、AIチップの開発領域で特に顕著な成果を上げている。Anthropicのエンジニアリングチームは、実際のAIモデルトレーニングにおける経験に基づいて、Trainium2チップの設計最適化に貢献しており、実際のワークロードにおける効率性の向上につながっている。具体的には、AIモデルの学習過程で頻繁に使用される特定の演算パターンに対する最適化や、メモリアクセスパターンの効率化などが、この協力関係を通じて実現されている。

さらに、この提携は両社のビジネス戦略においても重要な意味を持つ。AWSにとって、Anthropicは最先端のAIモデル開発を通じてTrainium2チップの性能を最大限に引き出す「ショーケース的」な存在となる。一方、Anthropicにとっては、Project Rainierを通じて、次世代AIモデルの開発に必要な massive な計算リソースへのアクセスが保証される。これは、OpenAIとMicrosoftの関係に匹敵する戦略的な重要性を持つパートナーシップと言える。

また、この提携には長期的な技術革新の視点も含まれている。AWSの分散コンピューティング技術とAnthropicのAIモデル開発の知見を組み合わせることで、より効率的で拡張性の高いAIインフラストラクチャの実現を目指している。これは、将来的なAIモデルの大規模化に向けた重要な布石となっている。

この戦略的提携の影響は、AI業界全体にも波及する可能性がある。特に、NVIDIAのGPUに過度に依存しない、新たなAIインフラストラクチャのあり方を提示している点は注目に値する。Project Rainierを通じて実証される分散型アーキテクチャと自社開発チップの組み合わせは、AI開発のインフラストラクチャに関する新たなパラダイムを示唆している。これは、AI開発の民主化とインフラの多様化という観点からも、重要な意味を持つ発展と言えるだろう。

Sources

コメント