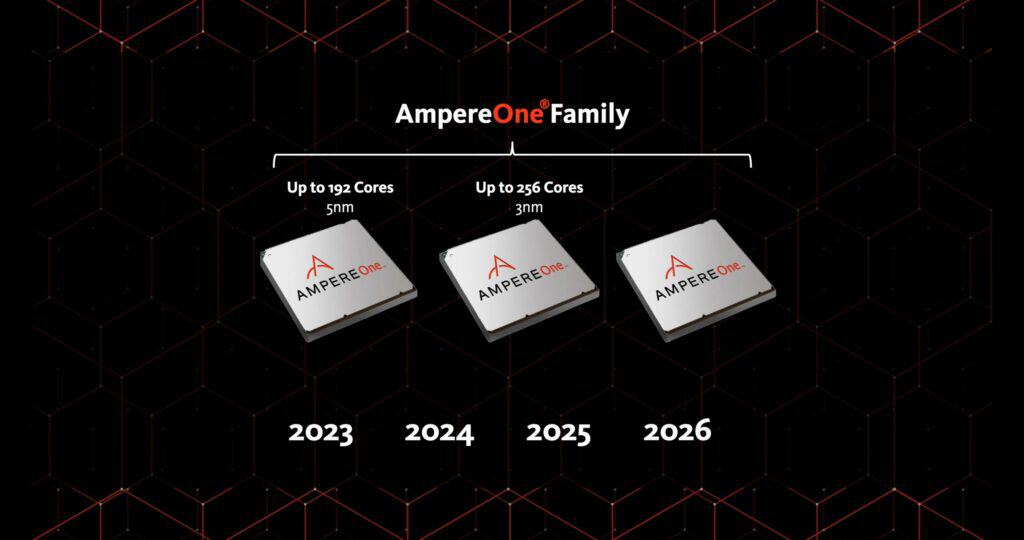

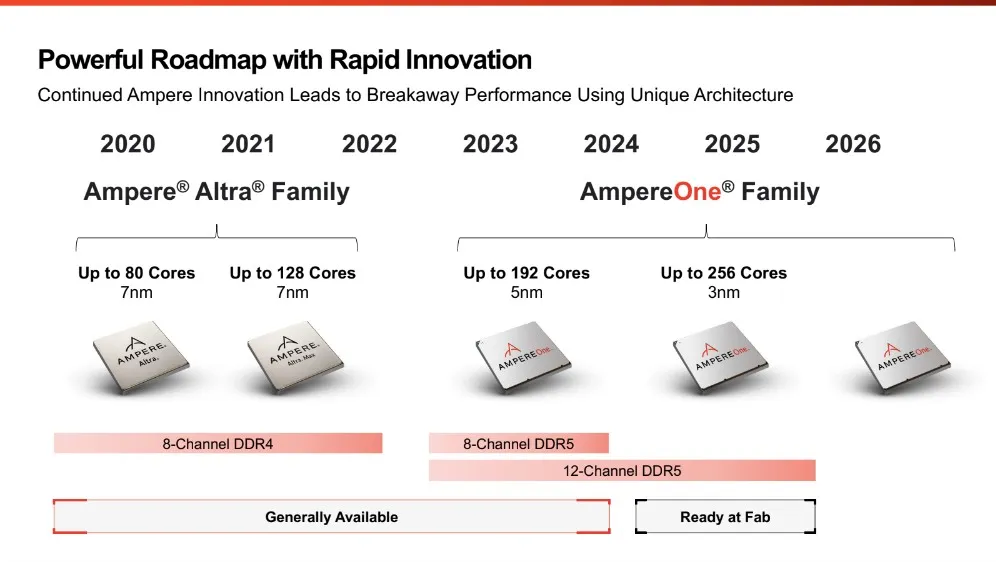

Ampere Computingは本日、新たなチップ開発のロードマップを公開し、来年にはTSMCの3nmプロセス技術で製造された全く新しい256コアの「AmpereOne」プロセッサを発売する予定であると発表した。加えて、AmpereはQualcommと提携し、同社のアクセラレーターを使用してAI推論サーバーを構築する予定である事も明らかにした。

256コアCPUの登場

AmpereOneは、クラウドネイティブワークロード、AI推論、データベース、ウェブサーバー、メディア配信向けに設計されたArm互換のチップだ。

既にAmpereは192コアのAmpereOneプロセッサの出荷を開始しており、昨年導入された8チャネルDDR5メモリサブシステムを備えている。今年後半には、12チャネルDDR5メモリサブシステムを備えた192コアのAmpereOne CPUを新しいプラットフォームで導入する予定だ。

これに伴い来年には新しいプラットフォームの導入が必要となり、来年の256コアバリアントへの移行の基盤を築くことになる。

Ampereによれば、この256コアチップはTSMCの最先端3nmプロセスノードで製造される予定とのことだ。新しいプロセッサが新しいマイクロアーキテクチャを採用するかどうかについては明らかにされていないが、各コアに2MBのL2キャッシュを引き続き搭載する見込みである。

「我々は新たに256コアの製品をファミリーに追加し、市場で最も高性能なCPUに対して40%の性能向上を実現します。コアの数だけでなく、プラットフォームで何ができるかが重要です。効率的な性能、メモリ、キャッシュ、およびAIコンピューティングを実現するための新しい機能をいくつか備えています」と、Ampere CEOのRenee James氏は述べている。

同社によれば、256コアCPUは既存製品と同じ冷却システムを使用するため、その熱設計電力は350ワット程度に留まる見込みだが、チップに詰め込まれたコアの数を考慮すると驚異的な成果だ。

AmpereOne CPUの採用は目覚ましいものである。Ampereは、AMDのGenoaと比較して50%、Bergamoと比較して15%のワット当たり性能の向上を主張している。したがって、データセンターが古いインフラを統合して刷新する際に、AmpereOneを導入すればラックあたり34%の性能向上が得られる計算となる。。

AIサーバーのためのQualcommとの提携

Ampereは多くの一般的なクラウドインスタンスに対応できる一方で、AIに関する能力は限定的である。同社によれば、128コアのAmpereOne CPUは各コアに2つの128ビットベクターユニットを搭載しており(INT8、INT16、FP16、およびBFloat16形式に対応)テストでは、Oracle Cloud上でAmpere CPUを使用してMetaのLlama 3言語モデルが実行された。興味深いことに、128コアのAmpere Altra CPUでLlama 3を専用GPUなしで実行した場合、NVIDIA A10 GPUとx86 CPUを組み合わせた場合と同等の性能を発揮し、消費電力は3分の1に抑えられているという。。しかし、AmpereがNVIDIAのA100、H100、またはB100/B200に対抗するためには、より優れたものが必要だ。

そこで、AmpereはQualcommと提携し、AmpereのCPUとQualcommのCloud AI 100 Ultraアクセラレーターに基づいたLLM推論プラットフォームを構築する計画を立てている。プラットフォームの準備がいつ整うかについては明らかにされていないが、Ampereの野望が一般的なコンピューティングにとどまらないことを示している。

Sources

コメント