大規模言語モデル(LLM)の性能向上を目指し、長年のライバルであるAppleとNVIDIAが異例の協力関係を築いている。Appleが開発した新しいテキスト生成手法「ReDrafter」をNVIDIAのGPU最適化フレームワークに統合することで、最大2.7倍の処理速度向上を達成した。

ReDrafterが実現する革新的な高速化技術

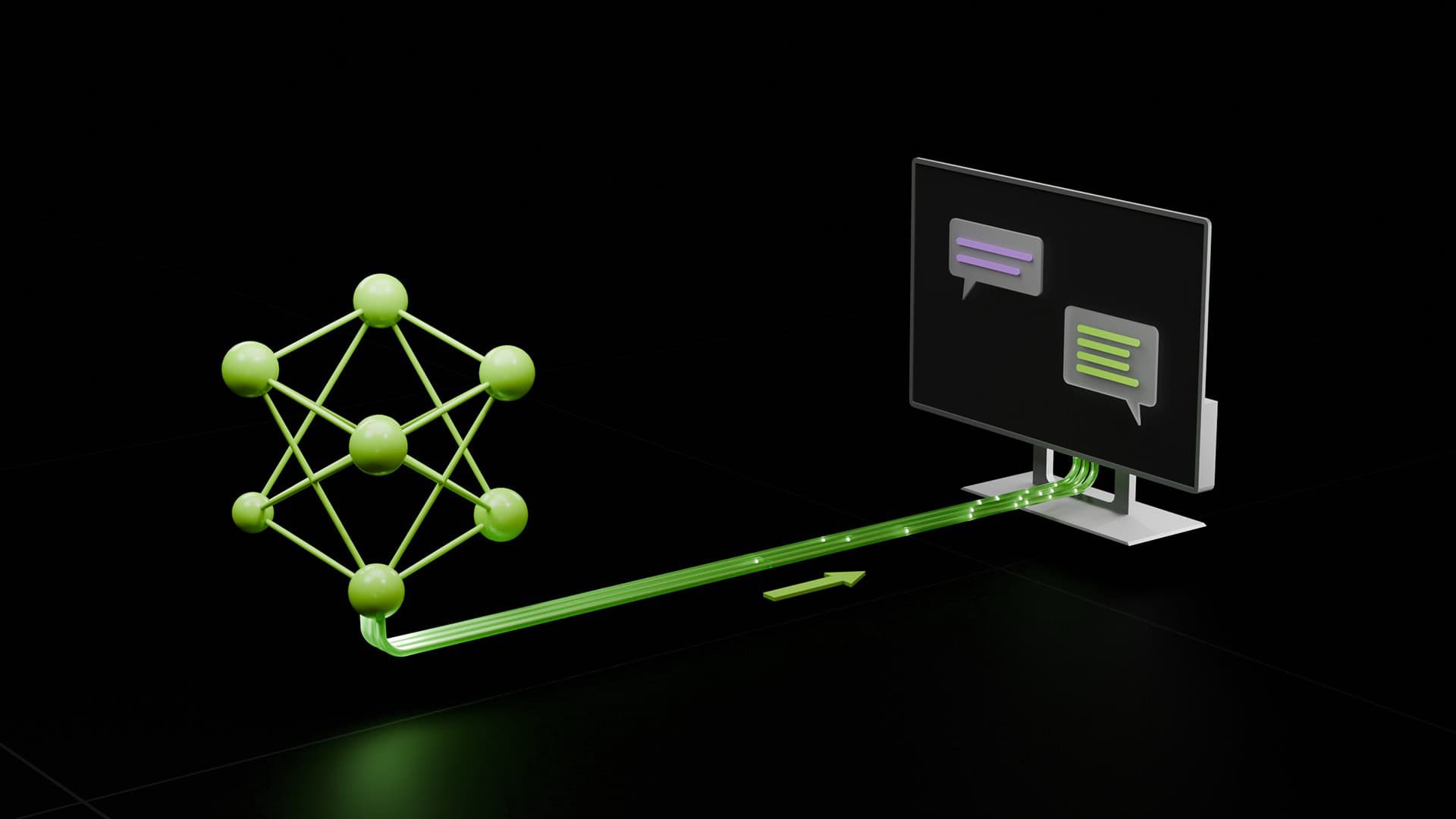

Appleが開発した「ReDrafter(Recurrent Drafter)」は、大規模言語モデル(LLM)における推論処理を根本から見直し、まったく新しいアプローチで高速化を実現した画期的な技術だ。その核心となるのは、「投機的デコーディング」と呼ばれる先進的な手法である。これは、モデルが次のトークン(単語や文字)を生成する際に、複数の可能性を同時に検討し、並列して処理を進めることを可能にする革新的なアプローチである。

この技術の特徴的な点は、小規模な「ドラフトモジュール」を活用して将来のトークンを予測し、それをメインモデルで検証するという二段階の処理方式にある。従来のモデルが一つずつトークンを生成していたのに対し、ReDrafterは複数のトークンを同時に予測し、その正確性を効率的に検証することができる。これは、ちょうど人間が文章を書く際に、まず下書きを作成し、その後推敲を重ねていく過程に似ている。

技術的な観点から見ると、ReDrafterは「ビーム探索」と「ツリーアテンション」という二つの重要な技術を組み合わせている。ビーム探索は複数の可能性のある文章の流れを同時に追跡し、最も適切な展開を選択する手法だ。一方、ツリーアテンションは、これらの複数の可能性を木構造として効率的に管理し、処理する手法である。この組み合わせにより、高い品質を維持しながら、処理速度を大幅に向上させることに成功している。

実際の性能向上は印象的だ。数百億のパラメータを持つ大規模な実用モデルでのベンチマークテストでは、従来手法と比較して2.7倍もの処理速度向上を達成している。しかも、この高速化は単なる速度向上だけでなく、GPU使用量の削減にも貢献している。これは、データセンターの電力消費削減という現代の重要課題に対する有効な解決策となる可能性を示している。

特筆すべきは、この技術がトラフィックの少ない状況で特に効果を発揮する点だ。従来のGPUリソースが十分に活用されていなかった低負荷時の性能を大幅に改善し、より効率的なリソース活用を実現している。これは、AIサービスの運用コスト削減に直接的に貢献する重要な進展といえる。

さらに、この技術はコード補完のような特定のタスクにおいて特に高い効果を発揮することが確認されている。これは、プログラミング支援ツールやコード生成AI等の実用的なアプリケーションにおいて、より快適なユーザー体験を提供できる可能性を示唆している。

技術統合におけるブレークスルー

ReDrafterをNVIDIA TensorRT-LLMに統合する過程では、複数の重要な技術的ブレークスルーが実現された。最も注目すべき進展は、推論エンジン内部での処理の一元化である。従来の手法では、トークンの検証やパス選択などの処理が実行時エンジンの外部で行われていたが、ReDrafterではこれらの処理をすべて単一エンジン内に統合することに成功した。これにより、処理のオーバーヘッドが大幅に削減され、より効率的な最適化が可能となった。

さらに、インフライトバッチング(IFB)と呼ばれる高度な並列処理技術との互換性も実現された。IFBは文脈処理フェーズとテキスト生成フェーズの要求を効果的にバッチ処理することで、スループットを向上させる技術である。ReDrafterはこれらの異なるフェーズの要求を適切に分離し、それぞれに最適化された計算パイプラインを通過させた後、再び単一のバッチとして統合する洗練された処理フローを実装している。

特筆すべきは、この統合過程でNVIDIAが実装した新しいオペレータ群の柔軟性である。これらのオペレータは空のテンソルにも対応できるよう設計されており、バッチ内のリクエストがすべて文脈処理フェーズもしくは生成フェーズのどちらかに偏っている場合でも、安定した処理を実現できる。この柔軟性により、将来的により複雑なモデルアーキテクチャにも対応できる拡張性の高い基盤が整備された。

また、Appleが開発したPyTorchによる実装を、ほぼ直接的にTensorRT-LLMに移植できるようになったことも重要な進展である。これは、研究段階のプロトタイプから本番環境での実装への移行を大幅に効率化し、新しい手法やモデルのより迅速な展開を可能にしている。この実装の容易さは、オープンソースコミュニティによる技術の発展にも大きく貢献することが期待される。

これらの技術的ブレークスルーは、単にReDrafterの実装を可能にしただけでなく、TensorRT-LLM全体の機能を拡張し、より高度なモデルやデコード手法にも対応できる基盤を確立した。これは、大規模言語モデルの実用化における重要なマイルストーンといえる。

Sources

コメント