Googleは、同社が「推論の時代」と呼ぶ新たなフェーズに向けた最新AIアクセラレータ「Ironwood」を発表した。第7世代となるこのTensor Processing Unit (TPU)は、Google史上初めて推論処理に特化して設計されており、AIが自律的に思考し行動する能力を飛躍的に高めることを目指した野心的な物となっている。

推論特化の新世代TPU「Ironwood」登場:AIは「考える」フェーズへ

Google Cloud Next ’25の場で発表された「Ironwood」は、単なる性能向上に留まらない、GoogleのAI戦略における重要な転換点を示すチップである。これまでGoogleのTPUは、AIモデルの学習(トレーニング)と実行(推論)の両方を担ってきた。しかし、Ironwoodは明確に「推論」に焦点を当てて設計されている。これは、AI技術が新たな段階に入ったことの現れと言えるだろう。

Googleが提唱する「推論の時代」とは、AIが単にユーザーの指示に応答するだけでなく、自ら能動的に情報を収集・分析し、洞察を生成して提案するような、より高度な役割を担う未来を指す。いわば、AIが「考える」ことを始め、人間と協働するエージェントとして機能する時代だ。こうした「AIエージェント」や、複雑な問題解決を行う「思考するモデル(thinking models)」、例えば大規模言語モデル(LLM)や混合エキスパートモデル(MoE)は、膨大な計算能力と効率的なデータ処理能力を必要とする。Ironwoodは、まさにこうした次世代AIの要求に応えるために開発された。

なぜ今、推論特化なのか?その背景には、AIの利用形態の変化と経済性の問題がある。AIモデルのトレーニングには依然として莫大な計算資源が必要だが、それは基本的に一度きりのプロセスだ。一方、学習済みモデルを使った推論は、検索、翻訳、画像生成、対話AIなど、日常的なサービスの中で日々何十億回、何兆回と繰り返される。AIが社会に浸透すればするほど、推論処理の効率とコストが極めて重要になる。Googleによれば、AIコンピューティングへの需要は過去8年間で年率10倍、累計で1億倍にも達しているという。ムーアの法則だけでは追いつけないこの爆発的な需要増に応えるには、Ironwoodのような特化型アーキテクチャが不可欠となるのだ。

驚異的なスペック:性能、メモリ、効率性の詳細

Ironwoodの技術仕様が、Googleの本気度を物語っている。

1. 圧倒的な計算能力:

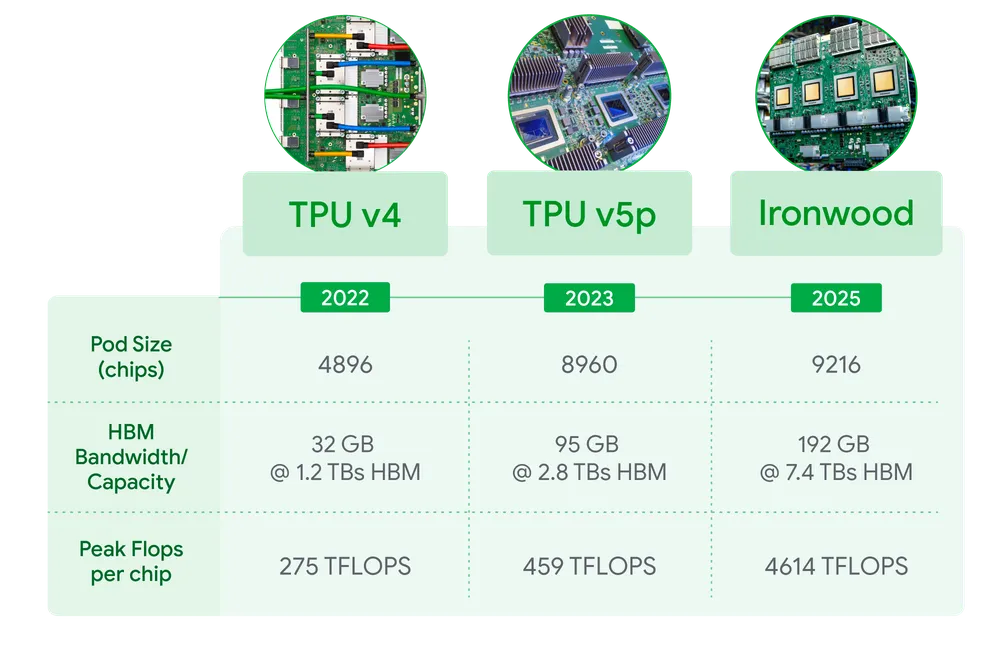

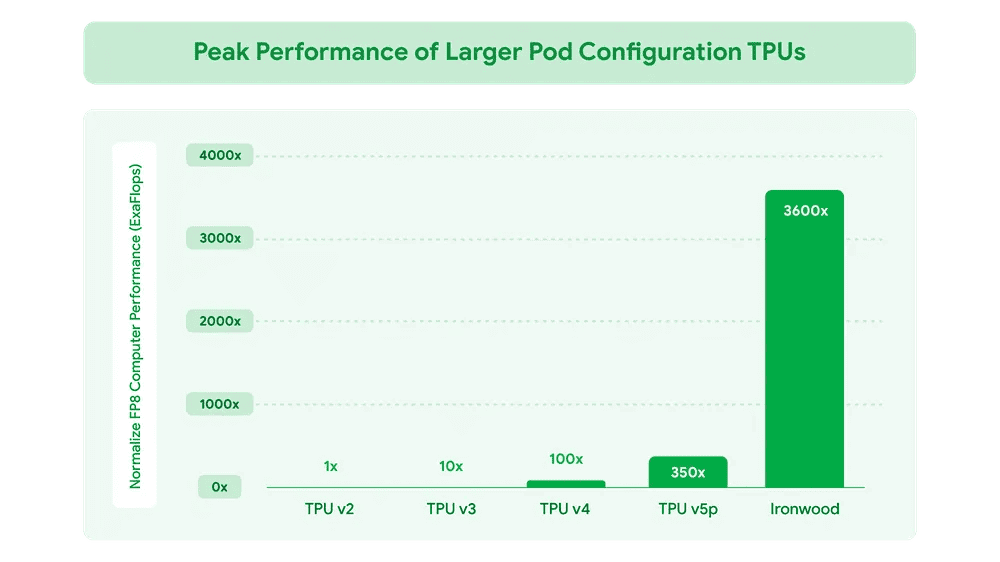

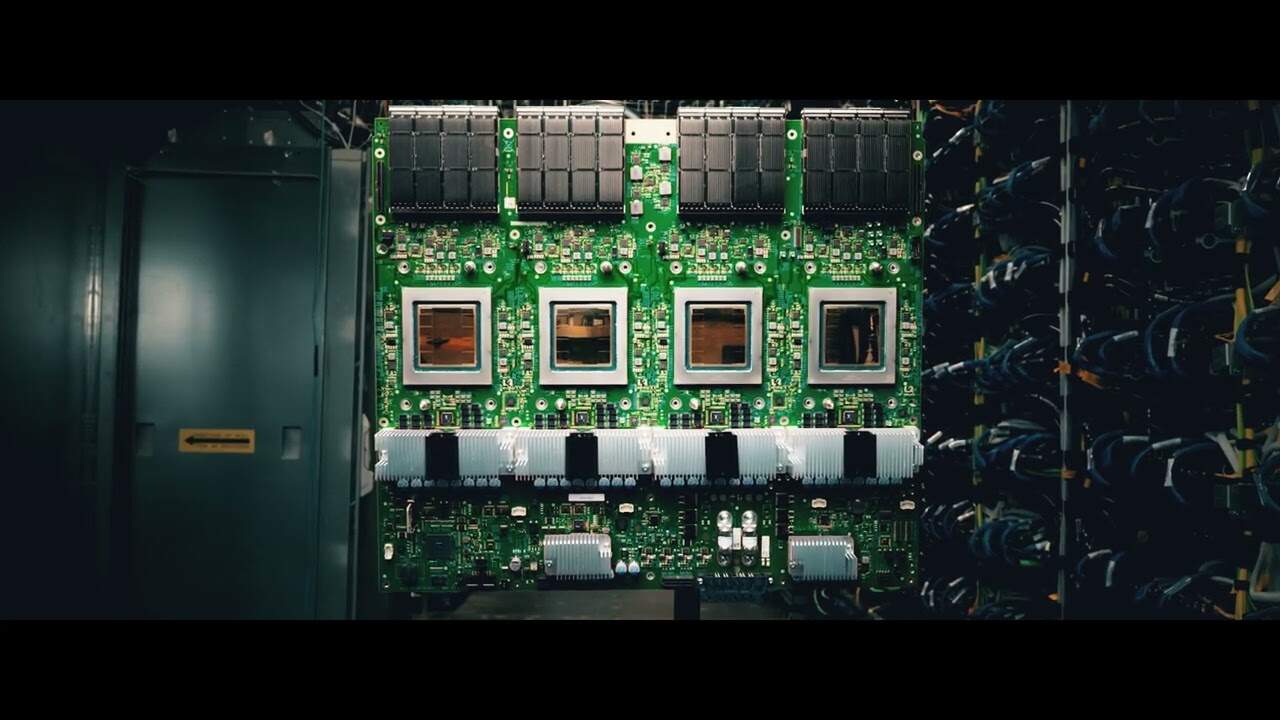

各Ironwoodチップは、ピーク時で4,614 TFLOPS(テラフロップス)の計算能力を発揮する。これは、1秒間に4,614兆回の浮動小数点演算が可能であることを意味する。さらに、Googleはこのチップを液冷システムと組み合わせ、最大9,216個を相互接続した巨大な「ポッド」として構成できる。この最大構成では、実に42.5 Exaflops(エクサフロップス、1秒間に4京2500兆回の演算)という驚異的な推論性能を実現する。

Googleはこの性能を、現在世界最速とされるスーパーコンピュータ「El Capitan」(ピーク性能1.7 Exaflops)の24倍以上だと主張している。ただし、この比較には注意が必要だ。GoogleがIronwoodの性能指標としているのはFP8(8ビット浮動小数点演算)精度であるのに対し、El Capitanのような伝統的なスパコンの性能は通常FP64(64ビット倍精度浮動小数点演算)で計測される。FP8はAIの推論処理には適しているが、FP64は科学技術計算などで要求されるより高い精度を持つ。演算精度が異なるため、単純に24倍という数字を鵜呑みにすることはできない。Google自身も比較表から前世代TPU(Trillium)を除外するなど、ベンチマークの解釈には慎重さが求められる。とはいえ、Ironwoodが推論処理において極めて高い計算能力を持つことは間違いないだろう。

2. 大容量・高速メモリ:

現代のAIモデル、特にLLMは巨大なパラメータ(モデルを構成する数値)を持っており、これを効率的に処理するには大容量かつ高速なメモリが不可欠だ。Ironwoodはこの点でも大きな進化を遂げている。各チップには192GBのHBM(High Bandwidth Memory、広帯域幅メモリ)が搭載されている。これは前世代のTrillium TPUと比較して6倍の容量であり、より大規模なモデルやデータをチップ上に保持できるため、外部メモリとのデータ転送頻度を減らし、処理速度を向上させる。

さらに、メモリ帯域幅(単位時間あたりに転送できるデータ量)も7.2 Tbps(テラビット/秒)に達し、Trilliumの4.5倍を実現。これにより、膨大なデータへの迅速なアクセスが可能となり、メモリへの依存度が高いAIワークロードのボトルネック解消に貢献する。

3. 強化されたチップ間接続:

9,216チップもの大規模構成で効率的に協調動作するためには、チップ間の高速な通信が欠かせない。Ironwoodでは、チップ間を直接接続するICI(Inter-Chip Interconnect)の帯域幅が1.2 Tbps(双方向)に強化された。これはTrilliumの1.5倍にあたり、大規模な並列処理におけるデータ交換を高速化し、遅延を最小限に抑える。

4. 劇的な電力効率の向上:

AIの計算能力が向上する一方で、その消費電力と運用コスト、環境負荷は大きな課題となっている。Ironwoodは、性能向上だけでなく電力効率の改善にも注力している点が特筆される。Googleによると、IronwoodはTrilliumと比較してワットあたりの性能(電力効率)が2倍に向上。さらに、2018年に発表された初代Cloud TPUと比較すると、実に約30倍もの電力効率改善を果たしたという。これは、電力供給が限られるデータセンターにおいて、より多くのAI処理能力を低コストで提供できることを意味し、AIの持続可能な発展にとって重要な要素となる。

5. 特定用途向けの最適化:

Ironwoodは、汎用的なAI処理だけでなく、特定のワークロードに最適化された機能も持つ。強化された「SparseCore」は、レコメンデーションシステムや検索ランキングなどで用いられる巨大な埋め込み(データをベクトル表現したもの)を効率的に処理するための専用アクセラレータだ。これにより、従来のAI領域だけでなく、金融モデリングや科学技術計算といった分野への応用も期待される。

GoogleのAI戦略とIronwoodの位置づけ:垂直統合と推論シフト

Ironwoodの登場は、Googleが長年培ってきたAIインフラ戦略の集大成であり、今後の方向性を示すものである。

1. AI Hypercomputer構想の中核:

Ironwoodは、Google Cloudが提供する統合スーパーコンピューティングプラットフォーム「AI Hypercomputer」の重要な構成要素となる。AI Hypercomputerは、TPUやGPUといったハードウェアだけでなく、ネットワーキング、ストレージ、そしてPathwaysのようなソフトウェアスタックまでを最適に組み合わせ、最も要求の厳しいAIワークロードに対応することを目指している。Ironwoodはこのエコシステムにシームレスに統合され、その性能を最大限に引き出すことが可能になる。

2. Pathwaysによる超大規模スケーリング:

Google DeepMindが開発した機械学習ランタイム「Pathways」は、複数のTPUチップにまたがる分散コンピューティングを効率化するソフトウェアだ。Google Cloud上でPathwaysを利用することで、単一のIronwoodポッド(9,216チップ)を超え、数万、さらには数十万ものIronwoodチップを連携させて、生成AIの計算限界を押し広げることが可能になるという。

3. 「思考するモデル」の実現基盤:

Googleは、Gemini 2.5のような次世代AIモデルが持つ「思考能力」を支える上で、Ironwoodのような高性能ハードウェアが不可欠であると強調している。複雑な問題を分解し、多段階の推論を経て結論を導き出すような高度なAI機能は、Ironwoodが提供する計算能力、メモリ容量、低遅延通信によって初めて現実的なものとなる。

4. 競争環境におけるGoogleの強み:

AIアクセラレータ市場では、NVIDIAが圧倒的なシェアを持つ一方、Amazon (Trainium, Inferentia) やMicrosoft (Maia 100) も自社開発チップに注力し、競争が激化している。その中でGoogleの強みは、10年以上にわたるTPUの自社開発経験と、チップからソフトウェア、クラウドサービスに至るまでの「垂直統合」にある。Googleは、自社の検索やGmail、YouTubeといった大規模サービスでTPUを運用し、最適化してきた経験を持つ。このノウハウを活かしたIronwoodは、性能、効率、スケーラビリティにおいて独自の優位性を発揮することが期待される。

5. 推論特化へのシフトが示す業界トレンド:

Googleが推論に特化したチップを投入したことは、AI業界全体のトレンド変化を示唆している。これまで、AI開発競争は主にモデルの規模やトレーニング性能に焦点が当てられてきた。しかし、実用化が進むにつれて、学習済みモデルをいかに効率よく、低コストで、大規模に展開・運用するか、すなわち「推論」の重要性が増している。Ironwoodは、この新たなフェーズへの移行を象徴するチップと言えるだろう。

開発者と企業にもたらすインパクト:AI活用の新次元へ

Ironwoodは、Google Cloudを利用する開発者や企業にとって、AI活用の可能性を大きく広げるものとなる。

1. 柔軟な利用オプション:

Ironwoodは、Google Cloudを通じて2025年後半に利用可能になる予定だ。提供形態としては、比較的小規模なワークロード向けの256チップ構成と、最大規模の性能を必要とするワークロード向けの9,216チップ構成が用意される。これにより、ユーザーは自身のニーズに合わせて最適な計算資源を選択できる。

2. AI導入・運用のコスト効率化:

Ironwoodの卓越した電力効率は、AIモデルの運用コスト、特に電力コストの削減に直結する。これにより、これまでコスト面で導入をためらっていた高度なAIモデルの活用が現実味を帯びてくる。特に、大規模な推論処理を常時行う必要があるサービスにとっては大きなメリットとなるだろう。

3. 高度なAIアプリケーションの実現:

Ironwoodの高い性能と大容量メモリは、より複雑で「思考する」能力を持つAIモデルの実行を可能にする。これにより、創薬研究、金融市場分析、リアルタイムでの複雑なレコメンデーション、そして自律的にタスクをこなすAIエージェントの開発など、これまで実現が難しかった高度なAIアプリケーションへの道が開かれる。

4. 強化される周辺インフラ:

GoogleはIronwoodの投入に合わせて、AI Hypercomputer全体のインフラも強化している。これには、NVIDIAの最新GPU(Blackwellアーキテクチャ B200/GB200)の提供、最大4倍の帯域幅を持つ400Gネットワーキング(Cloud Interconnect/Cross-Cloud Interconnect)、高性能ストレージ(Hyperdisk Exapool, Cloud Storage zonal bucket)、そしてPathwaysやGKE(Google Kubernetes Engine)向けの推論管理ツール(Inference Gateway, Cluster Director)などが含まれる。これらの強化により、ユーザーはIronwoodを含む最適なリソースを組み合わせて、AIワークロードを効率的に構築・運用できるようになる。

GoogleのIronwoodは、単なる新しいチップの発表ではない。AIが次の進化段階へと進むための強力なエンジンであり、Googleが描く「推論の時代」を実現するための礎となる。その驚異的な性能と効率性は、AIの研究開発を加速させ、ビジネスや社会におけるAIの役割を再定義する可能性を秘めている。もちろん、ベンチマークの解釈には注意が必要であり、実際のワークロードでの性能が重要となるが、IronwoodがAIインフラのランドスケープに大きな影響を与えることは間違いないだろう。Google自身のサービスだけでなく、世界中の開発者や企業がこの新しい力をどのように活用していくのか、今後の展開が注目される。

Sources