AIチップスタートアップGroqが、AIインフラ市場で大きな注目を集めている。同社は最近、6億4000万ドルのシリーズD資金調達ラウンドを完了し、企業価値を28億ドルに押し上げた。AIバブルの危険性も囁かれる中でのこの巨額の資金調達成功は、AIチップ市場の熾烈な競争と、投資家たちのAIインフラへの関心がいまだ続いていることの現れとも言えるのではないだろうか。

Groqの革新的なAIチップ技術と急成長戦略

Groqは2016年に設立された比較的若いスタートアップだが、その技術力と成長速度は業界に大きなインパクトを与えている。創業者でありCEOのJonathan Ross氏は、GoogleのカスタムAIアクセラレータチップであるテンソル処理ユニット(TPU)の発明に貢献した経歴を持つ。この経験を活かし、Groqは当初からAIの推論処理に特化したチップの開発に注力してきた。

同社の主力製品は言語処理ユニット(LPU)と呼ばれる推論エンジンだ。Groqは、このLPUが従来のプロセッサと比較して、ChatGPTやGPT-4のような大規模言語モデル(LLM)を10倍の速度で、かつ10分の1のエネルギーで実行できると主張している。この性能と省エネ性は、AI業界に大きな変革をもたらす可能性を秘めたものだ。

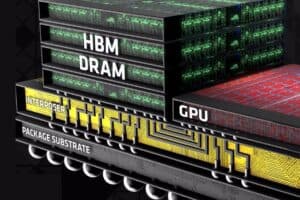

Groqの技術的アプローチは、従来のGPUベースの装置とは一線を画している。同社のLPUは、高価な高帯域幅メモリ(HBM)や高度なパッケージングを必要とせず、代わりに光ファイバー相互接続を使用して数百のLPUを接続する戦略を採用している。この独自のアーキテクチャにより、AIインフラのボトルネックとなっていた供給問題の解決に貢献する可能性があるのだ。

Groqの技術力を示す一例として、576個のLPUを使用したクラスタで、MetaのLlama 2 70Bモデルにおいて、8個のGPUを搭載したHGX H100システムの10倍となる毎秒300トークン以上の生成速度を達成したことが報告されている。¥

今回の大型資金調達により、Groqは積極的な拡大戦略を打ち出している。2025年第1四半期末までに10万8000個以上のLPUを展開する計画だ。これらのLPUはGlobalFoundriesの14nmプロセスノードで製造される予定だが、同社はすでに次世代LPUの開発にも着手している。Samsungの4nmプロセス技術を利用して15〜20倍の電力効率向上を目指すなど、継続的な技術革新にも注力している。

Groqの成長戦略は、ハードウェアの開発だけにとどまらない。同社はAIインフラストラクチャ・アズ・ア・サービス(AIaaS)プロバイダーとしての地位を確立しつつある。クラウドサービスであるGroqCloudには既に36万人以上の開発者が参加しており、MetaのLlama 3.1ファミリー、GoogleのGemma、OpenAIのWhisper、MistralのMixtralなど、オープンに利用可能なモデルを使用してアプリケーションを構築している。

さらに、Groqは企業や政府機関向けのソリューション提供にも力を入れている。2024年3月にはDefinitive Intelligenceを買収し、Groq Systemsという新しいビジネスユニットを設立した。このユニットは、米国政府機関や主権国家を含む組織に対して、既存のデータセンターにGroqのチップを追加したり、Groqのプロセッサを使用して新しいデータセンターを構築したりするサービスを提供している。

Groqの急成長は、AIインフラ市場全体の活況を反映したものだ。同社のCEOのJonathan Ross氏は「AIモデルのトレーニングは解決済みです。今は、世界中の人々がこれらのモデルを使用できるようにデププロイする時です」と述べ、AIの実用化と大規模展開に向けた同社の取り組みを強調している。

しかし、AIチップ市場は競争が激しさを増していることもまた事実だ。市場を独占しているNVIDIAに対抗し、Amazon、Google、Microsoftなどの大手テック企業は独自チップ開発に注力しており、D-MatrixやEtched.aiなどのスタートアップも台頭している。さらに、OpenAIもAIチップ製造への参入を検討しているとの報道もある。

このような競争環境の中、Groqの今後の展開が注目される。同社の革新的な技術と積極的な成長戦略が、AIインフラ市場にどのような変革をもたらすのか、今回の巨額の資金調達成功はその期待の現れとも言えるだろう。NVIDIAをはじめとする既存の大手との競争や、他のAIチップスタートアップとの差別化が、Groqの成功の鍵を握るに違いない。

Source

コメント