IBMが次世代メインフレーム向けの新型AIプロセッサー「Telum II」を発表した。この革新的なチップは、従来のAIモデルと大規模言語モデル(LLM)の両方を加速させる能力を持ち、IBMのAI処理業界における存在感を高めることが期待されている。Telum IIは、8コア5.5GHzの高性能プロセッサーに360MBのキャッシュを搭載し、AIワークロードの処理能力を大幅に向上させる設計となっている。

Telum IIプロセッサーの革新的アーキテクチャ

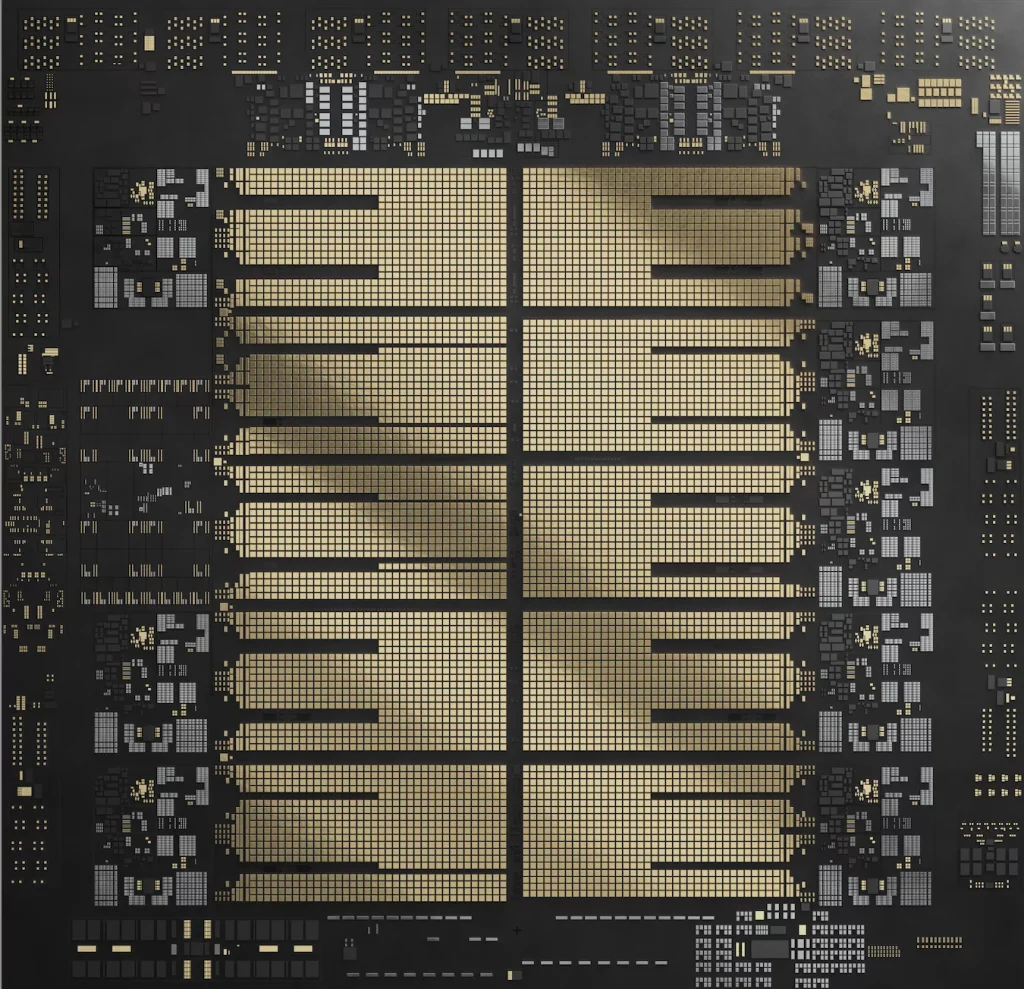

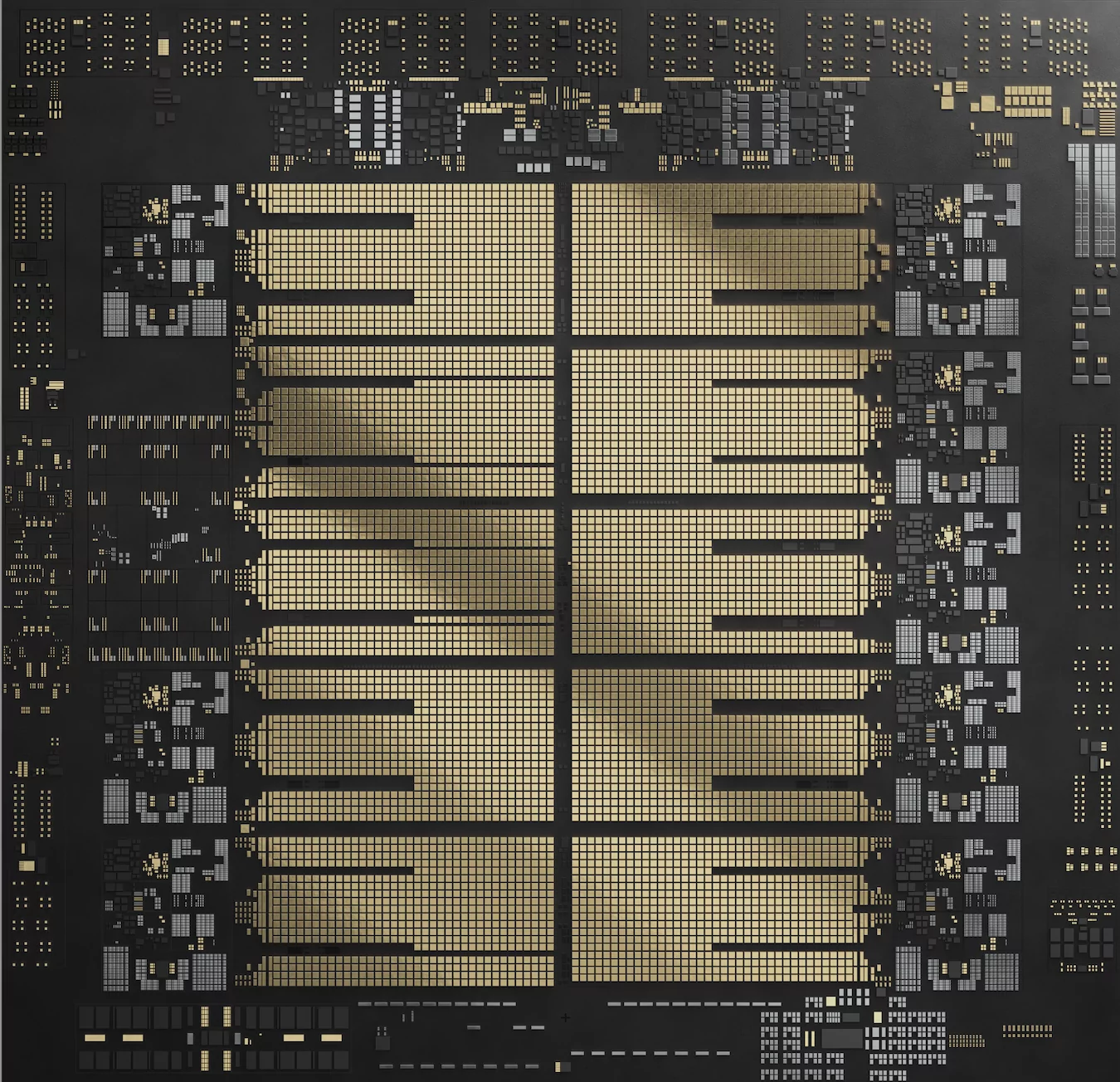

Telum IIプロセッサーは、Samsung Foundryの5nmプロセスで製造され、43億のトランジスタを600平方ミリメートルのダイに集積している。この高度な製造プロセスにより、高性能と省電力性を両立させることが可能となった。

プロセッサーの中核となる8つのコアは、それぞれ5.5GHzという高クロック周波数で動作する。各コアには36MBのL2キャッシュが搭載されており、これによりオンチップキャッシュ容量が前世代から40%増加し、合計360MBという大容量を実現している。さらに、プロセッサードロワーあたり2.88GBの仮想L4キャッシュを備えており、これも前世代から40%の増加となっている。

Telum IIの特筆すべき機能の一つが、チップに統合されたAIアクセラレータだ。このアクセラレータは低遅延・高スループットのAI推論処理に特化して設計されており、チップあたり24TOPS(1秒間に24兆回の演算)、ドロワーあたり192TOPS、システム全体で768TOPSという性能を提供する。これは前世代のTelumプロセッサーと比較して4倍の計算能力向上だ。

さらに、Telum IIには新たに開発されたデータ処理ユニット(DPU)が統合されている。このDPUは、ネットワーキングとストレージの複雑な入出力プロトコルを効率的に処理することで、I/O密度を50%向上させている。これにより、大規模なAIワークロードやデータ集約型アプリケーションの処理に適したシステムとなっている。

興味深いことに、Telum IIはレジスタサイズを160に増加させながらも、全体的なチップサイズを20%削減し、消費電力も15%低減させることに成功している。これは、高度な設計技術と最新の製造プロセスの成果と言える。

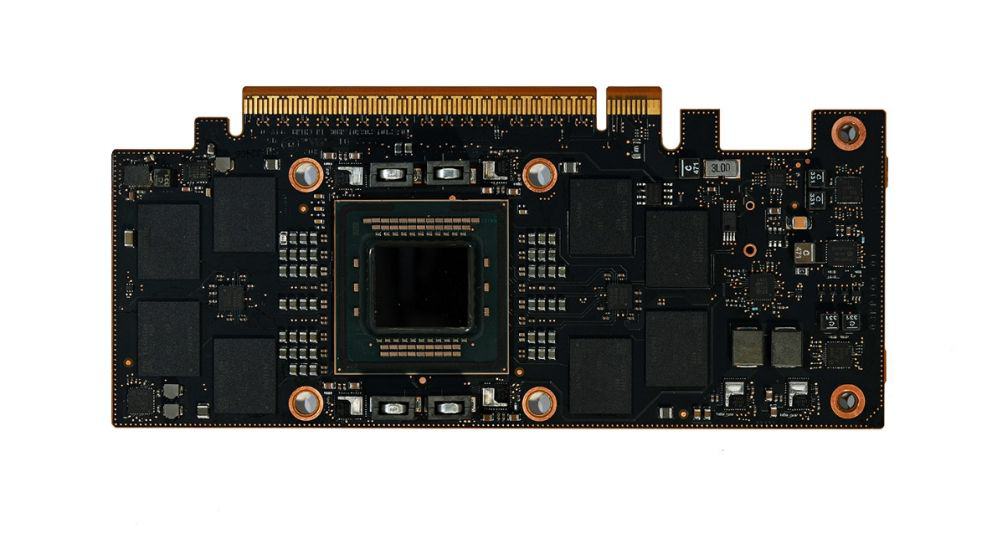

IBMは、Telum IIプロセッサーと併用するための新しいIBM Spyreアクセラレータも同時に発表した。このSpyreアクセラレータは、8枚のカードに分散された1テラバイトという大容量のメモリを搭載し、32の専用計算コアを備えている。これらのコアは、int4、int8、fp8、fp16といった多様なデータタイプをサポートしており、幅広いAIアプリケーションに対応できる柔軟性を持っている。

Telum IIとSpyreの組み合わせは、AIモデリングの新たなアプローチである「アンサンブル手法」を実現するためのスケーラブルなアーキテクチャを提供する。この手法は、複数の機械学習および深層学習AIモデルをエンコーダーLLMと組み合わせることで、単一のモデルタイプを使用する場合と比較して、より正確で洞察力のある結果を導き出すことができる。

これらの革新的な技術は、保険詐欺検出の強化やマネーロンダリング検出システムのサポートなど、従来IBMのZメインフレームシステムで処理されてきた特殊なAIアプリケーションに新たな可能性をもたらす。例えば、リアルタイムでの金融取引における不正検出能力が大幅に向上することが期待される。また、Telum IIは知識転送やコード説明などの機能を持つ生成AIアシスタントの基盤としても理想的であり、企業のAI活用の幅を広げることができる。

IBM Z および LinuxONE 製品管理担当副社長のTina Tarquinio氏は、「Telum II プロセッサーと Spyre アクセラレーターは、高性能で安全性が高く、より省電力なエンタープライズコンピューティングソリューションを提供するように設計されています」と述べており、これらの新技術がエンタープライズAI市場に与える影響に大きな期待を寄せている。

Telum IIチップを搭載した次期IBM ZメインフレームおよびIBM LinuxONEシステムは2025年に発売される予定だ。この新世代のシステムにより、IBMはAI処理業界における競争力を一層強化し、エンタープライズAIの未来を切り開くことを目指している。

Source

コメント