人工知能(AI)技術の急速な進化により、データセンターの在り方が大きく変わりつつある。この変革の波に乗り、Intelが次世代のAIインフラストラクチャー向けに新たな製品を発表した。Xeon 6プロセッサーとGaudi 3 AIアクセラレーターは、高性能と低コストを両立させ、企業のAI導入を加速させることを目指している。

Intelのデータセンターおよび人工知能グループのエグゼクティブバイスプレジデント兼ゼネラルマネージャーであるJustin Hotard氏は、今回の発表について次のように述べている。

「AIの需要急増により、データセンターは大きな変革期を迎えています。業界からは、ハードウェア、ソフトウェア、開発ツールにおける選択肢が求められています。Xeon 6とGaudi 3 AIアクセラレーターの発表により、Intelはオープンなエコシステムを実現し、顧客があらゆるワークロードをより高性能、効率的、そして安全に実装できるようにします」。

Xeon 6:AIワークロード対応の次世代プロセッサー

Xeon 6プロセッサーは、AI時代のデータセンターに求められる多様なワークロードに対応するため、柔軟性と高性能を両立させている。前世代と比較して2倍の性能を実現し、以下の特徴を持つ:

- コア数の増加:より多くの並列処理が可能となり、複雑なAIワークロードの処理速度が向上。

- メモリ帯域幅の倍増:大規模なデータセットを扱うAIモデルの学習や推論に必要な高速データアクセスを実現。

- AI加速機能の内蔵:各コアにAI専用の処理ユニットを組み込むことで、AI処理の効率を大幅に向上。

- 幅広い用途:エッジコンピューティングから大規模データセンターまで、様々な環境での利用が可能。

Xeon 6は、機械学習の数値処理からAIモデルの運用まで、幅広いタスクを効率的に処理することができる。特に、従来のCPUワークロードとAIワークロードを同時に処理する必要がある環境で、その真価を発揮する。

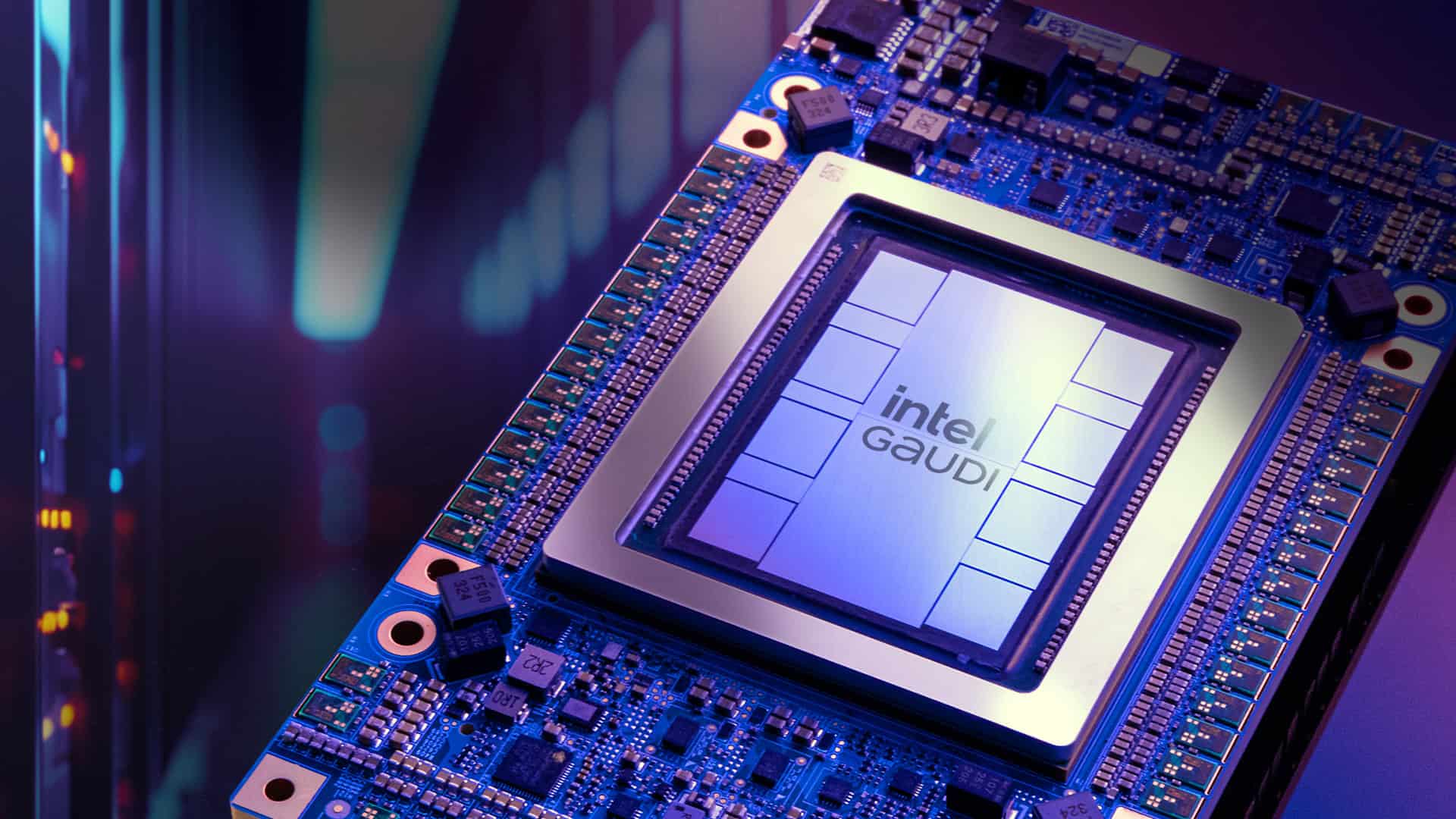

Gaudi 3:大規模AI処理に特化したアクセラレーター

Gaudi 3 AIアクセラレーターは、大規模な生成AIタスクに特化して設計されており、以下の特徴を持つ:

- 高性能アーキテクチャ:64個のTensorプロセッサコア(TPC)と8個の行列乗算エンジン(MME)を搭載し、深層ニューラルネットワークの計算を高速で処理。

- 大容量高速メモリ:128GBのHBM2eメモリを搭載し、3.67 TB/sの巨大な帯域幅を提供。

- 高速ネットワーク接続:24個の200ギガビットイーサネットポートにより、大規模なAIタスクを効率的に分散処理。

- 優れた性能指標:最大1856 BF16/FP8行列TFLOPSおよび最大28.7 BF16ベクトルTFLOPSを提供し、消費電力は約600W。

- ソフトウェア互換性:PyTorchフレームワークやHugging Faceの先進的なトランスフォーマーおよびディフューザーモデルとの優れた互換性。

Gaudi 3の性能は、NVIDIAのH100 GPUと比較して、BF16行列性能ではわずかに低い(1,856 vs 1,979 TFLOPS)ものの、価格面での優位性を考慮すると、非常に競争力のある製品といえる。特に、大規模言語モデル(LLM)の学習や推論、コンピュータビジョンタスクなど、計算負荷の高いAIワークロードに適している。

戦略的価格設定とパートナーシップ

Intelは、Xeon 6とGaudi 3の価格競争力を強調している。特に、Gaudi 3を8基搭載したアクセラレーターキットは125,000ドルで提供される予定であり、1基あたり約15,625ドルとなる。これはNVIDIA H100カードの現在の価格30,678ドルと比較して、大きな価格優位性を持つ。

この価格戦略は、AIインフラの総保有コスト(TCO)を削減したい企業にとって魅力的な選択肢となる可能性がある。Intelは、ワット当たりの性能バランスに優れた製品を提供することで、大規模AIワークロードを実行する企業の運用コストを削減することを目指している。

さらに、IntelはIBM CloudやDell Technologies、Supermicroなどの主要パートナーとの協力関係を強化している。IBM CloudではGaudi 3 AIアクセラレーターをサービスとして提供する予定であり、AIソリューションのスケーラビリティと利便性を向上させることが期待される。

Dell TechnologiesとSupermicroは、Xeon 6とGaudi 3を搭載したシステムを2024年第4四半期に一般提供開始する予定である。これにより、企業は自社のニーズに合わせたAIインフラを柔軟に構築することが可能となる。

Source

コメント