昨日はGoogleが独自のArmベース・カスタムチップ「Axion」を、そしてIntelも新たなAIアクセラレータ「Gaudi 3」を発表したが、これに続き本日、MetaもAI分野でライバルに後れを取るまいと、同社が多額の投資を行い開発を続けているカスタムAIチップ「MTIA」の次世代バージョンについて、詳細を発表した。

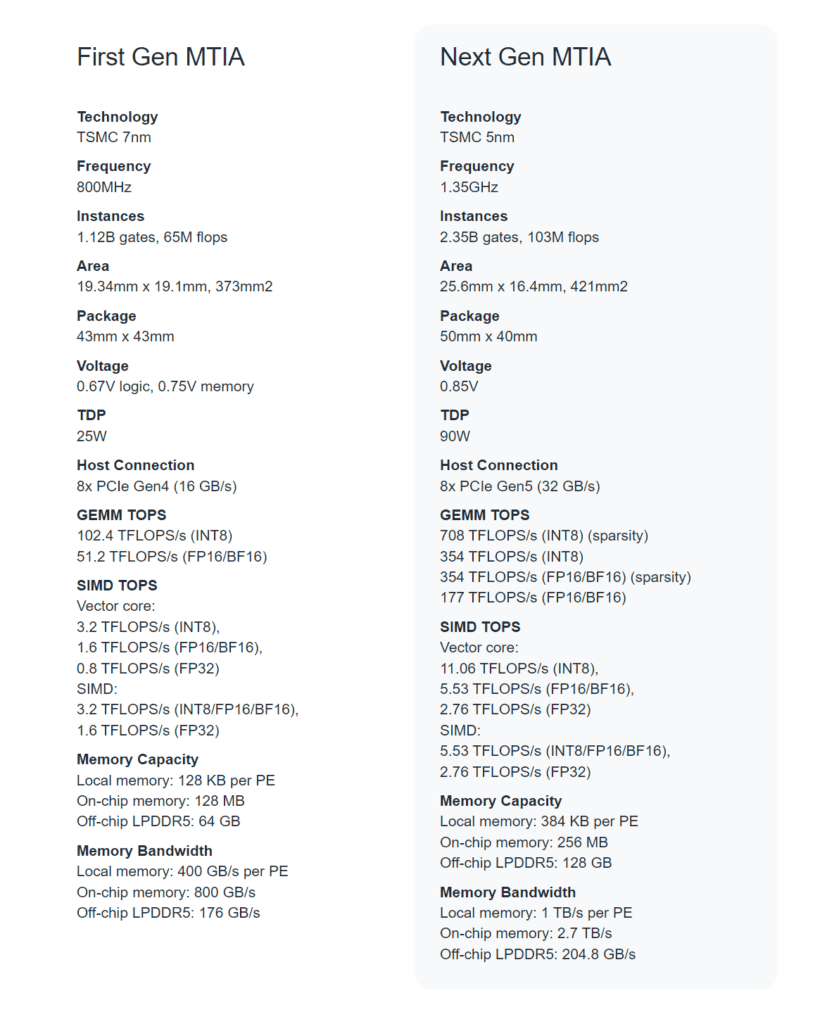

Meta Training and Inference Accelerator(MTIA)は、MetaがAIワークロードの推論用に特別に開発しているチップ・ファミリーである。MTIA v1は2023年5月に初めて登場したが、それから1年足らずで同社はその次世代バージョンを開発し、すでに自社の広告やランキングのプロセスにこれを使用しているという。

「当社のカスタム・シリコンに対する野望を満たすことは、コンピュート・シリコンだけでなく、メモリ帯域幅、ネットワーキング、容量、その他の次世代ハードウェア・システムにも投資することを意味します」とMetaはプレスリリースで述べている。

Metaによると、この次世代MTIAは、Metaのワークロードとの緊密な接続を維持しながら、コンピュートとメモリの帯域幅を旧バージョンの2倍にする事を実現しているとのことだ。このアーキテクチャは、特にMetaの広告ランキングとレコメンデーション・モデルの処理能力、帯域幅、ストレージ容量の適切なバランスを取ることに重点を置いているという。

次世代MTIAは、TSMCの5nmプロセスで製造されており、v1の128MBと800GHzと比較して、256MBのメモリをオンチップで1.35GHz搭載する。

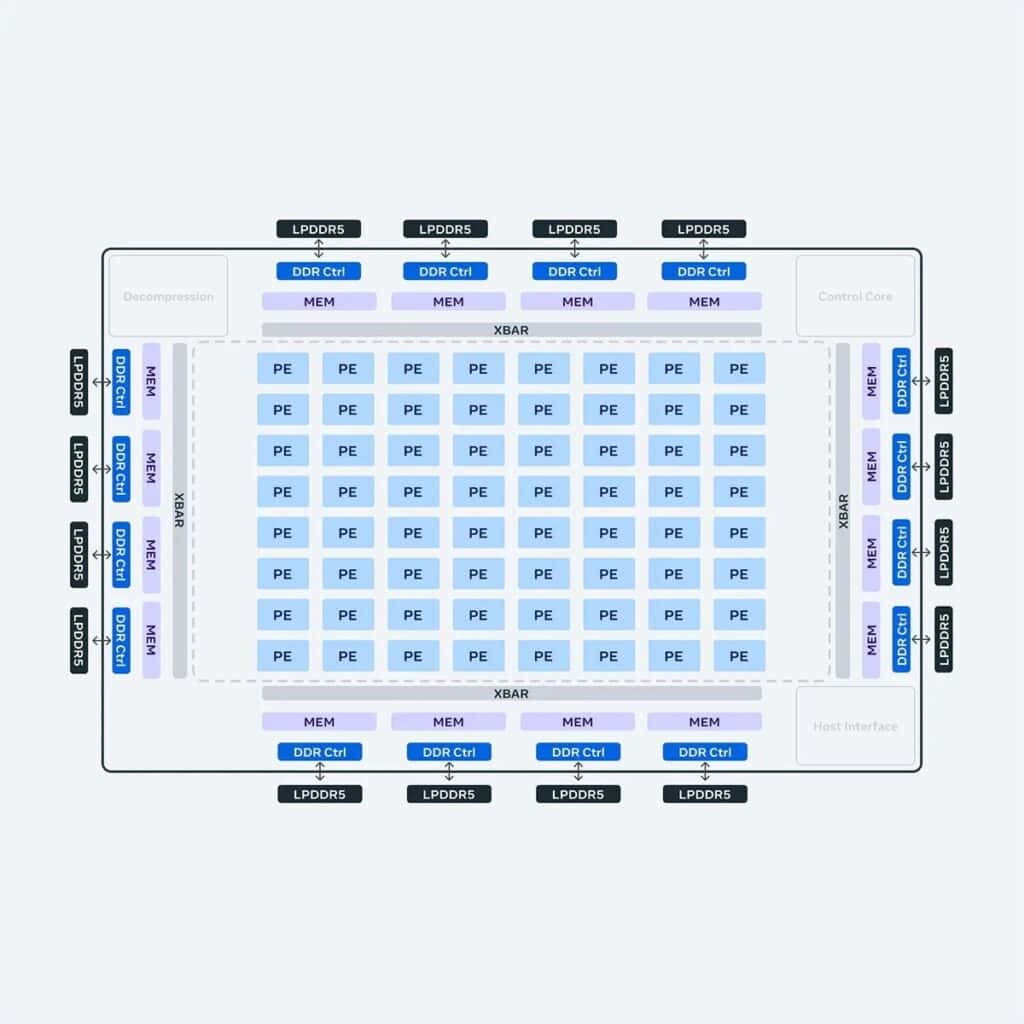

このアクセラレータは、8×8グリッドのプロセッシング・エレメント(PE)で構成されている。スパース計算のパイプライン化に関連するアーキテクチャの改善、また、PEグリッドへの給電方法も変更され、更に、ローカルPEストレージのサイズを3倍にし、オンチップSRAMを2倍にしてそのバンド幅を3.5倍にし、LPDDR5の容量を2倍にしている。これらの変更により、高密度計算性能(MTIA v1の3.5倍)とスパース計算性能(7倍)が大幅に向上しているとのことだ。

また、次世代MTIAをサポートするため、Metaは最大72台のアクセラレーターを収納できる大型のラックベースのシステムを開発した。これは3つのシャーシで構成され、各シャーシにはそれぞれ2つのアクセラレーターを搭載する12枚のボードが収められている。MTIA v1のTDP25ワットに対し、次世代MTIAは90ワットで動作させることができるよう、特別にシステムも設計されている。

さらに、アクセラレータ間およびホストとアクセラレータ間のファブリックをPCIe Gen5にアップグレードし、システムの帯域幅とスケーラビリティを向上させているという。

さらに、生成AIワークロードのサポートを含め、MTIAの範囲を拡大するためのいくつかのプログラムが進行中とのことだ。

Metaはまた、ソフトウェア・レベルの最適化を行い、MTIAハードウェア用の「高性能コード」を生成する低レベル・コンパイラであるTriton-MTIAを開発した事も明らかにしている。

Metaによれば、この新しいチップの初期結果では、4つの主要モデルの性能が第1世代のチップに比べてすでに3倍になっているという。Metaはスタック全体を制御しているため、商用GPUと比較してより高い効率を達成できるようだ。

こうしたカスタムAIチップの開発は自社製品への最適化という側面もあるが、コスト削減効果という面でも大いに意義のある事だろう。Metaは2024年末までに、生成AIモデルのトレーニングと実行のためにGPUに推定180億ドル費やすと見ており、最先端の生成AIモデルのトレーニング費用は数千万ドルに及ぶため、社内のハードウェアは魅力的な選択肢となる。新チップは、AIモデルの実行だけでなく、そのトレーニングにも使用されるNVIDIA GPUへの依存を一部の分野で減らすことができ、コスト削減に大いに寄与することが期待されている。

Source

コメント