Metaが最新の言語モデル「Llama 3.2」を発表した。この新バージョンは、スマートフォンで動作する小型モデルと画像理解能力を持つ大規模モデルを含み、AIの可能性を大きく広げる革新的な機能を搭載している。Llama 3.2の登場により、モバイルデバイスでのAI活用が加速し、画像と言語を組み合わせた高度な処理が可能になることが期待出来そうだ。

Llama 3.2:モバイルAIの新時代を切り拓く小型モデル

Llama 3.2の最も注目すべき特徴の一つは、スマートフォンで動作する1B(10億パラメータ)と3B(30億パラメータ)の小型モデルである。これらのモデルは、128,000トークンという長い文脈を処理できる能力を持ち、テキストの要約、コンテンツの書き換え、他のアプリでの特定の機能の呼び出しなどのタスクを、デバイス上でローカルに実行できる。

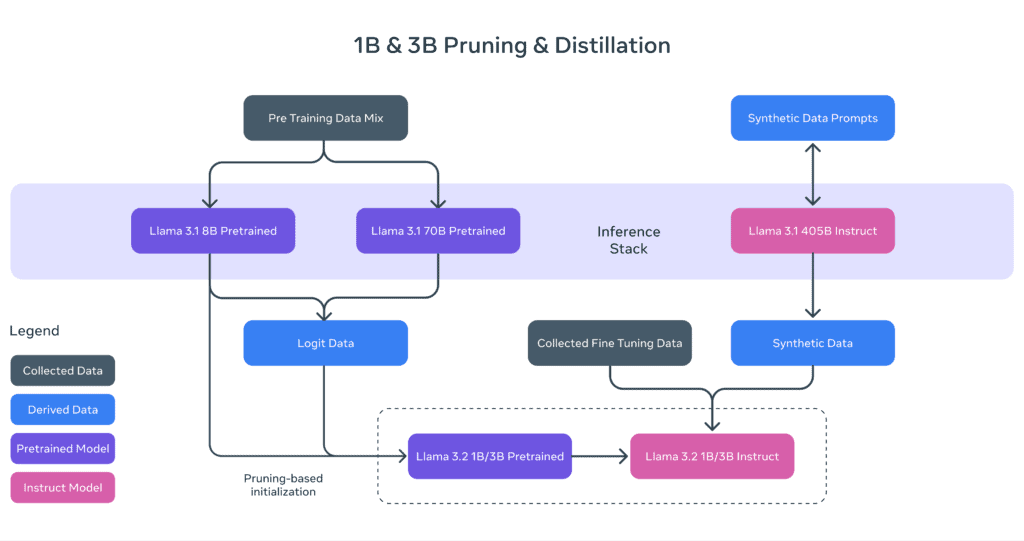

Metaは、これらの軽量モデルを最適化するために、大規模な教師モデルからの知識転移と構造化プルーニングを組み合わせた手法を採用した。具体的には、Llama 3.1の8Bモデルから一度のパスで構造化プルーニングを行い、ネットワークの一部を系統的に削除して重みを調整している。

モバイルデバイスでのAI処理には、主に2つの大きな利点がある。第一に、処理がローカルで行われるため、プロンプトや応答がほぼ瞬時に得られる。第二に、メッセージやカレンダー情報などのデータがクラウドに送信されないため、プライバシーが保たれる。これにより、アプリケーションはどのクエリをデバイス上に保持し、どのクラウド上でどの大規模モデルで処理する必要があるかを明確に制御できる。

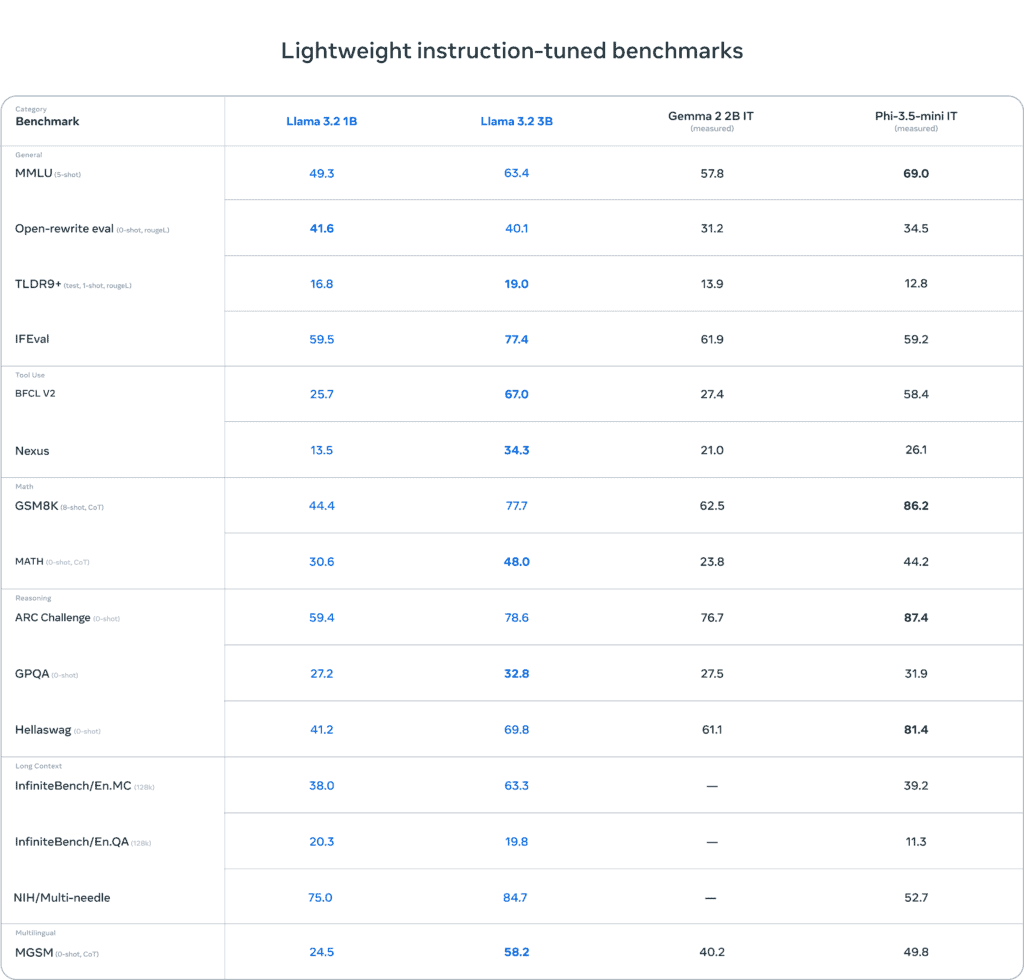

Metaの評価によると、3Bモデルは指示に従う能力、要約、プロンプトの書き換え、ツールの使用などのタスクにおいて、Gemma 2の2.6BモデルやPhi-3 3.5-miniモデルを上回る性能を示している。一方、1BモデルはGemmaと競争力のある性能を持つという。

これらの軽量モデルの開発において、Metaは世界最大のモバイルSoCメーカーであるQualcommやMediaTek、そしてモバイルデバイスの99%の計算基盤を提供するArmと密接に協力した。今回リリースされる重みはBFloat16数値に基づいているが、Metaのチームはさらに高速に動作する量子化バリアントの探索を積極的に進めており、近い将来に共有される可能性がある。

このような小型モデルの登場により、個人のスマートフォンでプライバシーを保ちながら高度なAI機能を利用できる時代が到来しつつある。例えば、最後に受信した10件のメッセージを要約し、アクションアイテムを抽出し、ツール呼び出しを利用してフォローアップミーティングの予定を直接送信するといったパーソナライズされたアプリケーションの構築が可能になる。

ビジョン機能とLlama Stack

Llama 3.2の大きな特徴の一つが、画像理解能力を持つ11B(110億パラメータ)と90B(900億パラメータ)の大規模モデルである。これらのモデルは、グラフや図表を含むドキュメントレベルの理解、画像のキャプション生成、自然言語による説明に基づいて画像内のオブジェクトを方向的に特定するなどの視覚的グラウンディングタスクをサポートしている。

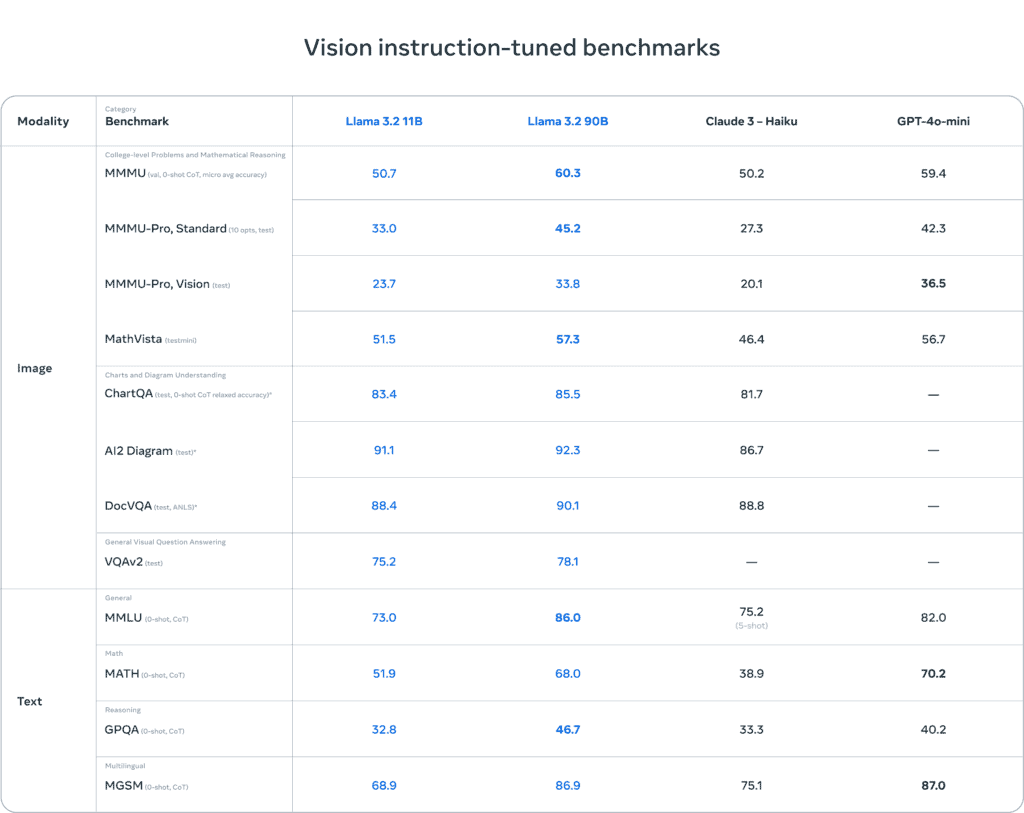

Metaのベンチマークによると、Llama 3.2の11Bおよび90Bモデルは、画像理解タスクにおいてClaude 3 HaikuやGPT-4o miniなどの主要なクローズドモデルと同等の性能を発揮するという。また、オープンソースの競合であるMistralも最近、Pixtralという初のビジョンモデルを発表したが、パラメータ数は大幅に少ない。

画像入力を可能にするために、Metaは事前学習済みの画像エンコーダを事前学習済みの言語モデルに統合する追加のアダプター重みを訓練するという新しいアーキテクチャを採用した。このアダプターは、画像エンコーダの表現を言語モデルに供給する一連のクロスアテンション層で構成されている。

Metaの訓練パイプラインは、事前訓練されたLlama 3.1テキストモデルから始まり、複数の段階を経て行われる。まず画像アダプターとエンコーダを追加し、大規模なノイズの多い(画像、テキスト)ペアデータで事前訓練を行う。次に、中規模の高品質なドメイン内および知識強化された(画像、テキスト)ペアデータで訓練を行う。

事後訓練では、テキストモデルと同様のレシピを使用し、監督付き微調整、棄却サンプリング、直接選好最適化の数ラウンドを行う。また、Llama 3.1モデルを使用してドメイン内の画像に関する質問と回答をフィルタリングおよび拡張し、報酬モデルを使用してすべての候補回答をランク付けすることで、高品質な微調整データを提供する合成データ生成を活用している。

Llama Stack:AIアプリケーション開発の新標準

Llama 3.2のリリースに合わせて、MetaはLlama Stack分布の最初の公式版も発表した。これは、開発者がさまざまな環境でLlamaモデルを使用する方法を大幅に簡素化するものである。Llama Stackは、Retrieval Augmented Generation(RAG)やツール統合を含むアプリケーションのターンキー提供を可能にする。

Llama Stack分布には以下が含まれる:

- Llama CLI(コマンドラインインターフェース):Llama Stack分布の構築、設定、実行用

- 複数の言語(Python、Node.js、Kotlin、Swift)でのクライアントコード

- Llama Stack分布サーバーとAgents APIプロバイダー用のDockerコンテナ

- 複数の分布(シングルノード、クラウド、オンデバイス、オンプレミス)

Metaは、AWS、Databricks、Dell、Together AIなどの企業と協力してAPIを開発している。また、コマンドラインインターフェース(CLI)や様々なプログラミング言語用のコードも提供されている。

この統合されたスタックにより、開発者はLlamaモデルを使用したアプリケーションの構築をより簡単に行えるようになる。例えば、オンプレミス環境、クラウド、シングルノード、オンデバイスなど、さまざまな環境でLlamaモデルを一貫して使用できるようになる。

安全性と責任あるAI開発への取り組み

Metaは、オープンなアプローチを取りつつ、安全で責任あるシステムの構築を開発者に促している。Llama 3.2のリリースに合わせて、新たな安全対策も導入された:

- Llama Guard 3 11B Vision:Llama 3.2の新しい画像理解機能をサポートし、テキスト+画像の入力プロンプトや、これらのプロンプトに対するテキスト出力応答をフィルタリングするように設計されている。

- Llama Guard 3 1B:オンデバイスなどのより制約の厳しい環境で使用するための1Bおよび3B Llamaモデルに合わせて最適化された。サイズが2,858 MBから438 MBに大幅に縮小され、展開コストが大幅に削減された。

これらの新しいソリューションは、Metaのリファレンス実装、デモ、アプリケーションに統合されており、オープンソースコミュニティが初日から使用できる状態にある。

Metaは、責任ある公開の一環として、開発者に新しいツールとリソースを提供し、Responsible Use Guide(責任ある使用ガイド)のベストプラクティスを継続的に更新している。これにより、Llamaを使用した安全で倫理的なAIアプリケーションの開発を促進している。

Source

コメント