MetaのGenerative AI部門VP、Ahmad Al-Dahle氏は、同社の最新オープンソース大規模言語モデル「Llama 3.3」を発表した。このモデルは、従来の405B(4050億)パラメータモデルと同等の性能を、わずか70B(700億)パラメータで実現する画期的な効率性を特徴としている。

革新的な効率性の実現

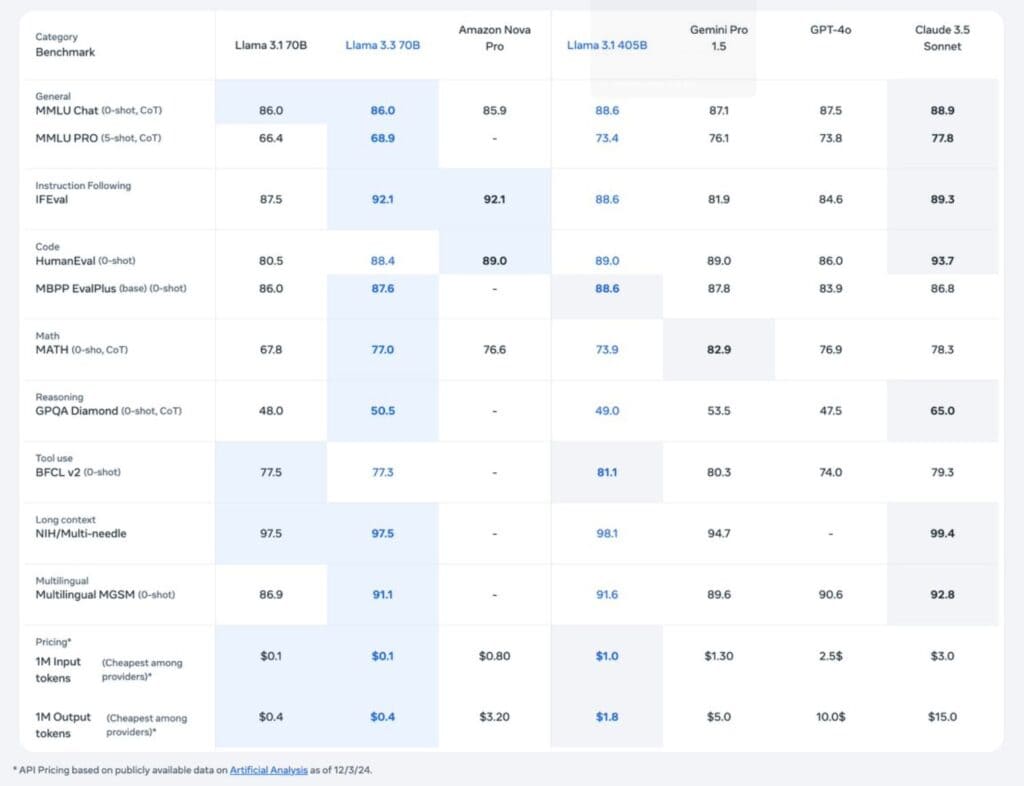

Llama 3.3における最も注目すべき革新は、必要とされるコンピューティングリソースの劇的な削減にある。従来のLlama 3.1-405Bモデルでは、動作に243GBから最大1,944GBものGPUメモリを必要としていた。これに対して新たに投入されたLlama 3.3は、わずか42-168GBのGPUメモリで動作が可能となっている。この技術的ブレークスルーにより、標準的な80GB NVIDIA H100 GPUの処理負荷を最大で24分の1まで軽減することに成功した。

この効率化がもたらす経済的インパクトも極めて大きい。現在のH100 GPUの市場価格は1台あたり約25,000ドルとされているが、必要なGPU数の大幅な削減により、システム構築時の初期投資を最大60万ドルも削減できる可能性がある。さらに、継続的に発生する電力コストについても、従来モデルと比較して大幅な削減が期待できる。

トークン処理のランニングコストについても、画期的な改善が実現されている。入力トークンの処理コストは100万件あたりわずか0.1ドル、出力トークンは0.4ドルと、従来モデルの10分の1以下まで低減された。これは、Llama 3.1-405Bモデルが必要とした入力トークン100万件あたり1ドル、出力トークン1.8ドルという処理コストと比較すると、劇的な改善といえる。

高度な技術仕様と性能

Llama 3.3の開発過程と技術的達成は、現代の大規模言語モデルにおける効率性と性能の新たな基準を示している。開発チームは約15兆のトークンという膨大なデータセットを用いて事前学習を実施し、さらに2,500万件を超える合成データによって機能を強化した。この学習プロセスには、NVIDIA社のH100-80GB GPUを用いて総計39.3万時間という途方もない計算時間が投入された。注目すべきは、この大規模な計算処理において、Metaが環境負荷を考慮し、再生可能エネルギーを全面的に活用したことである。

モデルのアーキテクチャ面では、Grouped Query Attention(GQA)という革新的な注意機構を採用している。この技術により、推論時のスケーラビリティと性能が大幅に向上した。特筆すべきは約400ページ分の書籍テキストに相当する長さの文脈を一度に処理できる128,000トークンというコンテキストウィンドウの実現だ。この拡張された文脈理解能力により、長文の文書処理や複雑な分析タスクにおいて、より正確で一貫性のある出力が可能となっている。

多言語処理能力においても、Llama 3.3は顕著な成果を上げている。MGSMにおける多言語推論タスクでは91.1%という高精度を達成し、英語はもとより、ドイツ語、フランス語、イタリア語、ヒンディー語、ポルトガル語、スペイン語、タイ語など、幅広い言語をサポートしている。これは、グローバルなAIアプリケーション開発において重要な意味を持つ。

モデルの学習方法にも特徴がある。Metaは従来の教師あり微調整(Supervised Fine-tuning, SFT)に加えて、人間のフィードバックに基づく強化学習(Reinforcement Learning from Human Feedback, RLHF)を組み合わせた。この二段階の学習アプローチにより、モデルの出力は単なる性能向上だけでなく、より適切な応答と安全性の確保を実現している。具体的には、不適切なプロンプトに対する堅牢な拒否応答や、実世界のアプリケーションに最適化されたアシスタント的な振る舞いが可能となった。

さらに、Metaはモデルの展開をサポートするための包括的なツールセットも提供している。Llama Guard 3やPrompt Guardなどの安全性確保のためのツールは、開発者がモデルを責任を持って安全に展開するための重要な基盤となっている。これらのツールは、オープンソースコミュニティ全体にとって貴重なリソースとなることが期待される。

Xenospectrum’s Take

Meta、そしてAI業界全体にとって、このリリースが持つ意味は極めて大きい。計算資源の効率化は、AI開発の民主化と環境負荷軽減という、現代のAI開発が直面する2つの本質的な課題への回答となっている。

特筆すべきは、Metaがこの技術革新をオープンソースとして公開した点だ。ただし、月間アクティブユーザー7億人以上のプラットフォームには商用ライセンスが必要という制限は、「オープン」とは何かという議論にも繋がるかもしれない。

EUのAI規制法やGDPRへの対応に苦心するMetaだが、ルイジアナ州に計画中の100億ドル規模のAIデータセンターや、10万台以上のNVIDIA GPU調達など、次世代モデル開発への布石も着々と打っている。効率性と拡張性の両立を図るMetaの戦略は、今後のAI開発の方向性を示唆している。

Source

コメント