Microsoftは、プレイヤーの操作にリアルタイムで応答し、ゲーム環境を生成する新たなAIモデル「WHAMM」を発表した。この技術デモとして、古典的FPSゲーム『Quake II』の一部をAIが再現したバージョンがCopilot Labsにて公開され、誰でもブラウザ上で体験可能となっている。これは、AIがゲームコンテンツ生成にどのように貢献できるかを探る重要な一歩となる。

リアルタイム生成を実現した新AI「WHAMM」とは?

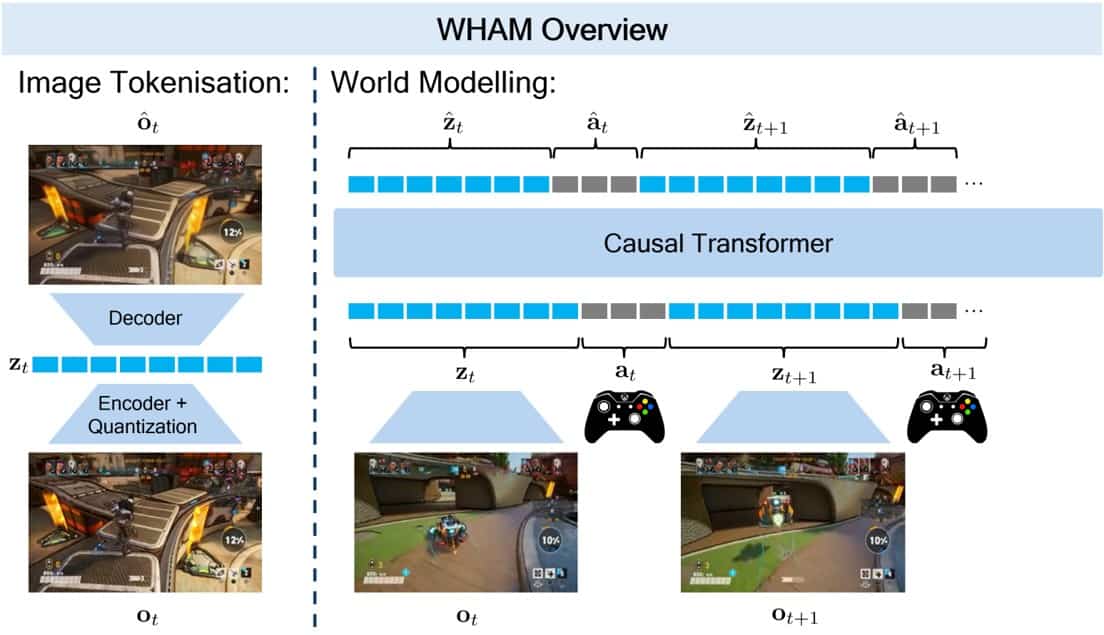

Microsoftが発表したWHAMM(World and Human Action MaskGIT Model)は、同社が開発を進めるゲーム用ワールドモデル群「Muse」ファミリーの最新モデルである。今年2月に発表された「WHAM」(World and Human Action Model)を基盤としつつ、リアルタイムでのインタラクションを実現するために大幅な改良が加えられた。

WHAMが1秒あたり約1フレームの生成速度だったのに対し、WHAMMは1秒あたり10フレーム以上の画像生成を可能にし、プレイヤーのキーボードやコントローラー操作に即座に反応するリアルタイム体験を提供する。この速度向上は、AIのアーキテクチャ変更によって達成された。

従来のWHAMは、LLM(大規模言語モデル)のようにトークン(画像やアクションを構成する最小単位)を1つずつ順番に生成するオートリグレッションモデルを採用していた。これは高品質な生成が可能だが、時間がかかるという課題があった。

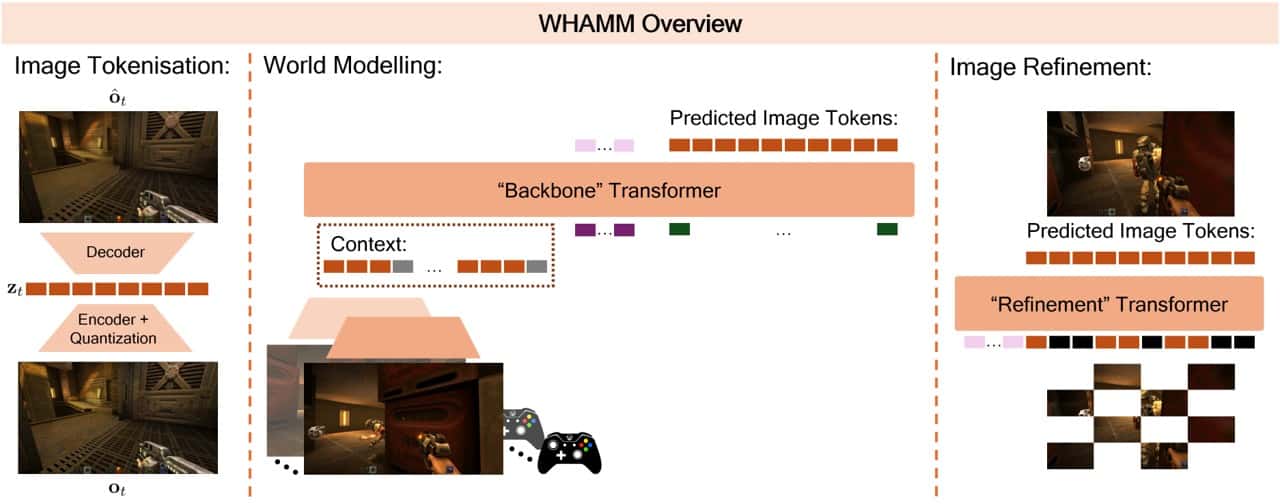

一方、WHAMMではMaskGITと呼ばれるアーキテクチャを採用。これは、画像全体のトークンを一度に生成し、その後、一部のトークンを「マスク」して再度予測・修正するプロセスを繰り返すことで、画像を段階的に精密化する手法である。これにより、少ない計算ステップで画像全体を生成でき、リアルタイム性が実現した。

WHAMMは具体的に、2段階のTransformerモデル構成を採用している。

- Backbone Transformer(約5億パラメータ): 過去の画像とアクションのシーケンス(コンテキスト)を入力とし、次の画像の全トークンの初期予測を生成する。

- Refinement Transformer(約2億5千万パラメータ): Backboneからの初期予測と、コンテキスト情報を凝縮した少数の「条件付けトークン」を入力とし、MaskGITの手法を用いて反復的に画像の精密化を行う。比較的小型で入力トークン数も少ないため高速に動作し、限られた時間内で複数回の精密化ステップを実行できる。

WHAMMのアーキテクチャ概要。左:画像をトークン化(WHAMと同様)。中央:Backbone Transformerがコンテキストから次画像を初期予測。右:Refinement Transformerが反復的に画像を精密化。 (Credit: Microsoft)

訓練効率と解像度も大幅向上:Quake IIデモ開発秘話

WHAMMの開発において特筆すべきは、その訓練データの効率性である。WHAM-1.6Bモデルの訓練には7年分ものゲームプレイデータが使用されたが、今回のQuake II版WHAMMは、わずか1週間のデータで訓練された。

これは、プロのゲームテスターと協力し、特定のレベルに焦点を当てて意図的に多様かつ高品質なゲームプレイデータを収集・キュレーションしたことによる成果である。これにより、新しいゲームへの適用が格段に容易になった。

さらに、生成される画像の解像度も向上している。WHAM-1.6Bの300×180ピクセルに対し、WHAMMは640×360ピクセルでの出力を実現。これは、画像エンコーダー/デコーダー(ViT-VQGAN [3])のパッチサイズを10から20に増やすという比較的小さな変更で達成され、体験の質感を大幅に向上させた。トークン数はほぼ同じ(WHAM: 540トークン、WHAMM: 576トークン)に保たれている。

現在Copilot Labsで公開されているデモでは、『Quake II』の最初のレベルの一部をWHAMMがシミュレートした世界で、プレイヤーは移動、視点変更、ジャンプ、しゃがみ、射撃といった基本的な操作が可能である。オリジナルのゲームと同様に、隠された秘密を発見したり、オブジェクト(例: 爆発する樽)とインタラクトしたりすることもできる。

「ゲームをプレイする」のではなく「モデルをプレイする」体験:限界と可能性

Microsoftはこのデモについて、「オリジナルのQuake II体験を完全に再現するものではなく、現在の機械学習アプローチで何が可能かを探る研究的な試み」であると強調している。「ゲームをプレイする」というよりは「AIモデルそのものをプレイする」感覚に近い。

現状のWHAMMにはいくつかの限界点も存在する。

- 敵とのインタラクション: 敵キャラクターの表示がぼやけたり、戦闘時のダメージ計算が不正確だったりする場合がある。

- コンテキスト長: モデルが記憶できるのは直近約0.9秒(10fpsで9フレーム分)のプレイ内容のみ。視界から長く外れたオブジェクトは忘れられる可能性があり、これを利用して敵を消したり出現させたり、マップ内を瞬間移動したりすることも(意図せず)可能。

- 数値の正確性: ヘルス値などのカウントが不安定なことがある。

- 範囲の限定: デモはQuake IIの特定レベルの一部のみを対象としており、エリアの終点(エレベーター)に到達すると生成が停止する。

- 遅延: Webブラウザ経由での大規模公開に伴い、操作に対する遅延が目立つ場合がある。

これらの限界点は、今後の改善に向けた課題であると同時に、AI生成によるインタラクティブ体験のユニークな特性を示唆しているとも言える。

Microsoft Gaming CEOのPhil Spencer氏は、2月のMuse発表時に、こうしたAIモデルが「古いゲームを学習し、モデルが動作するあらゆるプラットフォームに移植可能にする世界」や「ゲーム保存活動」への貢献に期待を示していた。WHAMMの登場は、ゲーム開発のプロトタイピング支援や、古典ゲームへの新たなアクセス方法提供といった、AIがゲーム業界にもたらす未来の可能性を具体的に示すものと言えるだろう。

Microsoftは今後も、こうしたAIモデルの探求を進め、新たなインタラクティブメディアの創出や、ゲームクリエイターの表現力向上に貢献していく方針だ。

Copilot Gaming Experiencesのゲームデモはこちらから体験可能だ。

Sources