フランスのAIスタートアップMistral AIは、オープンソースにおいて、最高の性能と効率を達成したとする新型オープンソース言語モデル「Mixtral 8x22B」を発表した。

このモデルは、1,410億個のパラメーターのうち、390億個だけを積極的に使用するSMoE(Sparse Mixture-of-Experts)モデルである。MoEモデルとは、従来の Transformerモデルがは1つの大きなニューラル ネットワークとして機能するのに対し、より小さな「エキスパート」ニューラル ネットワークに分割するものだ。これにより、与えられた入力の種類に応じて、ニューラル ネットワーク内の最も関連性の高いエキスパートパスウェイのみを選択的に有効化することを学習し、モデルの効率を大幅に向上させることが出来る。

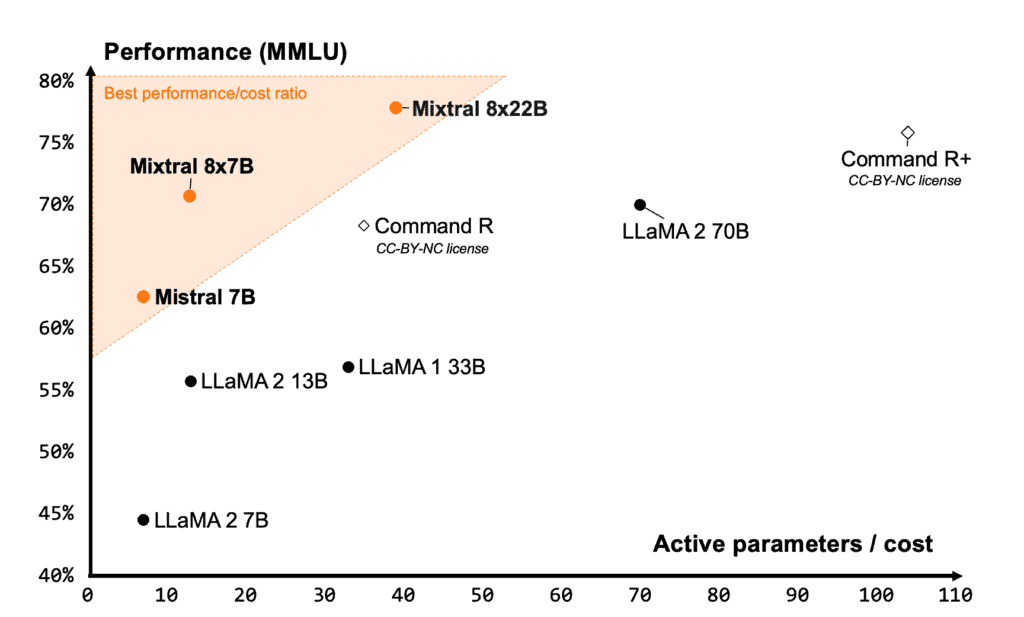

Mistalによれば、このモデルはアクティブ・パラメーターをまばら(Sparse)に使用しているため、従来の高密度に訓練された700億パラメーターのモデルよりも高速で、他のオープンソースのモデルよりも高性能だという。また、そのサイズに対して非常に優れた価格性能比を実現していると主張している。

ちなみに前身であるMixtral 8x7Bは、オープンソースコミュニティで高い評価を得ている。

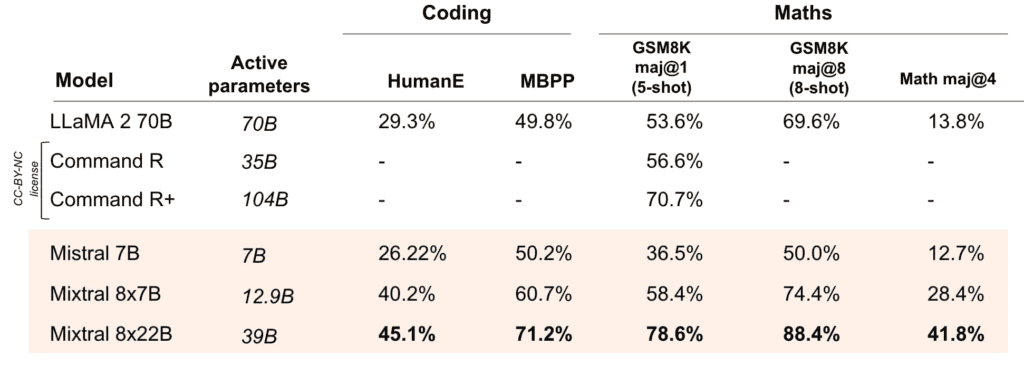

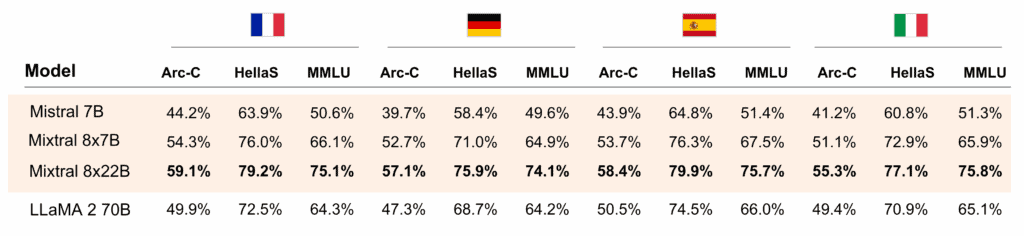

Mistralによれば、Mixtral 8x22Bの強みは、英語、フランス語、イタリア語、ドイツ語、スペイン語をサポートする多言語性と、強力な数学およびプログラミング機能である。また、外部ツールを使用するためのネイティブ関数呼び出しも可能とのことだ。64,000トークンというコンテキストウィンドウは、GPT-4(128K)やClaude 3(200K)のような現在の主要な商用モデルよりも小さい。

また、そのライセンス形態も注目に値する。MistralはMixtral 8x22Bのリリースにあたり、最も寛容なオープンソースライセンスであるApache 2.0ライセンスを与えている。このライセンスはモデルの使用を制限しない。つまり、商用利用も可能なのだ。

性能面では、他のオープンモデルと比較して、Mixtral 8x22Bは、MMLU、HellaSwag、Wino Grande、Arc Challenge、TriviaQA、NaturalQSなどの一般的な理解力、論理力、知識テストにおいて最高の結果を達成している。

また、HellaSwag、Arc Challenge、MMLUベンチマークでは、対応言語であるフランス語、ドイツ語、スペイン語、イタリア語において、70B LLaMA-2モデルを明らかに上回っている。

新モデルは現在、Mistralの「la Plateforme」でテストすることができる。オープンソースのバージョンはHugging Faceで入手可能で、Mistralによれば、アプリケーションを微調整するための良い出発点だという。なお、このモデルの利用には258ギガバイトのVRAMを必要とするとのことだ。

Sources

- Mistral AI: Cheaper, Better, Faster, Stronger

コメント