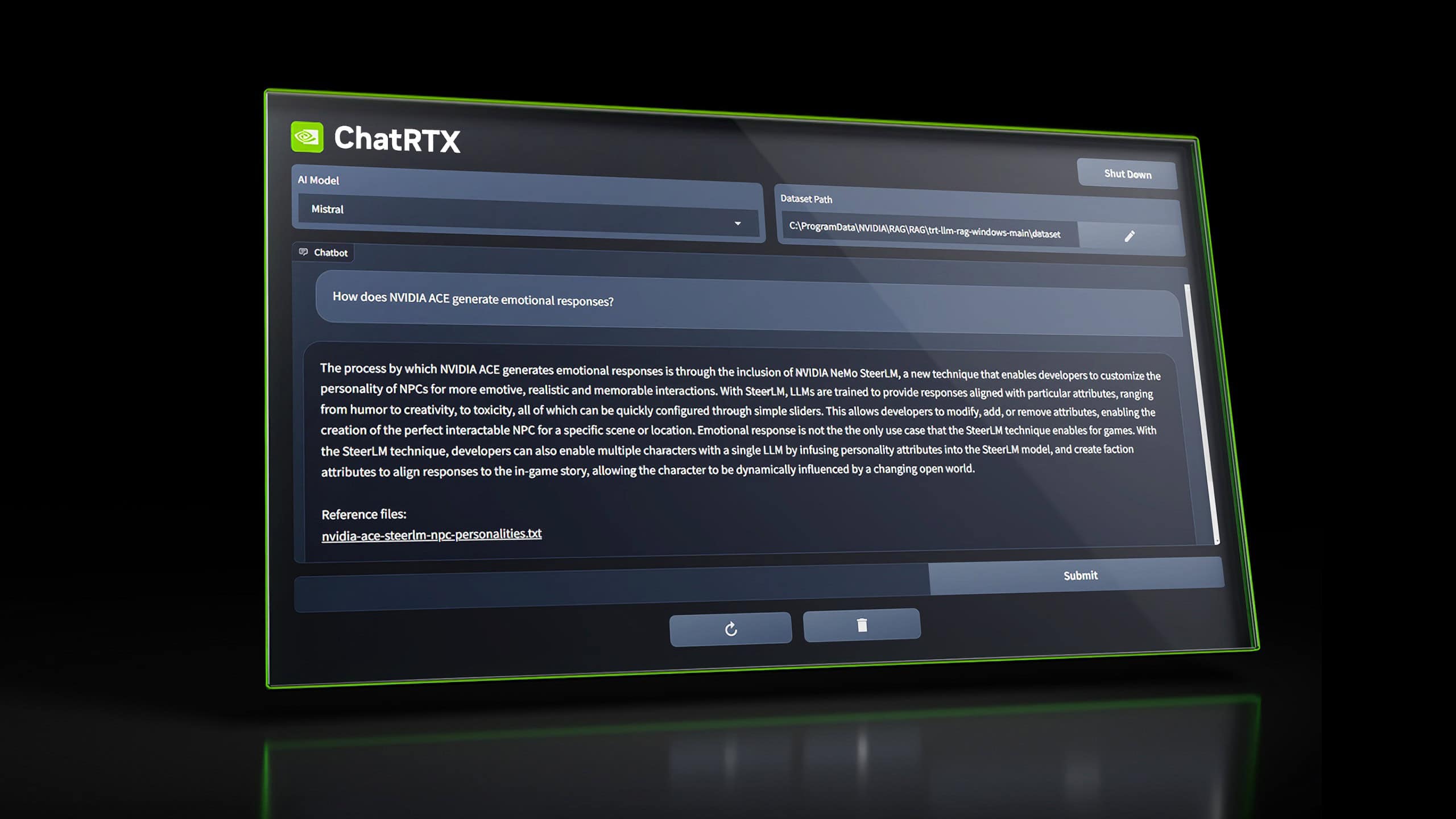

NVIDIAは2月にNVIDIA GPUを使ってローカルでAIチャットボットを駆動させられる「Chat with RTX」のデモを公開したが、今回これをアップデートすると共に名称を改め、「ChatRTX」アプリとしてRTX GPUユーザー向けにリリースした。

新たな名称、新たな機能

既にOpenAIのChatGPTや、GoogleのGeminiと言った強力なチャットボットが存在する中で、ChatRTXの意義について疑問を持たれるかも知れないが、ChatRTXはローカルシステム上で実行するように設計されているため、よりパーソナライズされた経験が期待出来る点にその優位性がある。

ChatRTXを実行するには8GB以上のVRAMを搭載したRTX 30シリーズまたは40シリーズのGPUが必要だ。このアプリは基本的に、ブラウザからアクセスできるローカルのチャットボット・サーバーを作成し、ローカルに保存されているファイルやオンライン上の動画等にアクセスし、自分のデータに関する質問の要約や回答を含む強力な検索ツールとして機能する。

Chat with RTXの段階で、すでにMistral 7BやLlama 2を使用して、テキスト生成等が可能だったが、今回のアップデートに伴いサポートされるAIモデルのリストには、新たにGoogleのオープンソースLLM「Gemma」や、「ChatGLM3」モデルも含まれるようになった。加えて、OpenAIのContrastive Language-Image Pre-training (CLIP)も採用され、これにより、複雑なメタデータのラベル付けをすることなく、写真データを簡単に検索し、ローカルで対話することが出来る様になっている。

ChatRTXでは、txt、pdf、doc/docx、jpg、png、gif、xmlを含む複数のファイル形式を取り込むことができるようになっており、ユーザーはこれらのファイルを含むフォルダを指定してチャットボットと会話をすることで、検出されたコンテンツについてChatRTXに質問を投げかけることが出来るようになっている。また、特定のプロンプトに応じて画像を並べ替えたり、特定の画像を除外したり、シンプルなプロンプトであらゆることができるようになっている。

また、このアプリケーションは音声読み上げにも対応しているので、コンピュータのマイクを使ってボットに質問することができる。

ChatRTXは、NVIDIAのWebサイトからダウンロード出来る。ファイルサイズは36GBと巨大な物なので注意が必要だ。

Sources

- NVIDIA: NVIDIA ChatRTX

コメント