今では、私たちは皆、人工知能(AI)について多くのことを聞いたり読んだりしている。おそらく、数多くのAIツールを使用したことがあるだろう。AIは未来を予測する魔法の杖のように感じられることもある。

しかし、AIは完璧ではない。Aotearoa New Zealandのスーパーマーケットの食事プランナーは顧客に毒性のあるレシピを提供し、ニューヨーク市のチャットボットは人々に違法行為を勧め、GoogleのAI Overviewは人々に岩を食べるように指示している。

AIツールの本質は、特定の問題に対処する特定のシステムである。どのAIシステムにおいても、その能力に応じた期待を持つべきであり、その多くはAIの構築方法に依存する。

AIシステムの固有の欠点を探ってみよう。

現実世界での問題

すべてのAIシステムにとっての固有の問題の一つは、現実の設定で100%の精度を持たないことである。例えば、予測AIシステムは過去のデータポイントを使って訓練される。

そのAIが訓練データに似ていない新しいものに遭遇した場合、正しい決定を下すことはほとんどできないだろう。

仮想の例として、AI搭載の自動操縦システムを備えた軍用機を考えてみよう。このシステムはその訓練「知識ベース」に基づいて機能する。しかし、AIは本当に魔法の杖ではなく、ただの数学的計算である。敵は訓練データにない障害物を作り出し、それが飛行機AIには「見えない」ため、潜在的に壊滅的な結果を招く可能性がある。

この問題に対してできることは、既知のすべての状況に対応するようAIを訓練すること以外にあまりない。これは時には克服しがたい課題である。

訓練データの偏り

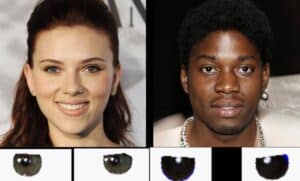

AIが偏った決定を下すという話を聞いたことがあるかもしれない。通常、偏りはデータが不均衡な場合に発生する。簡単に言えば、AIシステムを訓練する際に、あるタイプの結果の例が多すぎて、他のタイプが非常に少ないときに起こる。

例えば、特定の個人が犯罪を犯す可能性を予測するために訓練されたAIシステムを考えてみよう。訓練データに特定の民族グループAの人々が多く、グループBの人々が少ない場合、システムは両方のグループを平等に学習することはできない。

その結果、グループAの予測はこれらの人々がグループBの人々に比べて犯罪を犯す可能性が高いように見えるだろう。このシステムが無批判に使用されると、この偏りの存在は深刻な倫理的結果を招く。

幸いなことに、開発者はデータセットを「バランスさせる」ことでこの問題に対処できる。この方法には、合成データ(テストおよび訓練用に構築されたコンピュータ生成の事前ラベル付きデータ)を使用することが含まれる。

最新でない場合

もう一つの問題は、「オフライン」で訓練されており、それが取り組む問題の動態に最新でない場合に発生する。

簡単な例として、ある都市の日々の気温を予測するために開発されたAIシステムを考えてみよう。訓練データにはこの場所の過去の気温データが含まれている。

AIが訓練を終えて展開された後、例えば、異常気象が通常の気象動態を乱すとしよう。この予測を行うAIシステムは、この乱れを含むデータで訓練されていないため、その予測はますます不正確になる。

この問題を解決する方法は、AIを「オンライン」で訓練することである。つまり、使用中に最新の気温データを定期的に提供する。

これは素晴らしい解決策のように聞こえるが、オンライン訓練にはいくつかのリスクが伴う。最新のデータを使用してAIシステムを訓練し続けることができるが、それは制御不能になる可能性がある。

基本的に、これはカオス理論によるもので、簡単に言えば、ほとんどのAIシステムは初期条件に敏感であるということだ。システムがどのようなデータに遭遇するかわからない場合、将来の潜在的不安定性を制御するための初期条件を調整する方法がわからない。

データが適切でない場合

時々、訓練データが目的に適していないことがある。例えば、そのAIシステムが行おうとしているタスクを実行するために必要な特性を持っていないことがある。

極めて単純化した例として、「高い」人と「低い」人を識別するAIツールを考えてみよう。訓練データで170cmの人を高いとラベル付けすべきか低いとラベル付けすべきか?もし高いとラベル付けした場合、169.5cmの人に遭遇したときにシステムは何を返すだろうか?(おそらく最良の解決策は「中間」のラベルを追加することであろう。)

上記は些細なことのように見えるかもしれないが、データラベリングや不適切なデータセットの問題は、例えば医療診断に関与するAIシステムの場合、問題を引き起こす可能性がある。

この問題を解決するのは容易ではない。関連する情報を特定するには多大な知識と経験が必要である。データ収集プロセスに専門家を参加させることは素晴らしい解決策であり、開発者がどのような種類のデータを最初から含めるべきかを指導することができる。

将来のAIおよび技術のユーザーとして、これらの問題を認識し、AIとその予測結果が私たちの生活のさまざまな側面に与える影響について視野を広げることが重要である。

コメント