Appleが長らく開発を進めてきた人工知能(AI)機能「Apple Intelligence」が、ついに開発者向けベータ版で利用可能になった。iOS 18.1、iPadOS 18.1、macOS Sequoia 15.1の最初の開発者向けベータ版に搭載され、開発者たちは待望のAI機能をテストできるようになった。ただし、最も注目の新たなSiriの機能は来年まで待たなければならないようだ。

Apple Intelligenceはまずは米国の英語ユーザー向けにテストが開始

Apple Intelligenceは、Appleが生成AIの分野に本格参入するための中核技術だ。大規模言語モデル(LLM)を活用し、テキスト、画像、アプリ内アクションなど、さまざまなタスクを処理する。この技術は、ユーザーの日常的なデバイス操作を大幅に向上させることを目指している。

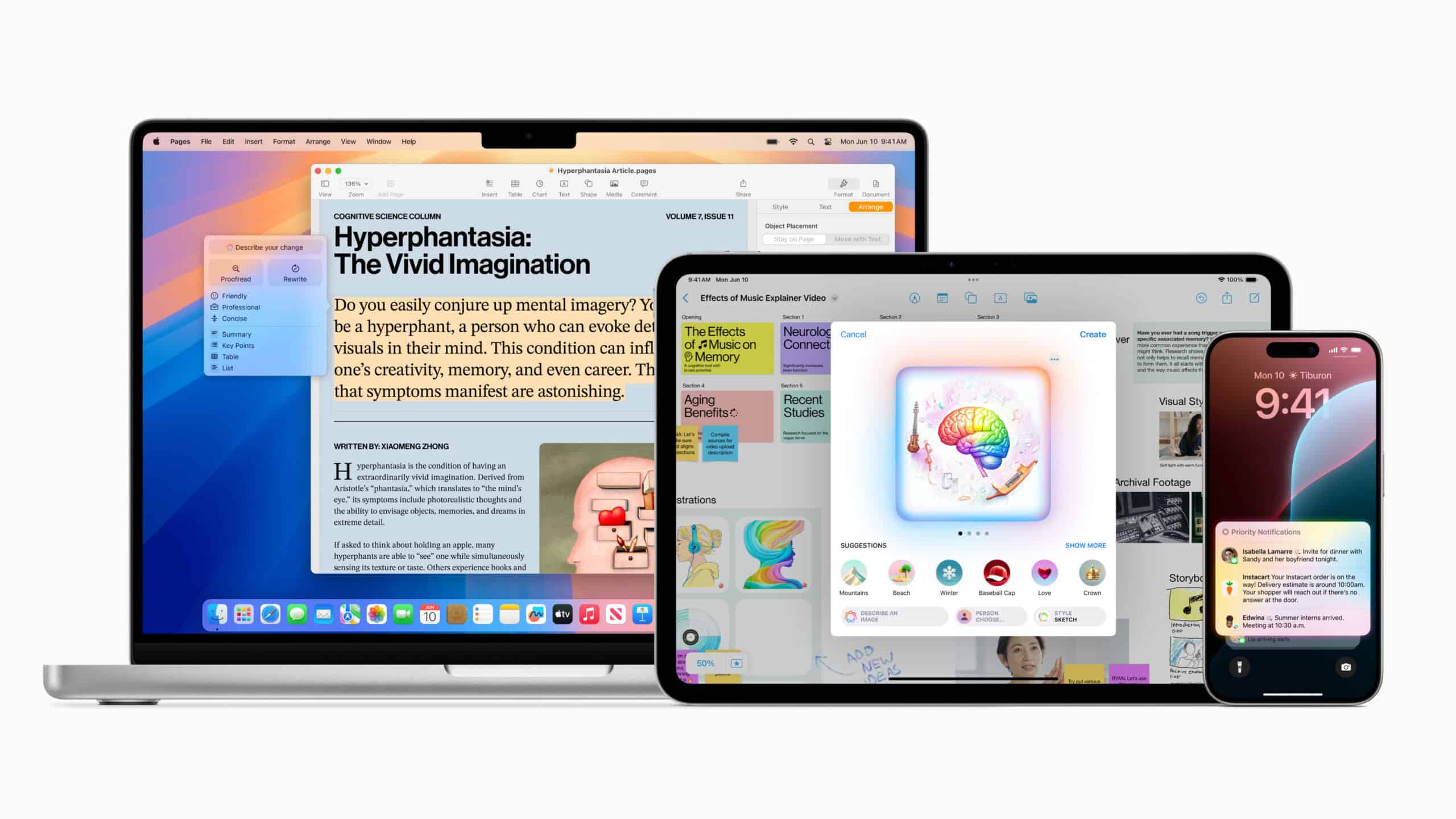

開発者向けベータ版では、メールの作成や文章の校正、トーン調整などをサポートするライティングツールが提供される。これにより、ユーザーは状況に応じて適切な文章スタイルを選択し、より効果的なコミュニケーションを図ることが可能になる。また、優先メッセージ機能やメールの要約、自動返信機能も導入され、情報の整理と効率的な対応をサポートする。

さらに、ロック画面上でのテキストやメールの自動要約機能も搭載される。これにより、ユーザーは重要な情報を素早く把握できるようになる。音声文字起こしの要約機能も加わり、長時間の会議や講演の内容を効率的に理解することが可能になる。

写真や動画の自然言語検索は、Apple Intelligenceの画像処理能力を示す重要な機能だ。ユーザーは複雑な検索クエリを使用して、特定の場所、人物、物体が写った画像を簡単に見つけ出すことができるようになる。また、Image Playgroundでユーザーは独自の画像を作成することが出来たり、生成AIを使った独自の絵文字を作る「Genmoji」もApple Intelligenceの目玉機能として紹介されている。

これらの機能を利用するには、Siriの言語設定を英語に、地域を米国に設定する必要がある。また、対応デバイスはAppleシリコンを搭載したMacモデル、iPadモデル、iPhone 15 Pro、iPhone 15 Pro Maxに限定されている。この制限は、Apple Intelligenceが要求する高度な処理能力に起因すると考えられる。

開発者たちは、設定メニューからApple Intelligenceの待機リストに参加し、数時間以内にアクセス権を得られる見込みだ。この迅速なアクセス提供は、Appleが開発者からのフィードバックを積極的に求めていることの現れと言えるだろう。ただし、一般ユーザー向けの公開ベータ版での提供時期は現時点で不明である。

Apple Intelligenceの導入により、iPhoneユーザーはより自然な会話でSiriを利用できるようになり、コンテキストや関係性を考慮した応答が可能になる。これは単なる機能の追加ではなく、AI技術によるユーザーインターフェースの根本的な変革を意味する。Siriは単なる音声アシスタントから、ユーザーの意図を深く理解し、適切なアクションを提案できる知的なパートナーへと進化することが期待される。

一方で、一部の機能、特にSiriの大規模な改良については2025年まで段階的に導入される可能性がある。これは、AIシステムの複雑さと、Appleが重視するプライバシーや安全性の確保に時間を要することが関係していると見られる。また、EUでの提供に関しては、デジタル市場法(DMA)の相互運用性要件との兼ね合いから、現時点では不透明な状況だ。Appleは欧州委員会と協力して解決策を見出そうとしているが、規制遵守とユーザー体験の最適化のバランスをどのように取るかが課題となっている。

AppleのAI戦略は今後も進化を続けると見られ、開発者や一般ユーザーの反応が注目される。Apple Intelligenceの導入は、スマートフォンやタブレット、パソコンの利用体験を大きく変える可能性を秘めており、テクノロジー業界全体に影響を与えることが予想される。特に、プライバシーを重視したAIの実装方法や、オンデバイス処理とクラウド処理のバランスなど、Appleの取り組みは他社のAI開発にも影響を与える可能性がある。

コメント