Appleは、OpenAIのChatGPTやGoogleのGeminiのような、世界が驚くような先進的なAIを発表しておらず、その開発は先行他社に比べて遅れているとの批判も根強い。だが、Apple本体からの公式な発表は何もないが、同社の研究者らは積極的に研究論文を発表しており、そこにはAppleが革新的なAI開発に向けた積極的な取り組みを行っている事が垣間見える。そして今回新たに発表された論文では、Siri が画像の内容を認識するだけではなく、そうした画像内の会話や背景のコンテキストを高精度に理解出来るような、新たなAIを開発した事が報告されている。

Appleは次期iPhoneにおいて、GoogleのGeminiモデルを搭載する可能性が最近報じられたが、同社はオンデバイスでのAI処理の研究も盛んに進めているようで、クラウドでの大規模言語モデルとオンデバイスでの小規模モデルによるハイブリッドアプローチを取る可能性が噂されている。同社が近く発表する独自のAIは、後者のオンデバイスで駆動する小規模なモデルであると言われている。

ユーザーが“これ”や“あれ”と言うような曖昧な言語入力に基づいて、コンピューター・プログラムにタスクを実行させることを参照解決と呼ぶ。コンピューターは人間のように画像を解釈できないため、解決するのは複雑な問題だが、AppleはこれをAIモデルによって解決できる可能性を示している。

Appleの明らかになった最新の論文では、「ReALM(Reference Resolution As Language Modeling)」と呼ばれる、言語モデルで強化された音声アシスタントの有用性を高める可能性のあるシステムが詳述されている。同社によれば、これはOpenAIのGPT-4に匹敵、もしくは上回る可能性があるとの事だ。

Siriのようなスマートアシスタントに話しかけるとき、ユーザーはバックグラウンドタスク、ディスプレイ上のデータ、その他の会話以外のエンティティなど、対話するためにあらゆる数のコンテキスト情報を参照する可能性がある。従来の構文解析手法は、非常に大きなモデルや画像のような参照資料に依存していたが、Appleはすべてをテキストに変換することでアプローチを効率化した。

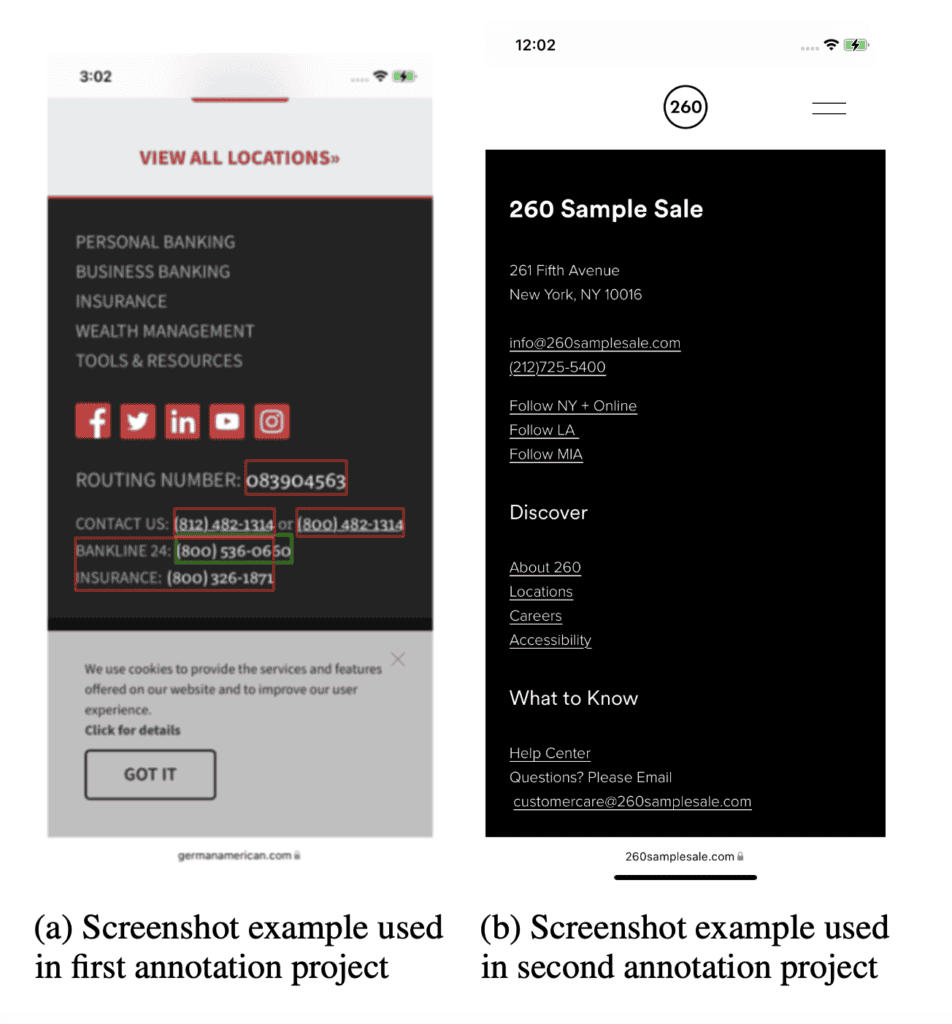

Appleによれば、以下のような画面に表示されているものと、アクティブなタスクの両方を考慮する事が可能だという:

- 画面上のエンティティ:ユーザーの画面上に現在表示されているエンティティ。

- 会話エンティティ:会話に関連するエンティティ。これらのエンティティは、ユーザの以前のターンから来る可能性のある物(例えば、ユーザが “Call Mom “と言ったとき、Momのコンタクトが問題の関連エンティティになるだろう)、またはバーチャルアシスタントから来るかもしれない(例えば、エージェントがユーザに選択する場所やアラームのリストを提供するとき)。

- バックグラウンドエンティティ:例えば、鳴り始めたアラームやバックグラウンドで流れている音楽など。

これは、今までお世辞にも賢いとは言えなかったSiriを大幅にパワーアップさせる可能性のある物だ。

Appleによれば、最小のReALMモデルが、はるかに少ないパラメータでGPT-4と同様の性能を発揮したと報告している。これはオンデバイスでの駆動が可能なパラメータサイズとのことだ。さらにReALMで使用されるパラメータを増やすと、GPT-4を大幅に上回るようになったという。

なぜこうした効率化が可能になったのか?それは、GPT-4が画面上の情報を理解するために画像解析に依存していることにある。画像学習データの多くは、テキストで埋め尽くされた人工的なコードベースのWebページではなく、自然な画像に基づいて構築されているため、直接的なOCRは効率が悪い。

画像をテキストに変換することで、ReALMはこのような高度な画像認識パラメータを必要としなくなり、より小型で効率的なものになっている。Appleはまた、デコードを制約したり、単純な後処理を使用したりする機能を含めることで、幻覚の問題を回避していると述べている。

例えば、Webサイトをスクロールしていて、その企業に電話したいと思った場合、単に「企業に電話する」と言うと、Siriは文脈からあなたが何を言いたいのかを解析する必要がある。Siriは、ページ上にビジネスナンバーと表示された電話番号があることを「認識」し、ユーザーに促されることなく、その電話番号に電話をかけることが出来るのだ。

Appleは6月に開催されるWWDCにおいて、長らく噂されており、度々予告もしているAIへの取り組みについて大々的にアピールすることだろう。それがどのような形になるのかは不明だが、急激に変化していくAI分野の進歩に必死に追いつこうと、内部では多くの研究が行われていることは確かなようだ。

論文

参考文献

研究の要旨

参照解決は重要な問題であり、さまざまな種類のコンテキストを理解し、うまく扱うために不可欠なものである。このコンテキストには、以前のターンや、ユーザーの画面上のエンティティやバックグラウンドで実行されているエンティティなど、会話以外のエンティティに関連するコンテキストの両方が含まれる。LLMは様々なタスクにおいて非常に強力であることが示されているが、参照解決、特に会話以外のエンティティに対する利用は、まだ十分に活用されていない。本論文では、従来テキストのみのモダリティに還元することが困難であった画面上のエンティティのような形式を含むにもかかわらず、参照解決を言語モデリング問題に変換できることを示すことで、様々な種類の参照を解決するための極めて効果的なシステムを構築するためにLLMをどのように利用できるかを示す。我々は、様々な種類の参照において、同様の機能を持つ既存のシステムに対して大きな改善を示し、我々の最小のモデルでは、画面上の参照において5%以上の絶対的な改善を得た。また、GPT-3.5とGPT-4に対してベンチマークを行い、我々の最小モデルはGPT-4と同等の性能を達成し、我々の大型モデルはGPT-4を大幅に上回る性能を達成した。

コメント