Googleは、単一GPUまたはTPUで動作するAIモデルとして世界最高性能を謳う新たなオープンモデル「Gemma 3」を発表した。Gemini 2.0と同じ研究と技術をベースにした同モデルは、画像やテキスト解析機能を備え、140言語以上をサポートし、モバイルからワークステーションまであらゆるデバイスで動作するよう設計されている。

Gemma 3の概要と性能

Gemma 3は、GoogleがGemini 2.0モデルと同じ技術をベースに開発した最新のオープンモデルファミリーである。2024年2月にバージョン1、5月にバージョン2が発表され、現在までに1億回以上のダウンロードを記録し、6万以上のバリアントが作成された「Gemmaverse」と呼ばれるエコシステムを形成している。

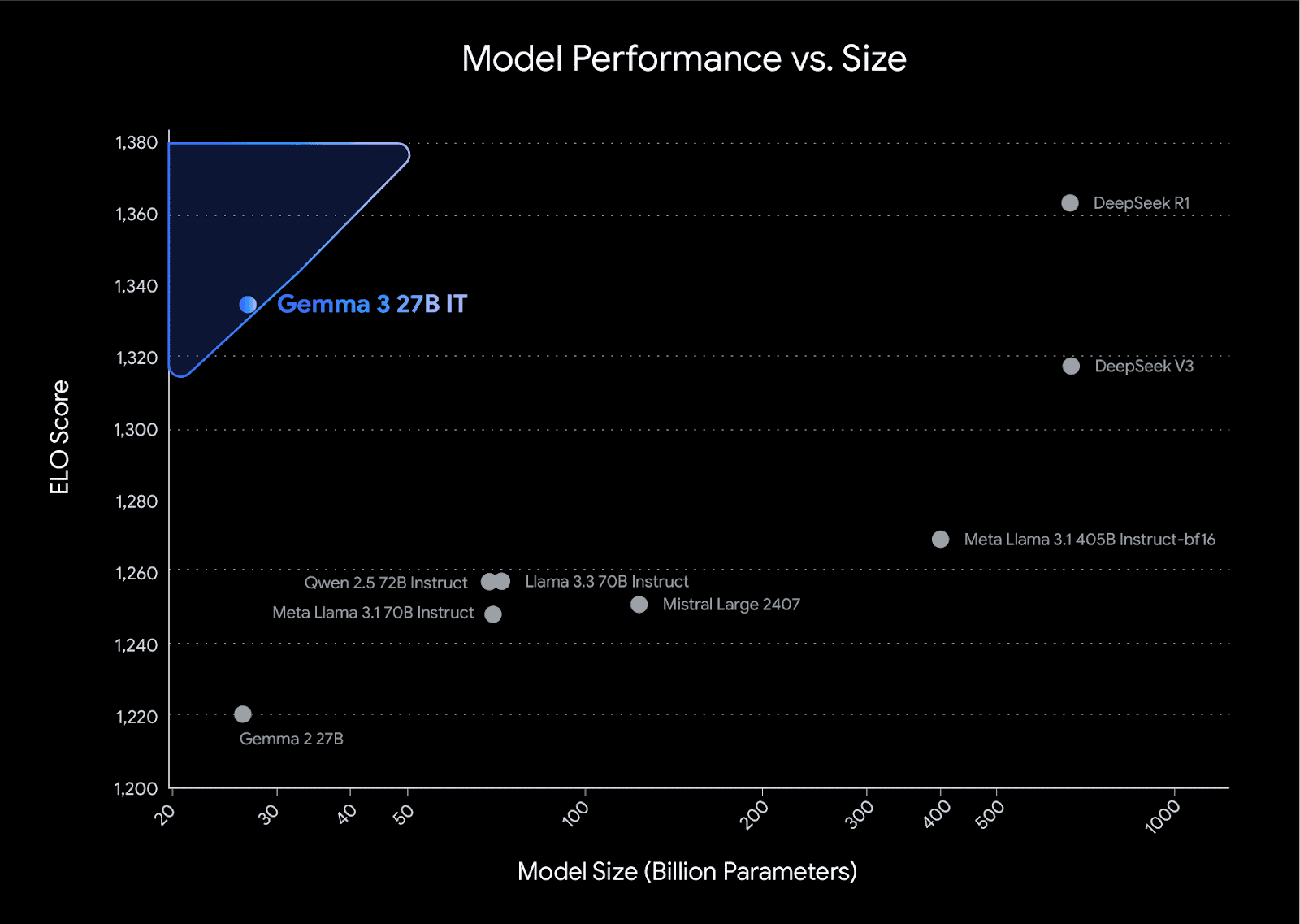

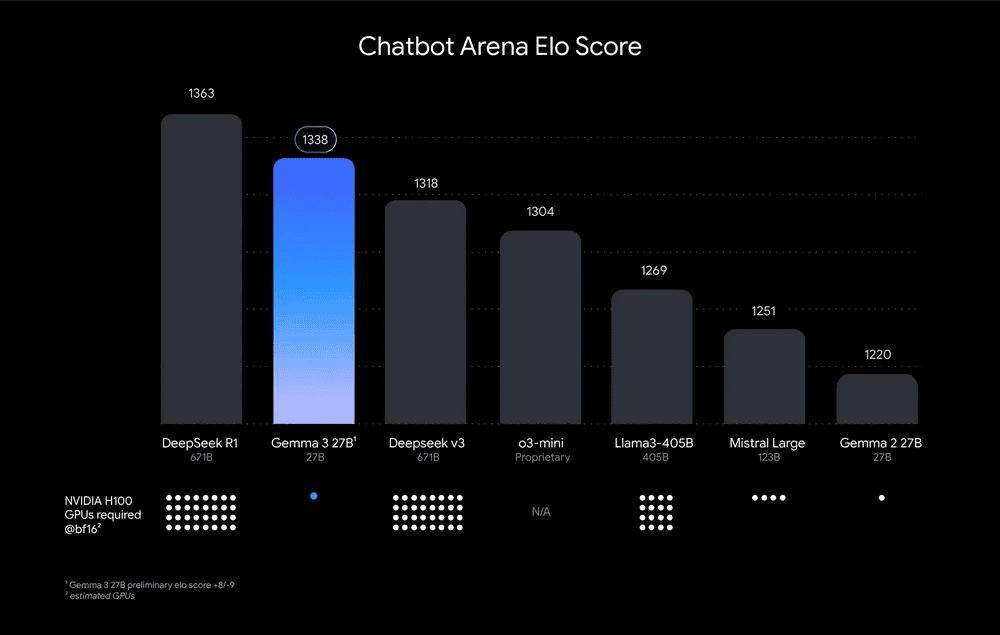

Gemma 3は1B、4B、12B、27Bの4つのサイズで展開され、ハードウェアと性能要件に合わせて選択できる。特筆すべきは、LMArenaのリーダーボードでの人間の嗜好評価において、Facebook(Meta)のLlama-405B、DeepSeek-V3、OpenAIのo3-miniを上回るパフォーマンスを発揮している点だ。

最小サイズのGemma 3 1Bはわずか529MBのサイズながら、Google AI EdgeのLLM推論を介して最大2585トークン/秒のプリフィル速度を実現し、1ページのコンテンツを1秒未満で処理できる性能を持つ。

主な機能と技術的特徴

Gemma 3の最大の新機能は、マルチモダリティのサポートである。SigLIPに基づく統合ビジョンエンコーダーを搭載し、画像や短い動画の入力とテキスト出力をサポートする。これにより、画像解析や画像に関する質問応答、画像の比較、オブジェクト識別、画像内のテキスト応答などが可能になる。

また、Gemma 3は128kトークンまでのコンテキストウィンドウを処理でき、35言語以上を標準でサポートし、140言語以上の事前学習サポートを提供する。関数呼び出しと構造化出力もサポートしており、タスクの自動化やエージェント体験の構築が可能だ。

Gemma 3の開発には、蒸留、強化学習、モデルマージングなどの技術が組み合わされている。事前トレーニングでは1Bモデルに2兆トークン、4Bモデルに4兆トークン、12Bモデルに12兆トークン、27Bモデルに14兆トークンが使用された。

ポストトレーニングでは、以下の4つのコンポーネントが使用されている:

- 大きなモデルからの蒸留

- 人間のフィードバックからの強化学習(RLHF)

- 機械フィードバックからの強化学習(RLMF)

- 実行フィードバックからの強化学習(RLEF)

これらの改良により、LMArenaで1338のスコアを獲得し、オープンなコンパクトモデルでトップの評価を得ている。

安全性への取り組みとShieldGemma 2

Googleは、オープンモデルには慎重なリスク評価が必要だと考え、イノベーションと安全性のバランスを取るアプローチを採用している。Gemma 3の開発には、広範なデータガバナンス、安全ポリシーとの整合を図るための微調整、堅牢なベンチマーク評価が含まれている。

特に、Gemma 3の強化されたSTEM性能に関しては、有害物質の作成における悪用の可能性に焦点を当てた評価が行われ、リスクレベルは低いことが確認されている。

Gemma 3と共に、ShieldGemma 2と呼ばれる4B画像安全チェッカーも発表された。これはGemma 3基盤上に構築され、「危険なコンテンツ、性的に露骨なコンテンツ、暴力」の3つのカテゴリに関する安全ラベルを出力する。開発者はこれを自社の安全ニーズやユーザーに合わせてカスタマイズできる。

利用方法と開発支援

Gemma 3とShieldGemma 2は、既存のワークフローにシームレスに統合できるよう設計されている。Hugging Face Transformers、Ollama、JAX、Keras、PyTorch、Google AI Edge、UnSloth、vLLM、Gemma.cppなど、多様な開発ツールをサポートしている。

開発者は、Google AI Studioですぐに試すことができ、KaggleやHugging Faceからモデルをダウンロードすることも可能だ。また、効率的な微調整と推論のためのレシピを含む改良されたコードベースも提供されている。

デプロイオプションとしては、Vertex AI、Cloud Run、Google GenAI API、ローカル環境などが用意されている。さらに、NVIDIAはGemma 3モデルを直接最適化しており、Jetson NanoからBlackwellチップまで、あらゆるサイズのGPUで最大のパフォーマンスを発揮できる。

Google Cloud TPUとの統合や、オープンソースのROCm™スタックを介したAMD GPUとの統合もサポートされている。CPU実行の場合は、Gemma.cppが直接的なソリューションを提供する。

開発事例とアカデミックプログラム

Gemmaverseは、コミュニティが作成したGemmaモデルとツールの広範なエコシステムである。代表的な事例としては、東南アジア全体のコミュニケーションを促進するAI SingaporeのSEA-LION v3、ブルガリア語を優先した大規模言語モデルであるINSAITのBgGPT、オンデバイスAIの可能性を示すNexa AIのOmniAudioなどが挙げられる。

学術研究のブレークスルーをさらに促進するため、GoogleはGemma 3 Academic Programを立ち上げた。学術研究者は、Gemma 3ベースの研究を加速するためのGoogle Cloudクレジット(1賞あたり10,000ドル相当)を申請できる。申請フォームは現在オープンで、4週間開放される予定だ。

Sources