AI一色となったGoogle I/Oだが、そのAI革命の屋台骨を支える裏方にもスポットライトは当てられている。

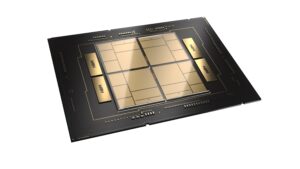

Googleは本日、データセンター向けのAIチップであるTensor Processing Unit(TPU)の次世代バージョンとなる、第6世代TPU「Trillium」を発表した。Googleによれば、第5世代TPUと比較して、大きな性能向上とエネルギー効率の向上が見込まれるという。

チップあたり性能が4.7倍も向上

第6世代TPU「Trillium」は、第5世代のTPU v5eと比較して、チップあたりのピーク演算性能が4.7倍にまで高められているという。

v5eのスペックシートを参考に、4.7倍の性能向上を誇るというTrilliumの性能を推定してみると、この新しいチップがBF16でおよそ926TFLOPS、INT8で1847TFLOPSの性能を持つことが推測される。

そうすると、Googleが半年前に発表したTPU v5pアクセラレーターの約2倍の速さということになりそうだ。

この性能向上には、行列乗算ユニット(MXU)のサイズ拡大や、クロック速度の向上が寄与しているという。MXUの改良と並行して、Googleは第3世代SparseCoreの搭載も大きいとしている。これは、ランキングや推薦システムでよく見られる大規模な埋め込みを処理するために設計された特殊なアクセラレータだ。

一方、帯域幅と容量の倍増は、1.6TB/秒で動作する32GBのHBMと、3.2Tbpsのチップ間インターコネクトを意味する。

Googleは、メモリ容量が増えることで、より多くのウェイトを含む大型モデルや、より大きなキー・バリュー・キャッシュ(後者は多数の同時ユーザーを処理するために重要)をサポートできるようになると述べている。

一方、チップ間のインターコネクト帯域幅が向上したことで、より大きなモデルの推論やトレーニングをサポートするために、複数のTPUをより効率的につなげることができる。

スケーラビリティの点では、Trilliumは最大256チップのPodをサポートするという点で、v5eインスタンスとよく似ている。複数のPodは、GoogleのマルチスプライステクノロジーとTitaniumインフラストラクチャ処理ユニットを使ってネットワーク化され、「数万チップ」までスケールするトレーニングワークロードをサポートすることができる。

性能向上と共にGoogleが焦点を当てているのはエネルギー効率だ。Google CEOのSundar Pichai氏は、TrilliumをGoogleの「最もエネルギー効率の高い」TPUと表現し、これはAIチップの需要が指数関数的に増加する中で特に重要であると述べた。「過去6年間でML計算の需要は100万倍に増加し、毎年約10倍増加している」と彼は述べた。これは、これらのチップの電力需要を削減するための投資なしには持続可能ではない事を示している。Googleは新しいTPUが第5世代チップと比較して67%エネルギー効率が高いと主張している。

現在、Nuro、Deep Genomics、Deloitte、Google自身のDeepMindチームなど、いくつかの顧客が、それぞれのモデルのトレーニングと実行にTrilliumを最初に使用する予定であるとしている。

一般への提供は今年の後半に行われるとのことだ。

Source

コメント