大規模言語モデル(LLM)の学習や推論に使用されるデータセンター向けGPUの寿命が、従来の想定を大きく下回る可能性があることが明らかになった。Alphabetの匿名の主任AIアーキテクトによると、高負荷での使用時には1〜3年程度で寿命を迎える可能性があるという。この発見は、急速に拡大するAI産業の収益性に大きな影響を与える可能性がある。

GPUの短命化、その実態と要因

データセンターにおけるAI処理用GPUの稼働率は60〜70%に達しており、この高負荷な使用環境下では、GPUの寿命はわずか1〜2年、最長でも3年程度とされている。この情報は、信頼性の高い情報源を持つテック投資家のTechFundが報告している。

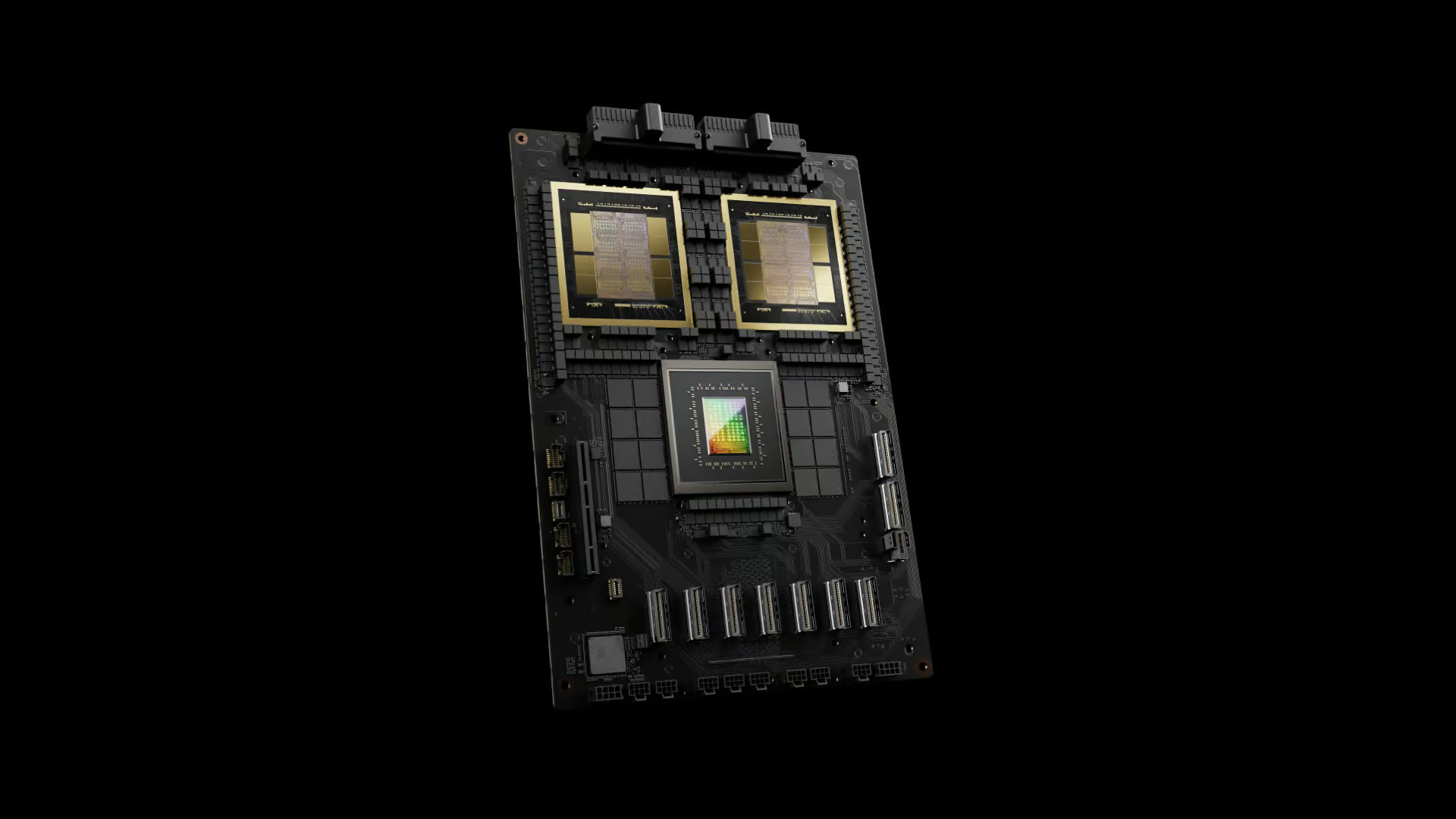

寿命が短くなる主な要因は、最新のデータセンター向けGPUが700W以上の電力を消費・放熱する点にある。この大きな熱負荷が、微細な半導体チップに重大なストレスを与えていると考えられている。

実データが示す故障率

Metaが今年発表したLlama 3 405Bモデルの学習に関する調査では、具体的な故障データが報告されている。期間中、クラスターは合計466回のジョブ中断を経験したが、そのほとんどがGPUに起因した物であることが明らかになっている。同社は16,384台のNVIDIA H100 80GB GPUを使用したクラスターでの54日間の学習期間中:

- 419件の予期せぬ中断が発生

- そのうち148件(30.1%)がGPU関連の故障(NVLinkの故障を含む)

- 72件(17.2%)がHBM3メモリの故障

を報告している。

これらのデータから推計される年間故障率は約9%で、3年使用後には約27%に達する可能性がある。さらに、使用期間が長くなるほど故障率が上昇する傾向が指摘されている。

[前半部分は同じなので省略…]

AI産業への影響と対応策

GPUの短寿命化問題は、AI業界の経済性に深刻な影響を及ぼしつつある。その象徴的な例として、AI業界を牽引するOpenAIの収支予測がある。同社は、Microsoftから巨額の支援を受けているにもかかわらず、2024年には50億ドルの損失を計上する見通しだ。この損失の大きな要因の一つが、大規模言語モデルの学習と運用に必要な計算資源のコストである。

さらにGoogleは、AI処理能力の増強に積極的な投資を続けており、2024年第2四半期だけでも132億ドルをAI処理ハードウェアに投じている。しかし、これらの投資は従来考えられていたような長期的な設備投資としての性質を失いつつある。3年という短いサイクルでの設備更新が必要となれば、投資回収の見通しは大きく変化せざるを得ない。

この課題に対し、一部のデータセンター事業者はGPUの稼働率を意図的に抑制することで寿命の延長を図っている。しかし、この対応策には大きな代償が伴う。稼働率の低下は設備の償却期間を延長させ、結果として投資効率を悪化させる。このジレンマは、AI産業全体が直面する構造的な課題となりつつある。

Xenospectrum’s Take

GPUの短寿命化が明らかになったことで、AI産業は重要な転換点を迎えている。この問題は単なる技術的な課題を超えて、産業構造全体に影響を及ぼす可能性がある。

まず、設備投資の考え方そのものの見直しが必要となるだろう。従来の3年間の減価償却期間を前提とした投資計画は、現実に即さなくなりつつある。より短期的な投資回収計画への移行が求められる中で、AI企業各社は収益化への時間的プレッシャーを一層強く受けることになる。

この状況は、皮肉にもGPU市場で圧倒的なシェアを持つNVIDIAの市場支配力をさらに強化する方向に作用している。実際、同社の時価総額は2024年6月には3兆ドルに達し、定期的なGPU需要の確保がさらなる成長を後押しする構図となっている。

しかし、より本質的な課題は、現在のAIビジネスモデルの持続可能性にある。莫大な計算資源を必要とする現在の大規模言語モデルの開発・運用アプローチは、ハードウェアの短寿命化という現実の前で、根本的な見直しを迫られる可能性がある。

今後のAI産業は、より効率的なモデルアーキテクチャの開発や、革新的な学習手法の確立に注力せざるを得ないだろう。また、GPU以外の選択肢として、専用のAIアクセラレーターの開発競争も活発化すると予想される。GPUの短寿命化問題は、AI技術の進化の方向性そのものに影響を与える可能性を秘めている。このような技術的・経済的な課題への対応が、今後のAI企業の競争力を左右する重要な要素となっていくだろう。

Sources

コメント